📝个人主页:哈__

期待您的关注

目录

🔥引言

背景介绍

文章目的

一、GPT-4简介

GPT-4概述

主要特性

局限性和挑战

二、自监督学习的新进展

自监督学习的原理

代表性模型和技术

三、少样本学习和零样本学习

少样本学习的挑战

先进方法

四、跨模态学习

跨模态学习的概念

代表性技术

应用场景

第五部分:可解释性和透明性

AI的可解释性问题

最新研究进展

应用与影响

🔥引言

背景介绍

自然语言处理(NLP)是人工智能的一个重要分支,致力于让计算机理解、生成和处理人类语言。从20世纪50年代的初步探索,到如今的深度学习革命,NLP技术经历了巨大的发展。早期的NLP系统依赖于复杂的手工规则和统计模型,但这些方法在处理多样性和复杂性的自然语言时表现有限。进入21世纪后,随着计算能力的提升和大数据的涌现,深度学习技术开始在NLP领域崭露头角,推动了一系列革命性进展。

近年来,基于神经网络的语言模型如Word2Vec、GloVe、BERT和GPT系列相继问世,彻底改变了NLP的研究和应用。尤其是GPT-3及其后续版本GPT-4,以其卓越的文本生成和理解能力,引发了广泛关注和应用。然而,尽管这些模型在NLP任务中表现出色,它们仍然存在一些局限性和挑战,如计算资源需求巨大、缺乏可解释性等。

文章目的

本文旨在探讨GPT-4及其后续技术的进展和应用,重点关注自监督学习、少样本学习、跨模态学习、可解释性和透明性等前沿领域。我们将通过介绍这些新技术的发展现状及其应用前景,展望未来自然语言处理的主要趋势和方向。希望通过这篇文章,读者能够更全面地了解Beyond GPT-4的技术探索和发展,并对NLP领域的未来充满信心。

一、GPT-4简介

GPT-4概述

GPT-4(Generative Pre-trained Transformer 4)是由OpenAI开发的一种大规模预训练语言模型,是GPT系列的最新版本。基于Transformer架构,GPT-4通过在大规模文本数据上进行无监督预训练,然后通过监督微调来提高其在特定任务上的性能。它能够生成高质量的自然语言文本,并在多种NLP任务中表现出色,如文本生成、翻译、摘要和对话系统等。

主要特性

- 更大规模的模型参数:GPT-4比其前身GPT-3拥有更多的参数,提升了模型的生成质量和语言理解能力。

- 多语言支持:GPT-4支持多种语言的文本生成和理解,使其在全球范围内具有更广泛的应用。

- 上下文理解:增强了对长文本的上下文理解能力,能够生成更加连贯和一致的文本。

- 广泛的应用场景:

- 文本生成:自动生成高质量的文章、故事、对话等。

- 翻译:在多语言间进行高质量的文本翻译。

- 摘要:提取文本中的关键信息,生成简洁的摘要。

- 对话系统:用于构建智能聊天机器人和虚拟助理。

局限性和挑战

- 计算资源和成本:GPT-4的训练和部署需要大量的计算资源和成本,对硬件设备和能源消耗提出了很高的要求。

- 伦理和安全问题:由于GPT-4能够生成高度逼真的文本,可能被用于生成虚假信息、操纵舆论或其他不道德用途。

- 缺乏可解释性:GPT-4作为黑箱模型,其决策过程缺乏透明性,使得理解其生成的文本背后的逻辑变得困难。

- 理解和推理能力:虽然GPT-4在许多任务中表现优异,但其在深层次理解和逻辑推理方面仍有不足,尤其是在处理需要复杂推理的问题时。

这些局限性和挑战为NLP领域的进一步研究指明了方向,激励了Beyond GPT-4技术的探索和发展。接下来,我们将详细探讨这些前沿技术及其应用。

二、自监督学习的新进展

自监督学习的原理

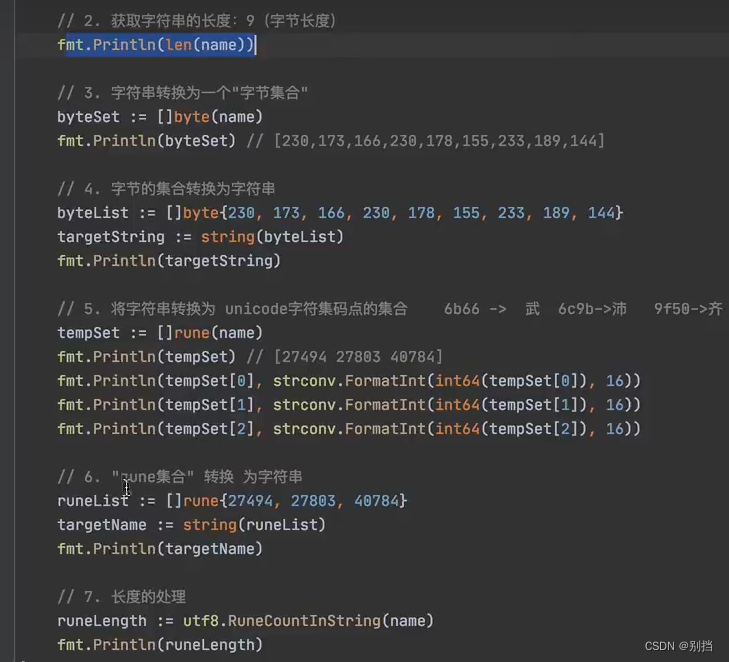

自监督学习是一种无需手工标注数据的学习方法,通过设计合适的预训练任务,让模型从大量的未标注数据中学习特征。自监督学习通过构造伪标签,使模型可以在无监督的条件下进行预训练,然后在特定任务上进行微调。自监督学习的一个常见例子是掩码语言模型(Masked Language Model, MLM),如BERT模型中的应用。。

代表性模型和技术

BERT(Bidirectional Encoder Representations from Transformers):

BERT通过双向Transformer架构进行预训练,使用MLM和下一句预测(Next Sentence Prediction, NSP)任务。

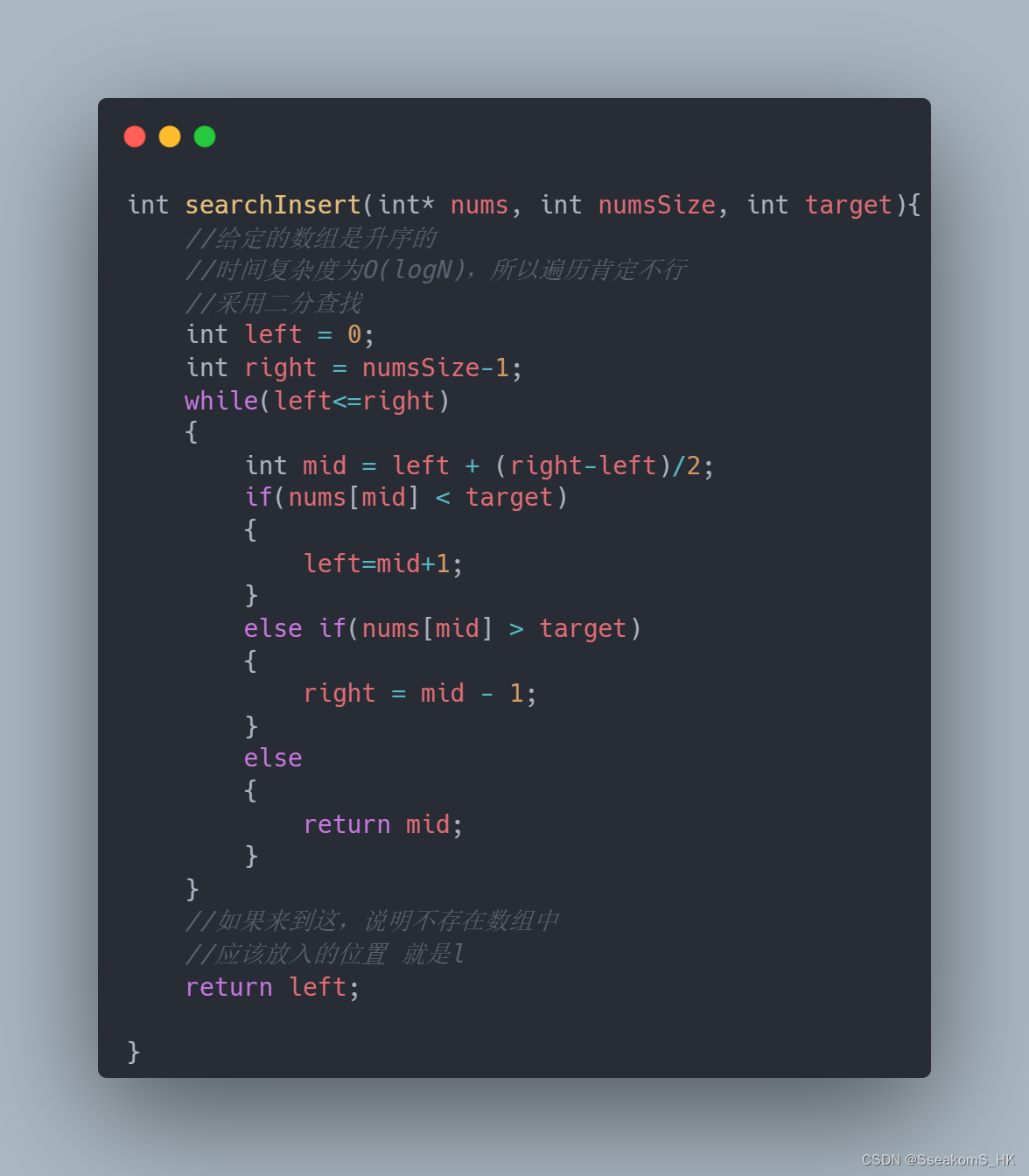

代码示例:

from transformers import BertTokenizer, BertForMaskedLM import torch tokenizer = BertTokenizer.from_pretrained('bert-base-uncased') model = BertForMaskedLM.from_pretrained('bert-base-uncased') input_text = "The capital of France is [MASK]." inputs = tokenizer(input_text, return_tensors='pt') outputs = model(**inputs) predictions = torch.argmax(outputs.logits, dim=-1) predicted_token = tokenizer.decode(predictions[0]) print(predicted_token)T5(Text-To-Text Transfer Transformer):

T5将所有NLP任务转化为文本到文本的格式,通过多任务学习进行预训练。

代码示例:

from transformers import T5Tokenizer, T5ForConditionalGeneration tokenizer = T5Tokenizer.from_pretrained('t5-small') model = T5ForConditionalGeneration.from_pretrained('t5-small') input_text = "translate English to French: The capital of France is Paris." inputs = tokenizer(input_text, return_tensors='pt') outputs = model.generate(**inputs) translated_text = tokenizer.decode(outputs[0]) print(translated_text)

三、少样本学习和零样本学习

少样本学习的挑战

少样本学习(Few-Shot Learning)是指在仅有少量标注数据的情况下训练模型,使其能够在新任务上表现出色。零样本学习(Zero-Shot Learning)则是指在完全没有标注数据的情况下,依靠模型的先验知识处理新任务。这两种学习方法在NLP中具有重要意义,因为获取大量标注数据往往成本高昂且耗时。

少样本学习的主要挑战在于模型必须从有限的样本中学习到足够的信息,以便在新的任务上进行准确预测。零样本学习则要求模型具备强大的泛化能力和知识迁移能力,以应对从未见过的任务或类别。这两种方法的主要目标是提高数据利用效率,减少对大规模标注数据的依赖,从而推动NLP技术在数据稀缺场景中的应用。

先进方法

GPT-3:

- 概述:GPT-3是一个具有1750亿参数的大规模语言模型,通过无监督预训练和少量的监督微调,在少样本和零样本学习任务中表现出色。

- Few-Shot Learning示例:

import openai openai.api_key = 'YOUR_API_KEY' prompt = """ Translate the following English text to French: "The capital of France is Paris." """ response = openai.Completion.create( engine="text-davinci-003", prompt=prompt, max_tokens=60 ) print(response.choices[0].text.strip())T0(T5-based Zero-Shot Learner):

- 概述:T0是一个基于T5架构的模型,通过多任务学习和无监督数据增强,在零样本学习任务中表现出色。

- Zero-Shot Learning示例:

from transformers import T5Tokenizer, T5ForConditionalGeneration tokenizer = T5Tokenizer.from_pretrained('t5-large') model = T5ForConditionalGeneration.from_pretrained('t5-large') input_text = "Translate English to German: The weather is nice today." inputs = tokenizer(input_text, return_tensors='pt') outputs = model.generate(**inputs) translated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(translated_text)CLIP(Contrastive Language-Image Pre-Training):

- 概述:CLIP通过对图像和文本的对比学习,在少样本和零样本学习任务中取得了优异表现。

- Few-Shot Learning示例

import clip from PIL import Image model, preprocess = clip.load("ViT-B/32") image = preprocess(Image.open("example.jpg")).unsqueeze(0) text = clip.tokenize(["a diagram", "a dog", "a cat"]).to(model.device) with torch.no_grad(): image_features = model.encode_image(image) text_features = model.encode_text(text) logits_per_image, logits_per_text = model(image, text) probs = logits_per_image.softmax(dim=-1).cpu().numpy() print("Label probs:", probs)

四、跨模态学习

跨模态学习的概念

跨模态学习(Cross-Modal Learning)是指模型在多个不同模态(如文本、图像、语音)之间进行信息的相互转换和理解。跨模态学习的重要性在于它可以实现多种信息形式的融合,提高模型在处理复杂任务时的灵活性和鲁棒性。例如,通过跨模态学习,模型可以理解文本描述并生成相应的图像,或者通过图像推断出文本信息,从而实现更加自然和智能的人机交互。

代表性技术

CLIP(Contrastive Language-Image Pre-Training):

- 概述:由OpenAI开发,CLIP通过同时训练图像和文本的对比学习模型,使其能够理解和生成跨模态的内容。在训练过程中,模型通过最大化图像和对应文本的相似度来学习。

- 优势:CLIP能够在零样本情况下实现高效的图像分类、文本-图像检索等任务,展示了强大的泛化能力。

DALL-E:

- 概述:也是由OpenAI开发的,DALL-E通过将文本描述转换为图像生成。该模型能够根据文本提示生成高质量、逼真的图像,从而在跨模态内容生成上表现出色。

- 优势:DALL-E在多样化的图像生成任务中表现优异,能够生成具有创意和复杂细节的图像。

应用场景

图像生成:

- 通过跨模态学习,模型可以根据文本描述生成相应的图像。例如,DALL-E可以根据“一个骑在背上的蓝色独角兽”生成相应的图像,为内容创作和设计提供了强大的工具。

文本-图像检索:

- CLIP在文本-图像检索任务中表现出色,可以根据文本描述检索出相关的图像,或根据图像找到相应的文本描述。这在电子商务、图片搜索等应用中具有重要意义。

语音识别与生成:

- 跨模态学习还可以用于语音识别和生成任务,如将语音转换为文本或根据文本生成语音,进一步提升了语音助手和智能家居系统的智能化水平。

第五部分:可解释性和透明性

AI的可解释性问题

AI模型在决策过程中往往缺乏透明性,这是当前AI技术面临的一大挑战。复杂的深度学习模型,如神经网络,通常被视为“黑箱”,因为它们的决策过程难以被人类理解和解释。这种缺乏可解释性的特性在某些关键领域,如医疗诊断、金融决策和司法系统中,可能导致用户对AI系统的不信任和抵触情绪。

最新研究进展

可解释的深度学习模型:

- 概述:研究者们开发了一些方法,使得深度学习模型的决策过程更具解释性。例如,Attention机制可以帮助理解模型在处理特定任务时关注了哪些部分,从而揭示模型的内部工作原理。

- 例子:Transformer模型中的Attention机制通过可视化显示哪些输入部分在影响模型的输出。

可视化工具:

- 概述:各种可视化工具被开发出来,用于展示AI模型的内部状态和决策过程,如LIME(Local Interpretable Model-agnostic Explanations)和SHAP(SHapley Additive exPlanations)。

- 例子:LIME通过构建局部线性模型来解释单个预测,从而帮助用户理解模型的行为。

应用与影响

实际应用中的效果:

- 在实际应用中,增强AI模型的可解释性和透明性有助于提高用户对模型的信任度。例如,在医疗领域,医生可以更好地理解AI系统的诊断建议,从而做出更为准确的决策。

- 在金融领域,透明的AI决策过程有助于监管机构审查和批准自动化交易系统。

对用户信任度的提升:

- 可解释性和透明性技术在实际应用中的成功案例表明,它们能够显著提升用户对AI系统的信任度和接受度。例如,在司法系统中,透明的AI辅助决策系统能够减少偏见和误判,增强公众对司法公正性的信心。

通过增强AI模型的可解释性和透明性,不仅有助于提升模型在关键领域中的应用效果,还能够促使AI技术朝着更加负责任和可持续的方向发展。总结来看,跨模态学习和可解释性技术的进步为NLP和AI的发展带来了新的机遇和挑战,为实现更智能、更可靠的人工智能系统奠定了坚实基础。