目录

- 引言

- 第一部分:Groq简介

- 第二部分:Groq的特点与优势

- 1、高性能推理加速

- 2、近存计算技术

- 3、专用ASIC芯片设计

- 4、低延迟与高吞吐量

- 5、成本效益分析

- 6、易用性与集成性

- 7、软件与硬件的协同设计

- 第三部分:Groq的使用指南

- 1、准备工作

- 2、简单使用样例

- 3、结合Langchain使用

- 第四部分:Groq的不足与挑战

- 1、硬件成本考量

- 2、市场接受度与生态建设

- 3、与现有技术的兼容性问题

- 4、技术支持与社区活跃度

- 第五部分:未来展望

- 结语

引言

在人工智能的飞速发展中,机器学习和深度学习模型正变得越来越复杂,对计算能力的要求也随之水涨船高。AI推理,作为将训练好的模型应用于实际问题的过程,其效率和性能成为衡量AI解决方案商业可行性的关键因素。然而,传统的GPU在处理大规模AI推理任务时,面临着性能瓶颈和成本问题。

在这样的背景下,Groq公司凭借其创新的AI推理技术异军突起,被誉为"AI推理性能之王"。Groq的横空出世,不仅在技术层面上为AI推理带来了革命性的突破,更在商业应用上展现出巨大的潜力和价值。

Groq的LPU(Language Processing Unit)是一款专为大型语言模型推理设计的专用ASIC芯片,它以其卓越的性能和成本效益,向传统GPU在AI领域的统治地位发起了挑战。Groq的推理平台不仅能够提供无与伦比的推理速度,还能够大幅降低运营成本,为AI技术的普及和应用开辟了新的道路。

第一部分:Groq简介

Groq 最近因其作为当今最快的大型语言模型(LLM)推理解决方案之一而广受关注。LLM 实践者对于降低LLM响应的延迟非常感兴趣,因为延迟是一个重要的性能指标,它需要被优化以支持实时人工智能应用。目前,许多公司都在LLM推理领域展开竞争。

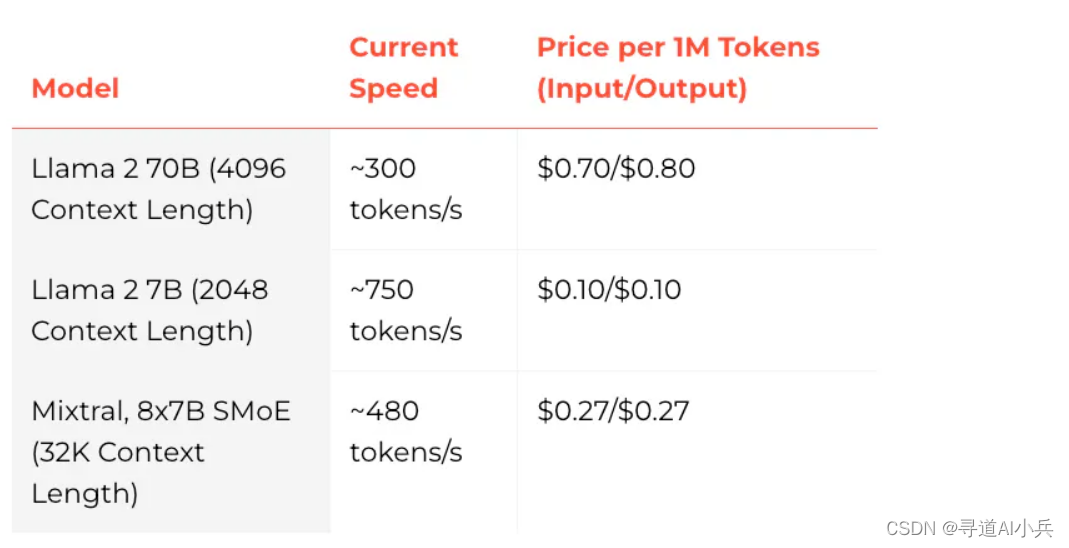

Groq 是那些声称在 Anyscale 的 LLMPerf 排行榜上,比其他顶尖的基于云的服务提供商快 18 倍的公司之一。Groq 目前通过其 API 提供了 Meta AI 的 Llama 2 70B 和 Mixtral 8x7B 等模型。这些模型由 Groq LPU™ 推理引擎驱动,该引擎是基于他们为运行 LLM 特别设计的定制硬件——语言处理单元(LPUs)构建的。

1、Groq的起源与发展

Groq是一家成立于2016年的AI芯片初创公司,由一群来自谷歌TPU团队的资深工程师创立。公司总部位于美国硅谷,是人工智能硬件领域的一颗新星。Groq的名字来源于“Grain

of Quantum”,寓意着公司致力于开发能够处理量子级别数据的高性能处理器。2、Groq的愿景与使命

Groq的愿景是打造能够推动人工智能进步的硬件技术,让机器学习模型的推理和训练更加高效、经济。公司的使命是通过创新的处理器设计,解决传统硬件在处理AI工作负载时的性能瓶颈,为开发者和企业提供更加强大、灵活的AI解决方案。

3、Groq的核心技术

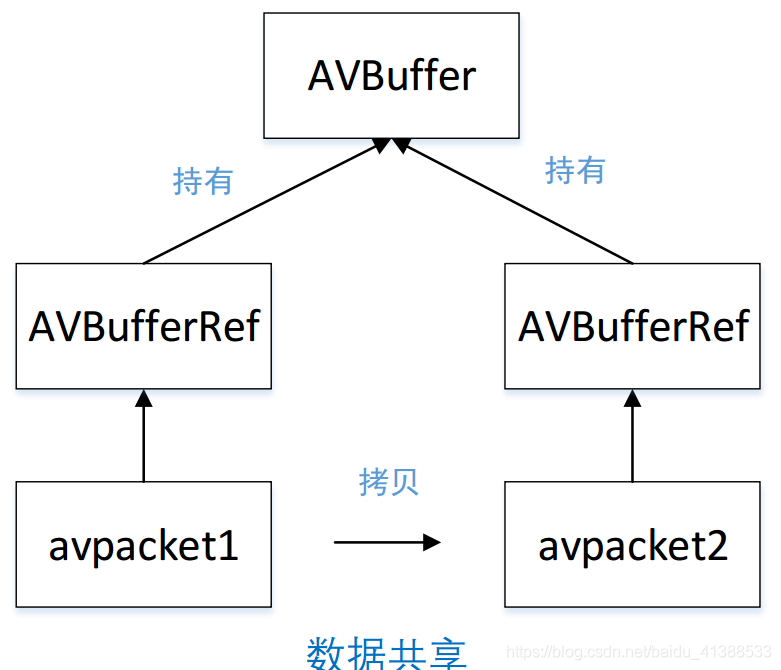

Groq的核心技术是其自研的LPU(Language Processing

Unit),这是一种专为AI推理和机器学习工作负载设计的处理器。LPU采用了先进的近存计算架构,将处理单元与存储紧密集成,大幅减少了数据传输延迟,提高了计算效率。4、Groq的市场定位

Groq的市场定位非常明确,它专注于为大型语言模型和复杂的机器学习任务提供高性能的推理平台。Groq的目标客户包括AI应用开发者、大型企业、云服务提供商等,旨在帮助他们提升AI应用的性能和降低运营成本。

5、Groq的行业影响

Groq的推出在AI硬件领域引起了广泛关注。其高性能、低延迟、低成本的特点,使其成为传统GPU在AI推理市场的有力竞争者。Groq的LPU被业界视为AI推理技术的一次重大突破,有望重塑AI硬件市场的格局。

第二部分:Groq的特点与优势

1、高性能推理加速

Groq的LPU专为AI推理设计,提供了前所未有的处理速度。与传统GPU相比,LPU在处理大型语言模型时的速度提高了10倍,这使得Groq在AI推理领域独树一帜。

特点解析:

- 极速响应:在问答等实时交互场景中,Groq能够实现几乎无感知的延迟。

- 高吞吐量:LPU能够每秒输出近500个token,远超现有解决方案。

2、近存计算技术

Groq的LPU采用了近存计算技术,这一创新设计显著减少了数据在处理器和存储之间的传输时间,从而大幅提升了计算效率。

优势体现:

- 低延迟:数据处理速度快,减少了等待时间。

- 高效率:优化了数据流,提高了整体运算效率。

3、专用ASIC芯片设计

Groq的LPU是一款专用的ASIC芯片,这意味着它是为了特定的任务——AI推理——而量身定制的,从而在性能上达到了极致优化。

设计优势:

- 定制化:针对AI推理的特定需求进行了优化。

- 性能优化:相较于通用芯片,ASIC在特定任务上表现更出色。

4、低延迟与高吞吐量

Groq平台的低延迟和高吞吐量特点,使其在处理大规模并发请求时表现出色,尤其适合需要快速响应的AI应用场景。

实际意义:

- 实时应用:适用于需要快速反馈的实时系统。

- 大规模处理:能够同时处理大量请求,保持高性能。

5、成本效益分析

尽管Groq的硬件成本较高,但其在推理速度和效率上的优势,使得总体拥有成本(TCO)具有很高的竞争力。

经济性考量:

- 运营成本:由于高效率,长期运营成本较低。

- 性价比:在性能大幅提升的同时,成本相对较低。

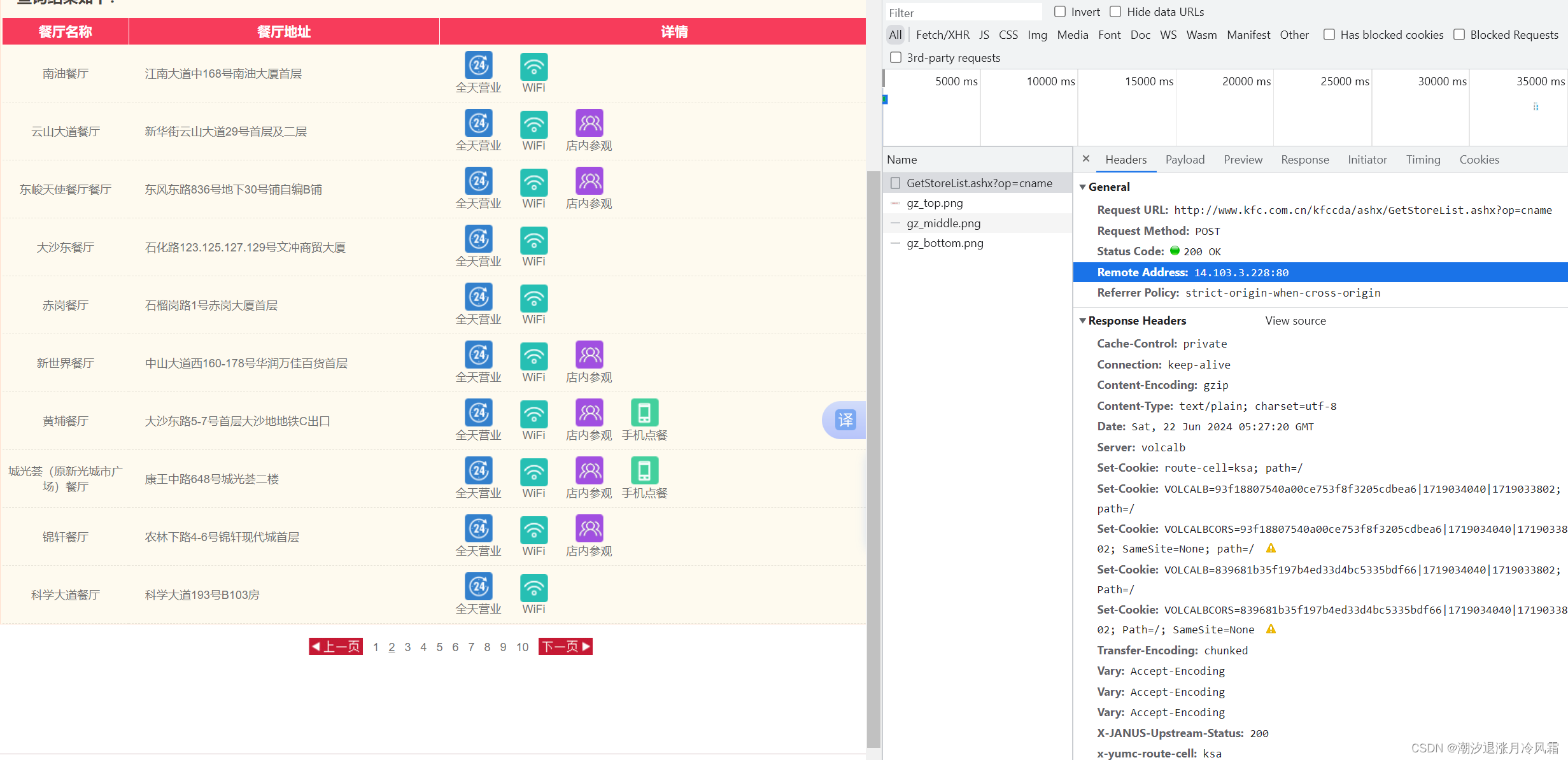

6、易用性与集成性

Groq提供了易于使用的API和工具,使得开发者可以快速集成Groq的推理服务到现有的AI应用中。

使用便捷性:

- API接入:提供简单直观的API,方便调用。

- 快速集成:支持多种开发环境,易于集成。

7、软件与硬件的协同设计

Groq的软件和硬件是协同设计的,确保了在各种应用场景下都能发挥最佳性能。

设计协同:

- 优化匹配:软硬件紧密结合,实现最优性能。

- 易于开发:为开发者提供了强大的工具和库。

第三部分:Groq的使用指南

1、准备工作

开始使用Groq之前,需要进行一些基本的准备工作,包括环境配置和账户注册。

访问Groq官方网站进行注册,创建账户后,获取API密钥,这是调用Groq服务的必要凭证。

2、简单使用样例

安装依赖

!pip install groq

代码样例

import os

from groq import Groq

client = Groq(

# This is the default and can be omitted

api_key=os.environ.get("GROQ_API_KEY"),

)

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "Explain the importance of low latency LLMs",

}

],

model="llama3-8b-8192",

)

print(chat_completion.choices[0].message.content)

3、结合Langchain使用

安装依赖

!pip install langchain-groq

导入依赖

# 导入必要的库。

from langchain_core.prompts import ChatPromptTemplate

from langchain_groq import ChatGroq

定义LLM

# 使用温度为0和“llama-2-70b”模型初始化ChatGroq对象。

llm = ChatGroq(temperature=0, model_name="llama-2-70b")

测试

# 定义介绍AI助手能力的系统消息。

system = "You are an expert Coding Assistant."

# 定义用户输入的占位符。

human = "{text}"

# 创建一个聊天提示,包含系统和用户消息。

prompt = ChatPromptTemplate.from_messages([("system", system), ("human", human)])

# 使用用户的输入调用聊天链。

chain = prompt | llm

response = chain.invoke({"text": "Write a simple code to generate Fibonacci numbers in Rust?"})

# 打印回复。

print(response.content)

第四部分:Groq的不足与挑战

尽管Groq在AI推理领域展现出了卓越的性能和多方面的优势,作为一项新兴技术,它也面临着一些挑战和不足之处。本章节将探讨Groq在普及和应用过程中可能遇到的问题。

1、硬件成本考量

Groq的LPU虽然在性能上具有显著优势,但其硬件成本相对较高。高昂的初期投资可能会让一些企业和开发者望而却步。

挑战分析:

- 初期投资:对于许多企业来说,硬件的购买成本是一个重要的考量因素。

- 成本回收:需要评估高性能带来的长期收益是否能覆盖初期投资。

2、市场接受度与生态建设

作为市场的新进入者,Groq需要时间来建立用户信任和市场接受度。此外,生态系统的建设也是其成功的关键。

发展障碍:

- 用户信任:需要时间来证明其技术的稳定性和可靠性。

- 生态系统:需要构建一个支持开发者和合作伙伴的生态系统。

3、与现有技术的兼容性问题

Groq的LPU是为特定类型的AI工作负载设计的,可能与现有的一些应用和框架不完全兼容。

技术挑战:

- 应用迁移:现有应用迁移到Groq平台可能需要额外的开发工作。

- 框架支持:需要确保Groq平台与主流AI框架的兼容性。

4、技术支持与社区活跃度

作为新兴技术,Groq的技术支持和社区活跃度可能不如一些成熟的技术解决方案。

支持需求:

- 技术支持:需要提供及时有效的技术支持来帮助用户解决问题。

- 社区建设:活跃的社区可以促进知识共享和技术发展。

第五部分:未来展望

Groq以其在AI推理技术上的突破,预示着对现有计算范式的重塑。

技术革新潜力

- Groq的LPU设计预示着在处理大型AI模型方面的巨大潜力,特别是在需要快速、高效推理的场景中。

市场影响预测

- Groq可能会改变AI硬件市场的竞争格局,提供更具成本效益的解决方案,推动行业向更高性能的推理平台转型。

发展路线图

- Groq预计将继续技术创新,优化产品性能,同时探索跨行业应用,拓宽其市场影响力。

技术融合与创新

- 随着新技术的涌现,Groq可能会与量子计算等前沿技术融合,进一步增强其在AI领域的领先地位。

结语

Groq的创新技术为AI推理领域带来了新的动力,其高性能和成本效益的解决方案预示着AI硬件的未来趋势。对开发者而言,Groq提供了一个强大的工具,以实现更高效的AI应用开发。同时,它也为整个行业的发展注入了新活力,推动着向更高性能、更低成本的AI解决方案迈进。

展望未来,我们期待Groq继续推动技术边界,与新兴技术融合,为AI的进步贡献力量。随着技术的演进,Groq有望在AI技术的发展中扮演关键角色。

🎯🔖更多专栏系列文章:AIGC-AI大模型开源精选实践

😎 作者介绍:我是寻道AI小兵,资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索。

📖 技术交流:建立有技术交流群,可以扫码👇 加入社群,500本各类编程书籍、AI教程、AI工具等你领取!

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我,让我们携手同行AI的探索之旅,一起开启智能时代的大门!