搭建zookeeper、Kafka集群

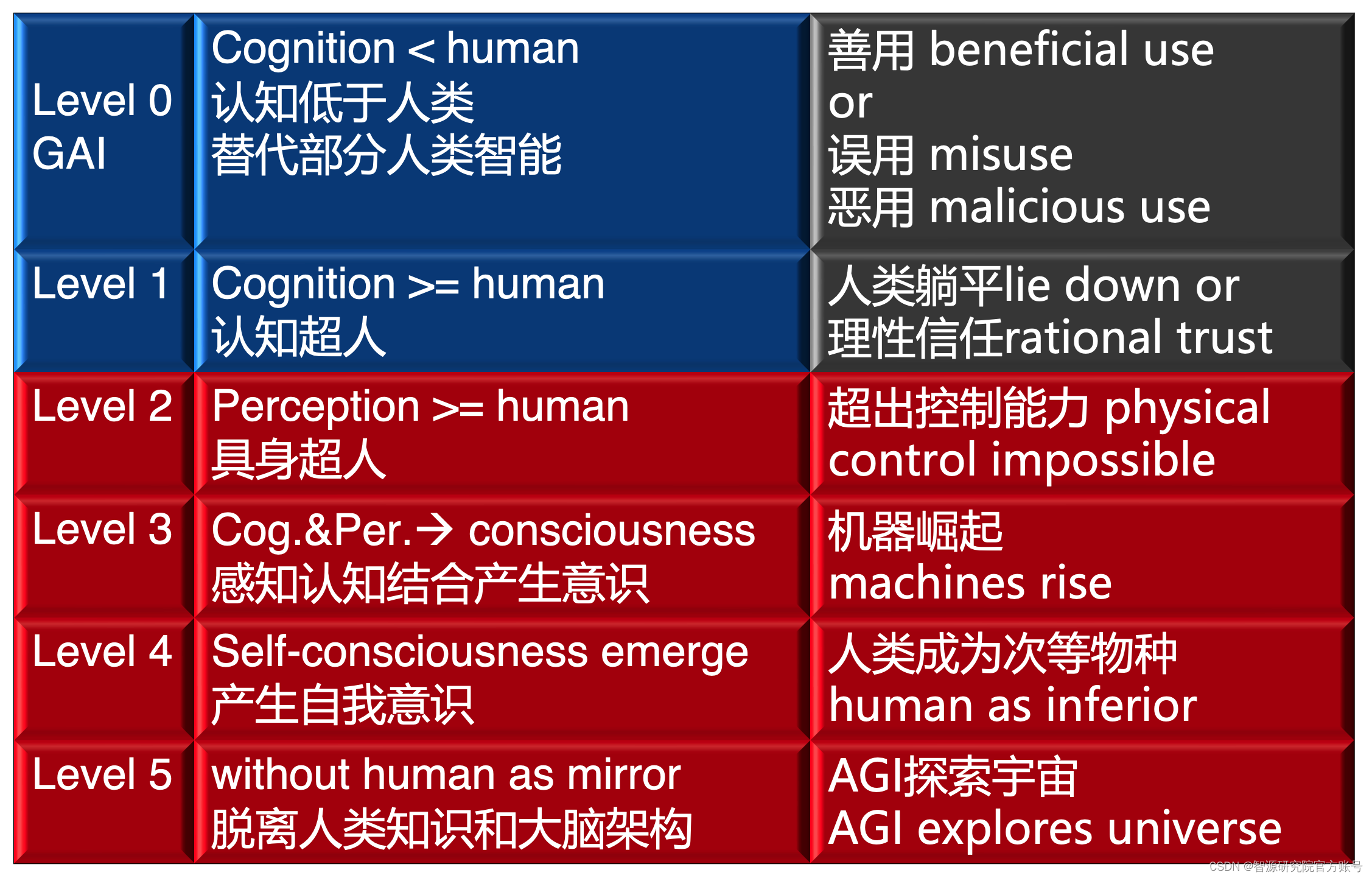

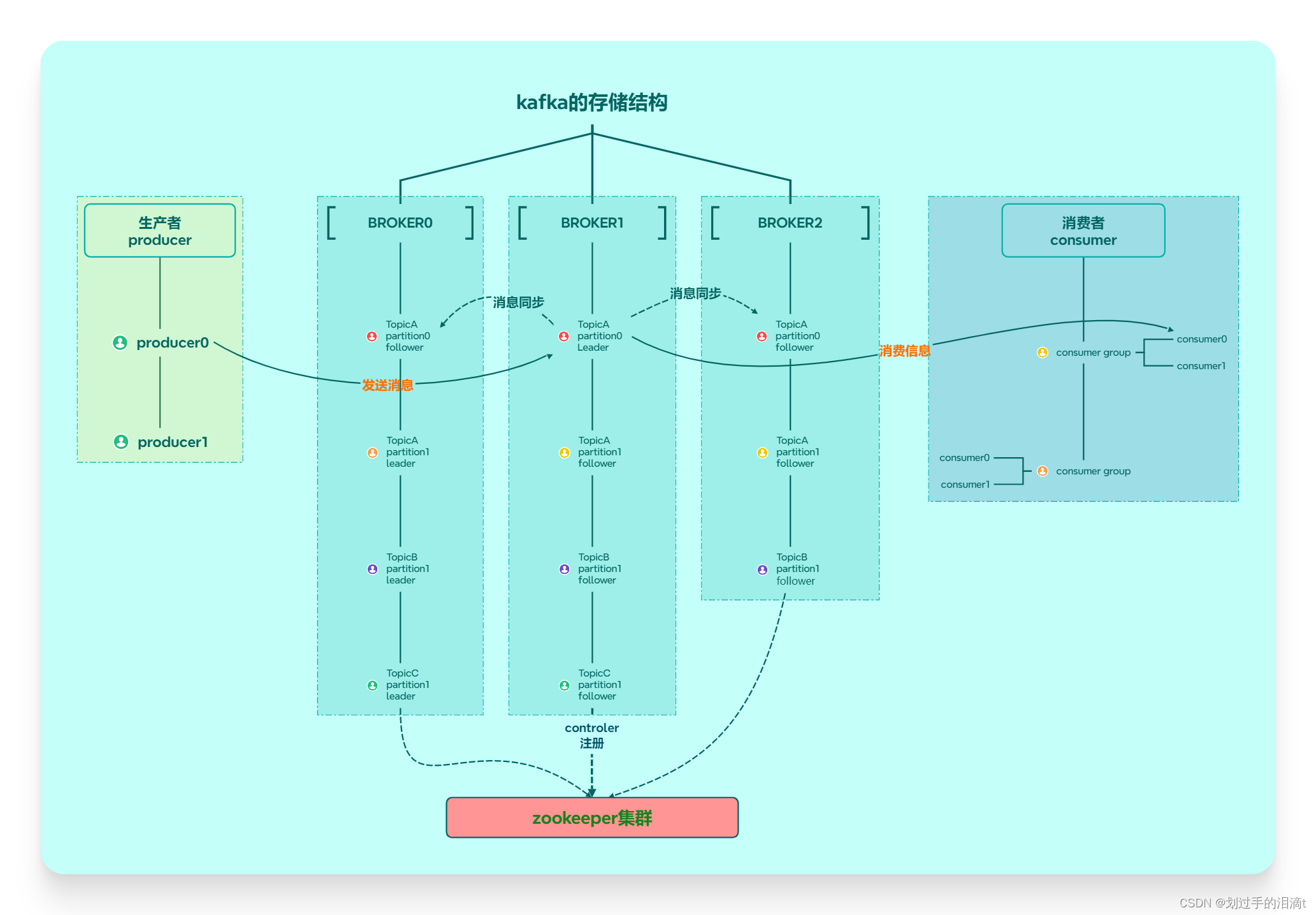

- 1、绘制kafka的存储结构、副本机制

- 2、搭建zookeeper集群

- 3、搭建kafka集群

- 4、使用kafka创建名为自己姓名汉语拼音的topic

- 5、查看topic的分区和副本策略

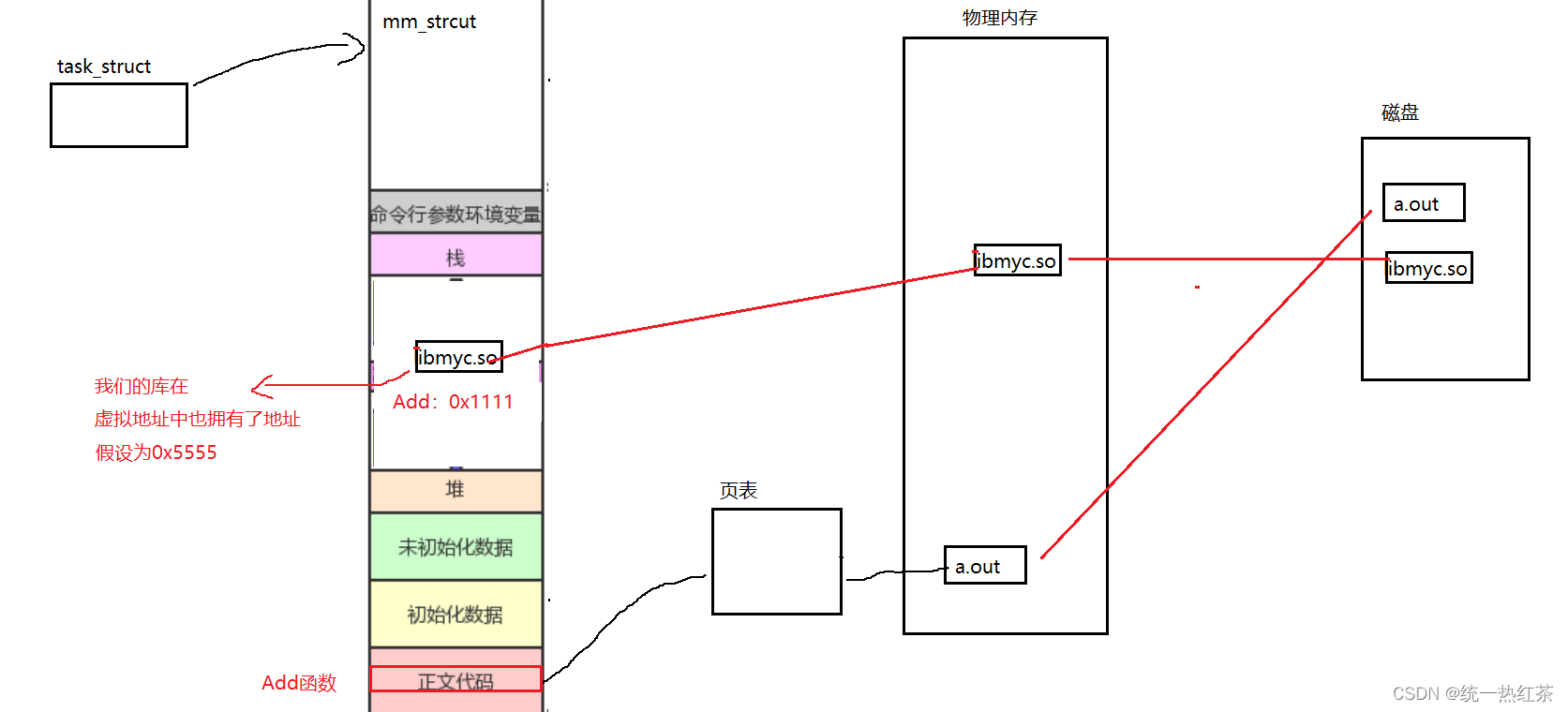

1、绘制kafka的存储结构、副本机制

2、搭建zookeeper集群

实验环境准备:

3台服务器:

| 192.168.99.133 | 192.168.99.141 | 192.168.99.156 |

|---|

1.安装前准备

#关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

#安装JDK

yum install -y java-1.8.0-openjdk java-1.8.0-openjdk-devel

java -version #查看一下 一般默认安装好了

cd /opt

wget https://archive.apache.org/dist/zookeeper/zookeeper-3.5.7/apache-zookeeper-3.5.7-bin.tar.gz

2.安装Zookeeper

cd /opt # 把安装包拖进去然后解压

tar -zxvf apache-zookeeper-3.5.7-bin.tar.gz

mv apache-zookeeper-3.5.7-bin /usr/local/zookeeper-3.5.7

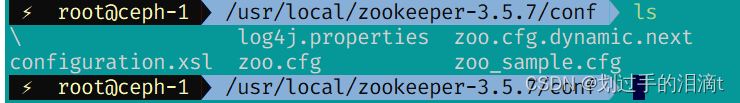

cd /usr/local/zookeeper-3.5.7/conf/

cp zoo_sample.cfg zoo.cfg

3.配置文件

vim zoo.cfg

#通信心跳时间,Zookeeper服务器与客户端心跳时间,单位毫秒

tickTime=2000

#Leader和Follower初始连接时能容忍的最多心跳数(tickTime的数量),这里表示为10*2s

initLimit=10

#Leader和Follower之间同步通信的超时时间,这里表示如果超过5*2s,Leader认 为Follwer死掉,并从服务器列表中删除Follwer

syncLimit=5

#修改,指定保存Zookeeper中的数据的目录,目录需要单独创建

dataDir=/usr/local/zookeeper-3.5.7/data

#添加, 指定存放日志的目录,目录需要单独创建

dataLogDir=/usr/local/zookeeper-3.5.7/logs

#客户端连接端口

clientPort=2181

#添加集群信息

server.1=192.168.99.133:3188:3288

server.2=192.168.99.141:3188:3288

server.3=192.168.99.156:3188:3288

---------------------------------------------------------------

server.A=B:C:D

●A是一个数字,表示这个是第几号服务器。集群模式下需要在zoo.cfg中dataDir指定的目录下创建一个文件myid,这个文件里面有一个数据就是A的值,Zookeeper启动时读取此文件,拿到里面的数据与zoo.cfg里面的配置信息比较从而判断到底是哪个server

●B是这个服务器的地址

●c是这个服务器Follower与集群中的Leader服务器交换信息的端口

●D是万一集群中的Leader服务器挂了,需要一个端口来重新进行选举,选出一个新的Leader,而这个端口就是用来执行选举时服务器相互通信的端口

如果指定节点不参加选举,在末尾加observer

server.3=192.168.19.102:3188:3288:observer

---------------------------------------------------------------

#在每个节点上创建数据目录和日志目录

mkdir /usr/local/zookeeper-3.5.7/data

mkdir /usr/local/zookeeper-3.5.7/logs

#在每个节点的dataDir指定的目录下创建一个myid的文件

#.133

echo 1 > /usr/local/zookeeper-3.5.7/data/myid

#.141

echo 2 > /usr/local/zookeeper-3.5.7/data/myid

#.156

echo 3 > /usr/local/zookeeper-3.5.7/data/myid

#配置Zookeeper 启动脚本

vim /etc/init.d/zookeeper

#!/bin/bash

#chkconfig:2345 20 90

#description: Zookeeper Service Control Script

ZK_HOME='/usr/local/zookeeper-3.5.7'

case $1 in

start)

echo "-----zookeeper启动-----"

$ZK_HOME/bin/zkServer.sh start

;;

stop)

echo "----zookeeper停止-------"

$ZK_HOME/bin/zkServer.sh stop

;;

restart)

echo "----zookeeper重启-------"

$ZK_HOME/bin/zkServer.sh restart

;;

status)

echo "-----zookeeper状态------"

$ZK_HOME/bin/zkServer.sh status

;;

*)

echo "Usage: $0 {start|stop|restart|status}"

esac

#拷贝配置好的Zookeeper 配置文件和脚本文件到其他机器上,多重执行跳过

scp -r zookeeper-3.5.7/ 192.168.99.141:/usr/local/

scp -r zookeeper-3.5.7/ 192.168.99.156:/usr/local/

scp -r /etc init.d/zookeeper 192.168.99.141:/etc/init.d/

scp -r /etc init.d/zookeeper 192.168.99.156:/etc/init.d/

service管理服务

#设置开机自启

chmod +x /etc/init.d/zookeeper

chkconfig --add zookeeper

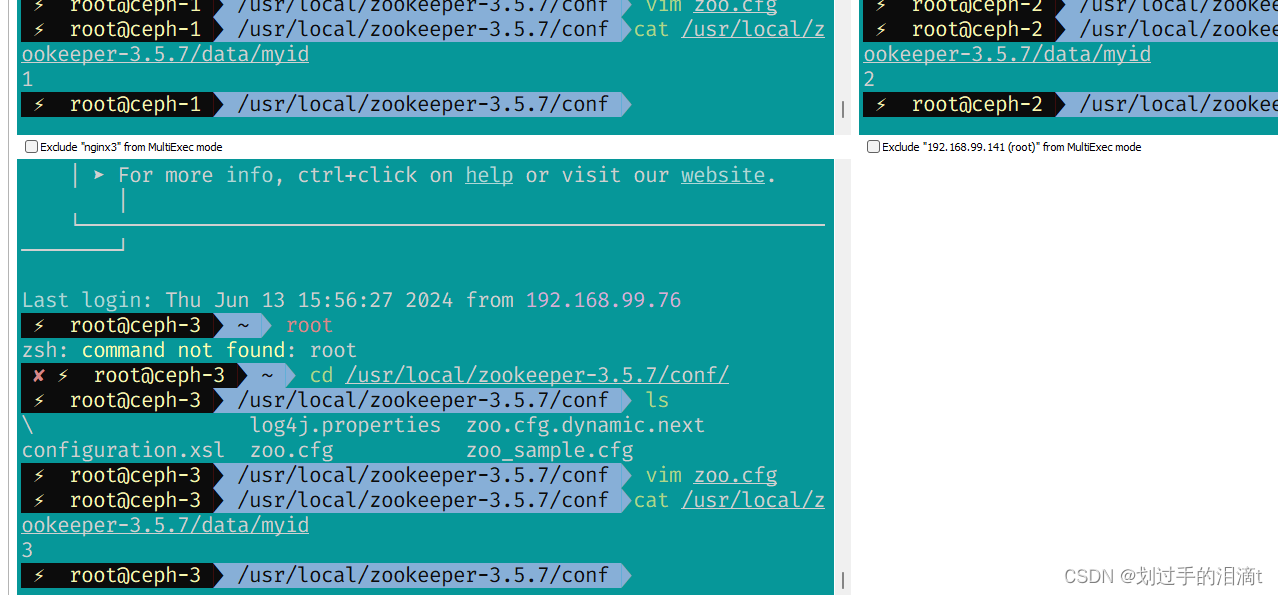

#分别启动 Zookeeper

service zookeeper start

#查看当前状态

service zookeeper status

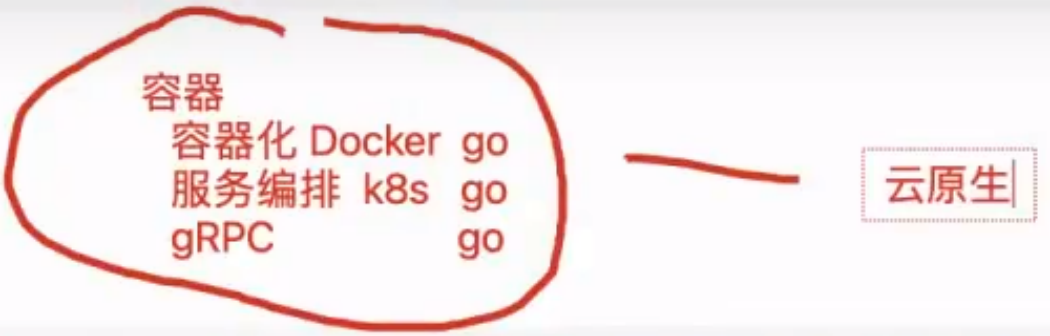

3、搭建kafka集群

环境准备: 基于zookeeper实验

3台服务器:

| 192.168.99.133 | 192.168.99.141 | 192.168.99.156 |

|---|

1.下载安装包

cd /opt

wget https://mirrors.tuna.tsinghua.edu.cn/apache/kafka/2.7.1/kafka_2.13-2.7.1.tgz

2.安装 Kafka

cd /opt/

tar zxvf kafka_2.13-2.7.1.tgz

mv kafka_2.13-2.7.1 /usr/local/kafka

#修改配置文件

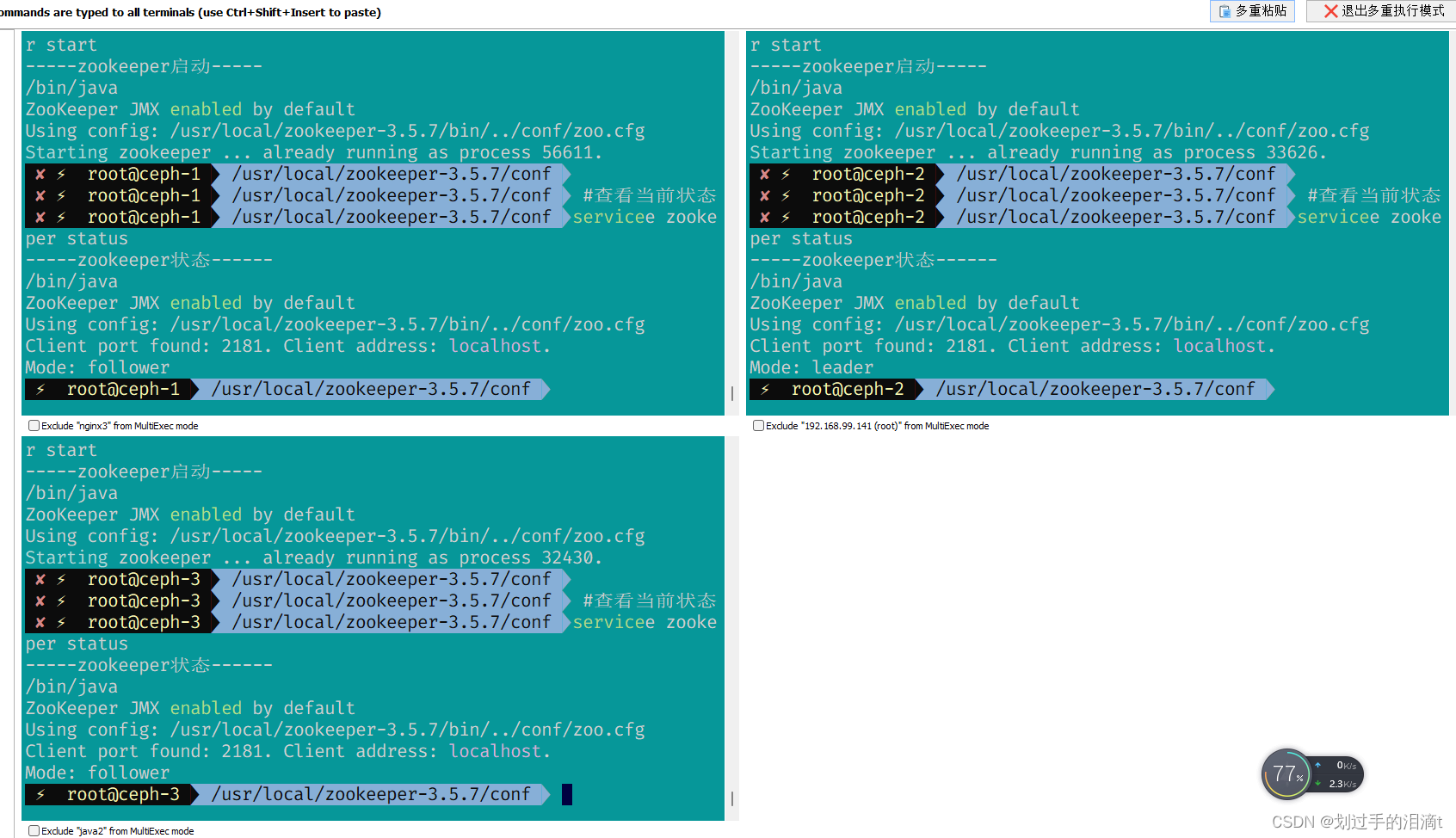

cd /usr/local/kafka/config/

cp server.properties{,.bak}

vim server.properties

broker.id=0 #21行,broker的全局唯一编号,每个broker不能重复,因此要在其他机器上配置 broker.id=1、broker.id=2

listeners=PLAINTEXT://192.168.19.100:9092 #31行,指定监听的IP和端口,可以修改每个broker的IP需区分开来,也可保持默认配置不用修改

num.network.threads=3 #42行,broker 处理网络请求的线程数量,一般情况下不需要去修改

num.io.threads=8 #45行,用来处理磁盘IO的线程数量,数值应该大于硬盘数

socket.send.buffer.bytes=102400 #48行,发送套接字的缓冲区大小

socket.receive.buffer.bytes=102400 #51行,接收套接字的缓冲区大小

socket.request.max.bytes=104857600 #54行,请求套接字的缓冲区大小

log.dirs=/usr/local/kafka/logs #60行,kafka运行日志存放的路径,也是数据存放的路径

num.partitions=1 #65行,topic在当前broker上的默认分区个数,会被topic创建时的指定参数覆盖

num.recovery.threads.per.data.dir=1 #69行,用来恢复和清理data下数据的线程数量

log.retention.hours=168 #103行,segment文件(数据文件)保留的最长时间,单位为小时,默认为7天,超时将被删除

log.segment.bytes=1073741824 #110行,一个segment文件最大的大小,默认为 1G,超出将新建一个新的segment文件

zookeeper.connect=192.168.19.100:2181,192.168.19.101:2181,192.168.19.102:2181 #123行,配置连接Zookeeper集群地址

# 如果设备延迟高,可以将zookeeper的连接超时时间改高一些

zookeeper.connection.timeout.ms=30000

#修改环境变量

vim /etc/profile

export KAFKA_HOME=/usr/local/kafka

export PATH=$PATH:$KAFKA_HOME/bin

source /etc/profile

#配置 Kafka 启动脚本

vim /etc/init.d/kafka

#!/bin/bash

#chkconfig:2345 22 88

#description:Kafka Service Control Script

KAFKA_HOME='/usr/local/kafka'

case $1 in

start)

echo "---------- Kafka 启动 ------------"

${KAFKA_HOME}/bin/kafka-server-start.sh -daemon ${KAFKA_HOME}/config/server.properties

;;

stop)

echo "---------- Kafka 停止 ------------"

${KAFKA_HOME}/bin/kafka-server-stop.sh

;;

restart)

$0 stop

$0 start

;;

status)

echo "---------- Kafka 状态 ------------"

count=$(ps -ef | grep kafka | egrep -cv "grep|$$")

if [ "$count" -eq 0 ];then

echo "kafka is not running"

else

echo "kafka is running"

fi

;;

*)

echo "Usage: $0 {start|stop|restart|status}"

esac

#设置开机自启

chmod +x /etc/init.d/kafka

chkconfig --add kafka

#分别启动 Kafka

service kafka start

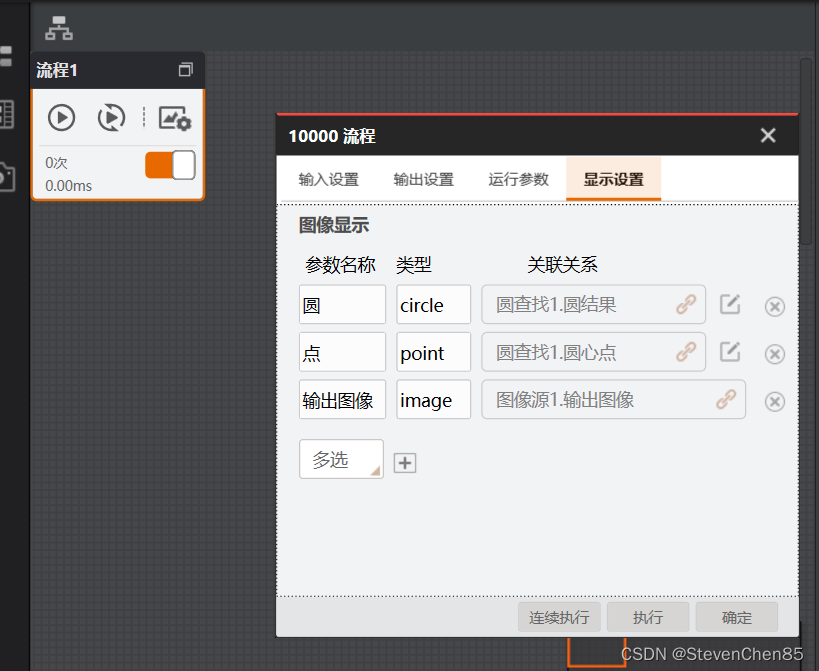

3.Kafka 命令行操作

#创建topic

kafka-topics.sh --create --zookeeper 192.168.99.133:2181,192.168.99.141:2181,192.168.99.156:2181 --replication-factor 2 --partitions 3 --topic test

-------------------------------------------------------------------------------------

--zookeeper:定义 zookeeper 集群服务器地址,如果有多个 IP 地址使用逗号分割,一般使用一个 IP 即可

--replication-factor:定义分区副本数,1 代表单副本,建议为 2

--partitions:定义分区数

--topic:定义 topic 名称

-------------------------------------------------------------------------------------

#查看当前服务器中的所有 topic

kafka-topics.sh --list --zookeeper 192.168.99.133:2181,192.168.99.141:2181,192.168.99.156:2181

#查看某个 topic 的详情

kafka-topics.sh --describe --zookeeper 192.168.99.133:2181,192.168.99.141:2181,192.168.99.156:2181

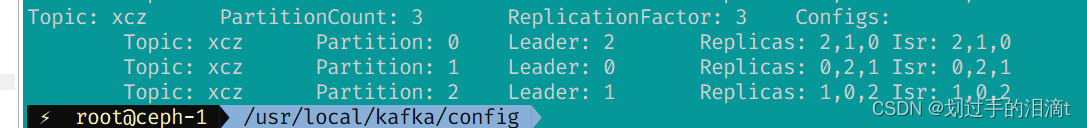

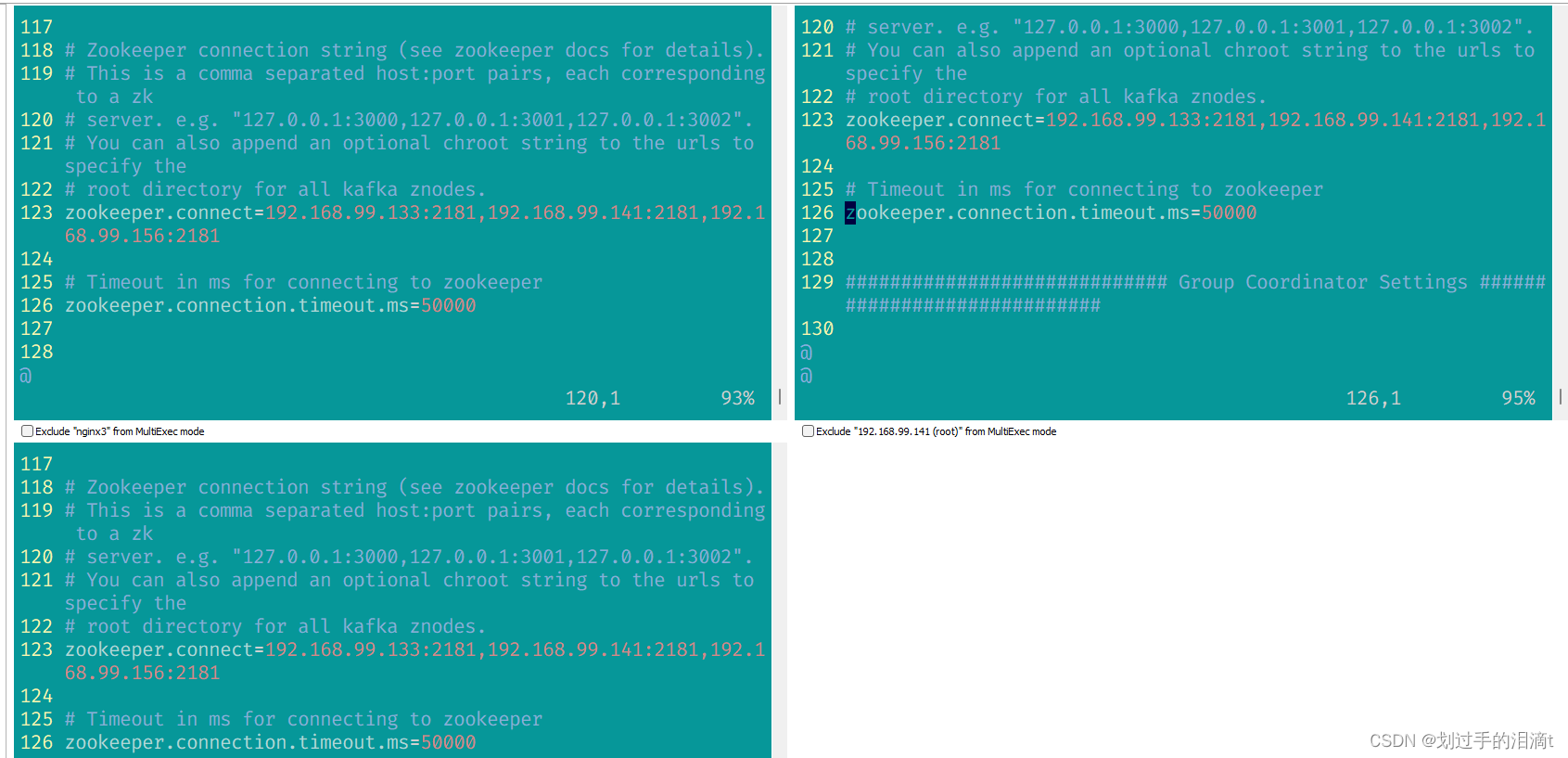

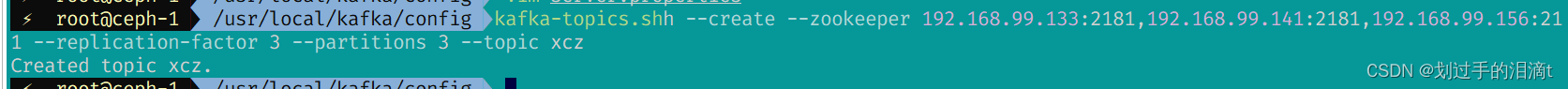

4、使用kafka创建名为自己姓名汉语拼音的topic

kafka-topics.sh --create --zookeeper 192.168.99.133:2181,192.168.99.141:2181,192.168.99.156:2181 --replication-factor 3 --partitions 3 --topic xcz

5、查看topic的分区和副本策略

kafka-topics.sh --describe --zookeeper 192.168.99.133:2181,192.168.99.141:2181,192.168.99.156:2181