2024年6月15日,为期 2 天的北京智源大会圆满落下帷幕。本次大会围绕大语言模型、多模态模型、Agent、具身智能、数据新基建、AI系统、AI开源、AI for Science、AI安全等人工智能热门技术方向和焦点议题,召开了20+平行论坛,共计百场报告。

过去一年,大模型发展速度之快,行业纷纷探讨通用人工智能的实现路径与曙光,但AI安全问题的严重性与紧迫性不容忽视。

“当我们从不同层面对人工智能安全问题进行审视,除了对社会偏见,错误信息,潜在的工作替代或者大模型、自主机器人带来的大规模自动化而导致的工作流失,以及潜在的加速财富集中或财富两极化等问题有所了解,更应该关注人工智能可能带来新的经济体系和包括潜在的灾难性风险或误用事故,甚至可能导致延伸性的人类风险。人工智能安全已有很多声明和请愿,但更重要的是明确目标、投入资源、采取行动、共同应对风险。”

北京智源人工智能研究院学术顾问委员会主任张宏江在AI安全论坛的开幕致辞中对人工智能安全进行了预警和呼吁。今年3月,张宏江发起,智源研究院承办了中国首个AI安全国际对话高端闭门论坛——“北京AI安全国际对话”。张宏江与Yoshua Bengio担任论坛主席,邀请Geoffrey Hinton、Stuart Russell、姚期智、傅莹、薛澜等30余位专家,Anthropic、智谱AI、零一万物等国内外头部大模型企业,以及相关政府部门参与,联合签署了《北京AI安全国际共识》。

本次AI安全论坛,加州大学伯克利分校教授Stuart Russell,图灵奖得主姚期智,清华大学资深文科教授,苏世民学院院长薛澜,中国工程院院士、清华大学智能产业研究院(AIR)院长张亚勤,Google DeepMind前沿安全与治理主任Allan Dafoe,MIT人工智能与基础交互研究中心教授,未来生命研究所创始人Max Tegmark等专家分享了关于AI安全的观察洞见与前沿研究。

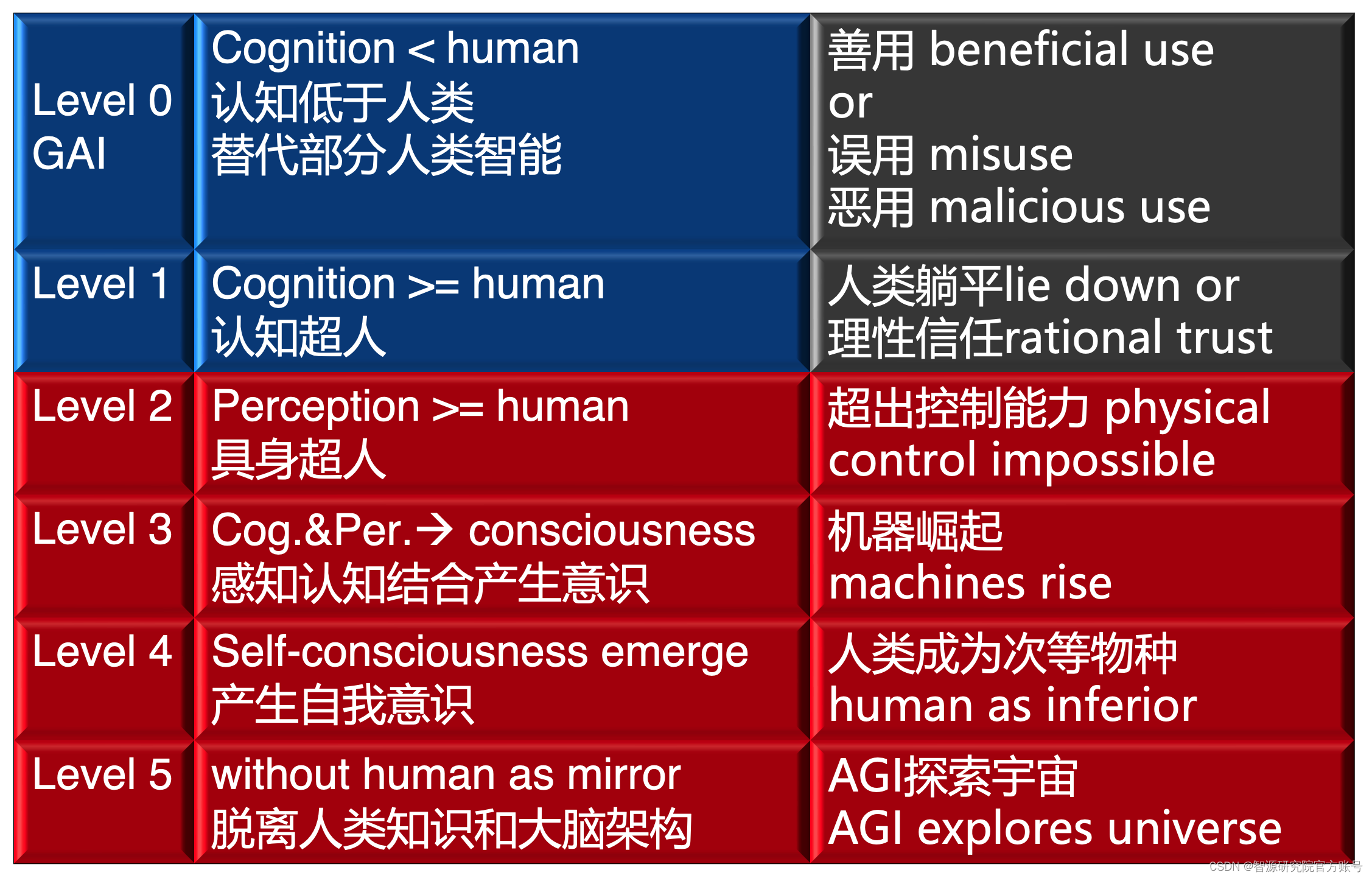

北京智源人工智能研究院理事长黄铁军在AI安全论坛闭幕致辞中表示,水深流急,AI安全已进入风险很突出的阶段。应对AI安全风险,需要对AGI水平和能力进行分级。

第0级

AI认知水平低于人类。对应DeepMind 2023年AGI分级之1-4级,还没达到AGI(Artificial General Intelligence)水平,只是GAI(General Artificial Intelligence ),目前大模型处于这一阶段。这一阶段的风险在于人类行为的规范,AI可能被善用、误用或恶用。即使出发点良好的善用,也可能因为对AI可能带来的正面和负面作用理解不足,造成伤害。

第1级

认知水平超越人类。对应DeepMind 2023年AGI分级之5级。大模型是用海量文本图像视频数据训练出来,认知能力可以超越人类,甚至超越顶尖科学家,具备了人类思考能实现的所有能力。但是没有身体执行,因此只能通过和人类的交流释放它的智慧。如果停留在这个阶段,人类仍然存在控制AGI的可能,可以选择与之理性对齐,借助它的能力解决人类智力难以解决的重大挑战性难题。这个阶段的风险在于,人类可能选择“躺平”,因为绝大多数人努力一生都达不到AGI的智力水平,于是干脆“躺平”,人类出现顶尖人才的机会越来越小,AGI智力水平反而快速提高,人类和AGI的智力水平差距越来越大,人类甘拜下风,失去主动权。

第2级

感知能力超越人类。AGI拥有了身体,也就是具身智能,视、听、触等感知性能远超人类,动作灵敏度和速度也远超人类,远远超出人类的物理控制能力,形态多样,遍布陆海空天,数量庞大,难以清除,人类面临巨大风险。

第3级

感知和认知能力同时超越人类,这样的物理实体与世界互动,产生意识。意识是生物体(特别是神经系统)作为复杂动力系统产生的自然现象,这个阶段的机器也可能出现意识。机器拥有了全面超越人类的感知、认知和行动力,机器霸权超越人类控制。

第4级

机器从具备意识进化为具备自我意识。动物都有意识,但是只有少数种类的动物有自我意识,从意识到自我意识没有绝对边界,神经系统达到一定水平的复杂程度,机器在与世界的互动中意识到“这是我”,从而产生欲望和诉求。这一阶段人类沦为次等物种,但AGI还是基于人类知识、类人脑神经网络训练出来的,是人类智能结构、机理和功能的高级镜像,或者说是人类的高级后代,掌握了主动权,有可能和人类和平共处。

第5级

AGI的认知不再源于人类知识,AGI神经结构超越人类大脑,形态和智力水平都超出了人类想象,可能适应不同的物理环境,开始宇宙智能进化的新历程。相比之下,人类作为地球环境的产物,最适合在地球上长期存在下去,如果能够在AGI协助下应对各种天灾人祸的话。

AI安全虽然身处“水深流急”的阶段,但是AI安全已经起航。未来,智源研究院将继续加强与国际社会在AI安全领域的合作,确保AI技术可控,迎接安全AGI的到来。