目录

一、引言

二、Dify在dockerhub被禁用后,如何部署、升级

2.1 网络及硬件条件

2.2 docker部署、升级方案

三、总结

一、引言

关于dify,之前力推过,大家可以跳转 AI智能体研发之路-工程篇(二):Dify智能体开发平台一键部署了解,今天主要以dify为例,分享一下当dockerhub镜像库被禁之后,如何部署和使用dockerhub上的image镜像。

二、Dify在网络环境不稳定的条件下,如何部署、升级

2.1 网络及硬件条件

- mac笔记本:网络稳定,arm64架构

- 服务器:网络不稳定,amd64架构

处理器架构可以通过uname -m查看

2.2 docker部署、升级方案

原方案(dockerhub未被禁用,直接通过docker compose拉取):

#首次部署:

git clone https://github.com/langgenius/dify

cd docker

docker compose up -d

#二次升级:

git checkout main

git pull origin main

cd docker

docker compose up -d新方案(无法直接从dockerhub拉取,先拉取到笔记本,再上传至服务器):

1、克隆项目、获取image名称和版本号

#首次部署

git clone https://github.com/langgenius/dify.git

cd docker

#查看docker-compose.yaml中的image名称和版本号

awk '/^ *image:/ {print $2}' docker-compose.yaml | uniq

2、针对每一个image,通过--platform指定linux/amd64/v4架构,pull拉取(务必指定与服务器匹配的架构!!!否则会将旧版本的image的tag附值为None,手动回退很麻烦!!!)

awk '/^ *image:/ {print $2}' docker-compose.yaml | uniq | xargs -n 1 docker pull --platform linux/amd64/v4

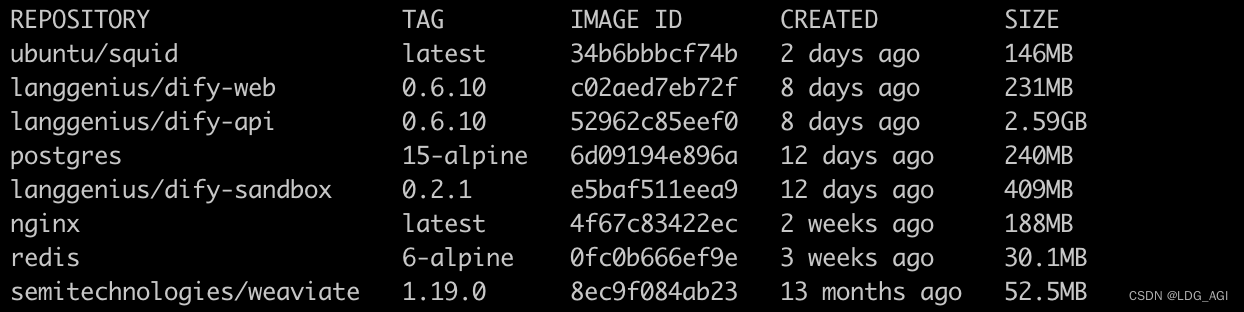

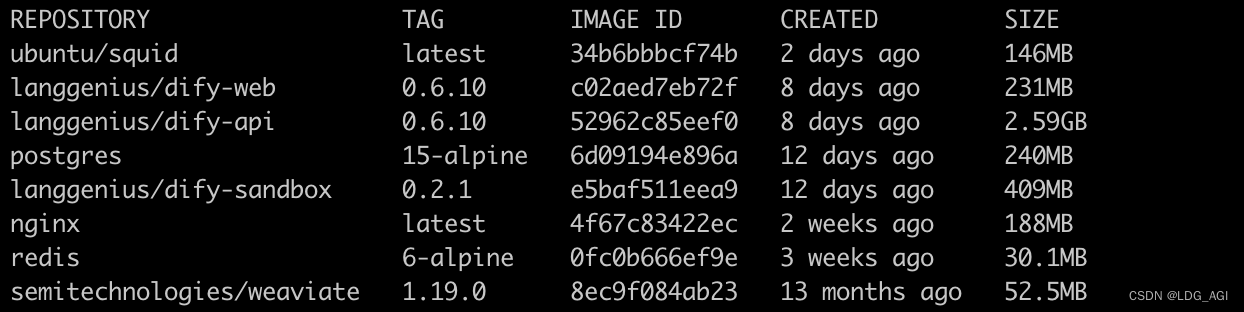

3、查看是否拉取成功

#查看是否拉取成功

docker images

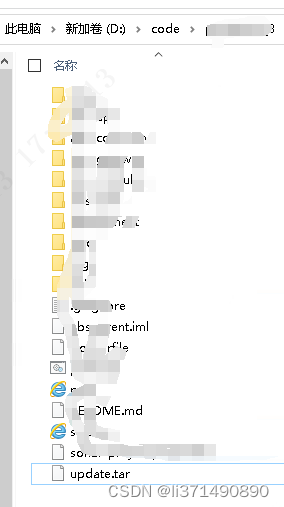

4、将所有镜像打包至amd64-dify-images-0.6.10.tar

awk '/^ *image:/ {print $2}' docker-compose.yaml | uniq | xargs docker save -o amd64-dify-images-0.6.10.tar5、上传至服务器,可以使用scp、rsync等

6、在服务器上将amd64-dify-images-0.6.10.tar内的所有镜像load到image库中,并查看运行情况

docker load -I amd64-dify-images-0.6.10.tar

docker images

7、采用docker compose up -d启动

docker compose up -d三、总结

当dockerhub被禁后,产生最大的影响就是服务器无法拉取项目image镜像,本文先在网络条件允许的mac笔记本上下载image,再将image镜像传至服务器应用。

最核心的问题还是linux服务器没办法科学上网。尝试过export https_proxy、http_proxy、all_proxy的方式,将笔记本作为代理服务器,没有生效。有什么linux下科学上网的方式,希望可以私信分享给我,求求了。

如果您还有时间,可以看看我的其他文章:

《AI—工程篇》

AI智能体研发之路-工程篇(一):Docker助力AI智能体开发提效

AI智能体研发之路-工程篇(二):Dify智能体开发平台一键部署

AI智能体研发之路-工程篇(三):大模型推理服务框架Ollama一键部署

AI智能体研发之路-工程篇(四):大模型推理服务框架Xinference一键部署

AI智能体研发之路-工程篇(五):大模型推理服务框架LocalAI一键部署

《AI—模型篇》

AI智能体研发之路-模型篇(一):大模型训练框架LLaMA-Factory在国内网络环境下的安装、部署及使用

AI智能体研发之路-模型篇(二):DeepSeek-V2-Chat 训练与推理实战

AI智能体研发之路-模型篇(三):中文大模型开、闭源之争

AI智能体研发之路-模型篇(四):一文入门pytorch开发

AI智能体研发之路-模型篇(五):pytorch vs tensorflow框架DNN网络结构源码级对比

AI智能体研发之路-模型篇(六):【机器学习】基于tensorflow实现你的第一个DNN网络

AI智能体研发之路-模型篇(七):【机器学习】基于YOLOv10实现你的第一个视觉AI大模型

AI智能体研发之路-模型篇(八):【机器学习】Qwen1.5-14B-Chat大模型训练与推理实战

AI智能体研发之路-模型篇(九):【机器学习】GLM4-9B-Chat大模型/GLM-4V-9B多模态大模型概述、原理及推理实战

AI智能体研发之路-模型篇(十):【机器学习】Qwen2大模型原理、训练及推理部署实战

《AI—Transformers应用》

【AI大模型】Transformers大模型库(一):Tokenizer

【AI大模型】Transformers大模型库(二):AutoModelForCausalLM

【AI大模型】Transformers大模型库(三):特殊标记(special tokens)

【AI大模型】Transformers大模型库(四):AutoTokenizer

【AI大模型】Transformers大模型库(五):AutoModel、Model Head及查看模型结构

【AI大模型】Transformers大模型库(六):torch.cuda.OutOfMemoryError: CUDA out of memory解决

【AI大模型】Transformers大模型库(七):单机多卡推理之device_map

【AI大模型】Transformers大模型库(八):大模型微调之LoraConfig