论文:https://arxiv.org/abs/2405.18407 (2024.05.30发布)

代码:https://github.com/G-U-N/Phased-Consistency-Model

一、论文要解决什么问题?效果如何? (需要先了解LCM模型)

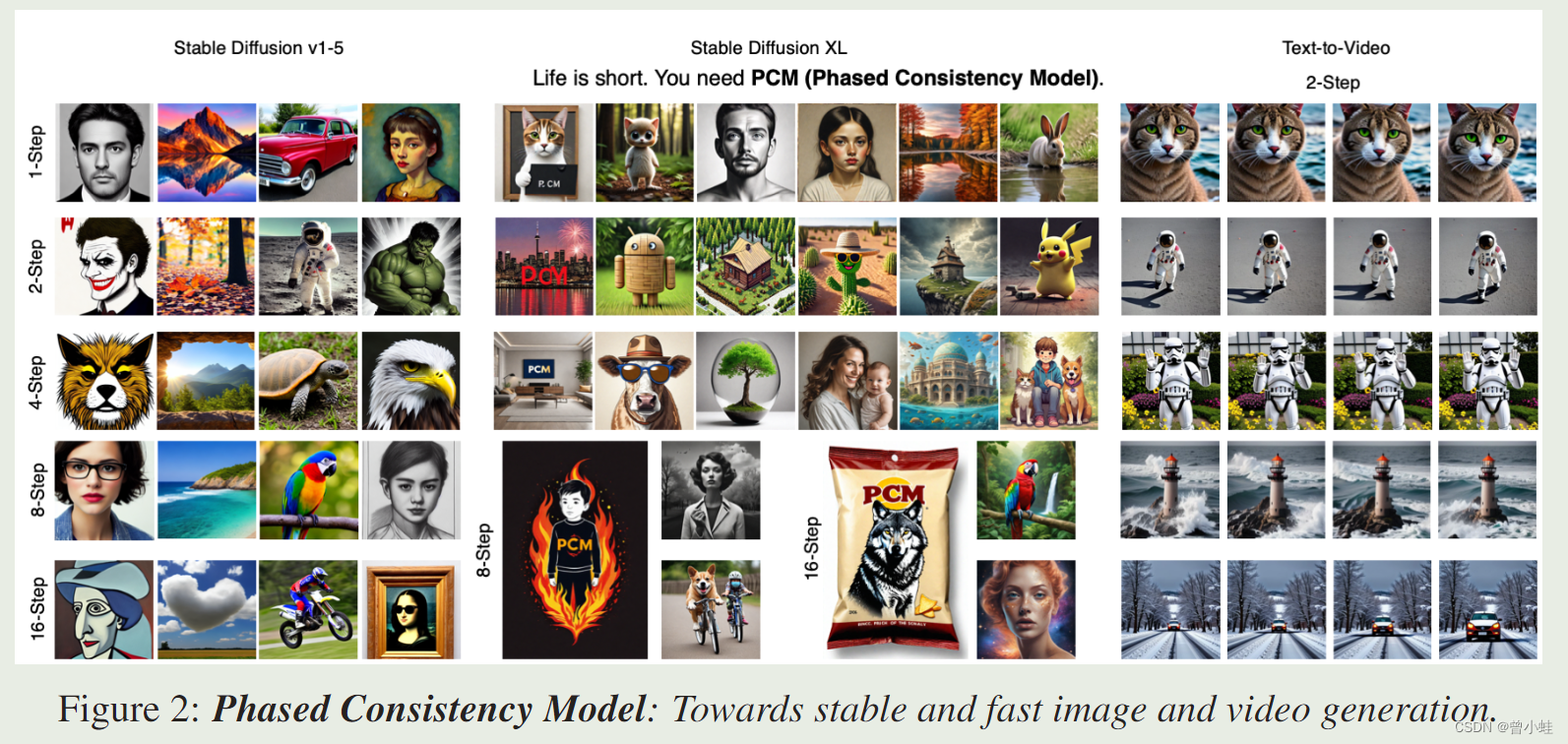

(阶段性一致性模型:朝着稳定、快速的图像和视频生成方向发展)

一致性模型(CM, Consistency Model)最近在加速生成扩散模型方面取得了显著进展。然而,其在潜在空间(即高分辨率、文本条件的图像生成,简称 LCM, Latent Consistency Model)中的应用仍不令人满意

LCM当前设计的三个主要缺陷:

- 一致性差:可以发现使用相同种子在不同推理步骤中生成的结果不一致。(见下图右上)

- 可控性(Controllability):尽管稳定扩散可以在广泛的推理步骤(即2-15步)中接受分类器无关指导(CFG, Classifier-Free Guidance),但配备LCM权重后,它们只能接受1-2步的CFG。较大的CFG值会导致曝光问题

- 效率(Efficiency):我们发现LCM在少数步骤设置中生成的结果质量较差,特别是在少于4步的推理中

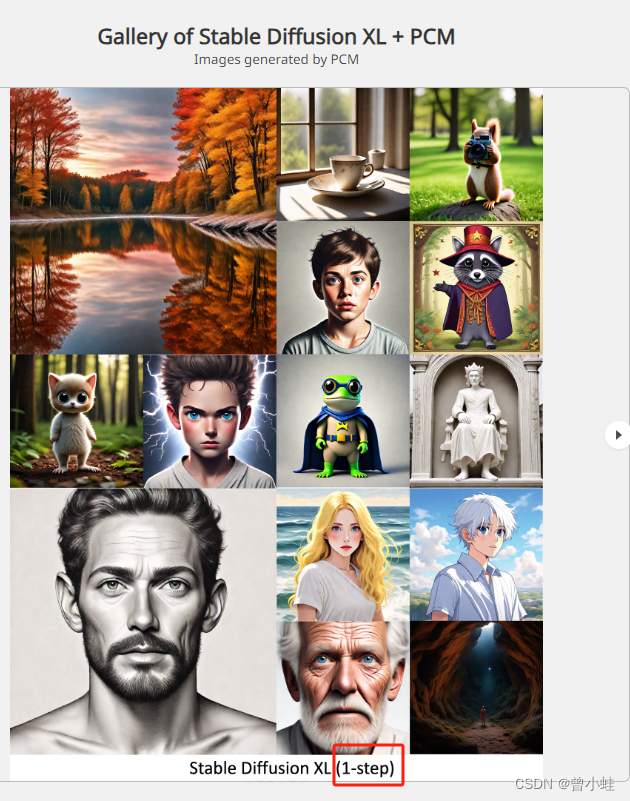

提出的PCM模型的生成效果?

采样1次

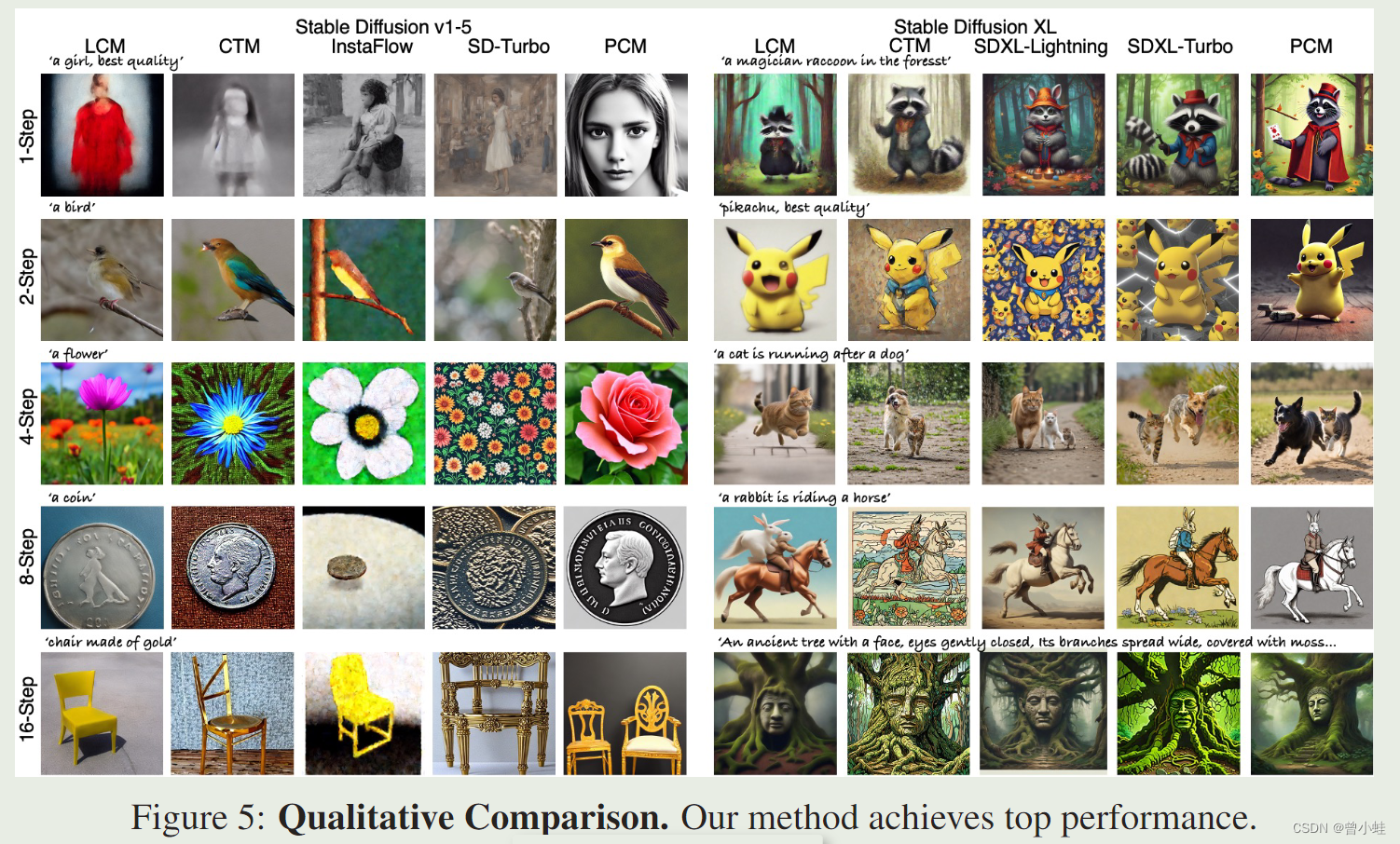

二、相关工作与对比

LCM (Latent Consistency Model) :https://github.com/luosiallen/latent-consistency-model

相关论文:“Latent Consistency Models: Synthesizing High-Resolution Images with Few-Step Inference”

相关论文:“LCM-LoRA: A Universal Stable-Diffusion Acceleration Module”

SDXL-Turbo:https://huggingface.co/stabilityai/sdxl-turbo

SDXL-Lightning: 2402.Progressive Adversarial Diffusion Distillation.: https://huggingface.co/ByteDance/SDXL-Lightning

InstaFlow!One-Step Stable Diffusion with Rectified Flow: https://github.com/gnobitab/InstaFlow

三、方法概述

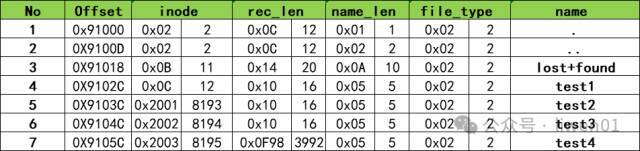

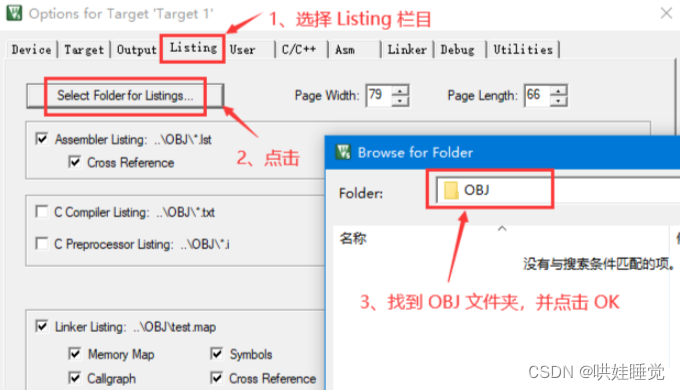

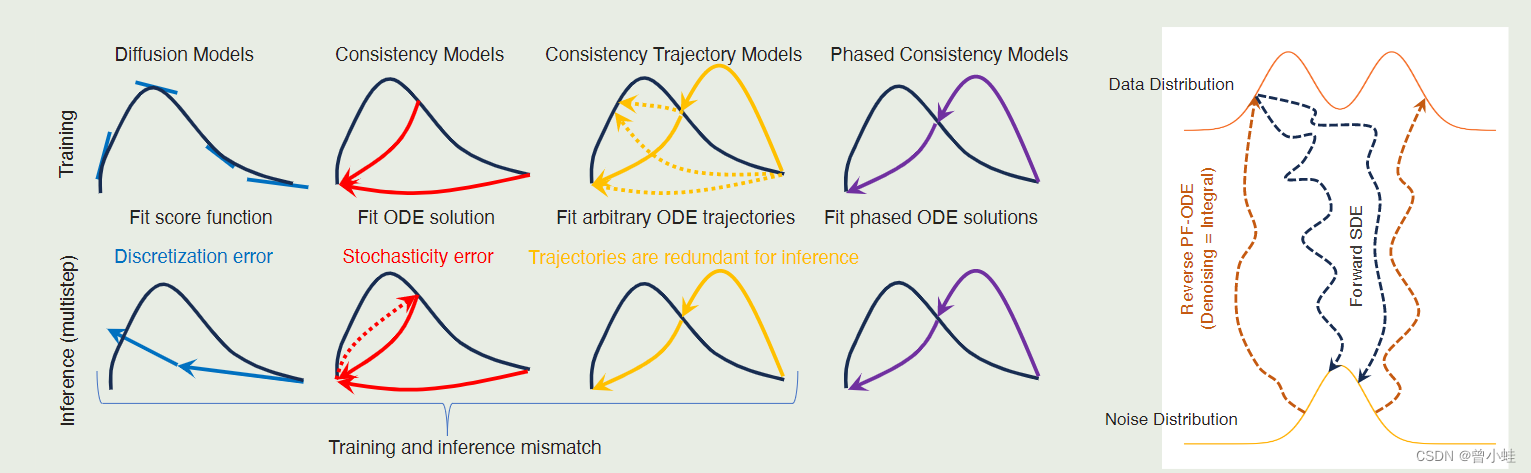

3.1 原论文图3:扩散模型和常微分方程(ODE)

左侧图

这张图展示了四种不同类型模型(扩散模型、一致性模型、一致性轨迹模型和逐步一致性模型)在训练和推理中的差异。

扩散模型 (Diffusion Models):扩散模型通过拟合得分函数来训练,即估计数据分布的梯度

一致性模型 (Consistency Models): 通过拟合ODE(常微分方程)解来训练。这种模型强制所有轨迹上的点映射到同一个解。

一致性轨迹模型 (Consistency Trajectory Models): 一致性轨迹模型通过拟合任意ODE轨迹来训练。即轨迹中的任意点对之间强制相同的预测。

逐步一致性模型 (Phased Consistency Models) :逐步一致性模型通过拟合分阶段的ODE解来训练。即将ODE轨迹分为多个子轨迹,并在每个子轨迹上强制执行一致性。

右侧图

展示了数据分布和噪声分布之间的转换过程。

- 橙色实线表示数据分布。

- 橙色虚线表示从数据分布到噪声分布的正向**SDE(随机微分方程)**过程。

- 蓝色虚线表示从噪声分布到数据分布的逆向PF-ODE(概率流ODE)过程。

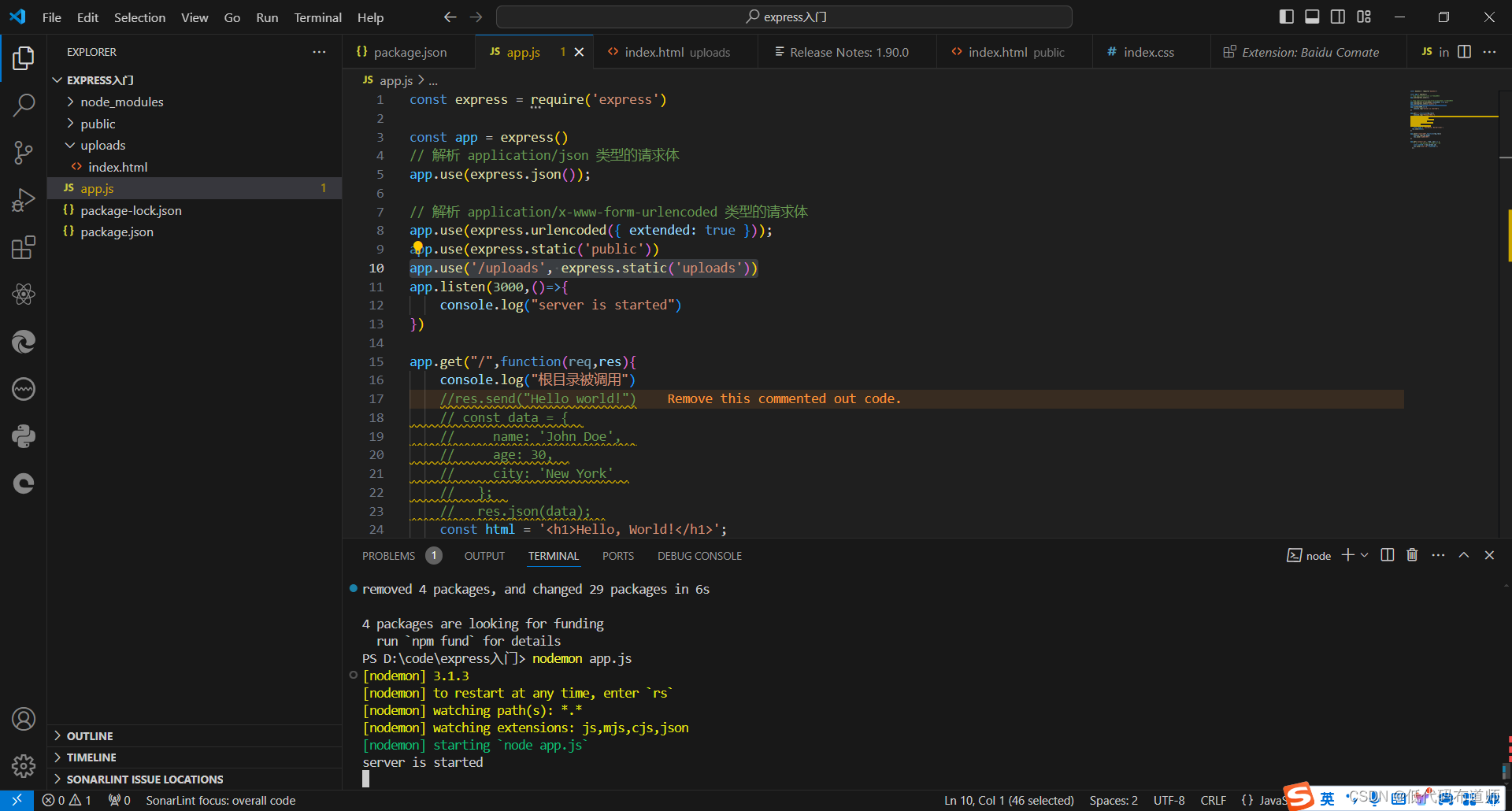

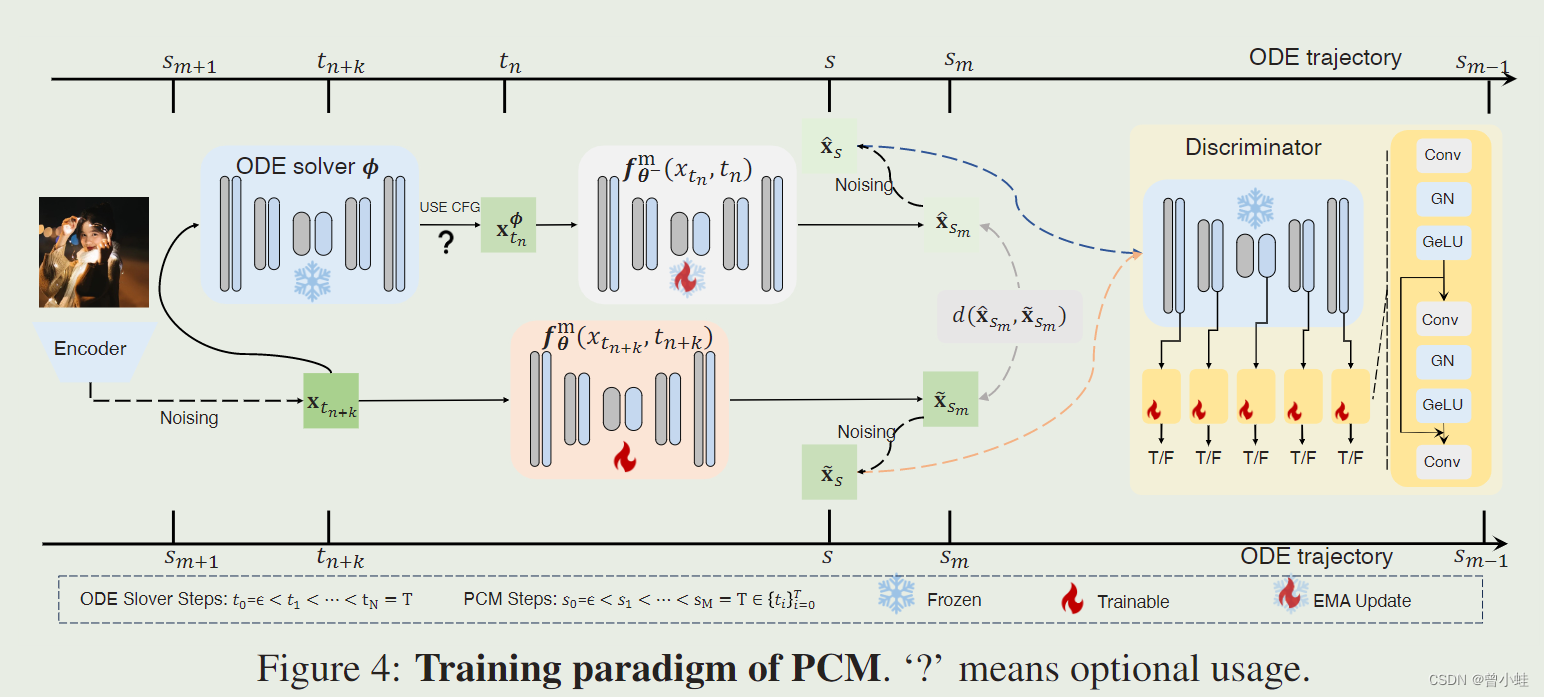

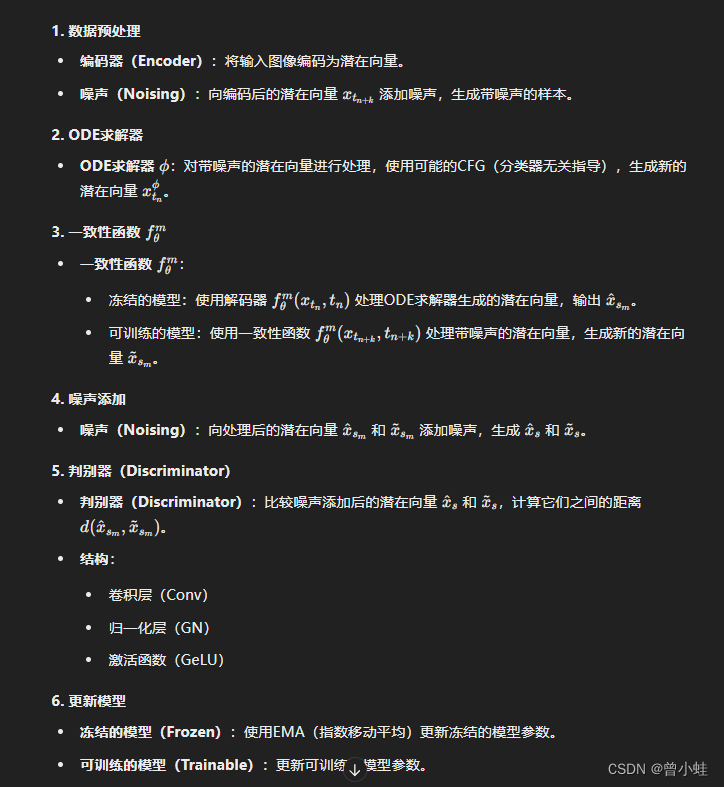

图4:逐步一致性模型 (Phased Consistency Models)的训练流程

这张图展示了逐步一致性模型(PCM)的训练流程。流程图从左到右展示了数据从编码到解码和对抗训练的全过程

附录