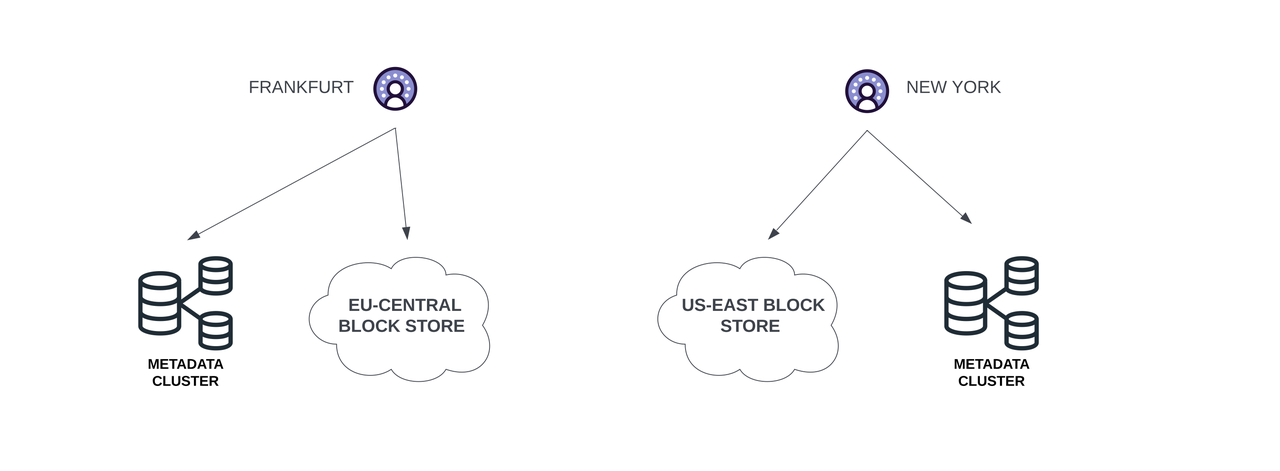

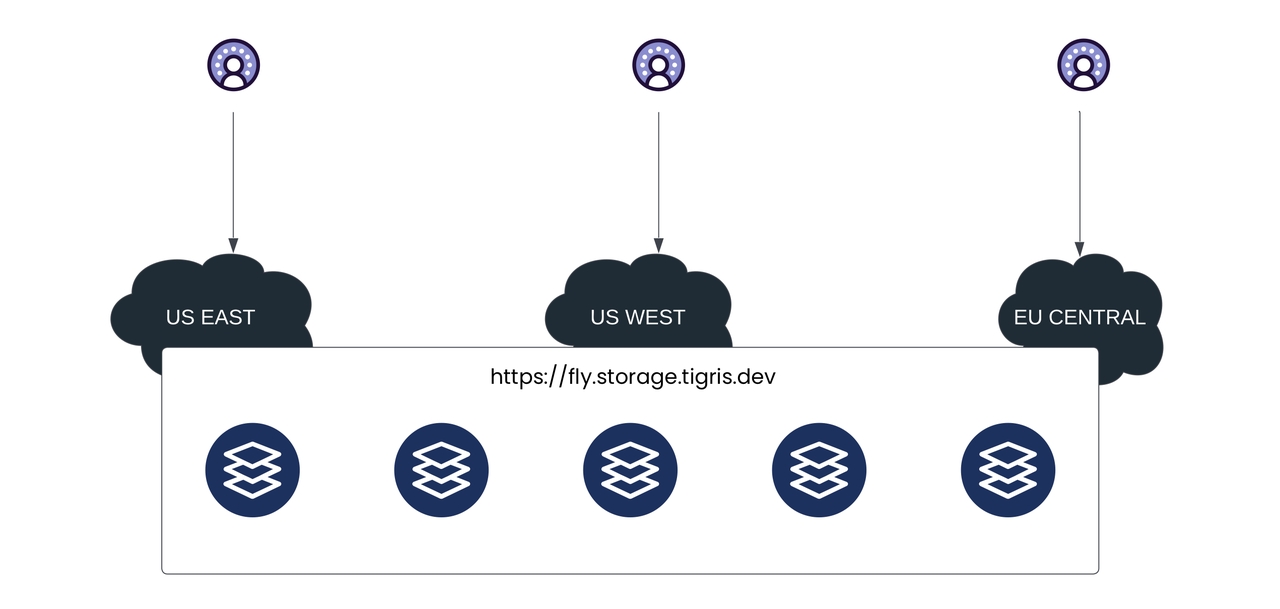

Tigris[1]是一个全球分布式的兼容 S3 的对象存储服务,它允许你存储和访问任意数量的数据,具有广泛的使用场景。Tigris 会自动且智能地将数据分布到靠近用户的位置,让用户无需担心数据复制和缓存复杂性。

你可以将 Tigris 用于多种场景,例如:

- 实时应用程序的存储

- 网页内容与媒体(图片、视频等)

- 物联网(IoT)应用程序的存储

- 数据分析、大数据及批处理

- 机器学习模型和数据集的存储

- 备份与归档 Tigris 兼容 S3 API。这意味着你可以在 Tigris 中使用标准的 S3 SDK、工具和库。本文将指导你如何将 AutoMQ[3] 集群部署在你私有数据中心的 Tigris 之上。

01

前置条件

- 一个可以正常使用的 Tigris 环境。如果你还没有可用的 Tigris 环境,可以参考其官方文档[8]获取。

- 准备 5 台主机用于部署 AutoMQ 集群。建议选择 2 核 16GB 内存的 Linux amd64 主机,并准备两个虚拟存储卷。

- 从 AutoMQ Github Releases 下载最新的正式二进制安装包,用于安装 AutoMQ。

- 为 Tigris 创建桶

a.设置环境变量来配置 AWS CLI 需要的 Access Key 和 Secret Key。

export AWS_ACCESS_KEY_ID=tid_avqGWWSohRwMErSDZoYAUOqcNiOYnyrzVEyatwqUlAskBBDCNA

export AWS_SECRET_ACCESS_KEY=tsec_4J9qtNpHC4E+c9mZeHTQv91uId7+8FbL7Ob6NvtiPJoo0301DU99uNTuOqFzX9b-UxAgklb.使用 AWS CLI 创建 S3 存储桶。

aws s3api create-bucket --bucket automq-data --endpoint=http://127.0.0.1:80

aws s3api create-bucket --bucket automq-ops --endpoint=http://127.0.0.1:80

Tips:

- Tigris 是一种基于 Fly.io 基础架构的全球缓存、兼容 S3 的对象存储服务,创建和管理桶完全通过 Fly CLI 进行,详细请前往 Fly 官网查看关于 Tigris 的文档。

- Tigris 提供了创建桶和 Access Key 的控制面板,你可以通过登陆 Fly 账号进行登陆查看。

02

安装并启动 AutoMQ 集群

配置S3 URL

第一步:生成 S3 URL

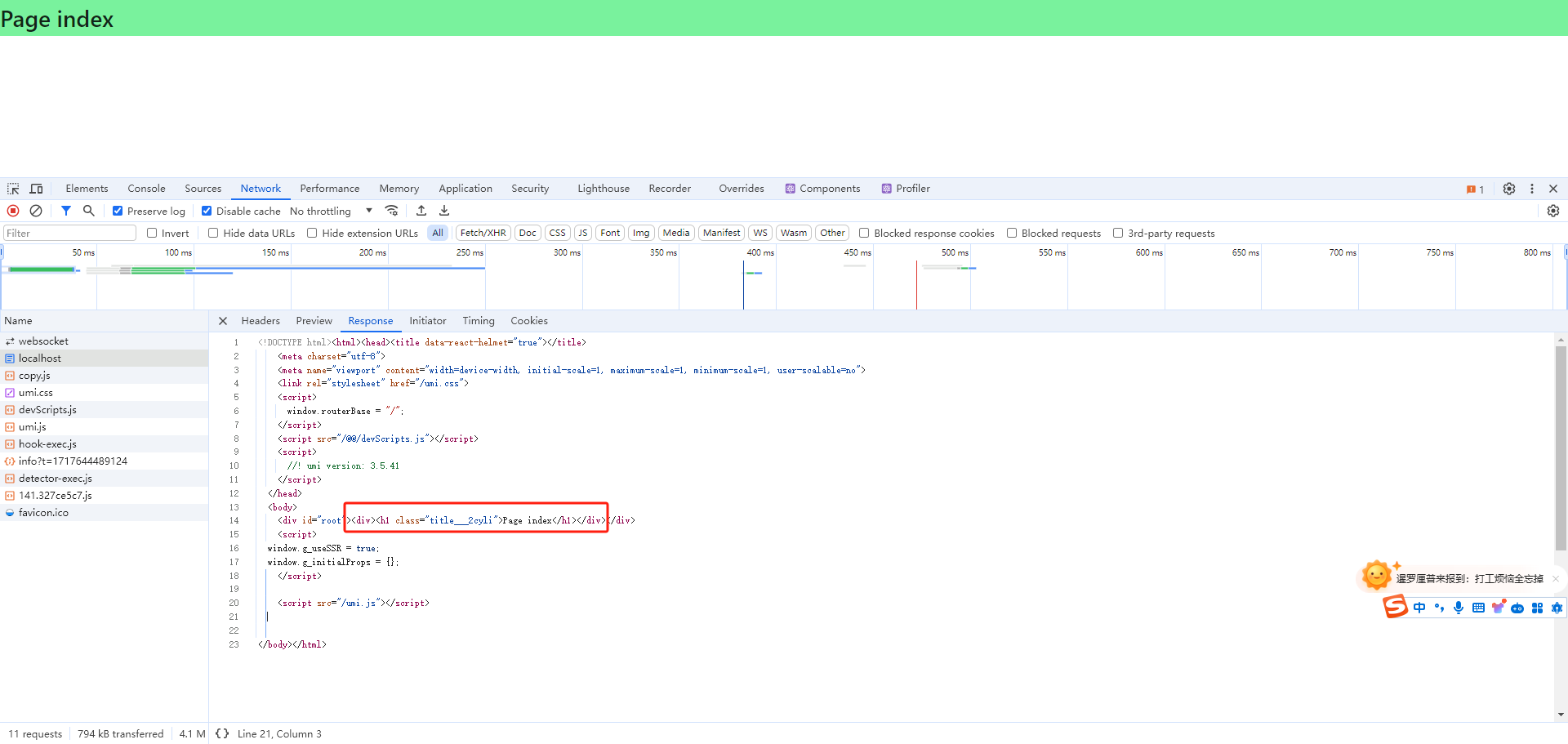

AutoMQ 提供了 automq-kafka-admin.sh 工具,用于快速启动 AutoMQ。只需提供包含所需 S3 接入点和身份认证信息的 S3 URL,即可一键启动 AutoMQ,无需手动生成集群 ID 或进行存储格式化等操作。

### 命令行使用示例

bin/automq-kafka-admin.sh generate-s3-url \

--s3-access-key=xxx \

--s3-secret-key=yyy \

--s3-region=cn-northwest-1 \

--s3-endpoint=s3.cn-northwest-1.amazonaws.com.cn \

--s3-data-bucket=automq-data \

--s3-ops-bucket=automq-ops关于 Fly[4]: fly.io 是一个容器化的部署平台,只需要一个 Dockerfile 文件就能部署代码到 fly.io 的服务器上,同时还自动生成域名。 Tigris 是一种基于 Fly 基础架构全球缓存的对象存储服务,在 Tigris 中,桶是固有的全局实体。这意味着桶中的对象存储在发起请求的区域。为了优化性能并减少延迟,这些对象会根据随时间观察到的访问模式智能地分布到其他区域。

输出结果

执行该命令后,将自动按以下阶段进行:

- 根据提供的 accessKey 和 secretKey 对 S3 基本功能进行探测,以验证 AutoMQ 和 S3 的兼容性。

- 根据身份信息,接入点信息生成 s3url。

- 根据 s3url 获取启动 AutoMQ 的命令示例。在命令中,将 --controller-list 和 --broker-list 替换为实际需要部署的 CONTROLLER 和 BROKER。执行结果示例如下:

############ Ping s3 ########################

[ OK ] Write s3 object

[ OK ] Read s3 object

[ OK ] Delete s3 object

[ OK ] Write s3 object

[ OK ] Upload s3 multipart object

[ OK ] Read s3 multipart object

[ OK ] Delete s3 object

############ String of s3url ################

Your s3url is:

s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=xxx&s3-secret-key=yyy&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA

############ Usage of s3url ################

To start AutoMQ, generate the start commandline using s3url.

bin/automq-kafka-admin.sh generate-start-command

--s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA"

--controller-list="192.168.0.1:9093;192.168.0.2:9093;192.168.0.3:9093"

--broker-list="192.168.0.4:9092;192.168.0.5:9092"

TIPS: Please replace the controller-list and broker-list with your actual IP addresses.第 2 步:生成启动命令列表

将上一步生成的命令中的 --controller-list 和 --broker-list 替换为你的主机信息,具体来说,将它们替换为环境准备中提到的 3 台 CONTROLLER 和 2 台 BROKER 的 IP 地址,并且使用默认的 9092 和 9093 端口。

bin/automq-kafka-admin.sh generate-start-command

--s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA"

--controller-list="192.168.0.1:9093;192.168.0.2:9093;192.168.0.3:9093"

--broker-list="192.168.0.4:9092;192.168.0.5:9092"输出结果

执行命令后,会生成用于启动 AutoMQ 的命令。

############ Start Commandline ##############

To start an AutoMQ Kafka server, please navigate to the directory where your AutoMQ tgz file is located and run the following command.

Before running the command, make sure that Java 17 is installed on your host. You can verify the Java version by executing 'java -version'.

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker,controller --override node.id=0 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.1:9092,CONTROLLER://192.168.0.1:9093 --override advertised.listeners=PLAINTEXT://192.168.0.1:9092

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker,controller --override node.id=1 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.2:9092,CONTROLLER://192.168.0.2:9093 --override advertised.listeners=PLAINTEXT://192.168.0.2:9092

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker,controller --override node.id=2 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.3:9092,CONTROLLER://192.168.0.3:9093 --override advertised.listeners=PLAINTEXT://192.168.0.3:9092

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker --override node.id=3 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.4:9092 --override advertised.listeners=PLAINTEXT://192.168.0.4:9092

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker --override node.id=4 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.5:9092 --override advertised.listeners=PLAINTEXT://192.168.0.5:9092

TIPS: Start controllers first and then the brokers.注意:node.id 默认从 0 开始自动生成。

第 3 步:启动 AutoMQ

要启动集群,请在预先指定的 CONTROLLER 或 BROKER 主机上依次执行上一步命令中的命令列表。例如,在 192.168.0.1 上启动第一个 CONTROLLER 进程,执行生成的启动命令列表中的第一条命令。

bin/kafka-server-start.sh --s3-url="s3://s3.cn-northwest-1.amazonaws.com.cn?s3-access-key=XXX&s3-secret-key=YYY&s3-region=cn-northwest-1&s3-endpoint-protocol=https&s3-data-bucket=automq-data&s3-path-style=false&s3-ops-bucket=automq-ops&cluster-id=40ErA_nGQ_qNPDz0uodTEA" --override process.roles=broker,controller --override node.id=0 --override controller.quorum.voters=0@192.168.0.1:9093,1@192.168.0.2:9093,2@192.168.0.3:9093 --override listeners=PLAINTEXT://192.168.0.1:9092,CONTROLLER://192.168.0.1:9093 --override advertised.listeners=PLAINTEXT://192.168.0.1:9092后台运行如果需要以后台模式运行,请在命令末尾添加以下代码:

command > /dev/null 2>&1 &至此,你已经完成了基于 Tigris 的 AutoMQ 集群部署,拥有了一个低成本、低延迟、秒级弹性的 Kafka 集群了。如果你需要进一步体验 AutoMQ 的秒级分区迁移、持续自平衡等特性,可以参考官方示例[7]。

参考资料 [1] Tigris: https://www.tigrisdata.com/ [2] Features of Tigris: https://www.tigrisdata.com/docs/overview/ [3] AutoMQ 1.0.6-rc1: https://github.com/AutoMQ/automq/releases [4] Fly: https://fly.io/ [5] WHAT IS AUTOMQ?: https://docs.automq.com/docs/automq-opensource/HSiEwHVfdiO7rWk34vKcVvcvn2Z [6] Example: Self-Balancing when Cluster Nodes Change: https://docs.automq.com/docs/automq-opensource/H6APwuugniOx7XktCiNcKnW8nYb [7] AutoMQ: GETTING STARTED: https://docs.automq.com/zh/docs/automq-opensource/EvqhwAkpriAomHklOUzcUtybn7g [8] Tigris: Getting Started: https://www.tigrisdata.com/docs/get-started/#getting-started

🌟 GitHub 地址:https://github.com/AutoMQ/automq

💻 官网:https://www.automq.com