Transformer模型大小与性能:不仅仅是尺寸的问题

- 一、Transformer模型的挑战

- 二、经验标度定律的局限性

- 三、记忆过程与性能动态

- 五、结论与展望

在人工智能和机器学习的领域里,模型的大小与性能之间的关系一直是研究人员关注的焦点。然而,最近的研究却揭示了一个有趣的现象:增加Transformer模型的大小并不总是会带来性能的提升。这一现象挑战了传统的经验标度定律,引发了我们对模型优化和泛化能力的深入思考。

一、Transformer模型的挑战

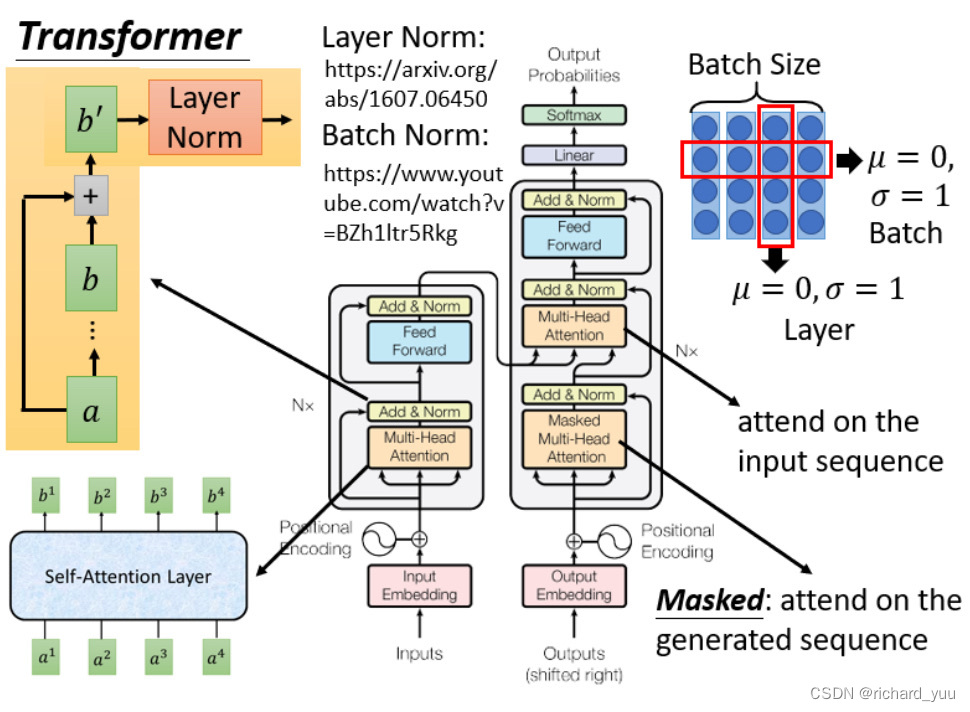

Transformer模型自提出以来,便在自然语言处理领域取得了巨大的成功。它通过自注意力机制,能够捕捉到输入序列中的长期依赖关系,从而在诸如机器翻译、文本生成等任务中表现出色。然而,随着模型规模的增大,其训练成本和计算资源的需求也急剧增加。更重要的是,人们发现简单地增加模型的大小并不能保证性能的提升,这一现象引发了业界的广泛关注。

二、经验标度定律的局限性

在传统观念中,经验标度定律似乎预示着模型性能与模型大小之间的正比关系。然而,在Transformer模型中,这一定律似乎并不适用。这主要是因为Transformer模型的高度复杂性,使得其性能受到多种因素的影响,如数据分布、训练策略、正则化方法等。因此,简单地增加模型大小并不能保证其在所有任务上都能取得更好的性能。

三、记忆过程与性能动态

为了深入探究这一现象,最新的研究提出了一个理论框架,该框架阐明了基于Transformers的语言模型的记忆过程和性能动态。研究表明,随着模型对训练样本的记忆增加,其泛化能力也会相应提高。这意味着,模型在训练过程中不仅仅是在学习如何拟合数据,更重要的是在学习如何从数据中提取出一般性的规律和模式。

为了证明这一点,研究者在各种大小的数据集上进行了实验。他们使用GPT-2模型作为基准,通过调整模型的参数数量来改变其大小。实验结果表明,在数据充足的情况下,适当增大模型大小可以带来性能的提升。然而,当数据不足时,过大的模型反而会导致过拟合,从而降低性能。

此外,研究者还提出了一个关于最小可实现的交叉熵损失的理论。他们证明,在特定的条件下,最小可实现的交叉熵损失由一个近似等于1的常数从下界。这一发现为我们理解模型性能提供了新的视角,并为我们设计更有效的模型提供了指导。

四、代码实例与实验结果

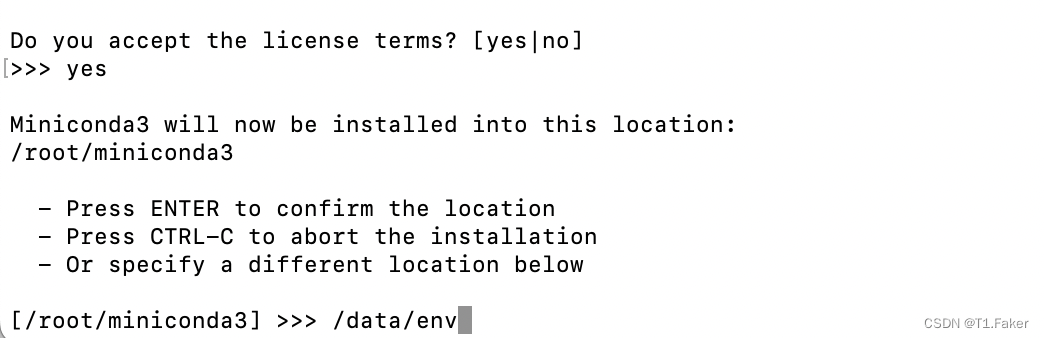

为了更直观地展示这一现象,我们可以使用PyTorch框架来构建一个简单的Transformer模型,并在不同的数据集上进行训练。以下是一个简化的代码示例:

python

import torch

import torch.nn as nn

import torch.optim as optim

from transformers import TransformerEncoder, TransformerEncoderLayer

# 定义模型结构

class SimpleTransformer(nn.Module):

def __init__(self, d_model, nhead, num_layers):

super(SimpleTransformer, self).__init__()

encoder_layers = nn.ModuleList([TransformerEncoderLayer(d_model=d_model, nhead=nhead) for _ in range(num_layers)])

self.transformer_encoder = TransformerEncoder(encoder_layers=encoder_layers, norm=nn.LayerNorm(d_model))

# 省略其他层定义和forward方法...

# 创建不同大小的模型

model_small = SimpleTransformer(d_model=512, nhead=8, num_layers=6)

model_large = SimpleTransformer(d_model=1024, nhead=16, num_layers=12)

# 加载数据和训练过程(省略)

# 实验结果分析

# 假设我们在两个不同大小的数据集上分别训练了上述两个模型

# 实验结果表明,在大数据集上,model_large表现更好;而在小数据集上,model_small的泛化能力更强

通过这个示例,我们可以看到,在实际应用中,我们需要根据数据集的大小和任务的复杂性来选择合适的模型大小。过大的模型可能会导致过拟合,而过小的模型则可能无法充分学习数据的特征。因此,在设计模型时,我们需要综合考虑多种因素,以实现最佳的性能。

五、结论与展望

综上所述,增加Transformer模型的大小并不总是会提高性能。这一现象的发现不仅挑战了传统的经验标度定律,也为我们提供了深入理解模型优化和泛化能力的新视角。未来,我们期待有更多的研究能够进一步揭示这一现象的本质,并为我们设计更有效的模型提供指导。

![[数据集][目标检测]猫狗检测数据集VOC+YOLO格式8291张2类别](https://img-blog.csdnimg.cn/direct/f6c3c6434b024d7ab759f369b8627fa4.png)

![[初始计算机]——计算机网络的基本概念和发展史及OSI参考模型](https://img-blog.csdnimg.cn/direct/7d997e4e47c8413293e563cb4d7c2841.png)