大模型技术论文不断,每个月总会新增上千篇。本专栏精选论文重点解读,主题还是围绕着行业实践和工程量产。若在某个环节出现卡点,可以回到大模型必备腔调重新阅读。而最新科技(Mamba,xLSTM,KAN)则提供了大模型领域最新技术跟踪。若对于如果构建生成级别的AI架构则可以关注AI架构设计专栏。技术宅麻烦死磕LLM背后的基础模型。

xAI

埃隆·马斯克于去年夏天创立了 xAI,今天宣布筹集 60 亿美元资金,称将帮助xAI“将首批产品推向市场,构建先进的基础设施,并加速未来技术的研发”。

到目前为止,xAI 已经推出了 Grok,这是OpenAI ChatGPT 的升级版,可通过 X(原名 Twitter)使用,目前该聊天机器人仅供 X Premium 订阅用户使用。

据 xAI 称,本轮融资来自多个渠道,包括 Andreessen Horowitz、红杉资本和沙特阿拉伯王子阿尔瓦利德·本·塔拉尔。去年,一份提交给美国证券交易委员会的文件显示,xAI 正寻求通过股权投资筹集高达 10 亿美元的资金。几个月前,《金融时报》报道称,该公司正寻求筹集高达60 亿美元的资金。马斯克当时否认了这一报道。

微软公司向 OpenAI 投资了约 130 亿美元,而亚马逊公司向 Anthropic 投资了约 40 亿美元。

能够支持 AI 开发的硬件价格相当昂贵,Nvidia 即将推出的 Blackwell B200 AI 显卡每张售价在 30,000 至 40,000 美元之间。上周有Information报道称,xAI 需要 100,000个 Nvidia的H100 芯片来为超级计算机提供 Grok AI 聊天机器人的升级版。据报道,马斯克告诉投资者,计划在 2025 年秋季之前启动新的数据中心。

在芯片、人才和技术方面展开人工智能竞赛的代价并不低——除了谷歌、苹果、亚马逊、微软和Meta向自己的人工智能项目投入资源之外,大型科技公司还向Anthropic等人工智能初创公司投入了数十亿美元。

微软还与 OpenAI 达成了数十亿美元的合作,据报道,OpenAI 首席执行官 Sam Altman 正在寻求数万亿美元的资金来重振全球芯片行业。作为 OpenAI 的创始成员之一,马斯克正在起诉该公司,声称该公司放弃了造福人类的使命。

除了 xAI 和 OpenAI,马斯克表示,在人工智能和机器人方面,除非他获得更多控制权,否则他“更愿意在特斯拉之外开发产品”。

Grok-1.5V

根据公开的开发者文件,埃隆·马斯克的人工智能公司 xAI 正在为其 Grok 聊天机器人添加多模式输入方面取得进展。这意味着,用户很快就能将照片上传到 Grok 并收到基于文本的答案。

xAI 上个月在一篇博客文章中首次透露了这一点,称 Grok-1.5V 将提供“多个领域的多模态模型”。开发人员文档的最新更新似乎显示了推出新模型的进展。

在开发人员文档中,一个示例 Python 脚本演示了开发人员如何使用 xAI 软件开发工具包库根据文本和图像生成响应。此脚本读取图像文件、设置文本提示并使用 xAI SDK 生成响应。

Grok-1 已经开源

xAI前端时间将使其 AI 聊天机器人Grok-1 版本开源,目前该版本已在GitHub和Hugging Face上发布。此举使研究人员和开发人员能够扩展该模型,影响 xAI 如何在 OpenAI、Meta、谷歌、微软等科技巨头的竞争中发展 Grok。

这一里程碑标志着 AI 领域的重大转折,使该领域的其他开发人员和专家能够访问 Grok-1 的代码和相关数据以进行分析和开发。

Grok-1 开源旨在为 AI 研发开辟新机遇。此前,Mixtral和Llama 2等行业领先模型主导了AI研究领域。然而,Grok以其庞大的规模脱颖而出,包含一组令人印象深刻的 314B参数,几乎是其最接近的竞争对手 Llama 2 的四倍。

这种规模意味着模型精度和交互能力方面具有广阔的前景。Grok 的权重对于其运行至关重要,可供下载,使开发人员能够试验其结构和行为。

现在 Grok-1 已经开源,xAI的Grok-1 版本的所有基本信息:314B params - 8*33B MoE - 25% 的权重激活/单个Token比Llama2和GPT3.5 Apache2更好。

马斯克声称,他决定采用 Grok 开源方式是为了响应人工智能领域日益增长的透明度和协作需求。为了寻求 OpenAI 和谷歌的替代方案,马斯克推出了xAI,目的是开发他期望的人工智能,能够最大限度提高寻求真相的能力。

Grok-1 最初于 2023 年 10 月进行训练,是一个预训练过的基础模型,未经任何微调。这种缺乏专业化的特性使其在广泛的应用中具有强大的潜力,同时完全不受约束。该模型的参数已根据很宽松的Apache 2.0许可发布,鼓励商业和非商业用途。

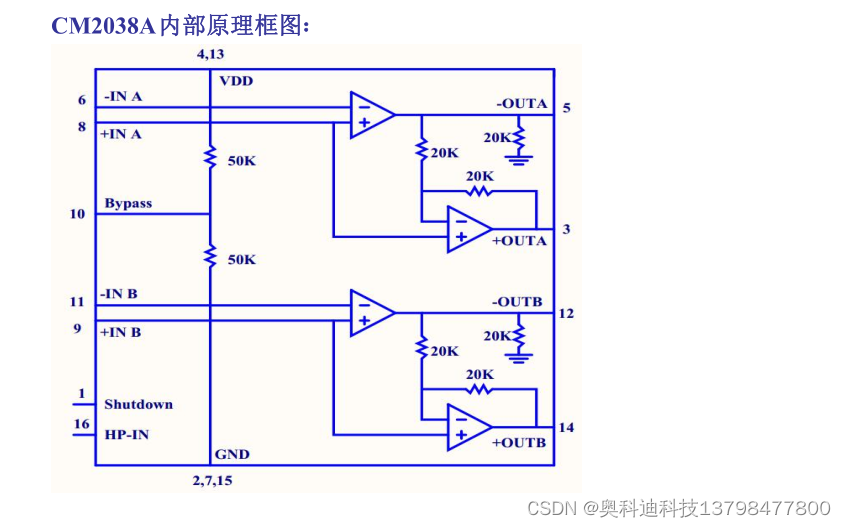

主要技术规格:

-

3140 亿个参数

-

混合专家架构,包含 8 位专家(每个Token有 2 位活跃专家)

-

64 层

-

48 个用于查询的注意力头

-

6,000 维内部嵌入

-

支持旋转位置嵌入 (RoPE)

-

支持 8 位量化和激活缓存

-

最大上下文窗口为 8,000 个 token

-

SentencePiece Tokenizer 标记器,包含 131,072 个标记

-

由于规模巨大,在本地运行 Grok-1 需要大量硬件资源。4 位推理估计需要 320GB VRAM,而 8 位推理则需要 NVIDIA DGX H100 这样的系统(配备 8 个 GPU,每个 GPU 配备 80GB VRAM)。

早期基准测试表明,在 GEM8K、MMLU、HumanEval 和数学问题等任务上,Grok-1 的表现优于 2700 亿参数 Lamma MoE 甚至 GPT-3.5 等模型。这表明该模型的规模可能转化为改进的推理能力。拥有大量高质量数据集的公司可以充分的利用开源Grok-1,能够获取卓越性能。