科学研究作为推动创新和知识进步的关键活动,在解决复杂问题和提升人类生活水平方面发挥着至关重要的作用。然而,科学研究的固有复杂性、缓慢的进展速度以及对专业专家的需求,限制了其生产力的提升。为了增强科研效率,本文提出了一个名为ResearchAgent的系统,这是一个由大型语言模型(LLMs)驱动的科研构思写作代理,能够自动生成问题、方法和实验设计,并通过科学文献进行迭代式细化。

ResearchAgent系统概述

ResearchAgent系统是一个创新的人工智能工具,旨在模拟人类研究者在科研过程中的思考和迭代方式。这一系统的设计灵感直接来源于科研人员在面对未知领域时如何提出问题、探索解决方案并验证其有效性的真实场景。它通过以下关键步骤来生成科研构思:

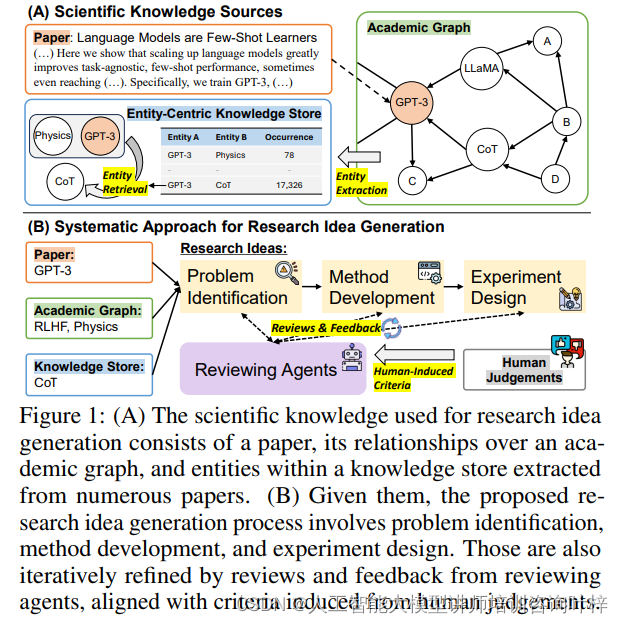

问题识别是科研构思生成的第一步。在这一阶段,ResearchAgent专注于分析现有的科学知识体系,寻找其中的空白点或矛盾之处。这涉及到对大量科学文献的深入分析,以识别那些尚未解决或需要进一步研究的问题。通过这种方式,系统能够提出具有潜在价值的研究问题,这些问题往往能够指向新的研究方向或领域。

方法开发阶段,ResearchAgent利用相关的程序和工具来设计研究方法。这不仅包括选择恰当的科学方法论,还涉及到对实验流程、数据收集和分析方法的详细规划。系统会考虑到研究问题的特定需求,选择最合适的技术手段和工具,以确保研究的系统性和科学性。

实验设计是将方法论付诸实践的阶段。在这一步骤中,ResearchAgent详细规划实验的每一个环节,包括实验的设置、操作步骤、预期结果以及如何收集和分析数据。实验设计的目的是验证前面阶段提出的假设,并通过实验结果来支持或反驳这些假设。系统会确保实验设计的清晰性、可重复性和有效性,以便于其他研究者可以复制实验并验证结果。

图1展示了用于生成研究想法的科学知识,包括一篇论文、学术图谱中的关系,以及从多篇论文中提取的实体。图的B部分描述了研究想法生成过程,包括问题识别、方法开发和实验设计,并且这些过程会通过来自评审代理的评审和反馈进行迭代细化。

方法详解

ResearchAgent系统的核心——大型语言模型(LLMs)。这些模型之所以关键,是因为它们具备强大的数据处理和分析能力,它们能够识别数据中的模式、趋势和相关性,这对于发现新的研究机会至关重要。LLMs通过以下几个方法被集成和增强,以提高科研构思的生成能力:

学术图谱的概念被引入以扩展知识基础。学术图谱是一种网络结构,它通过核心论文及其引用关系来组织和连接科学文献。这种图谱使ResearchAgent能够超越单一论文的界限,探索与之相关的更广泛的研究领域。通过分析论文之间的引用网络,系统能够识别研究领域内的重要节点和连接,从而为科研构思提供丰富的背景知识和上下文信息。

实体中心知识库的构建为LLMs提供了另一种增强信息的方式。这个知识库不同于传统的以文档或论文为中心的数据库,它专注于从科学文章中提取实体,并将这些实体作为知识的原子单位进行聚合。实体可以是特定的概念、方法、数据或任何与研究相关的项目。通过实体链接方法,系统能够识别和关联来自不同论文的实体,捕捉它们之间的相互关联性,从而构建一个跨学科的知识网络。

结合学术图谱和实体中心知识库,ResearchAgent能够生成更为全面和深入的科研构思。例如,系统可能通过分析学术图谱中的引用关系发现一个研究领域内的关键问题,然后利用实体中心知识库中的实体信息来探索可能的解决方案和实验方法。这种方法不仅提高了研究构思的相关性和创新性,还确保了它们在当前科学前沿中的定位。

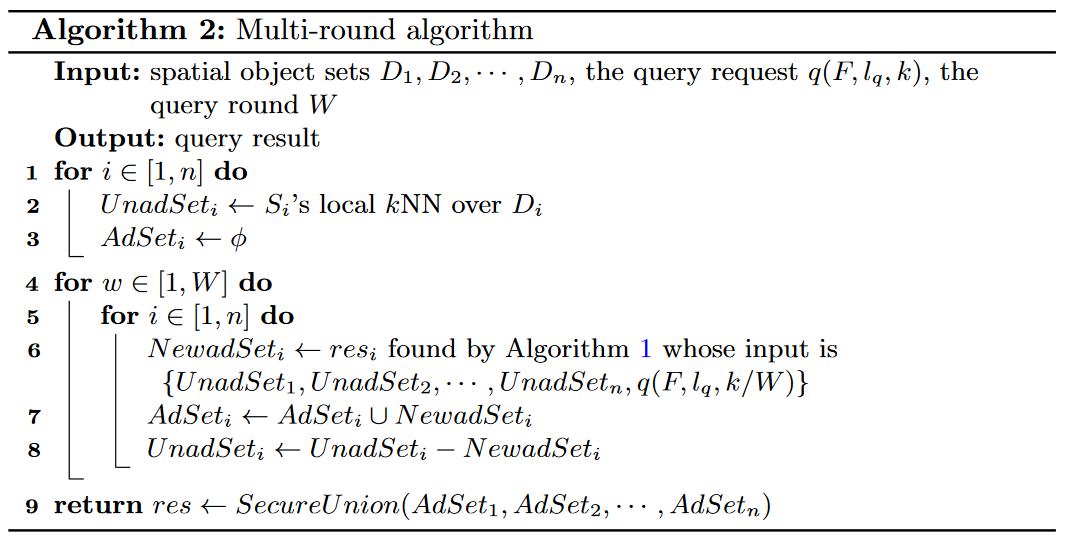

ResearchAgent的设计还包括了迭代式的构思生成和细化过程。在生成初始构思后,系统利用多个评审代理(ReviewingAgents)进行评估和反馈。这些评审代理基于LLMs,并且每个代理都根据人类判断制定的特定评价标准来运行。通过这种方式,系统能够不断改进和精细化生成的科研构思,使其更加符合科学研究的实际需求和标准。

实验

图2展示了不同模型生成的研究想法(问题、方法和实验设计)在人类和模型基础评估下的表现。每个想法根据其自身的五个标准进行评分,并给出了平均分。左侧是来自人类评估者的结果,而右侧是模型评估的结果。通过这种对比,可以观察到人类和模型在评估研究想法时的一致性和差异性。

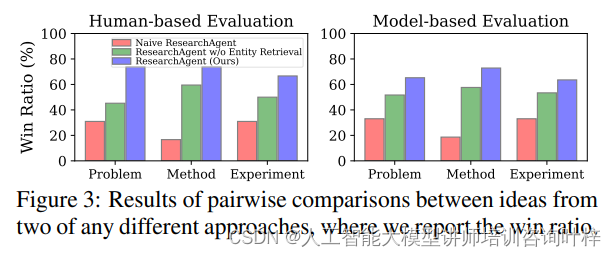

Figure 3 展示的是不同方法生成的研究想法之间的比较结果。在这个图表中,我们可以看到几种不同的方法——朴素的ResearchAgent(Naive ResearchAgent)、不包含实体检索的ResearchAgent(ResearchAgent w/o Entity Retrieval),以及我们提出的完整ResearchAgent(ResearchAgent)——在人类评估和模型评估的基础上,它们生成的问题、方法和实验设计的想法相互之间的比较。

在人类评估的基础上,报告了两种不同方法生成的想法之间的胜出比例(win ratio)。这个比例显示了在人类评估者看来,一种方法相对于另一种方法在生成更高质量的研究想法方面的表现如何。例如,如果完整的ResearchAgent在与朴素的ResearchAgent进行比较时胜出比例较高,这表明它在人类评估者眼中能更有效地生成高质量的研究想法。

在模型评估的基础上,使用了类似的胜出比例来展示不同方法之间的比较。这里的模型评估可能涉及使用像GPT-4这样的大型语言模型,根据预定义的标准对想法的质量进行评分。

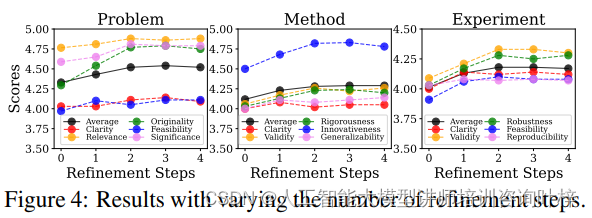

Figure 4 展示了随着迭代细化步骤数量的变化,生成的研究想法质量的变化情况。在这个图表中,我们可以看到,随着细化步骤的增加,研究想法在各项评价标准上的得分是如何变化的。评价标准可能包括清晰度、相关性、原创性、可行性和重要性等。随着细化步骤的继续增加,我们可能会观察到得分进一步的提升,但提升的幅度可能会逐渐减小。这表明,虽然迭代过程对于提高研究想法的质量是有效的,但随着每次迭代,改进的空间可能会逐渐减少,最终达到一个平台期,此时额外的迭代可能不会带来显著的改进。

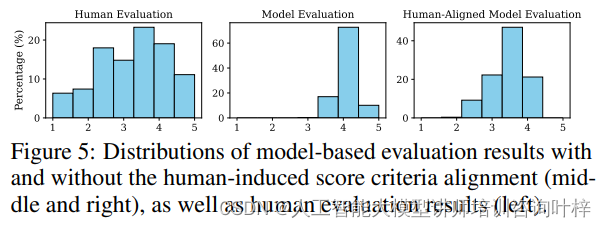

Figure 5 展示了模型评估结果的分布情况,特别是在不同评估标准对齐方式下的表现。这个图表比较了人类评估结果与模型评估结果的一致性,以及引入人类评价标准对齐(human-induced score criteria alignment)对模型评估准确性的影响。

在没有进行人类对齐的模型评估中,我们可能观察到评分分布的偏斜,这与人类评估者给出的评分分布存在显著差异。这表明,如果直接使用模型自身的评估标准,可能无法准确反映人类研究者对研究想法质量的判断。

然而,通过引入人类评价标准对齐,即利用少量人类标注的数据来指导模型学习人类的评价偏好,模型评估的分布开始更紧密地匹配人类评估的分布。这意味着,通过这种方式对齐后,模型能够更准确地模拟人类专家的评价标准,从而提供更加合理和可靠的评估结果。

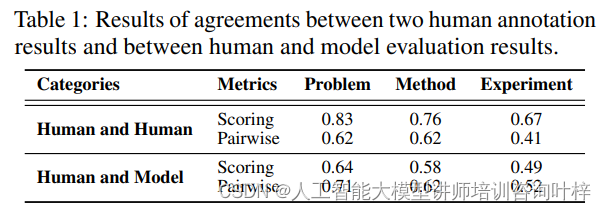

Table 1 展示了两个重要的评估一致性指标:人类评估者之间的评分一致性(Human and Human Scoring)和人类评估与模型评估之间的评分一致性(Human and Model Scoring)。这些数据是通过计算 Spearman 相关系数和 Cohen's kappa 系数来衡量的,分别对应评分任务和成对比较任务。评分任务的一致性较高,表明不同评估者对研究想法的质量有相似的看法。成对比较任务的一致性较低,这可能反映了评估者在比较不同想法时存在更多主观性。人类与模型评估之间的一致性也较高,这支持了使用模型评估作为评估研究想法的一种可靠方法。

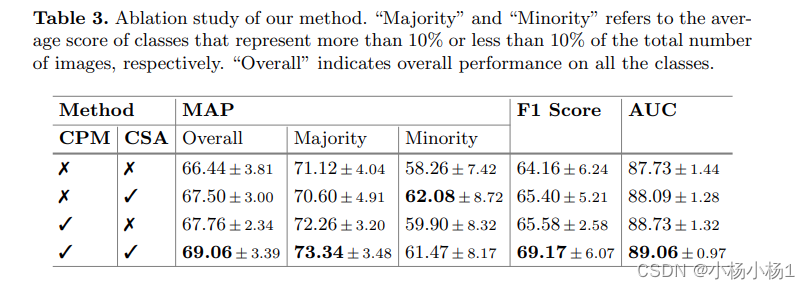

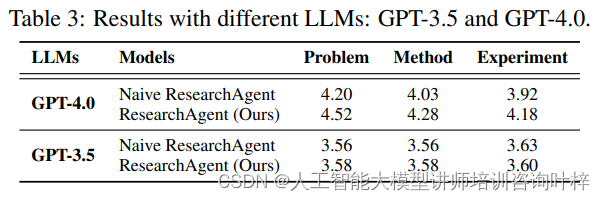

Table 3 对比了使用不同大型语言模型(LLMs),如 GPT-4.0 和 GPT-3.5,对 ResearchAgent 性能的影响。结果显示,使用更强大的 GPT-4.0 模型时,ResearchAgent 在所有指标上均优于基线模型。而当使用功能较弱的 GPT-3.5 模型时,ResearchAgent 的性能显著下降,这表明较小的模型可能无法捕捉跨不同科学论文的复杂概念和关系。

实验数据显示,与基线模型相比,ResearchAgent在问题、方法和实验设计三个关键领域均实现了质量上的大幅提升。通过人类评估者和模型评估的双重验证,该系统展现出在原创性、清晰性、相关性、可行性和重要性等评价标准上的明显优势。

迭代细化步骤的引入进一步增强了构思的质量。实验结果表明,随着迭代次数的增加,构思评分起初得到显著提高,但随着迭代的继续,改进幅度逐渐减少,暗示了迭代过程中的边际效益递减。消融研究揭示了学术图谱和实体中心知识库对构思质量的重要贡献,而模型与人类评估者之间的高一致性则验证了模型评估的可靠性。

不同领域和引用次数的论文评估结果支持了评价标准的广泛适用性。这些发现证实了ResearchAgent不仅能够生成高质量的研究构思,还能够通过迭代过程不断优化这些构思,最终达到与人类研究者相媲美的水平。综合来看,ResearchAgent系统在辅助科研人员生成和细化研究想法方面具有巨大的潜力和价值。

论文链接:https://arxiv.org/pdf/2404.07738