一:分布式事务

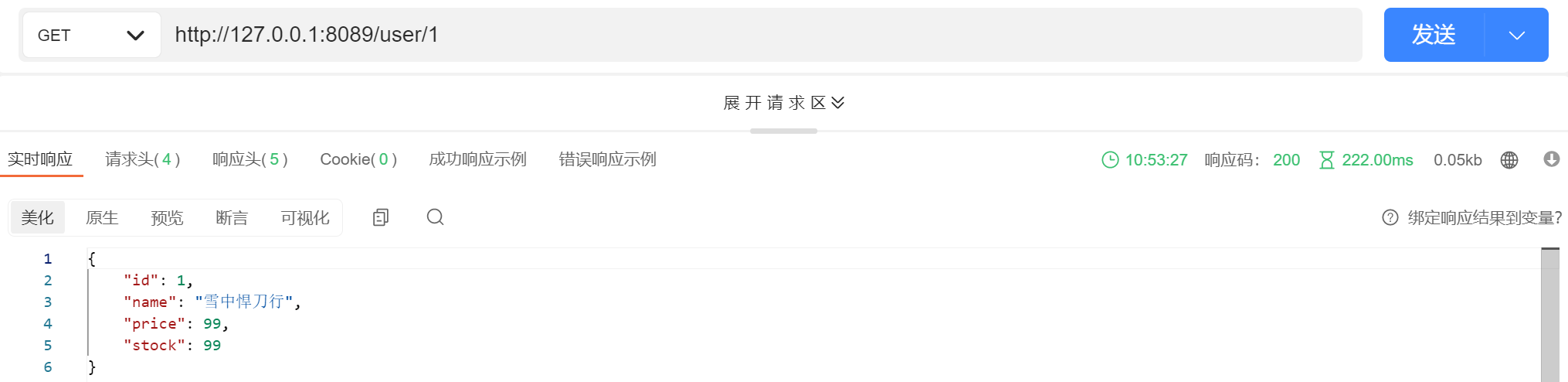

1、理论基础

分布式事务主要区分本地事务

什么是本地事务(Local Transaction)?本地事务也称为数据库事务或传统事务(相对于分布式事务而言)。尤其对于数据库而言,为了数据安全,提供了以下的几个步骤来完成本地事务的提交以及回滚。其具备ACID四特性。

分布式事务是指组成事务的参与者,每个业务部分都分别部署在不同的服务器上。在微服务架构中多个节点的协调工作必须保持原子性,多个节点的逻辑必须同时成功或者同时失败。不能出现部分节点成功,部分失败的情况。一次大的操作由不同的小操作组成的,这些小的操作分布在不同的服务器上,分布式事务需要保证这些小操作要么全部成功,要么全部失败。

本质上来说,分布式事务就是为了保证不同数据库、不同服务器节点的数据一致性

主要说2个理论基础,一个是分布式的CAP定理,一个是BASE理论。

CAP定理/原则:

指的是在一个分布式系统中,一致性(Consistency)、可用性(Availability)、分区容错性(Partition tolerance)这三个要素最多只能同时实现两点,不可能三者兼顾。在分布式场景中,由于网络硬件等客观因素,网络之间的通信可能会存在中断、丢包等情况,所以分区容错性(Partition tolerance)是我们分布式场景中必须要满足的,三要素中就只能有有这2种组合:CP和AP。

AP:AP模型强调的是系统的可用性,在做系统设计时,需要优先考虑可用性;

CP:CP模型强调的是系统的一致性,在做系统设计时,需要优先考虑一致性;

基于CAP定理的AP模型和CP模型,又演化出了BASE理论。

一致性(C):在分布式系统中的所有数据备份,在同一时刻是否同样的值。(等同于所有节点访问同一份最新的数据副本)

一致性可以这么理解,客户端访问所有节点,返回的都是同一份最新的数据。可用性是指,每次请求都能获取非错误的响应,但不保证获取的数据是最新数据。分区容错性是指,节点之间由于网络分区而导致消息丢失的情况下,系统仍能继续正常运行。需要强调的是,这里的一致性是指线性一致性,至于什么是线性一致性,我们会在3.7节中详细解释。这里读者只需要理解为,对于单个对象,读操作会返回最近一次写操作的结果,这也叫线性一致性读。

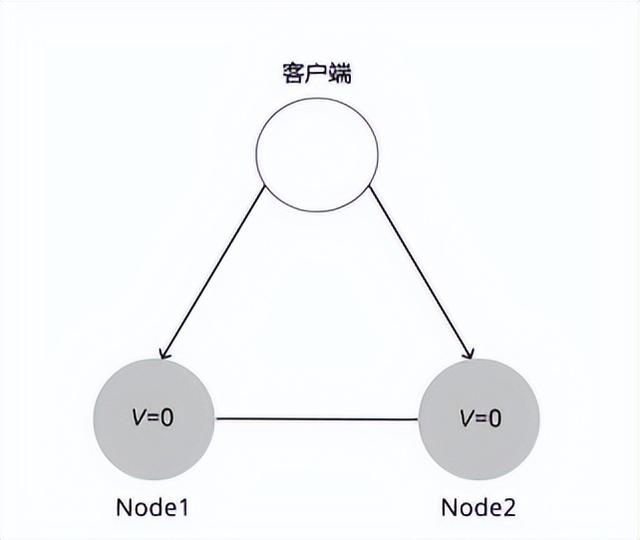

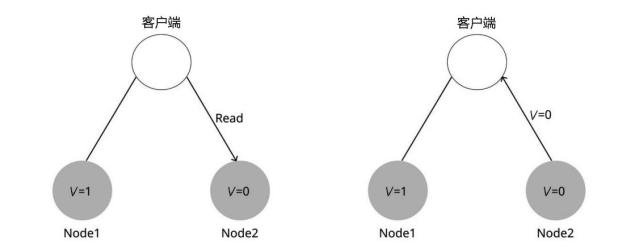

为了便于理解,举一个具体的例子。考虑一个非常简单的分布式系统,它由两台服务器Node1和Node2组成,这两台服务器都存储了同一份数据的两个副本,我们可以简单认为这个数据是一个键值对,初始的记录为V=0。服务器Node1和Node2之间能够互相通信,并且都能与客户端通信。这个例子如图所示。

现在客户端向Node1发送写请求V=1。如果Node1收到写请求后,只将自己的V值更新为1,然后直接向客户端返回写入成功的响应,这时Node2的V值还是等于0,此时客户端如果向Node2发起了读V的请求,读到的将是旧的值0。那么,此时这两个节点是不满足一致性的。

如果Node1先把V=1复制给Node2,再返回客户端,那么此时两个节点的数据就是一致的。这样,无论客户端从哪个节点读取V值,都能读到最新的值1。此时系统满足一致性

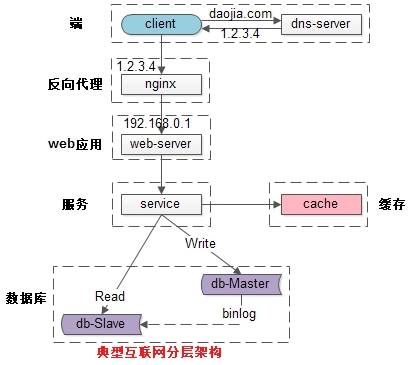

如图数据库主从的写和读操作:

确保一致性实现流程:

写入主库后,向从库同步器件要将从库锁定,待同步完成后再释放锁,以免在新数据写入成功后,从查询的依旧是旧数据。

接下来的可用性和分区容错性就比较好理解了。

可用性(A):保证每个请求不管成功或者失败都有响应。

可用性就是说,客户端向其中一个节点发起一个请求,且该节点正常运行无故障,那么这个节点最终必须响应客户端的请求。

对于高可用性的衡量标准如下:

确保可用性的前提下上面同步加锁的情况肯定不能发生,改进异步如下:

分区容忍性(P):系统中任意信息的丢失或失败不会影响系统的继续运作。

为什么CAP定理说一个系统不能同时满足一致性、可用性和分区容错性?这里给出简要的证明。

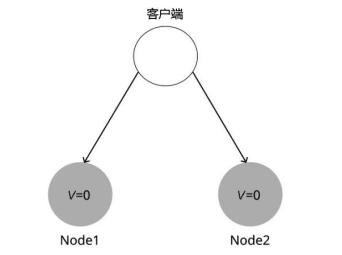

我们使用反证法证明。假设存在一个同时满足这三个属性的系统,我们第一件要做的事情就是让系统发生网络分区,就像图中的情况一样,服务器Node1和Node2之间的网络发生故障导致断开连接。

客户端向Node1发起写请求,将V的值更新为1,因为系统是可用的,所以Node1必须响应客户端的请求,但是由于网络分区,Node1无法将其数据复制到Node2,如图所示。

接着,客户端向服务器Node2发起读V的请求,再一次因为系统是可用的,所以Node2必须响应客户端的请求。还是因为网络分区,Node2无法从Node1更新V的值,所以Node2返回给客户端的是旧的值0,和客户端刚才写入的V的值不同,如图所示。

这显然违背了一致性,因此证明不存在这样的系统。

总的来说:

没有P分区容错性就不属于分布式系统,A强一致和C高可用不能并存所以只有 CP 和 AP的组合。

BASE理论

BASE理论是基于CAP原则演化而来。

是Basically Available(基本可用)、Soft state(软状态)和Eventually consistent(最终一致性)的简写。核心是既然没法做到强一致性,但每一个应用都可根据自身的业务特点采用适当的方式来达到最终一致性。

Basically Available(基本可用):指系统出现不可预知的故障时,允许损失部分可用性,但保证核心可用。

基本可用比较好理解,就是不追求 CAP 中的「任何时候,读写都是成功的」,而是系统能够基本运行,一直提供服务。基本可用强调了分布式系统在出现不可预知故障的时候,允许损失部分可用性,相比正常的系统,可能是响应时间延长,或者是服务被降级。

比如:系统某功能的正常响应时间是0.1秒,但由于系统出现异常(机房断电、光纤挖断等)系统功能的响应时间升到1-2秒;

再比如电商的大促或秒杀,为了保证系统的稳定性,当用户流量超过了系统阈值,可把部分用户引流到一个降级页面。

在双十一秒杀活动中,如果抢购人数太多超过了系统的 QPS 峰值,可能会排队或者提示限流,这就是通过合理的手段保护系统的稳定性,保证主要的服务正常,保证基本可用

Soft state(软状态):

与(原子性)硬状态相对。系统中的数据存在中间状态,并认为该中间状态不影响系统的整体可用性,即表示数据副本之间的同步有延迟。

软状态可以对应 ACID 事务中的原子性,在 ACID 的事务中,实现的是强制一致性,要么全做要么不做,所有用户看到的数据一致。其中的原子性(Atomicity)要求多个节点的数据副本都是一致的,强调数据的一致性。

原子性可以理解为一种“硬状态”,软状态则是允许系统中的数据存在中间状态,并认为该状态不影响系统的整体可用性,即允许系统在多个不同节点的数据副本存在数据延时。

Eventually consistent(最终一致性):

系统中的所有数据副本,在经过一段时间后,所有数据的状态都能达到一个最终的一致的状态。

数据不可能一直是软状态,必须在一个时间期限之后达到各个节点的一致性,在期限过后,应当保证所有副本保持数据一致性,也就是达到数据的最终一致性。

比如上面的软状态,不可能让其一直存在。必须在时限内,通过人工补偿或者定时任务或者MQ消息队列的形式让所有副本数据达到一致。

总的来说:

在系统设计中,最终一致性实现的时间取决于网络延时、系统负载、不同的存储选型、不同数据复制方案设计等因素。

分布式中的一致性有三种级别:

①强一致性:系统在某个节点中写入或修改了数据,那么之后在任意节点读取到的数据都是最新的数据。

②弱一致性:不一定能读到最新的值,也不能保证在一定时间后读取到的数据是最新的,只会尽量在某个时刻达到数据一致的状态。

③最终一致性:弱一致性的升级版,可以保证在一定时间内达到数据的最终一致性。

一般常用的是最终一致性,但是也有一些对一致性要求比较高的,比如银行的交易系统,这种要保证强一致性。

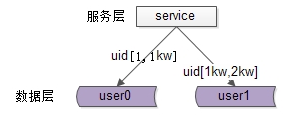

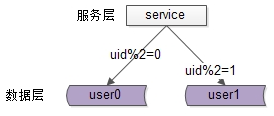

2,分布式事务产生的原因

分布式事务的产生,源自互联网、电商等的发展,当同一个系统不同模块不同业务的数据在一个存储设备里,随着业务的发展,系统逐渐满足不了业务的发展时,常用的手段就是“拆”,拆的手段有垂直拆分和水平拆分,针对业务模块和数据库存储,都可以进行垂直拆分和水平拆分。拆分后就会存在不同的业务使用自己的数据库进行存储,这就会导致一个操作需要进行跨数据库操作。这就是分布式事务产生的最基本的原因所在。而我们知道,只要是事务,必须要满足事务的四性(ACID),为了使事务的四性得到满足,业内使用了多种技术手段,但各种技术手段都有其优点和缺点。

事务的四性(ACID):Automicity(原子性)、Consistency(一致性)、Isolation(隔离性)、Durability(持久性)。

比如:电商的下单,里面包含写订单表、扣减商品库存、写财务结算,订单信息、商品库存、财务模块按业务已经拆分到不同的模块,各自有属于自己的数据库,这个时候就是一个典型的分布式事务场景。

分布式事务的解决方案:

2PC,3PC,TCC,seeta-saga,基于消息队列的异步模型等

3、刚性分布式事务

刚性务的特点:

数据的状态强调的是强一致性,系统能支持的并发低,事务执行的时间都比较短,属于短事务,所有数据在事务内同步执行。刚性分布式事务遵循XA协议,通过实现XA的接口来实现分布式事务。XA规范由AP、RM、TM组成。

AP:(应用程序 Application Program)定义事务的开始和结束,并访问事务内的资源;

RM:(资源管理器 Resource Manager)通常指的就是数据库资源;

TM:(事务管理器 Transaction Manager) 负责管理事务,分配事务的唯一标识、监控事务的执行情况、并负责事务的提交、回滚等操作;

下面列出一些常见的实现XA协议的分布式事务方法。

两阶段提交(2PC):

XA协议:XA是一个分布式事务协议。XA中大致分为两部分:事务管理器和本地资源管理器。其中本地资源管理器往往由数据库实现,比如Oracle、DB2这些商业数据库都实现了XA接口,而事务管理器作为全局的调度者,负责各个本地资源的提交和回滚。

思路

2PC机制顾名思义分为两个阶段,是基于DB来完成,其实施思路可概括为:

(1)投票阶段(voting phase):参与者将操作结果通知协调者;

(2)提交阶段(commit phase):收到参与者的通知后,协调者再向参与者发出通知,根据反馈情况决定各参与者是否要提交还是回滚;

举例

ABCDE五个室友,A组织一场王者荣耀开黑游戏,A需要拉其他四个室友五排,为了大家都有时间,你需要发送信息去问室友。这时候A就属于协调者,BCDE属于参与者、

投票阶段:

(1)A在寝室群发送一条消息,说今晚下课后寝室五黑,询问室友是否有时间;

(2)B回复有时间;

(3)C回复有时间;

(4)D回复有时间

(5)E迟迟不回复,此时对于这个活动,ABCD均处于阻塞状态,算法无法继续进行;

提交阶段:

(1)协调者A将收集到的结果反馈给BCDE(什么时候反馈,以及反馈结果如何,在此例中取决与E的时间与决定);

(2)B收到;

(3)C收到;

(4)D收到;

(5)E收到;

2PC 的流程如下图所示:

从上图可以看出,要实现 2PC,所有的参与者都要实现三个接口:

-

Prepare():TM 调用该接口询问各个本地事务是否就绪

-

Commit():TM 调用该接口要求各个本地事务提交

-

Rollback():TM 调用该接口要求各个本地事务回滚

2PC的缺点:

1、同步阻塞:所有参与事务的资源都处于阻塞状态;

2、TM瓶颈:当TM故障时,所有的参与者都将被锁定,资源得不到释放;

3、RM资源锁定时间过长;

4、全局锁定(隔离级别串行化),不适合长事务,并发低;

基于2PC的缺点,又提出三阶段(3PC)提交。

三阶段(3PC)提交:

三阶段(3PC)提交分为CanCommit询问阶段、PreCommit准备阶段和DoCommit提交三个阶段。

CanCommit:TM向所有RM发出CanCommit指令,RM收到指令后,判断可否提交事务,如果可以返回ok,否则返回no;

PreCommit:当TM收到所有RM都返回CanCommit的结果为ok时,TM向所有RM发出PreCommit;当有一个RM返回no或超时,导致TM没收到反馈则事务中断,TM向所有RM发出abort终止事务,TM收到abort后终止事务,释放资源。如果RM没收到TM发出的abort或是超时,则RM也会中断自身的事务,释放资源;

DoCommit:TM收到所有RM都返回PreCommit的结果为ok时,TM向所有RM发出DoCommit,执行事务真正的提交,TM收到所有RM的DoCommit的执行结果为ok时,释放所占用的所有资源;当有一个RM返回no或超时,导致TM没收到反馈则事务中断,TM向所有RM发出abort终止事务,各个RM收到abort后利用CanCommit阶段的Undo信息执行回滚操作,释放占用的资源;但是,如果RM没收到TM发出的abort或是超时后,则RM会继续提交事务,这将导致数据的不一致。

三阶段相比两阶段,优点有:降低阻塞范围;TM瓶颈问题得到部分解决,即在第一二阶段时,当超时的时候RM会自动释放资源,不依赖TM。但进入第三阶段后,如果超时则不会释放资源,而会继续提交事务,这种情况下,将导致数据的不一致。

4、柔性分布式事务

柔性分布式事务是相对刚性分布式事务、是对强一致性的妥协(也称补偿性事务),从而降低对数据库资源的锁定时间,提升系统的性能。柔性分布式事务适合于长事务、高并发,强调最终一致性的场合。常用的实现柔性分布式事务的方式有:TCC模型、Saga模型、基于消息队列的异步模型。

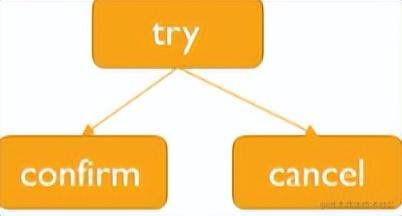

1、TCC(Try-Confirm-Cancel)模型

TCC是一个两阶段提交(2PC)的实现,每一个业务都需要实现Try-Confirm-Cancel三个接口

Try:准备阶段,是尝试执行业务,完成所有业务执行前的检查;

协调者调用所有的每个微服务提供的 try 接口,将整个全局事务涉及到的资源锁定住,若锁定成功 try 接口向协调者返回 yes。

Confirm:提交阶段,是真正执行业务,提交事务,释放资源;

若所有的服务的 try 接口在阶段一都返回 yes,则进入提交阶段,协调者调用所有服务的 confirm 接口,各个服务进行事务提交。

Cancel:取消阶段,业务失败的时候回滚业务操作,释放资源。

如果有任何一个服务的 try 接口在阶段一返回 no 或者超时,则协调者调用所有服务的 cancel 接口。

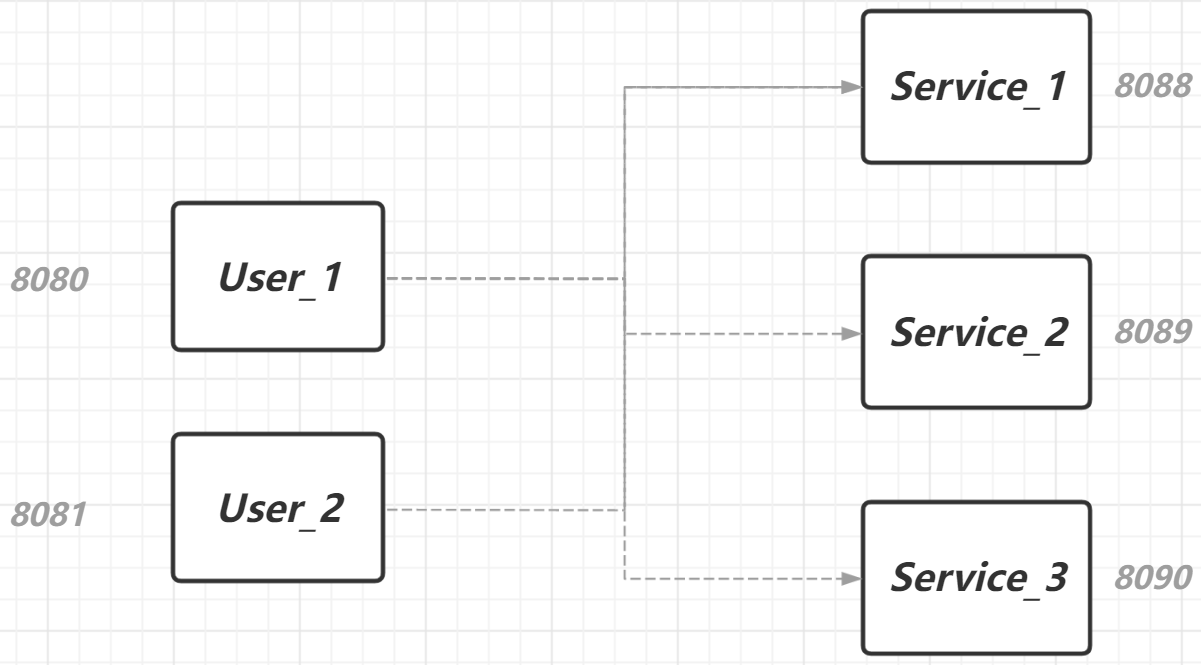

使用的电商微服务模型如下图所示,在这个模型中,shopping-service 是事务协调者,repo-service 和 order-service 是事务参与者。

TCC模型的实现是分为2步操作完成一次事务操作,达到最终事务的一致性。

TCC 的流程如下图所示:

这里有个关键问题,既然 TCC 是一种服务层面上的 2PC,它是如何解决 2PC 无法应对宕机问题的缺陷的呢?

答案是不断重试。由于 try 操作锁住了全局事务涉及的所有资源,保证了业务操作的所有前置条件得到满足,因此无论是 confirm 阶段失败还是 cancel 阶段失败都能通过不断重试直至 confirm 或 cancel 成功(所谓成功就是所有的服务都对 confirm 或者 cancel 返回了 ACK)。

这里还有个关键问题,在不断重试 confirm 和 cancel 的过程中(考虑到网络二将军问题的存在)有可能重复进行了 confirm 或 cancel,因此还要再保证 confirm 和 cancel 操作具有幂等性,也就是整个全局事务中,每个参与者只进行一次 confirm 或者 cancel。

实现 confirm 和 cancel 操作的幂等性,有很多解决方案,例如每个参与者可以维护一个去重表(可以利用数据库表实现也可以使用内存型 KV 组件实现),记录每个全局事务(以全局事务标记 XID 区分)是否进行过 confirm 或 cancel 操作,若已经进行过,则不再重复执行。

TCC 由支付宝团队提出,被广泛应用于金融系统中。我们用银行账户余额购买基金时,会注意到银行账户中用于购买基金的那部分余额首先会被冻结,由此我们可以猜想,也就是进入了 TCC 的第一阶段。

优点:

性能提升,具体业务来实现控制资源锁的粒度大小

数据最终一致性,基于confirm和cancel的幂等性,确保事务最终完成是提交还是取消的最终一致性

可靠性,解决了XA协议的协调者单点故障问题,有主业务发起并控制整个业务活动,业务活动管理器也变为多点,引入集群

缺点:

TCC的try,confirm和cancel操作功能要按具体业务来实现,业务耦合度较高,提高了开发成本

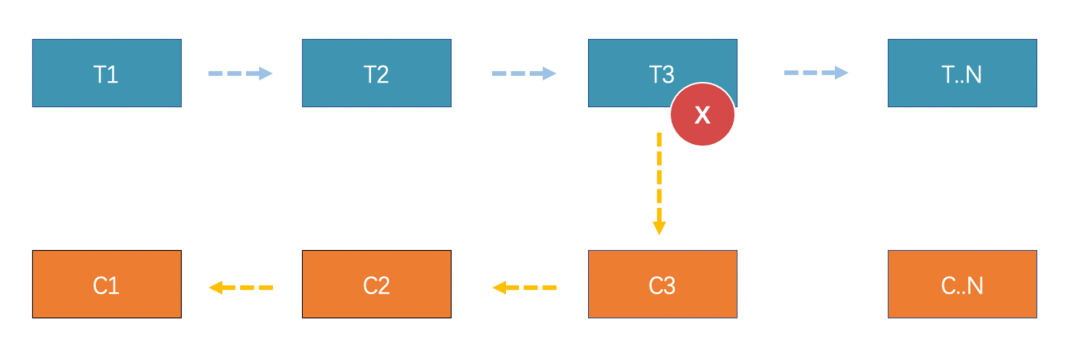

2、Saga模式

起源于1987年Hector Garcia-Molina和Kenneth Salem发表的论文《Sagas》,主要思想是把一个分布式事务拆分为多个本地事务,每一个本地事务都有相应的正常执行方法和异常补偿方法,当任意一个本地事务出错时,都可以通过调用相应的异常补偿方法恢复之前的事务或是继续执行未完成的事务,保证事务的最终一致性。

它是一种基于失败的设计,如上图可以看到,每个活动或者子事务流程,一般都会有对应的补偿服务。如果分布式事务发生异常的话,在 Saga 模式中,就要进行所谓的“恢复”,恢复有两种方式,逆向补偿和正向重试。

比如上面的分布式事务执行到 T3 失败,逆向补偿将会依次执行对应的 C3、C2、C1 操作,取消事务活动的“影响”。

那正向补偿,它是一往无前的,T3 失败了,会进行不断的重试,然后继续按照流程执行 T4、T5 等。

Saga的实现方式

有多种,流行的有基于事件的方式和基于命令的方式。

基于事件:(Event Choreography)

没有协调中心,整个模式的工作方式就像舞蹈一样,每个舞蹈者按照预先编排的动作和走位各自表演,最终形成舞蹈。处于当前Saga下的各个服务,会产生某类事件,或者监听其他服务产生的时间并决定是否针对要监听的时间做响应。

优点:

-

各参与方相互无直接沟通,完全解耦

-

适合整个分布式事务只有2-4个步骤。

缺点:

-

如果业务方较多,容易失控。

-

各个业务参与方可随意监控对方消息,最后可能没人知道到底那个系统在监听哪些消息,甚至坏环监听(两个业务相互监听对方产生的事件)

基于命令:(Order Orchestrator)

这种形式就像乐队,由一个指挥家(协调中心)来协调大家的工作。协调中心来告诉Saga的参与者应该执行哪一部分本地事务。

优点:

-

服务之间关系简单,避免服务间循环依赖

-

事务交由协调中心管理,协调中心对整个业务非常清晰

-

程序开发简单,只需要执行命令/回复(其实回复消息也是一种事件消息),降低参与者的复杂性

-

易维护扩展,在添加新步骤时,事务复杂性保持线性,回滚更容易管理,更容易实施和测试

缺点:

-

中央协调器处理逻辑容易变得庞大复杂,导致难以维护。

-

存在协调器单点故障风险。

2.2 seeta-saga状态机模式

Seata是一款开源的分布式事务解决方案,致力于提供高性能和简单易用的分布式事务服务。

Seata将为用户提供了AT、TCC、SAGA和XA事务模式,为用户打造一站式的分布式解决方案。

1.1 Seata的三大角色

在 Seata 的架构中,一共有三个角色:

TC (Transaction Coordinator) - 事务协调者

维护全局和分支事务的状态,驱动全局事务提交或回滚。

TM (Transaction Manager) - 事务管理器

定义全局事务的范围:开始全局事务、提交或回滚全局事务。

RM (Resource Manager) - 资源管理器

管理分支事务处理的资源,与TC交谈以注册分支事务和报告分支事务的状态,并驱动分支事务提交或回滚。

其中,TC 为单独部署的 Server 服务端,TM 和 RM 为嵌入到应用中的 Client 客户端。

Seata Saga的实现方式:

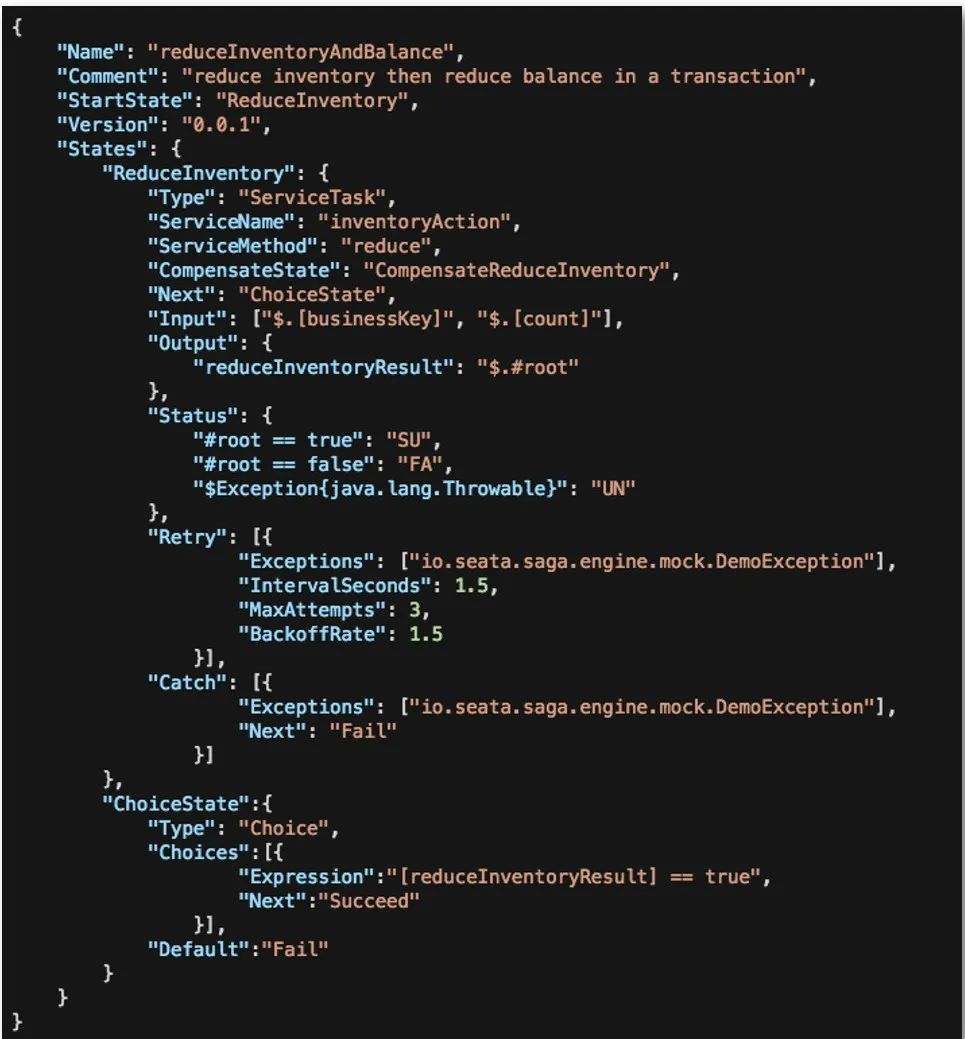

Seata Saga 的实现方式是编排式,是基于状态机引擎实现的。状态机执行的最小单位是节点:节点可以表示一个服务调用,对应 Saga 事务就是子事务活动或流程,也可以配置其补偿节点,通过链路的串联,编排出一个状态机调用流程。在 Seata 里,调用流程目前使用 JSON 描述,由状态机引擎驱动执行,当异常的时候,我们也可以选择补偿策略,由 Seata 协调者端触发事务补偿。

有没有感觉像是服务编排,区别于服务编排,Seata Saga 状态机是 Saga+服务编排,支持补偿服务,保证最终一致性。

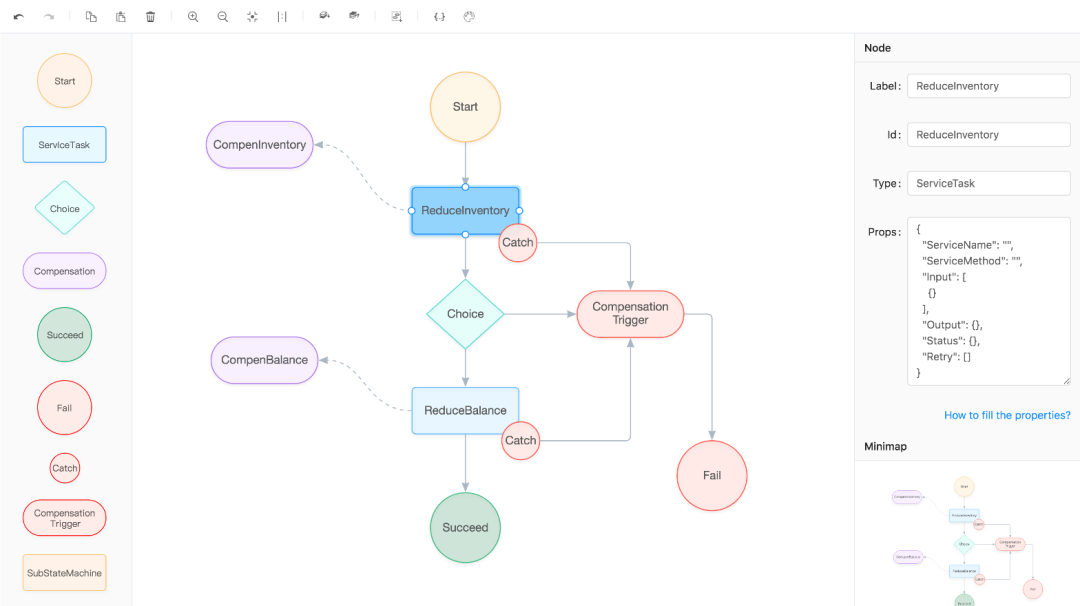

我们来看看一个简单的状态机流程定义:

上方是一个 Name 为 reduceIncentoryAndBalance 的状态机描述,里面定了 ServiceTask 类型的服务调用节点以及对应的补偿节点 CompensateReduceInventory。

看看几个基本的属性:

Type:节点类型,Seata Saga 支持多种类型的节点。例如 ServiceTask 是服务调用节点

ServiceName/ServiceMethod:标识 ServiceTask 服务及对应方法

Input/Output:定义输入输出参数,输入输出参数取值目前使用的是 SPEL 表达式

Retry:控制重试流程

Catch/Next:用于流程控制、衔接,串联整个状态机流程

Seata -saga工作流程图:

更多类型和语法可以参考 Seata 官方文档[1],可以看到状态机 JSON 声明还是有些难度的,为了简化状态机 JSON 的编写,我们也提供了可视化的编排界面[2],如下所示,编排了一个较为复杂的流程。

Reduce Inventory 进行扣减库存

Reduce Balance 进行扣减余额

Compensation Trigger 触发补偿机制

Compen Inventory 进行补偿库存

Compen Balance 进行补偿余额

优点:

-

Saga模式非常适合用来处理时间跨度比较长的分布式事务问题。

-

对于分布式事务参与方的完成时效性没有要求。

-

Saga模式可以在不同的阶段进行补偿操作,从而保证了数据的最终一致性。

-

Saga模式可以通过异步消息来实现,从而提高了系统的可扩展性。

缺点:

-

Saga模式需要开发人员自己实现补偿操作,这增加了开发难度。

-

Saga模式需要开发人员自己实现事务状态机,这增加了开发难度。

-

Saga模式可能会导致事务执行时间过长,从而影响系统的性能。

2.2. Seata-AT模式

Seata 的 AT 模式建立在关系型数据库的本地事务特性的基础之上,通过数据源代理类拦截并解析数据库执行的 SQL,记录自定义的回滚日志,如需回滚,则重放这些自定义的回滚日志即可。

AT 模式虽然是根据 XA 事务模型(2PC)演进而来的,但是 AT 打破了 XA 协议的阻塞性制约,在一致性和性能上取得了平衡。

AT 模式是基于 XA 事务模型演进而来的,它的整体机制也是一个改进版本的两阶段提交协议。AT 模式的两个基本阶段是:

1)第一阶段:首先获取本地锁,执行本地事务,业务数据操作和记录回滚日志在同一个本地事务中提交,最后释放本地锁;

2)第二阶段:如需全局提交,异步删除回滚日志即可,这个过程很快就能完成。如需要回滚,则通过第一阶段的回滚日志进行反向补偿。

Seata in AT mode 的工作原理使用的电商微服务模型如下图所示:

在上图中,协调者 shopping-service 先调用参与者 repo-service 扣减库存,后调用参与者 order-service 生成订单。这个业务流使用 Seata in XA mode 后的全局事务流程如下图所示:

上图描述的全局事务执行流程为:

1)shopping-service 向 Seata 注册全局事务,并产生一个全局事务标识 XID

2)将 repo-service.repo_db、order-service.order_db 的本地事务执行到待提交阶段,事务内容包含对 repo-service.repo_db、order-service.order_db 进行的查询操作以及写每个库的 undo_log 记录

3)repo-service.repo_db、order-service.order_db 向 Seata 注册分支事务,并将其纳入该 XID 对应的全局事务范围

4)提交 repo-service.repo_db、order-service.order_db 的本地事务

5)repo-service.repo_db、order-service.order_db 向 Seata 汇报分支事务的提交状态

6)Seata 汇总所有的 DB 的分支事务的提交状态,决定全局事务是该提交还是回滚

7)Seata 通知 repo-service.repo_db、order-service.order_db 提交/回滚本地事务,若需要回滚,采取的是补偿式方法

其中 1)2)3)4)5)属于第一阶段,6)7)属于第二阶段。

2.2. Seata in AT mode 工作流程详述

在上面的电商业务场景中,购物服务调用库存服务扣减库存,调用订单服务创建订单,显然这两个调用过程要放在一个事务里面。即:

start global_trx call 库存服务的扣减库存接口 call 订单服务的创建订单接口 commit global_trx

在库存服务的数据库中,存在如下的库存表 t_repo:

| id | production_code | name | count | price |

|---|---|---|---|---|

| 10001 | 20001 | xx 键盘 | 98 | 200.0 |

| 10002 | 20002 | yy 鼠标 | 199 | 100.0 |

在订单服务的数据库中,存在如下的订单表 t_order:

| id | order_code | user_id | production_code | count | price |

|---|---|---|---|---|---|

| 30001 | 2020102500001 | 40001 | 20002 | 1 | 100.0 |

| 30002 | 2020102500001 | 40001 | 20001 | 2 | 400.0 |

现在,id 为 40002 的用户要购买一只商品代码为 20002 的鼠标,整个分布式事务的内容为:

1)在库存服务的库存表中将记录

| id | production_code | name | count | price |

|---|---|---|---|---|

| 10002 | 20002 | yy 鼠标 | 199 | 100.0 |

修改为

| id | production_code | name | count | price |

|---|---|---|---|---|

| 10002 | 20002 | yy 鼠标 | 198 | 100.0 |

2)在订单服务的订单表中添加一条记录

| id | order_code | user_id | production_code | count | price |

|---|---|---|---|---|---|

| 30003 | 2020102500002 | 40002 | 20002 | 1 | 100.0 |

以上操作,在 AT 模式的第一阶段的流程图如下:

从 AT 模式第一阶段的流程来看,分支的本地事务在第一阶段提交完成之后,就会释放掉本地事务锁定的本地记录。这是 AT 模式和 XA 最大的不同点,在 XA 事务的两阶段提交中,被锁定的记录直到第二阶段结束才会被释放。所以 AT 模式减少了锁记录的时间,从而提高了分布式事务的处理效率。AT 模式之所以能够实现第一阶段完成就释放被锁定的记录,是因为 Seata 在每个服务的数据库中维护了一张 undo_log 表,其中记录了对 t_order / t_repo 进行操作前后记录的镜像数据,即便第二阶段发生异常,只需回放每个服务的 undo_log 中的相应记录即可实现全局回滚。

undo_log 的表结构:

| id | branch_id | xid | context | rollback_info | log_status | log_created | log_modified |

|---|---|---|---|---|---|---|---|

| …… | 分支事务 ID | 全局事务 ID | …… | 分支事务操作的记录在事务前后的记录镜像,即 beforeImage 和 afterImage | …… | …… | …… |

第一阶段结束之后,Seata 会接收到所有分支事务的提交状态,然后决定是提交全局事务还是回滚全局事务。

1)若所有分支事务本地提交均成功,则 Seata 决定全局提交。Seata 将分支提交的消息发送给各个分支事务,各个分支事务收到分支提交消息后,会将消息放入一个缓冲队列,然后直接向 Seata 返回提交成功。之后,每个本地事务会慢慢处理分支提交消息,处理的方式为:删除相应分支事务的 undo_log 记录。之所以只需删除分支事务的 undo_log 记录,而不需要再做其他提交操作,是因为提交操作已经在第一阶段完成了(这也是 AT 和 XA 不同的地方)。这个过程如下图所示:

分支事务之所以能够直接返回成功给 Seata,是因为真正关键的提交操作在第一阶段已经完成了,清除 undo_log 日志只是收尾工作,即便清除失败了,也对整个分布式事务不产生实质影响。

2)若任一分支事务本地提交失败,则 Seata 决定全局回滚,将分支事务回滚消息发送给各个分支事务,由于在第一阶段各个服务的数据库上记录了 undo_log 记录,分支事务回滚操作只需根据 undo_log 记录进行补偿即可。全局事务的回滚流程如下图所示:

这里对图中的 2、3 步做进一步的说明:

1)由于上文给出了 undo_log 的表结构,所以可以通过 xid 和 branch_id 来找到当前分支事务的所有 undo_log 记录;

2)拿到当前分支事务的 undo_log 记录之后,首先要做数据校验,如果 afterImage 中的记录与当前的表记录不一致,说明从第一阶段完成到此刻期间,有别的事务修改了这些记录,这会导致分支事务无法回滚,向 Seata 反馈回滚失败;如果 afterImage 中的记录与当前的表记录一致,说明从第一阶段完成到此刻期间,没有别的事务修改这些记录,分支事务可回滚,进而根据 beforeImage 和 afterImage 计算出补偿 SQL,执行补偿 SQL 进行回滚,然后删除相应 undo_log,向 Seata 反馈回滚成功。

事务具有 ACID 特性,全局事务解决方案也在尽量实现这四个特性。以上关于 Seata in AT mode 的描述很显然体现出了 AT 的原子性、一致性和持久性。下面着重描述一下 AT 如何保证多个全局事务的隔离性的。

在 AT 中,当多个全局事务操作同一张表时,通过全局锁来保证事务的隔离性。下面描述一下全局锁在读隔离和写隔离两个场景中的作用原理:

1)写隔离(若有全局事务在改/写/删记录,另一个全局事务对同一记录进行的改/写/删要被隔离起来,即写写互斥):写隔离是为了在多个全局事务对同一张表的同一个字段进行更新操作时,避免一个全局事务在没有被提交成功之前所涉及的数据被其他全局事务修改。写隔离的基本原理是:在第一阶段本地事务(开启本地事务的时候,本地事务会对涉及到的记录加本地锁)提交之前,确保拿到全局锁。如果拿不到全局锁,就不能提交本地事务,并且不断尝试获取全局锁,直至超出重试次数,放弃获取全局锁,回滚本地事务,释放本地事务对记录加的本地锁。

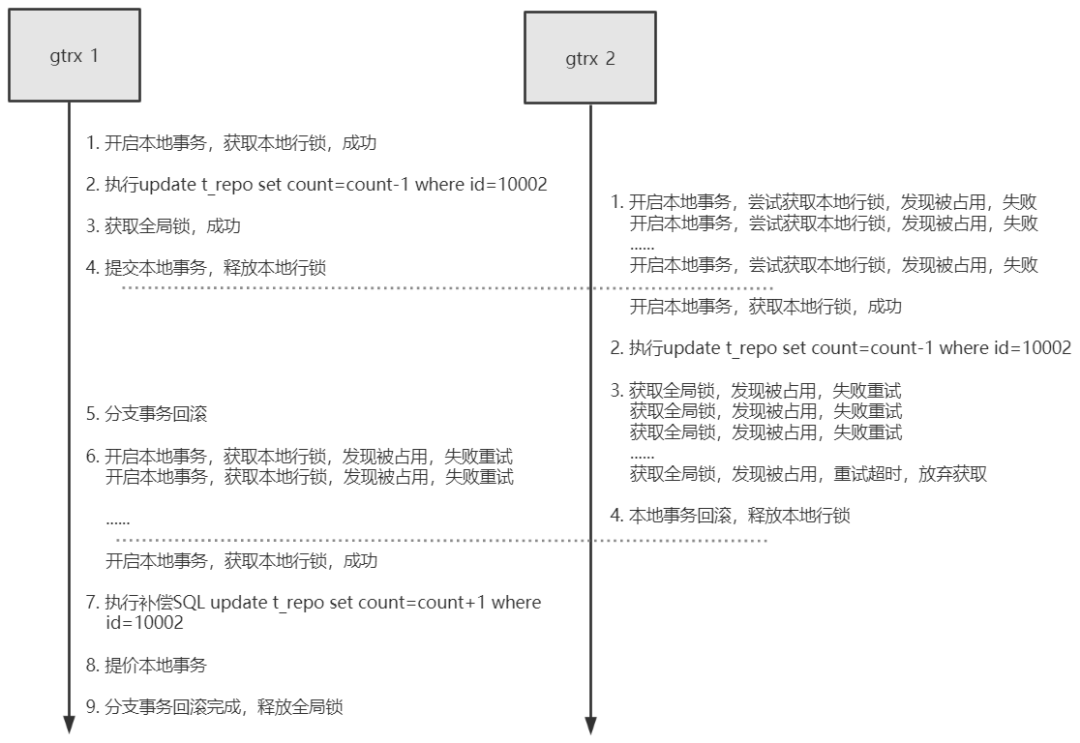

假设有两个全局事务 gtrx_1 和 gtrx_2 在并发操作库存服务,意图扣减如下记录的库存数量:

AT 实现写隔离过程的时序图如下:

图中,1、2、3、4 属于第一阶段,5 属于第二阶段。

在上图中 gtrx_1 和 gtrx_2 均成功提交,如果 gtrx_1 在第二阶段执行回滚操作,那么 gtrx_1 需要重新发起本地事务获取本地锁,然后根据 undo_log 对这个 id=10002 的记录进行补偿式回滚。此时 gtrx_2 仍在等待全局锁,且持有这个 id=10002 的记录的本地锁,因此 gtrx_1 会回滚失败(gtrx_1 回滚需要同时持有全局锁和对 id=10002 的记录加的本地锁),回滚失败的 gtrx_1 会一直重试回滚。直到旁边的 gtrx_2 获取全局锁的尝试次数超过阈值,gtrx_2 会放弃获取全局锁,发起本地回滚,本地回滚结束后,自然会释放掉对这个 id=10002 的记录加的本地锁。此时,gtrx_1 终于可以成功对这个 id=10002 的记录加上了本地锁,同时拿到了本地锁和全局锁的 gtrx_1 就可以成功回滚了。整个过程,全局锁始终在 gtrx_1 手中,并不会发生脏写的问题。整个过程的流程图如下所示:

2)读隔离(若有全局事务在改/写/删记录,另一个全局事务对同一记录的读取要被隔离起来,即读写互斥):在数据库本地事务的隔离级别为读已提交、可重复读、串行化时(读未提交不起什么隔离作用,一般不使用),Seata AT 全局事务模型产生的隔离级别是读未提交,也就是说一个全局事务会看到另一个全局事务未全局提交的数据,产生脏读,从前文的第一阶段和第二阶段的流程图中也可以看出这一点。这在最终一致性的分布式事务模型中是可以接受的。

如果要求 AT 模型一定要实现读已提交的事务隔离级别,可以利用 Seata 的 SelectForUpdateExecutor 执行器对 SELECT FOR UPDATE 语句进行代理。SELECT FOR UPDATE 语句在执行时会申请全局锁,如果全局锁已经被其他全局事务占有,则回滚 SELECT FOR UPDATE 语句的执行,释放本地锁,并且重试 SELECT FOR UPDATE 语句。在这个过程中,查询请求会被阻塞,直到拿到全局锁(也就是要读取的记录被其他全局事务提交),读到已被全局事务提交的数据才返回。这个过程如下图所示:

3、基于消息队列的异步模型

无论是 2PC & 3PC 还是 TCC、事务状态表,基本都遵守 XA 协议的思想,即这些方案本质上都是事务协调者协调各个事务参与者的本地事务的进度,使所有本地事务共同提交或回滚,最终达成一种全局的 ACID 特性。在协调的过程中,协调者需要收集各个本地事务的当前状态,并根据这些状态发出下一阶段的操作指令。

但是这些全局事务方案由于操作繁琐、时间跨度大,或者在全局事务期间会排他地锁住相关资源,使得整个分布式系统的全局事务的并发度不会太高。这很难满足电商等高并发场景对事务吞吐量的要求,因此互联网服务提供商探索出了很多与 XA 协议背道而驰的分布式事务解决方案。

其中利用消息中间件实现的最终一致性全局事务就是一个经典方案。

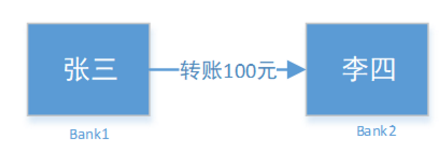

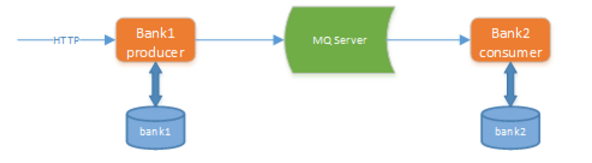

为了表现出这种方案的精髓,我将使用如下的电商系统微服务结构来进行描述:

在这个模型中,用户不再是请求整合后的 shopping-service 进行下单,而是直接请求 order-service 下单,order-service 一方面添加订单记录,另一方面会调用 repo-service 扣减库存。

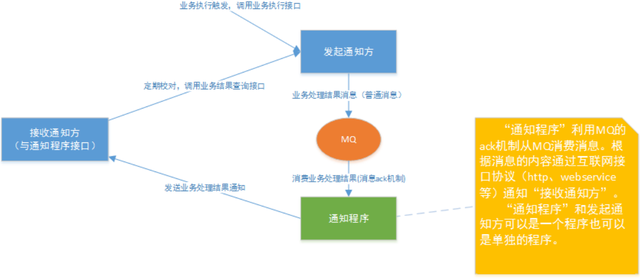

这种基于消息中间件的最终一致性事务方案实现方式:

如下所示:

完整业务流程图:

当用户下单操作业务开始,订单服务先插入订单表,并记录事件表,定时任务会读取未发送的事件(0未发送,1已发送)发到消息队列并将事件状态改为1.

库存服务监听程序会消费消息队列中的消息,并根据事件记录事件表,并返回消息队列ACK确认。库存服务中同样有一个定时任务读取事件,并将未处理(0未处理,1已处理)的做响应的扣减库存操作。

上图所示的方案,利用消息中间件如 rabbitMQ 来实现分布式下单及库存扣减过程的最终一致性。对这幅图做以下说明:

1)order-service 中,

在 t_order 表添加订单记录 && 在 t_local_msg 添加对应的扣减库存消息

这两个过程要在一个事务中完成,保证过程的原子性。同样,repo-service 中,

检查本次扣库存操作是否已经执行过 && 执行扣减库存如果本次扣减操作没有执行过 && 写判重表 && 向 MQ sever 反馈消息消费完成 ACK

这四个过程也要在一个事务中完成,保证过程的原子性。

2)order-service 中有一个后台程序,源源不断地把消息表中的消息传送给消息中间件,成功后则删除消息表中对应的消息。如果失败了,也会不断尝试重传。由于存在网络 2 将军问题,即当 order-service 发送给消息中间件的消息网络超时时,这时候消息中间件可能收到了消息但响应 ACK 失败,也可能没收到,order-service 会再次发送该消息,直至消息中间件响应 ACK 成功,这样可能发生消息的重复发送,不过没关系,只要保证消息不丢失,不乱序就行,后面 repo-service 会做去重处理。

3)消息中间件向 repo-service 推送 repo_deduction_msg,repo-service 成功处理完成后会向中间件响应 ACK,消息中间件收到这个 ACK 才认为 repo-service 成功处理了这条消息,否则会重复推送该消息。但是有这样的情形:repo-service 成功处理了消息,向中间件发送的 ACK 在网络传输中由于网络故障丢失了,导致中间件没有收到 ACK 重新推送了该消息。这也要靠 repo-service 的消息去重特性来避免消息重复消费。

4)在 2)和 3)中提到了两种导致 repo-service 重复收到消息的原因,一是生产者重复生产,二是中间件重传。为了实现业务的幂等性,repo-service 中维护了一张判重表,这张表中记录了被成功处理的消息的 id。repo-service 每次接收到新的消息都先判断消息是否被成功处理过,若是的话不再重复处理。

通过这种设计,实现了消息在发送方不丢失,消息在接收方不被重复消费,联合起来就是消息不漏不重,严格实现了 order-service 和 repo-service 的两个数据库中数据的最终一致性。

优点:

基于消息中间件的最终一致性全局事务方案是互联网公司在高并发场景中探索出的一种创新型应用模式,利用 MQ 实现微服务之间的异步调用、解耦合和流量削峰,支持全局事务的高并发,并保证分布式数据记录的最终一致性。降低用户的响应时间,提高系统的吞吐量。

缺点:

系统不能做到强一致,会有短暂不一致。

归纳总结:

XA 协议是 X/Open 提出的分布式事务处理标准。文中提到的 2PC、3PC、TCC、本地事务表、Seata in AT mode,无论哪一种,本质都是事务协调者协调各个事务参与者的本地事务的进度,使使所有本地事务共同提交或回滚,最终达成一种全局的 ACID 特性。在协调的过程中,协调者需要收集各个本地事务的当前状态,并根据这些状态发出下一阶段的操作指令。这个思想就是 XA 协议的要义,我们可以说这些事务模型遵守或大致遵守了 XA 协议。

基于消息中间件的最终一致性事务方案是互联网公司在高并发场景中探索出的一种创新型应用模式,利用 MQ 实现微服务之间的异步调用、解耦合和流量削峰,保证分布式数据记录的最终一致性。它显然不遵守 XA 协议。

对于某项技术,可能存在业界标准或协议,但实践者针对具体应用场景的需求或者出于简便的考虑,给出与标准不完全相符的实现,甚至完全不相符的实现,这在工程领域是一种常见的现象。TCC 方案如此、基于消息中间件的最终一致性事务方案如此、Seata in AT mode 模式也如此。而新的标准往往就在这些创新中产生。

二:分布式幂等性如何设计

1. 什么是幂等性?

幂等性是指在分布式系统中,一个操作多次执行的结果与其执行一次的结果相同。设计具有幂等性的分布式系统可以有效避免数据不一致和重复处理的问题。

幂等系统的应用场景

在微服务架构下,由于分布式天然特性的时序问题, 以及网络的不可靠性(机器、机架、机房故障, 电缆被挖断等等), 重复请求很常见, 接口幂等性设计就显得尤为重要。 比如浏览器/客户端多次提交、微服务间超时重试、消息重复消费等。 以订单流程为例的幂等性场景:

1.一个订单创建接口,第一次调用超时了,然后调用方重试了一次 2.在订单创建时,我们需要去扣减库存,这时接口发生了超时,调用方重试了一次 3.当这笔订单开始支付,在支付请求发出之后,在服务端发生了扣钱操作,接口响应超时了,调用方重试了一次 4.一个订单状态更新接口,调用方连续发送了两个消息,一个是已创建,一个是已付款。但是你先接收到已付款,然后又接收到了已创建 5.在支付完成订单之后,需要发送一条短信,当一台机器接收到短信发送的消息之后,处理较慢。消息中间件又把消息投递给另外一台机器处理

为了解决以上问题,就需要保证接口的幂等性,接口的幂等性实际上就是接口可重复调用,在调用方多次调用的情况下,接口最终得到的结果是一致的。有些接口可以天然的实现幂等性,比如查询接口,对于查询来说,你查询一次和两次,对于系统来说,没有任何影响,查出的结果也是一样。除了查询功能具有天然的幂等性之外,增加、更新、删除都要保证幂等性。

2. 分布式幂等性设计方法

2.1 利用数据库实现幂等性

数据库的唯一约束和事务特性可以用来实现幂等性。例如,在处理支付请求时,我们可以在支付记录表中插入一条带有唯一支付 ID 的记录。如果数据库已存在相同支付 ID 的记录,则认为该支付请求已处理过,从而实现幂等性。

1、去重表(唯一索引)

往数据库去重表里插入数据的时候,利用数据库的唯一索引特性,保证唯一的逻辑。唯一序列号可以是一个字段,例如订单的订单号,也可以是多字段的唯一性组合。

使用数据库防重表的方式它有个严重的缺点,那就是系统容错性不高,如果幂等表所在的数据库连接异常或所在的服务器异常,则会导致整个系统幂等性校验出问题。

2、多版本号控制之乐观锁

多版本并发控制,该策略主要使用update with condition(更新带条件来防止)来保证多次外部请求调用对系统的影响是一致的。在系统设计的过程中,合理的使用乐观锁,通过version或者updateTime(timestamp)等其他条件,来做乐观锁的判断条件,这样保证更新操作即使在并发的情况下,也不会有太大的问题。借鉴数据库的乐观锁机制。

示例:

update t_goods set count = count -1 , version = version + 1 where good_id=2 and version = 1

根据version版本,也就是在操作库存前先获取当前商品的version版本号,然后操作的时候带上此version号。我们梳理下,我们第一次操作库存时,得到version为1,调用库存服务version变成了2;但返回给订单服务出现了问题,订单服务又一次发起调用库存服务,当订单服务传如的version还是1,再执行上面的sql语句时,就不会执行;因为version已经变为2了,where条件就不成立。这样就保证了不管调用几次,只会真正的处理一次。

3、悲观锁

使用悲观锁实现幂等性,一般是配合事务一起来实现。

使用select…for update会把数据给锁住,不过我们需要注意一些锁的级别,MySQL InnoDB默认行级锁。行级锁都是基于索引的,如果一条SQL语句用不到索引是不会使用行级锁的,会使用表级锁把整张表锁住。for update仅适用于InnoDB,且必须在事务块(BEGIN/COMMIT)中才能生效。在进行事务操作时,通过“for update”语句,MySQL会对查询结果集中每行数据都添加排他锁,其他线程对该记录的更新与删除操作都会阻塞。排他锁包含行锁、表锁。

select for update,整个执行过程中锁定该订单对应的记录。注意:这种在DB读大于写的情况下尽量少用。

举个更新订单的业务场景:

假设先查出订单,如果查到的是处理中状态,就处理完业务,再然后更新订单状态为完成。如果查到订单,并且是不是处理中的状态,则直接返回

4、全局唯一ID

如果使用全局唯一ID,就是根据业务的操作和内容生成一个全局ID,在执行操作前先根据这个全局唯一ID是否存在,来判断这个操作是否已经执行。如果不存在则把全局ID,存储到存储系统中,比如数据库、Redis等。如果存在则表示该方法已经执行。使用全局唯一ID是一个通用方案,可以支持插入、更新、删除业务操作。

结合redis的incr自增实现全局唯一ID,是一个常用的方案。

示例代码:

#####

2.2 使用分布式事务实现幂等性

在涉及多个服务和数据源的场景下,可以使用分布式事务来实现幂等性。例如,使用两阶段提交(2PC)或者三阶段提交(3PC)协议来保证多个服务间的数据一致性。

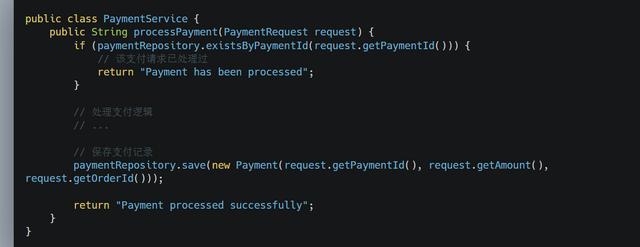

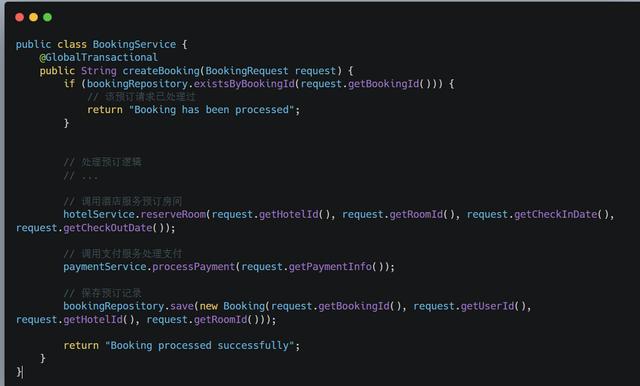

示例代码:

在这个示例中,我们使用 @GlobalTransactional 注解来标记需要分布式事务支持的方法。在处理预订请求时,系统首先检查预订记录是否已存在,然后依次调用酒店服务和支付服务。如果其中任何一个服务出现异常,分布式事务将回滚,确保数据的一致性和幂等性。

2.3、token机制

token机制的幂等保障的主要流程就是:

1.服务端提供了发送token的接口。我们在分析业务的时候,哪些业务是存在幂等问题的,就必须在执行业务前,先去获取token,服务器会把token保存2.到redis中。(微服务肯定是分布式了,如果单机就适用jvm缓存)。 3.然后调用业务接口请求时,把token携带过去,一般放在请求头部。 4.服务器判断token是否存在redis中,存在表示第一次请求,这时把redis中的token删除,继续执行业务。 5.如果判断token不存在redis中,就表示是重复操作,直接返回重复标记给client,这样就保证了业务代码,不被重复执行。

缺点:

业务请求每次请求,都会有额外的请求(一次获取token请求、判断token是否存在的业务)。其实真实的生产环境中,1万请求也许只会存在10个左右的请求会发生重试,为了这10个请求,我们让9990个请求都发生了额外的请求。(当然redis性能很好,耗时不会太明显)

2.4,分布式锁

分布式锁可以确保同一时间只有一个线程处理特定的操作。我们可以在处理关键业务逻辑之前获取分布式锁,从而保证幂等性。

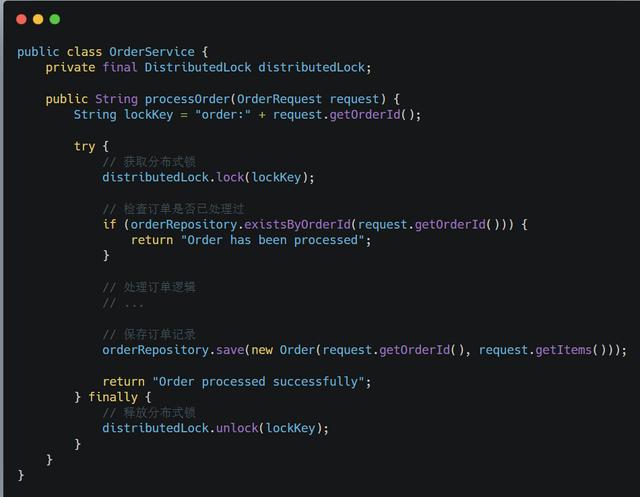

示例代码:

#####

分布式锁实现幂等性的逻辑是,在每次执行方法之前判断,是否可以获取到分布式锁,如果可以,则表示为第一次执行方法,否则直接舍弃请求即可。需要注意的是分布式锁的key必须为业务的唯一标识,通常适用redis或者zookeeper来实现分布式锁

如果是分布是系统,构建唯一索引比较困难,例如唯一性的字段没法确定,这时候可以引入分布式锁,通过第三方的系统,在业务系统插入数据或者更新数据,获取分布式锁,然后做操作,之后释放锁,这样其实是把多线程并发的锁的思路,引入多多个系统,也就是分布式系统中得解决思路;

目前主要有几种方式实现分布式锁:

1、redis setNx命令

(1)获取锁的时候,使用setnx加锁,并使用expire命令为锁添加一个超时时间,超过该时间则自动释放锁,锁的value值为一个随机生成的UUID,通过此在释放锁的时候进行判断。

(2)获取锁的时候还设置一个获取的超时时间,若超过这个时间则放弃获取锁。

(3)释放锁的时候,通过UUID判断是不是该锁,若是该锁,则执行delete进行锁释放。

优点:

(1)Redis有很高的性能; (2)Redis命令对此支持较好,实现起来比较方便

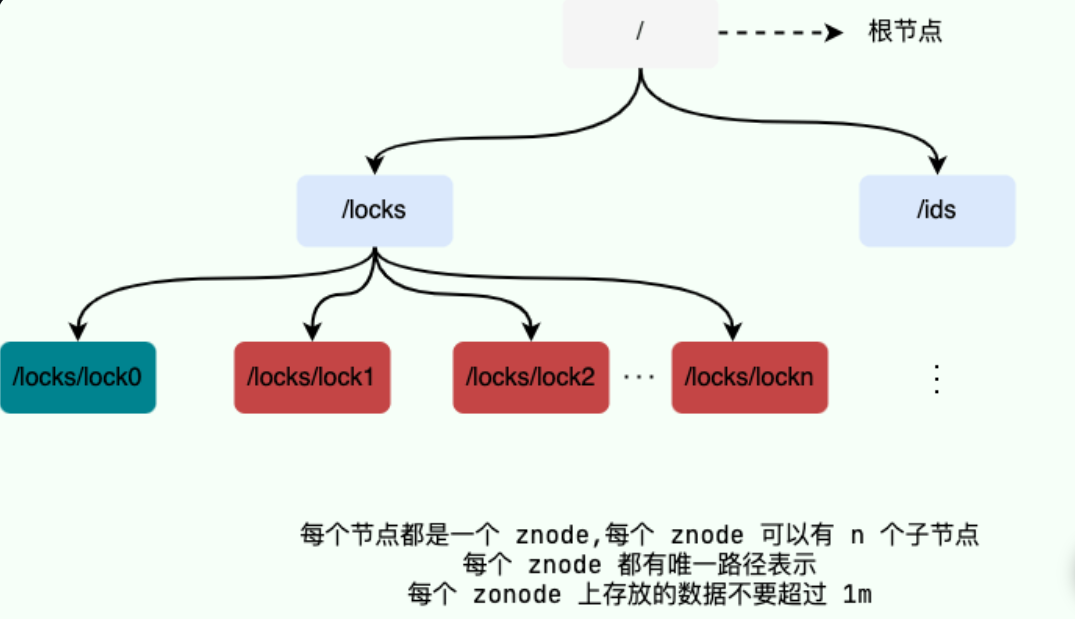

2,基于ZooKeeper的实现方式

ZooKeeper是一个为分布式应用提供一致性服务的开源组件,它内部是一个分层的文件系统目录树结构,规定同一个目录下只能有一个唯一文件名。基于ZooKeeper实现分布式锁的步骤如下:

(1)创建一个目录mylock; (2)线程A想获取锁就在mylock目录下创建临时顺序节点; (3)获取mylock目录下所有的子节点,然后获取比自己小的兄弟节点,如果不存在,则说明当前线程顺序号最小,获得锁; (4)线程B获取所有节点,判断自己不是最小节点,设置监听比自己次小的节点; (5)线程A处理完,删除自己的节点,线程B监听到变更事件,判断自己是不是最小的节点,如果是则获得锁。

优点:具备高可用、可重入、阻塞锁特性,可解决失效死锁问题。

缺点:因为需要频繁的创建和删除节点,性能上不如Redis方式。

3, 状态机

在设计单据相关的业务,或者是任务相关的业务,肯定会涉及到状态机,就是业务单据上面有个状态,状态在不同的情况下会发生变更,一般情况下存在有限状态机,这时候,如果状态机已经处于下一个状态,这时候来了一个上一个状态的变更,理论上是不能够变更的,这样的话,保证了有限状态机的幂等。

很多业务表,都是有状态的,比如转账流水表,就会有0-待处理,1-处理中、2-成功、3-失败状态。转账流水更新的时候,都会涉及流水状态更新,即涉及状态机 (即状态变更图)。

状态机是怎么实现幂等的呢?

第1次请求来时,如流水号是 666,该流水的状态是处理中,值是 1,要更新为2-成功的状态,所以该update语句可以正常更新数据,sql执行结果的影响行数是1,流水状态最后变成了2。 第2请求也过来了,如果它的流水号还是 666,因为该流水状态已经2-成功的状态了,所以不会再处理业务逻辑,接口直接返回。 示例: 对于不少业务是有一个业务流转状态的,每一个状态都有前置状态和后置状态,以及最后的结束状态。例如流程的待审批,审批中,驳回,从新发起,审批经过,审批拒绝。订单的待提交,待支付,已支付,取消。

3.幂等性设计的注意事项

在实现分布式幂等性时,需要考虑以下几点:

-

幂等性操作的粒度:根据业务场景和性能要求,可以选择适当的幂等性设计粒度,如方法级、服务级或全局级。

-

幂等性与性能的权衡:实现幂等性可能会增加系统的复杂性和性能开销。在设计时,需要考虑这些因素并选择合适的实现策略。

-

幂等性与可用性的关系:某些幂等性实现方法可能会影响系统的可用性,如分布式锁。在设计时,需要充分了解各种方法的优缺点,选择合适的方案。

三:分布式ID

必要性

业务量小于500W或数据容量小于2G的时候单独一个mysql即可提供服务,再大点的时候就进行读写分离也可以应付过来。但当主从同步也扛不住的是就需要分表分库了,但[分库分表]后需要有一个唯一ID来标识一条数据,数据库的自增ID显然不能满足需求;

特别一点的如订单、[优惠券]也都需要有唯一ID做标识。此时一个能够生成全局唯一ID的系统是非常必要的。那么这个全局唯一ID就叫分布式ID。

分布式ID需满足那些条件

-

全局唯一:基本要求就是必须保证ID是全局性唯一的。

-

高性能:高可用低延时,ID生成响应要快。

-

高可用:无限接近于100%的可用性

-

好接入:遵循拿来主义原则,在系统设计和实现上要尽可能的简单

-

趋势递增:最好趋势递增,这个要求就得看具体业务场景了,一般不严格要求

1. UUID

UUID 是指Universally Unique Identifier,翻译为中文是通用唯一识别码,UUID 的目的是让分布式系统中的所有元素都能有唯一的识别信息。形式为 8-4-4-4-12,总共有 36个字符。用起来非常简单

import java.util.UUID; public static void main(String[] args) { String uuid = UUID.randomUUID().toString().replaceAll("-",""); System.out.println(uuid); }

输出结果 99a7d0925b294a53b2f4db9d5a3fb798,但UUID却并不适用于实际的业务需求。订单号用UUID这样的字符串没有丝毫的意义,看不出和订单相关的有用信息;而对于数据库来说用作业务主键ID,它不仅是太长还是字符串,存储性能差查询也很耗时,所以不推荐用作分布式ID。

优点:生成足够简单,本地生成无网络消耗,具有唯一性

缺点:无序的字符串,不具备趋势自增特性,没有具体的业务含义。如此长的字符串当MySQL主键并非明智选择。

2. 基于数据库自增ID

基于数据库的auto_increment自增ID完全可以充当分布式ID,具体实现:需要一个单独的MySQL实例用来生成ID,建表结构如下:

CREATE DATABASE `SoWhat_ID`;CREATE TABLE SoWhat_ID.SEQUENCE_ID (

`id` bigint(20) unsigned NOT NULL auto_increment,

`value` char(10) NOT NULL default '',

`update_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP, PRIMARY KEY (id),) ENGINE=MyISAM;insert into SEQUENCE_ID(value) VALUES ('values');

当我们需要一个ID的时候,向表中插入一条记录返回主键ID,但这种方式有一个比较致命的缺点,访问量激增时MySQL本身就是系统的瓶颈,用它来实现分布式服务风险比较大,不推荐!

优点:实现简单,ID单调自增,数值类型查询速度快

缺点:DB单点存在宕机风险,无法扛住高并发场景

3. 基于数据库集群模式

前边说了单点数据库方式不可取,那对上边的方式做一些高可用优化,换成主从模式集群。害怕一个主节点挂掉没法用,那就做双主模式集群,也就是两个Mysql实例都能单独的生产自增ID。那这样还会有个问题,两个MySQL实例的自增ID都从1开始,会生成重复的ID怎么办?解决方案:设置起始值和自增步长

MySQL_1 配置:

set @@auto_increment_offset = 1; -- 起始值set @@auto_increment_increment = 2; -- 步长

MySQL_2 配置:

set @@auto_increment_offset = 2; -- 起始值set @@auto_increment_increment = 2; -- 步长

这样两个MySQL实例的自增ID分别就是:

1、3、5、7、9 2、4、6、8、10

但是如果两个还是无法满足咋办呢?增加第三台MySQL实例需要人工修改一、二两台MySQL实例的起始值和步长,把第三台机器的ID起始生成位置设定在比现有最大自增ID的位置远一些,但必须在一、二两台MySQL实例ID还没有增长到第三台MySQL实例的起始ID值的时候,否则自增ID就要出现重复了,必要时可能还需要停机修改。

优点:解决DB单点问题

缺点:不利于后续扩容,而且实际上单个数据库自身压力还是大,依旧无法满足高并发场景。

4. 基于数据库的号段模式

号段模式是当下分布式ID生成器的主流实现方式之一,号段模式可以理解为从数据库批量的获取自增ID,每次从数据库取出一个号段范围,例如 (1,1000] 代表1000个ID,具体的业务服务将本号段,生成1~1000的自增ID并加载到内存。表结构如下:

CREATE TABLE id_generator ( `id` int(10) NOT NULL, `max_id` bigint(20) NOT NULL COMMENT '当前最大id', `step` int(20) NOT NULL COMMENT '号段的步长', `biz_type` int(20) NOT NULL COMMENT '业务类型', `version` int(20) NOT NULL COMMENT '版本号', PRIMARY KEY (`id`))

-

max_id :当前最大的可用id

-

step :代表号段的长度

-

biz_type :代表不同业务类型

-

version :是一个乐观锁,每次都更新version,保证并发时数据的正确性

| id | biz_type | max_id | step | version |

|---|---|---|---|---|

| 1 | 101 | 1000 | 2000 | 0 |

等这批号段ID用完,再次向数据库申请新号段,对max_id字段做一次update操作,update max_id= max_id + step,update成功则说明新号段获取成功,新的号段范围是(max_id ,max_id +step]。

update id_generator set max_id = {max_id+step}, version = version + 1 where version = {version} and biz_type = XX

由于多业务端可能同时操作,所以采用版本号 version 乐观锁方式更新,这种分布式ID生成方式不强依赖于数据库,不会频繁的访问数据库,对数据库的压力小很多。但是如果遇到了双十一或者秒杀类似的活动还是会对数据库有比较高的访问。

5. 基于Redis模式

Redis 也同样可以实现,原理就是Redis 是单线程的,因此我们可以利用redis的incr命令实现ID的原子性自增。

127.0.0.1:6379> set seq_id 1 // 初始化自增ID为1OK127.0.0.1:6379> incr seq_id // 增加1,并返回递增后的数值(integer) 2

用redis实现需要注意一点,要考虑到redis持久化的问题。redis有两种持久化方式RDB和AOF。

6. 基于雪花算法(Snowflake)模式

SnowFlake 算法,是 Twitter 开源的分布式 id 生成算法。其核心思想就是:使用一个 64 bit 的 long 型的数字作为全局唯一 id。在分布式系统中的应用十分广泛,且ID 引入了时间戳,为什么叫雪花算法呢?私以为众所周知世界上没有一对相同的雪花。雪花算法基本上保持自增的,后面的代码中有详细的注解。

| 1bit | 41bit | 5bit | 5bit 12 bit | |

|---|---|---|---|---|

| 0 | 0001100 10100010 10111110 10001001 01011100 00 | 10001 | 11001 0000 00000000 |

这 64 个 bit 中,其中 1 个 bit 是不用的,然后用其中的 41 bit 作为毫秒数,用 10 bit 作为工作机器 id,12 bit 作为序列号。举例如上图:

-

第一个部分是 1 个 bit:0, 这个是无意义的。因为二进制里第一个 bit 位如果是 1,那么都是负数,但是我们生成的 id 都是正数,所以第一个 bit 统一都是 0。

-

第二个部分是 41 个 bit:表示的是时间戳。单位是毫秒。41 bit 可以表示的数字多达 2^41 - 1,也就是可以标识 2 ^ 41 - 1 个毫秒值,换算成年就是表示 69 年的时间。

-

第三个部分是 5 个 bit:表示的是机房 id 5 个 bit 代表机器 id。意思就是最多代表 2 ^ 5 个机房(32 个机房)

-

第四个部分是 5 个 bit:表示的是机器 id。每个机房里可以代表 2 ^ 5 个机器(32 台机器),也可以根据自己公司的实际情况确定。

-

第五个部分是 12 个 bit:表示的序号,就是某个机房某台机器上这一毫秒内同时生成的 id 的序号。12 bit 可以代表的最大正整数是 2 ^ 12 - 1 = 4096,也就是说可以用这个 12 bit 代表的数字来区分同一个毫秒内的 4096 个不同的 id。

总结:简单来说,你的某个服务假设要生成一个全局唯一 id,那么就可以发送一个请求给部署了 SnowFlake 算法的系统,由这个 SnowFlake 算法系统来生成唯一 id。

这个 SnowFlake 算法系统首先肯定是知道自己所在的机房和机器的,比如机房 id = 17,机器 id = 12。

接着 SnowFlake 算法系统接收到这个请求之后,首先就会用二进制位运算的方式生成一个 64 bit 的 long 型 id,64 个 bit 中的第一个 bit 是无意义的。

接着 41 个 bit,就可以用当前时间戳(单位到毫秒),然后接着 5 个 bit 设置上这个机房 id,还有 5 个 bit 设置上机器 id。

最后再判断一下,当前这台机房的这台机器上这一毫秒内,这是第几个请求,给这次生成 id 的请求累加一个序号,作为最后的 12 个 bit。最终一个 64 个 bit 的 id 就出来了,类似于:

| 1bit | 41bit | 5bit | 5bit 12 bit | |

|---|---|---|---|---|

| 0 | 0001100 10100010 10111110 10001001 01011100 00 | 10001 | 11001 0000 00000000 |

这个算法可以保证一个机房的一台机器在同一毫秒内,生成了一个唯一的 id。可能一个毫秒内会生成多个 id,但是有最后 12 个 bit 的序号来区分开来。

总结:就是用一个 64 bit 的数字中各个 bit 位来设置不同的标志位,区分每一个 id。

SnowFlake 算法的实现代码如下:

/** * 雪花算法相对来说如果思绪捋顺了实现起来比较简单,前提熟悉位运算。 */

public class SnowFlake{

/** * 开始时间截 (2015-01-01) */

private final long twepoch = 1420041600000L;

/** * 机器id所占的位数 */

private final long workerIdBits = 5L;

/** * 数据标识id所占的位数 */

private final long dataCenterIdBits = 5L;

/** * 支持的最大机器id,结果是31 (这个移位算法可以很快的计算出几位二进制数所能表示的最大十进制数) */

private final long maxWorkerId = ~(-1L << workerIdBits); /** * 支持的最大机房标识id,结果是31 */

private final long maxDataCenterId = ~(-1L << dataCenterIdBits); /** * 序列在id中占的位数 */

private final long sequenceBits = 12L; /** * 机器ID向左移12位 */

private final long workerIdShift = sequenceBits; /** * 机房标识id向左移17位(12+5) */

private final long dataCenterIdShift = sequenceBits + workerIdBits; /** * 时间截向左移22位(5+5+12) */

private final long timestampLeftShift = sequenceBits + workerIdBits + dataCenterIdBits;

/** * 生成序列的掩码,这里为4095 (0b111111111111=0xfff=4095) */

private final long sequenceMask = ~(-1L << sequenceBits); /** * 工作机器ID(0~31) */

private volatile long workerId; /** * 机房中心ID(0~31) */

private volatile long dataCenterId; /** * 毫秒内序列(0~4095) */

private volatile long sequence = 0L; /** * 上次生成ID的时间截 */

private volatile long lastTimestamp = -1L; //==============================Constructors=====================================

/** * 构造函数 * * @param workerId 工作ID (0~31) * @param dataCenterId 机房中心ID (0~31) */

public SnowFlake(long workerId, long dataCenterId) { if (workerId > maxWorkerId || workerId < 0) { throw new IllegalArgumentException(String.format("worker Id can't be greater than %d or less than 0", maxWorkerId)); } if (dataCenterId > maxDataCenterId || dataCenterId < 0) {

throw new IllegalArgumentException(String.format("dataCenter Id can't be greater than %d or less than 0", maxDataCenterId)); }

this.workerId = workerId; this.dataCenterId = dataCenterId;

} // ==============================Methods==========================================

/** * 获得下一个ID (该方法是线程安全的) * 如果一个线程反复获取Synchronized锁,那么synchronized锁将变成偏向锁。 * * @return SnowflakeId */

public synchronized long nextId() throws RuntimeException { long timestamp = timeGen();

//如果当前时间小于上一次ID生成的时间戳,说明系统时钟回退过这个时候应当抛出异常

if (timestamp < lastTimestamp) {

throw new RuntimeException((String.format("Clock moved backwards. Refusing to generate id for %d milliseconds", lastTimestamp - timestamp))); }

//如果是毫秒级别内是同一时间生成的,则进行毫秒内序列生成

if (lastTimestamp == timestamp) { sequence = (sequence + 1) & sequenceMask;

//毫秒内序列溢出,一毫秒内超过了4095个

if (sequence == 0) {

//阻塞到下一个毫秒,获得新的时间戳

timestamp = tilNextMillis(lastTimestamp); } } else {

//时间戳改变,毫秒内序列重置

sequence = 0L; }

//上次生成ID的时间截

lastTimestamp = timestamp;

//移位并通过或运算拼到一起组成64位的ID

return ((timestamp - twepoch) << timestampLeftShift) | (dataCenterId << dataCenterIdShift) | (workerId << workerIdShift) | sequence; }

/** * 阻塞到下一个毫秒,直到获得新的时间戳 * @param lastTimestamp 上次生成ID的时间截 * @return 当前时间戳 */

private long tilNextMillis(long lastTimestamp) {

long timestamp = timeGen(); while (timestamp <= lastTimestamp) {

timestamp = timeGen(); } return timestamp; }

/** * 返回以毫秒为单位的当前时间 * @return 当前时间(毫秒) */

private long timeGen() { return System.currentTimeMillis(); }

}

SnowFlake算法的优点:

-

高性能高可用:生成时不依赖于数据库,完全在内存中生成。

-

容量大:每秒中能生成数百万的自增ID。

-

ID自增:存入数据库中,索引效率高。

SnowFlake算法的缺点:

-

依赖与系统时间的一致性,如果系统时间被回调,或者改变,可能会造成id冲突或者重复。

-

在单机上是递增的,但是由于涉及到分布式环境,每台机器上的时钟不可能完全同步,有时候会出现不是全局递增的情况 (此缺点可以认为无所谓,一般分布式ID只要求趋势递增,不会严格要求递增,90%的需求都只要求趋势递增)

实际中我们的机房并没有那么多,我们可以改进改算法,将10bit的机器id优化成业务表或者和我们系统相关的业务。

7. 百度uid-generator

项目GitHub地址:https://github.com/baidu/uid-generator,uid-generator是由百度技术部开发,基于Snowflake算法实现的,与原始的snowflake算法不同在于,uid-generator支持自定义时间戳、工作机器ID和 序列号等各部分的位数,而且uid-generator中采用用户自定义workId的生成策略。

uid-generator需要与数据库配合使用,需要新增一个WORKER_NODE表。当应用启动时会向数据库表中去插入一条数据,插入成功后返回的自增ID就是该机器的workId数据由host,port组成。

由上图可知,UidGenerator的时间部分只有28位,这就意味着UidGenerator默认只能承受8.5年(2^28-1/86400/365)。当然,根据你业务的需求,UidGenerator可以适当调整delta seconds、worker node id和sequence占用位数。

接下来分析百度UidGenerator的实现。需要说明的是UidGenerator有两种方式提供:和DefaultUidGenerator和CachedUidGenerator。我们先分析比较容易理解的DefaultUidGenerator。

DefaultUidGenerator

delta seconds这个值是指当前时间与epoch时间的时间差,且单位为秒。epoch时间就是指集成UidGenerator生成分布式ID服务第一次上线的时间,可配置,也一定要根据你的上线时间进行配置,因为默认的epoch时间可是2016-09-20,不配置的话,会浪费好几年的可用时间。

worker id接下来说一下UidGenerator是如何给worker id赋值的,搭建UidGenerator的话,需要创建一个表:

UidGenerator会在集成用它生成分布式ID的实例启动的时候,往这个表中插入一行数据,得到的id值就是准备赋给workerId的值。由于workerId默认22位,那么,集成UidGenerator生成分布式ID的所有实例重启次数是不允许超过4194303次(即2^22-1),否则会抛出异常。

这段逻辑的核心代码来自DisposableWorkerIdAssigner.java中,当然,你也可以实现WorkerIdAssigner.java接口,自定义生成workerId。sequence核心代码如下,几个实现的关键点:

-

synchronized保证线程安全。

-

如果时间有任何的回拨,那么直接抛出异常。

-

如果当前时间和上一次是同一秒时间,那么sequence自增。如果同一秒内自增值超过2^13-1,那么就-- 会自旋等待下一秒(getNextSecond)。

-

如果是新的一秒,那么sequence重新从0开始。

/** * Get UID * * @return UID * @throws UidGenerateException in the case: Clock moved backwards; Exceeds the max timestamp */ protected synchronized long nextId() { long currentSecond = getCurrentSecond(); // Clock moved backwards, refuse to generate uid if (currentSecond < lastSecond) { long refusedSeconds = lastSecond - currentSecond; throw new UidGenerateException("Clock moved backwards. Refusing for %d seconds", refusedSeconds); } // At the same second, increase sequence if (currentSecond == lastSecond) { sequence = (sequence + 1) & bitsAllocator.getMaxSequence(); // Exceed the max sequence, we wait the next second to generate uid if (sequence == 0) { currentSecond = getNextSecond(lastSecond); } // At the different second, sequence restart from zero } else { sequence = 0L; } lastSecond = currentSecond; // Allocate bits for UID return bitsAllocator.allocate(currentSecond - epochSeconds, workerId, sequence); }

总结通过DefaultUidGenerator的实现可知,它对时钟回拨的处理比较简单粗暴。另外如果使用UidGenerator的DefaultUidGenerator方式生成分布式ID,一定要根据你的业务的情况和特点,调整各个字段占用的位数:

<property name="timeBits" value="28"/><property name="workerBits" value="22"/><property name="seqBits" value="13"/><property name="epochStr" value="2016-09-20"/>

CachedUidGenerator

CachedUidGenerator是UidGenerator的重要改进实现。它的核心利用了RingBuffer,如下图所示,它本质上是一个数组,数组中每个项被称为slot。UidGenerator设计了两个RingBuffer,一个保存唯一ID,一个保存flag。RingBuffer的尺寸是2^n,n必须是正整数:

具体细节阅读Git源码即可,可以直接通过 SpringBoot 集成开发使用。

8. 美团(Leaf)

Leaf由美团开发,github地址:GitHub - Meituan-Dianping/Leaf: Distributed ID Generate Service,Leaf同时支持号段模式和snowflake算法模式,可以 切换使用。

号段模式

先导入源码 https://github.com/Meituan-Dianping/Leaf ,在建一张表leaf_alloc

DROP TABLE IF EXISTS `leaf_alloc`;CREATE TABLE `leaf_alloc` ( `biz_tag` varchar(128) NOT NULL DEFAULT '' COMMENT '业务key', `max_id` bigint(20) NOT NULL DEFAULT '1' COMMENT '当前已经分配了的最大id', `step` int(11) NOT NULL COMMENT '初始步长,也是动态调整的最小步长', `description` varchar(256) DEFAULT NULL COMMENT '业务key的描述', `update_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '数据库维护的更新时间', PRIMARY KEY (`biz_tag`)) ENGINE=InnoDB;

然后在项目中开启号段模式,配置对应的数据库信息,并关闭snowflake模式

leaf.name=com.sankuai.leaf.opensource.testleaf.segment.enable=trueleaf.jdbc.url=jdbc:mysql://localhost:3306/leaf_test?useUnicode=true&characterEncoding=utf8&characterSetResults=utf8leaf.jdbc.username=rootleaf.jdbc.password=rootleaf.snowflake.enable=false#leaf.snowflake.zk.address=#leaf.snowflake.port=

启动leaf-server 模块的 LeafServerApplication项目就跑起来了 号段模式获取分布式自增ID的测试url :http://localhost:8080/api/segment/get/leaf-segment-test 监控号段模式:http://localhost:8080/cache

snowflake模式

Leaf的snowflake模式依赖于ZooKeeper,不同于原始snowflake算法也主要是在workId的生成上,Leaf中workId是基于ZooKeeper的顺序Id来生成的,每个应用在使用Leaf-snowflake时,启动时都会都在Zookeeper中生成一个顺序Id,相当于一台机器对应一个顺序节点,也就是一个workId。

leaf.snowflake.enable=trueleaf.snowflake.zk.address=127.0.0.1leaf.snowflake.port=2181

snowflake模式获取分布式自增ID的测试url:http://localhost:8080/api/snowflake/get/test

9. 滴滴(Tinyid)

Tinyid 由滴滴开发,Github地址:https://github.com/didi/tinyid

Tinyid是一个ID生成器服务,它提供了REST API和Java客户端两种获取方式,如果使用Java客户端获取方式的话,官方宣称能单实例能达到1kw QPS(Over10 million QPSper single instance when using the java client.)

Tinyid教程 的原理非常简单,通过数据库表中的数据基本是就能猜出个八九不离十,就是经典的segment模式,和美团的leaf原理几乎一致。原理图如下所示,以同一个bizType为例,每个tinyid-server会分配到不同的segment,例如第一个tinyid-server分配到(1000, 2000],第二个tinyid-server分配到(2000, 3000],第3个tinyid-server分配到(3000, 4000]:

再以第一个tinyid-server为例,当它的segment用了20%(核心源码:segmentId.setLoadingId(segmentId.getCurrentId().get() + idInfo.getStep() * Constants.LOADING_PERCENT / 100);,LOADING_PERCENT的值就是20),即设定loadingId为20%的阈值,例如当前id是10000,步长为10000,那么loadingId=12000。那么当请求分布式ID分配到12001时(或者重启后),即超过loadingId,就会返回一个特殊code:new Result(ResultCode.LOADING, id);tinyid-server根据ResultCode.LOADING这个响应码就会异步分配下一个segment(4000, 5000],以此类推。

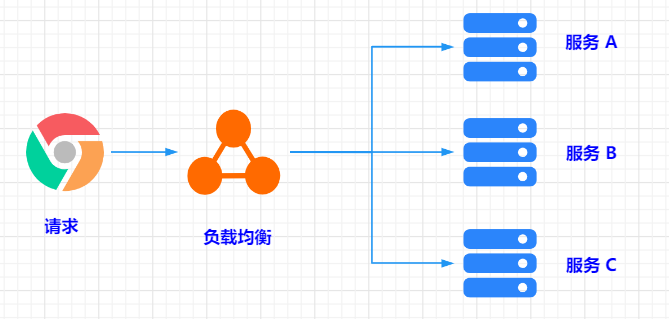

四:常见的负载均衡算法

介绍

负载均衡算法是在分布式系统中常用的一种技术,它通过合理地分配请求负载到多个服务器上,提高系统的性能和可靠性。

常见的负载均衡算法,包括轮询、随机、加权、EDF、堆维护、最小连接数、加权最少连接数和哈希算法等,接下来看看其原理和适用场景。

一、轮询算法(Round Robin)

轮询算法是最简单直观的负载均衡算法之一。在轮询算法中,每个请求依次按照顺序被分配到不同的服务器上。当一个新的请求到达时,它会被分配到列表中的下一个服务器。轮询算法可以保证请求均匀地分配到各个服务器上,但无法考虑各个服务器的实际负载情况。

后面讲的的加权也可结合轮询使用

代码实现示范:

public class RoundRobinLoadBalancer {

// 记录上一次选择的服务器下标

private int lastIndex = -1;

// 传入服务器列表,返回轮询选择的服务器

public Server selectServer(List<Server> serverList) {

// 获取服务器列表大小

int size = serverList.size();

// 如果服务器列表为空,返回null

if (size == 0) {

return null;

}

// 如果只有一个服务器,直接返回该服务器

if (size == 1) {

return serverList.get(0);

}

// 上锁,保证线程安全

synchronized (this) {

// 如果上一次选择的服务器下标超出了服务器列表大小,重置为-1

if (lastIndex >= size) {

lastIndex = -1;

}

// 选择下一个服务器

int index = lastIndex + 1;

lastIndex = index;

// 返回选择的服务器

return serverList.get(index);

}

}

// 服务器类

public static class Server {

private String ip;

private int port;

public Server(String ip, int port) {

this.ip = ip;

this.port = port;

}

// getter和setter方法省略

}

}

这里有两个需要注意的点

-

当我们初始化位置时,需要将其设置为一个随机值,避免多个负载均衡器同时请求同一个服务器,造成服务器的瞬时压力

-

在位置自增时,需要忽略符号位,因为Java没有无符号整数,所以当位置的值超出整型最大值时会变成负值导致抛出异常。至于为什么不能使用绝对值,是因为整型的最小值没有对应的绝对值,得到的依旧是负值

二、随机算法(Random)

随机算法是一种将请求随机分配到集群中的某个节点上的负载均衡算法。它通过随机选择一个节点来处理该请求。由于随机算法的特性,随着请求量的增加,各个节点处理请求的数量会趋于平衡,即演变为轮询算法。随机算法简单高效,适用于对负载均衡的绝对要求不高的场景。

基于Java的随机负载均衡算法实例:

// 基于Java的随机负载均衡算法

public class RandomLoadBalancer {

// 传入服务器列表,返回随机选择的服务器

public Server selectServer(List<Server> serverList) {

// 获取服务器列表大小

int size = serverList.size();

// 生成随机数

int randomIndex = new Random().nextInt(size);

// 返回随机选择的服务器

return serverList.get(randomIndex);

}

// 服务器类

public static class Server {

private String ip;

private int port;

public Server(String ip, int port) {

this.ip = ip;

this.port = port;

}

// getter和setter方法省略

}

}

三、加权算法(Weighted)

加权算法是一种根据服务器节点性能和负载情况分配权重的负载均衡算法。每个节点的权重值根据其性能差异进行设置,性能好的节点设置较大的权重,而性能差的节点则设置较小的权重。当收到一个新的请求时,算法会根据节点权重的比例来分配请求。这样可以更好地平衡各个节点的负载压力。

假设有3台服务、权重为3/5/2: server1 3 server2 5 server3 2

可以细分为随机加权负载、轮询加权负载

区别如下

随机加权负载: 就是按照几率选择服务,这里提供一个方案:

初始化一个容量为10的数组,随机装载上以上服务id,比如server2就会占有5个下标,获取服务的时候获取一个随机数0-9,取对应下标的服务,如果服务已经被取过了则下标+1,往上推,到了边界则置0再往上推,如果全被取过一次了,则重新装载

轮询加权负载: 就是挨个遍历结果,这里提供一个比较好的示例:

public class WeightedRoundRobinLoadBalancer {

// 记录上一次选择的服务器下标

private int lastIndex = -1;

// 记录当前权重

private int currentWeight = 0;

// 最大权重

private int maxWeight;

// 权重的最大公约数

private int gcdWeight;

// 服务器列表

private List<Server> serverList;

public WeightedRoundRobinLoadBalancer(List<Server> serverList) {

this.serverList = serverList;

init();

}

// 初始化

private void init() {

// 获取最大权重

maxWeight = getMaxWeight();

// 获取权重的最大公约数

gcdWeight = getGcdWeight();

}

// 传入服务器列表,返回加权轮询选择的服务器

public Server selectServer() {

while (true) {

// 上一次选择的服务器下标加1

lastIndex = (lastIndex + 1) % serverList.size();

// 如果上一次选择的服务器下标为0,重新计算当前权重

if (lastIndex == 0) {

currentWeight = currentWeight - gcdWeight;

if (currentWeight <= 0) {

currentWeight = maxWeight;

if (currentWeight == 0) {

return null;

}

}

}

// 获取当前下标的服务器

Server server = serverList.get(lastIndex);

// 如果当前服务器的权重大于等于当前权重,返回该服务器

if (server.getWeight() >= currentWeight) {

return server;

}

}

}

// 获取最大权重

private int getMaxWeight() {

int maxWeight = 0;

for (Server server : serverList) {

int weight = server.getWeight();

if (weight > maxWeight) {

maxWeight = weight;

}

}

return maxWeight;

}

// 获取权重的最大公约数

private int getGcdWeight() {

int gcdWeight = 0;

for (Server server : serverList) {

int weight = server.getWeight();

if (gcdWeight == 0) {

gcdWeight = weight;

} else {

gcdWeight = gcd(gcdWeight, weight);

}

}

return gcdWeight;

}

// 求最大公约数

private int gcd(int a, int b) {

if (b == 0) {

return a;

} else {

return gcd(b, a % b);

}

}

// 服务器类

public static class Server {

private String ip;

private int port;

private int weight; // 权重

public Server(String ip, int port, int weight) {

this.ip = ip;

this.port = port;

this.weight = weight;

}

// getter和setter方法省略

}

public static void main(String[] args) {

List<Server> servers=new ArrayList<>();

servers.add(new Server("1", 1, 3));

servers.add(new Server("2", 2, 5));

servers.add(new Server("3", 3, 2));

WeightedRoundRobinLoadBalancer weightedRoundRobinLoadBalancer = new WeightedRoundRobinLoadBalancer(servers);

System.out.println(JSON.toJSON(weightedRoundRobinLoadBalancer.selectServer()));

}

}

这里有三个需要注意的点:

-

当实例按权重展开成数组的时候,可能会出现实例权重都很大,但是它们的最大公约数不为1,这个时候可以使用最大公约数来减少展开后的数组大小。因为最大公约数的诸多限制,例如任意自然数N与N+1互质,任意自然数N与1互质,所以很容易出现优化失败的情况,因此本示例并未给出,感兴趣的可以去看Spring Cloud相关PR(Spring Cloud #1140)

-

在实例按权重展开成数组后,需要对得到的数组进行洗牌,以保证流量尽可能均匀,避免连续请求相同实例(Java中实现的洗牌算法是Fisher-Yates算法,其他语言可以自行实现)

-

因为是在构建负载均衡器的时候按权重展开成数组的,所以在负载均衡器构建完成后无法再改变实例的权值,对于频繁动态变更权重的场景不适用

四、EDF(Earliest Deadline First)实现

EDF算法最早被用在CPU调度上,EDF是抢占式单处理器调度的最佳调度算法。EDF实现与权重轮转实现相似,引入了名为deadline的额外变量,可以认为权重越高的服务器实例完成任务的时间越快,那么在假设所有请求的成本相同时,所需要花费的时间是权重的倒数,所以可以很自然地选择可以最早空闲出来提供服务的服务器实例,并将任务分配给它。

实现EDF算法只需要将每个下游服务器实例与deadline绑定,然后以deadline为优先级维护到优先队列中,并不断取出队首元素,调整它的deadline,并将它重新提交到优先队列中。知名Service Mesh代理envoy使用了此方法实现加权负载均衡(envoy),以及蚂蚁开源网络代理mosn中也实现了此方法

java实例代码如下:

public class WeightedLoadBalancer {

private final PriorityQueue entries;

public WeightedLoadBalancer(List instances) {

this.entries = instances.stream().map(EdfEntry::new).collect(Collectors.toCollection(PriorityQueue::new));

}

public ServiceInstance peek(HttpServletRequest request) {

EdfEntry entry = entries.poll();

if (entry == null) {

return null;

}

ServiceInstance instance = entry.instance;

entry.deadline = entry.deadline + 1.0 / instance.getWeight();

entries.add(entry);

return instance;

}

private static class EdfEntry implements Comparable {

final ServiceInstance instance;

double deadline;

EdfEntry(ServiceInstance instance) {

this.instance = instance;

this.deadline = 1.0 / instance.getWeight();

}

@Override

public int compareTo(EdfEntry o) {

return Double.compare(deadline, o.deadline);

}

}

}

EDF每次选择的算法复杂度为O(log(n)),相较于数组展开要慢,但相较于上界收敛选择在最坏情况下以及权重轮转都需要O(n)的时间复杂度来说,其性能表现的非常好,并且对于超大集群,其性能下降不明显。其空间复杂度为O(n),不会造成很大的内存开销

五、堆维护方式

所有动态有序集合都可以通过优先队列来实现,与EDF算法相同,取出队首的元素,修改它的优先级,并放回队列中

代码如下:

public class LeastConnectionLoadBalancer {

private final PriorityQueue instances;

public LeastConnectionLoadBalancer(List instances) {

this.instances = instances.stream().collect(toCollection(

() -> new PriorityQueue<>(comparingInt(ServiceInstance::getConnections))));

}

public ServiceInstance peek(HttpServletRequest request) {

ServiceInstance best = instances.poll();

if (best == null) {

return null;

}

best.setConnections(best.getConnections() + 1);

return best;

}

}

六、最小连接数算法(Least Connections)

最小连接数算法是一种根据集群中每个节点的当前连接数来决定请求分发的负载均衡算法。每次请求都会被分配给当前连接数最少的节点。

该算法可以避免某些节点负载过重,但在突发请求的情况下,仍然可能导致负载不平衡。

代码如下:

public class LeastConnectionLoadBalancer {

private final List instances;

public LeastConnectionLoadBalancer(List instances) {

this.instances = instances;

}

public ServiceInstance peek(HttpServletRequest request) {

ServiceInstance best = null;

for (ServiceInstance instance : instances) {

if (best == null || instance.getConnections() < best.getConnections()) {

best = instance;

}

}

if (best != null) {

best.setConnections(best.getConnections() + 1);

}

return best;

}

}

如果希望最大限度地减少响应时间,则最短响应时间算法是一个很好的选择。对于能够更好地处理复杂请求的服务实例,可以选择最少连接数算法

七、加权最少连接负载均衡算法(Weighted Least Connections)

加权最少连接负载均衡算法的实现方式与最少连接负载均衡算法相同,只是在计算时增加了权重相关的参数

代码如下:

public class LeastConnectionLoadBalancer {

private final List instances;

public LeastConnectionLoadBalancer(List instances) {

this.instances = instances;

}

public ServiceInstance peek(HttpServletRequest request) {

ServiceInstance best = null;

for (ServiceInstance instance : instances) {

if (best == null || instance.getConnections() * best.getWeight() < best.getConnections() * instance.getWeight()) {

best = instance;

}

}

if (best != null) {

best.setConnections(best.getConnections() + 1);

}

return best;

}

}

注意:在不等式中 a/b < c/d 与 ad < bc等价,并且可以避免除法带来的性能与精度问题

八、哈希算法(Hashing)

哈希算法是一种根据请求的特征(如IP地址或URL)进行哈希计算,并将计算结果与集群节点数量取模来确定请求应该被分发到哪个节点的负载均衡算法。哈希算法能够保证相同特征的请求总是被分配到同一个节点上,适用于需要保持特定状态的场景,但它也存在单点服务的问题。

public class HashLoadBalancer {

// 服务器列表

private List<Server> serverList;

public HashLoadBalancer(List<Server> serverList) {

this.serverList = serverList;

}

// 传入客户端IP,返回选择的服务器

public Server selectServer(String clientIp) {

// 将客户端IP进行Hash

int hashCode = clientIp.hashCode();

// 取模得到服务器下标

int index = hashCode % serverList.size();

// 返回对应下标的服务器

return serverList.get(index);

}

// 服务器类

public static class Server {

private String ip;

private int port;

public Server(String ip, int port) {

this.ip = ip;

this.port = port;

}

// getter和setter方法省略

}

}

需要注意的点:

面向公网提供服务的负载均衡器前面可能会经过任意多层反向代理服务器,为了获取到真实的源地址,需要先获取X-Forwarded-For头部,如果该头部不存在再去获取TCP连接的源地址

九、自适应负载均衡算法(Adaptive LoadBalance)

自适应负载均衡算法在P2C(Power of two Choice随机选择两个节点后继续选择连接数较少的节点)算法的基础上,选择二者中load最小的那个节点。详细使用可参看dubbo官网:知乎 - 安全中心

负载均衡有两个主要目标:

保持较短的请求响应时间和较小的请求阻塞概率; 负载均衡算法的 overhead 在可控级别,不占用过多的 CPU 、网络等资源。 自适应负载均衡是指无论系统处于空闲、稳定还是繁忙状态,负载均衡算法都会自动评估系统的服务能力,进行合理的流量分配,使整个系统始终保持较好的性能,不产生饥饿或者过载、宕机。

这种算法对于现在的电商系统、数据中心、云计算等领域都很有必要,使用自适应负载均衡能够更合理的利用资源,提高性能。例如,在双十一零点,用户集中下单支付,整个电商系统的请求速率到达峰值。如果将这些请求流量只分配给少部分 server,这些机器接收到的请求速率会远超过处理速率,新来的任务来不及处理,产生请求任务堆积。

示范代码:

@RestController

@RequestMapping("/balace")

public class DemoController {

@DubboReference(loadbalance=LoadbalanceRules.ADAPTIVE)

public DemoService demoService;

@GetMapping("/hello")

public String sayHello(String name) {

return demoService.sayHello(name);

}

}

综上所述:

负载均衡算法是分布式系统中重要的技术之一,是网络代理与网关组件最核心的组成部分。

能够提高系统的性能和可靠性。本文介绍了常见的负载均衡算法,包括轮询、随机、加权、最小连接数和哈希算法等,并分别说明了它们的原理和适用场景以及实现代码和注意事项。当然还有很多其他的负载均衡策略比如处理能力均衡(CPU、内存)此种均衡算法将把服务请求分配给内部中处理负荷(根据服务器 CPU 型号、CPU 数量、内存大小及当前连接数等换算而成)最轻的服务器,由于考虑到了内部服务器的处理能力及当前网络运行状况,所以此种均衡算法相对来说更加精确,尤其适合运用到第七层(应用层)负载均衡的情况下。以及DNS 响应均衡(Flash DNS)

在此均衡算法下,分处在不同地理位置的负载均衡设备收到同一个客户端的域名解析请求,并在同一时间内把此域名解析成各自相对应服务器的 IP 地址并返回给客户端,则客户端将以最先收到的域名解析 IP 地址来继续请求服务,而忽略其它的 IP 地址响应。在种均衡策略适合应用在全局负载均衡的情况下,对本地负载均衡是没有意义的。

在实际应用中,我们可以根据需求和场景选择合适的负载均衡算法,并结合其他优化策略来提升系统的性能和可扩展性。

五:常见的限流算法

介绍:

随着微服务的流行,服务和服务之间的依赖越来越强,调用关系越来越复杂,服务和服务之间的稳定性越来越重要。在遇到突发的请求量激增,恶意的用户访问,亦或请求频率过高给下游服务带来较大压力时,我们常常需要通过缓存、限流、熔断降级、负载均衡等多种方式保证服务的稳定性。其中限流是不可或缺的一环

在高并发系统中,我们通常需要通过各种手段来提供系统的可以用性,例如缓存、降级和限流等

限流简称流量限速(Rate Limit)是指只允许指定的事件进入系统,超过的部分将被拒绝服务、排队或等待、降级等处理.常见的限流方案如下

限流顾名思义,就是对请求或并发数进行限制;通过对一个时间窗口内的请求量进行限制来保障系统的正常运行。如果我们的服务资源有限、处理能力有限,就需要对调用我们服务的上游请求进行限制,以防止自身服务由于资源耗尽而停止服务。

在限流中有两个概念需要了解。

-

阈值:在一个单位时间内允许的请求量。如 QPS 限制为10,说明 1 秒内最多接受 10 次请求。

-

拒绝策略:超过阈值的请求的拒绝策略,常见的拒绝策略有直接拒绝、排队等待等。

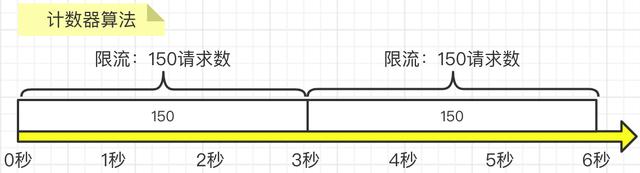

4.1:固定时间窗口限流算法

1,什么是固定时间窗口限流算法?

固定时间窗口限流算法是一种简单的限流方法,也被称之为计数器算法。它将时间分成固定长度的时间窗口,然后在每个时间窗口内对请求进行计数。如果某个时间窗口内的请求数超过了预设的阈值,那么后续请求将被拒绝,直到进入下一个时间窗口。

实现原理

-

时间线划分为多个独立且固定大小窗口;

-

落在每一个时间窗口内的请求就将计数器加1;

-

如果计数器超过了限流阈值,则后续落在该窗口的请求都会被拒绝。但时间达到下一个时间窗口时,计数器会被重置为0。

优点

-

逻辑简单、维护成本比较低;

缺点

-

窗口切换时无法保证限流值。

如图所示,我们要求3秒内的请求不要超过150次:

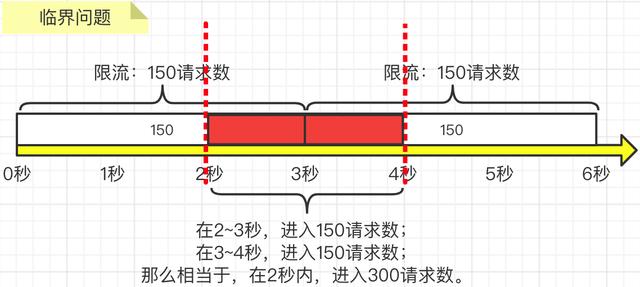

但是,貌似看似很“完美”的流量统计方式其实存在一个非常严重的临界问题,即:如果第2到3秒内产生了

150次请求,而第3到4秒内产生了150次请求,那么其实在第2秒到第4秒这两秒内,就已经发生了300次请求了,远远大于我们要求的3秒内的请求不要超过150次这个限制,如下图所示:

2. 应用场景

固定时间窗口限流算法适用于以下场景:

-

保护后端服务免受大流量冲击,避免服务崩溃。

-

对 API 调用进行限制,保证公平使用。

-

防止恶意用户对服务进行洪水攻击。

3. 代码示例

以下是使用 Java 编写的一个简单的固定时间窗口限流算法实现:

下面是简单的代码实现,QPS 限制为 2,这里的代码做了一些优化,并没有单独开一个线程去每隔 1 秒重置计数器,而是在每次调用时进行时间间隔计算来确定是否先重置计数器。

/**

* @author https://www.wdbyte.com

*/

public class RateLimiterSimpleWindow {

// 阈值

private static Integer QPS = 2;

// 时间窗口(毫秒)

private static long TIME_WINDOWS = 1000;

// 计数器

private static AtomicInteger REQ_COUNT = new AtomicInteger();

private static long START_TIME = System.currentTimeMillis();

public synchronized static boolean tryAcquire() {

if ((System.currentTimeMillis() - START_TIME) > TIME_WINDOWS) {

REQ_COUNT.set(0);

START_TIME = System.currentTimeMillis();

}

return REQ_COUNT.incrementAndGet() <= QPS;

}

public static void main(String[] args) throws InterruptedException {

for (int i = 0; i < 10; i++) {

Thread.sleep(250);

LocalTime now = LocalTime.now();

if (!tryAcquire()) {

System.out.println(now + " 被限流");

} else {

System.out.println(now + " 做点什么");

}

}

}

}

运行结果:

20:53:43.038922 做点什么 20:53:43.291435 做点什么 20:53:43.543087 被限流 20:53:43.796666 做点什么 20:53:44.050855 做点什么 20:53:44.303547 被限流 20:53:44.555008 被限流 20:53:44.809083 做点什么 20:53:45.063828 做点什么 20:53:45.314433 被限流

从输出结果中可以看到大概每秒操作 3 次,由于限制 QPS 为 2,所以平均会有一次被限流。看起来可以了,不过我们思考一下就会发现这种简单的限流方式是有问题的,虽然我们限制了 QPS 为 2,但是当遇到时间窗口的临界突变时,如 1s 中的后 500 ms 和第 2s 的前 500ms 时,虽然是加起来是 1s 时间,却可以被请求 4 次。

简单修改测试代码,可以进行验证:

// 先休眠 400ms,可以更快的到达时间窗口。

Thread.sleep(400);

for (int i = 0; i < 10; i++) {

Thread.sleep(250);

if (!tryAcquire()) {

System.out.println("被限流");

} else {

System.out.println("做点什么");

}

}

得到输出中可以看到连续 4 次请求,间隔 250 ms 没有却被限制。:

20:51:17.395087 做点什么 20:51:17.653114 做点什么 20:51:17.903543 做点什么 20:51:18.154104 被限流 20:51:18.405497 做点什么 20:51:18.655885 做点什么 20:51:18.906177 做点什么 20:51:19.158113 被限流 20:51:19.410512 做点什么 20:51:19.661629 做点什么

4. 固定时间窗口限流算法的局限性

虽然固定时间窗口限流算法简单易实现,但它存在一些局限性:

-

请求可能会在时间窗口的边界处集中,导致短时间内流量激增,从而影响服务稳定性。例如,在某个时间窗口的末尾和下一个时间窗口的开始,短时间内可能会有大量请求通过限流器。

-

由于时间窗口是固定的,限流器对突发流量的处理能力较弱。在某些情况下,可能需要使用更为灵活的限流算法,如滑动时间窗口限流算法或令牌桶算法。

尽管存在这些局限性,但固定时间窗口限流算法在许多场景下仍然具有较好的表现。

在实际应用中,可以根据对此限流算法做响应的改进。

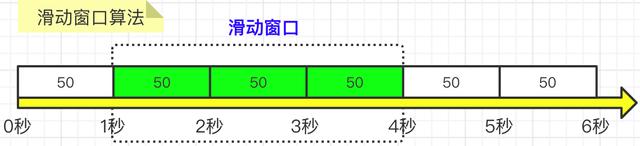

4.2:滑动时间窗口限流算法

1,什么是滑动时间窗口限流算法?

滑动时间窗口算法是对固定时间窗口算法的一种改进,在滑动窗口的算法中,同样需要针对当前的请求来动态查询窗口。但窗口中的每一个元素,都是子窗口。子窗口的概念类似于方案一中的固定窗口,子窗口的大小是可以动态调整的。

解决了固定窗口在窗口切换时会受到两倍于阈值数量的请求,滑动窗口在固定窗口的基础上,将一个窗口分为若干个等份的小窗口,每个小窗口对应不同的时间点,拥有独立的计数器,当请求的时间点大于当前窗口的最大时间点时,则将窗口向前平移一个小窗口(将第一个小窗口的数据舍弃,第二个小窗口变成第一个小窗口,当前请求放在最后一个小窗口),整个窗口的所有请求数相加不能大于阈值。其中,Sentinel就是采用滑动窗口算法来实现限流的。如图所示:

【1】 把3秒钟划分为3个小窗,每个小窗限制请求不能超过50秒。 【2】 比如我们设置,3秒内不能超过150个请求,那么这个窗口就可以容纳3个小窗,并且随着时间推移,往前滑动。每次请求过来后,都要统计滑动窗口内所有小窗的请求总量。

2,实现原理

-

将单位时间划分为多个区间,一般都是均分为多个小的时间段;

-

每一个区间内都有一个计数器,有一个请求落在该区间内,则该区间内的计数器就会加一;

-

每过一个时间段,时间窗口就会往右滑动一格,抛弃最老的一个区间,并纳入新的一个区间;

-

计算整个时间窗口内的请求总数时会累加所有的时间片段内的计数器,计数总和超过了限制数量,则本窗口内所有的请求都被丢弃。

3,代码实现

下面是基于以上滑动窗口思路实现的简单的滑动窗口限流工具类。

package com.wdbyte.rate.limiter;

import java.time.LocalTime;

import java.util.concurrent.atomic.AtomicInteger;

/**

* 滑动窗口限流工具类

*

* @author https://www.wdbyte.com

*/

public class RateLimiterSlidingWindow {

/**

* 阈值

*/

private int qps = 2;

/**

* 时间窗口总大小(毫秒)

*/

private long windowSize = 1000;

/**

* 多少个子窗口

*/

private Integer windowCount = 10;

/**

* 窗口列表

*/

private WindowInfo[] windowArray = new WindowInfo[windowCount];

public RateLimiterSlidingWindow(int qps) {

this.qps = qps;

long currentTimeMillis = System.currentTimeMillis();

for (int i = 0; i < windowArray.length; i++) {

windowArray[i] = new WindowInfo(currentTimeMillis, new AtomicInteger(0));

}

}

/**

* 1. 计算当前时间窗口

* 2. 更新当前窗口计数 & 重置过期窗口计数

* 3. 当前 QPS 是否超过限制

*

* @return

*/

public synchronized boolean tryAcquire() {

long currentTimeMillis = System.currentTimeMillis();

// 1. 计算当前时间窗口

int currentIndex = (int)(currentTimeMillis % windowSize / (windowSize / windowCount));

// 2. 更新当前窗口计数 & 重置过期窗口计数

int sum = 0;

for (int i = 0; i < windowArray.length; i++) {

WindowInfo windowInfo = windowArray[i];

if ((currentTimeMillis - windowInfo.getTime()) > windowSize) {

windowInfo.getNumber().set(0);

windowInfo.setTime(currentTimeMillis);

}

if (currentIndex == i && windowInfo.getNumber().get() < qps) {

windowInfo.getNumber().incrementAndGet();

}

sum = sum + windowInfo.getNumber().get();

}

// 3. 当前 QPS 是否超过限制

return sum <= qps;

}

private class WindowInfo {

// 窗口开始时间

private Long time;

// 计数器

private AtomicInteger number;

public WindowInfo(long time, AtomicInteger number) {

this.time = time;

this.number = number;

}

// get...set...

}

}

下面是测试用例,设置 QPS 为 2,测试次数 20 次,每次间隔 300 毫秒,预计成功次数在 12 次左右。

public static void main(String[] args) throws InterruptedException {

int qps = 2, count = 20, sleep = 300, success = count * sleep / 1000 * qps;

System.out.println(String.format("当前QPS限制为:%d,当前测试次数:%d,间隔:%dms,预计成功次数:%d", qps, count, sleep, success));

success = 0;

RateLimiterSlidingWindow myRateLimiter = new RateLimiterSlidingWindow(qps);

for (int i = 0; i < count; i++) {

Thread.sleep(sleep);

if (myRateLimiter.tryAcquire()) {

success++;

if (success % qps == 0) {

System.out.println(LocalTime.now() + ": success, ");

} else {

System.out.print(LocalTime.now() + ": success, ");

}

} else {

System.out.println(LocalTime.now() + ": fail");

}

}

System.out.println();

System.out.println("实际测试成功次数:" + success);

}

下面是测试的结果。

当前QPS限制为:2,当前测试次数:20,间隔:300ms,预计成功次数:12 16:04:27.077782: success, 16:04:27.380715: success, 16:04:27.684244: fail 16:04:27.989579: success, 16:04:28.293347: success, 16:04:28.597658: fail 16:04:28.901688: fail 16:04:29.205262: success, 16:04:29.507117: success, 16:04:29.812188: fail 16:04:30.115316: fail 16:04:30.420596: success, 16:04:30.725897: success, 16:04:31.028599: fail 16:04:31.331047: fail 16:04:31.634127: success, 16:04:31.939411: success, 16:04:32.242380: fail 16:04:32.547626: fail 16:04:32.847965: success, 实际测试成功次数:11

滑动窗口限流算法的优缺点

优点:

简单易懂 精度高(通过调整时间窗口的大小来实现不同的限流效果) 可扩展性强(可以非常容易地与其他限流算法结合使用)

缺点:

突发流量无法处理(无法应对短时间内的大量请求,但是一旦到达限流后,请求都会直接暴力被拒绝。酱紫我们会损失一部分请求,这其实对于产品来说,并不太友好),需要合理调整时间窗口大小。

存在的问题

那么滑动窗口限流法是完美的吗?细心观察我们应该能马上发现问题,如下图:设置1s内只能250请求。分割5个子窗口。

0ms-1000ms、200ms-1200ms的请求在我们设置的阈值内,但是100ms-1100ms的请求一共是350,远超过了我们所设置的阈值。

滑动时间窗口限流法其实就是计数器算法的一个变种,依然存在临界值的问题。并且流量的过渡是否平滑依赖于我们设置的窗口格数,格数越多,统计越精确。

格子的数量影响着滑动窗口算法的精度,依然有时间片的概念,无法根本解决临界点问题。

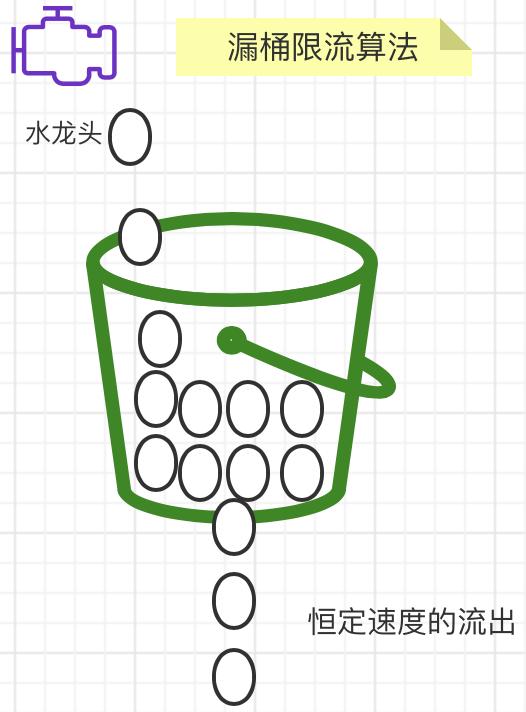

4.3:漏桶限流算法

1,什么是漏桶限流算法?

漏桶(Leaky Bucket)算法是水先进入到漏桶里,漏桶再以一定的速率出水,当流入水的数量大于流出水时,多余的水直接溢出。把水换成请求来看,漏桶相当于服务器队列,但请求量大于限流阈值时,多出来的请求就会被拒绝服务。漏桶算法使用队列实现,可以以固定的速率控制流量的访问速度,可以做到流量的平整化处理。

桶就相当于一个队列,请求先放到桶里,等待执行。桶满了则拒绝

2,实现原理:

-

将每个请求放入固定大小的队列进行中

-

队列以固定速率向外流出请求,如果队列为空则停止流出。

-

如队列满了则多余的请求会被直接拒绝

主要的作用:

【1】 控制数据注入网络的速度。 【2】 平滑网络上的突发流量。

漏桶限流算法的核心就是:不管上面的水流速度有多块,漏桶水滴的流出速度始终保持不变。消息中间件就采用的漏桶限流的思想。如图所示:

3,代码实现:

public class LeakyBucketRateLimiter {

private RedissonClient redissonClient = RedissonConfig.getInstance();

private static final String KEY_PREFIX = "LeakyBucket:";

/**

* 桶的大小

*/

private Long bucketSize;

/**

* 漏水速率,单位:个/秒

*/

private Long leakRate;

//控制流速

public LeakyBucketRateLimiter(Long bucketSize, Long leakRate) {

this.bucketSize = bucketSize;

this.leakRate = leakRate;

//这里启动一个定时任务,每s执行一次

ScheduledExecutorService executorService = Executors.newScheduledThreadPool(1);

executorService.scheduleAtFixedRate(this::leakWater, 0, 1, TimeUnit.SECONDS);

}

/**

* 漏水

*/

public void leakWater() {

RSet<String> pathSet = redissonClient.getSet(KEY_PREFIX + ":pathSet");

//遍历所有path,删除旧请求

for(String path : pathSet){

RScoredSortedSet<Long> bucket = redissonClient.getScoredSortedSet(KEY_PREFIX + path);

// 获取当前时间

long now = System.currentTimeMillis();

// 删除旧的请求

bucket.removeRangeByScore(0, true,now - 1000 * leakRate,true);

}

}

public boolean triggerLimit(String path) {

//加锁,防止并发初始化问题

RLock rLock = redissonClient.getLock(KEY_PREFIX + "LOCK:" + path);

try {

rLock.lock(100,TimeUnit.MILLISECONDS);

String redisKey = KEY_PREFIX + path;

RScoredSortedSet<Long> bucket = redissonClient.getScoredSortedSet(redisKey);

//这里用一个set,来存储所有path

RSet<String> pathSet = redissonClient.getSet(KEY_PREFIX + ":pathSet");

pathSet.add(path);

// 获取当前时间

long now = System.currentTimeMillis();

// 检查桶是否已满

if (bucket.size() < bucketSize) {

// 桶未满,添加一个元素到桶中

bucket.add(now, now);

return false;

}

// 桶已满,触发限流

System.out.println("[triggerLimit] path:"+path+" bucket size:"+bucket.size());

return true;

} finally {

rLock.unlock();

}

}

}

在代码实现里,我们用了 RSet 来存储 path,这样一来,一个定时任务,就可以搞定所有 path 对应的桶的出水,而不用每个桶都创建一个一个定时任务。

这里我直接用 ScheduledExecutorService 启动了一个定时任务,1s跑一次,当然集群环境下,每台机器都跑一个定时任务,对性能是极大的浪费,而且不好管理,我们可以用分布式定时任务,比如 xxl-job 去执行 leakWater。

测试:

public class LeakyBucketRateLimiterTest {

public static void main(String[] args) throws InterruptedException {

ThreadPoolExecutor threadPoolExecutor = new ThreadPoolExecutor(30, 50, 10, TimeUnit.SECONDS, new LinkedBlockingDeque<>(10));

LeakyBucketRateLimiter leakyBucketRateLimiter = new LeakyBucketRateLimiter(10L, 1L);

for (int i = 0; i < 8; i++) {

CountDownLatch countDownLatch = new CountDownLatch(20);

for (int j = 0; j < 20; j++) {

threadPoolExecutor.execute(() -> {

boolean isLimit = leakyBucketRateLimiter.triggerLimit("/test");

System.out.println(isLimit);

countDownLatch.countDown();

});

}

countDownLatch.await();

//休眠10s

TimeUnit.SECONDS.sleep(10L);

}

}

}

优点:

漏桶算法能够有效防止网络拥塞,实现也比较简单。是能够以固定的速率去控制流量,稳定性比较好。

缺点:

因为漏桶的出水速率是固定的,假如突然来了大量的请求,那么只能丢弃超量的请求,即使下游能处理更大的流量,没法充分利用系统资源。

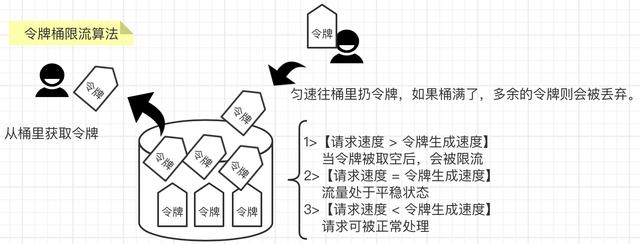

4.4:令牌桶限流算法

1,什么是令牌桶限流算法?

令牌桶算法是基于漏桶之上的一种改进版本,在令牌桶中,令牌代表当前系统允许的请求上限,令牌会匀速被放入桶中。当桶满了之后,新的令牌就会被丢弃

常用的 Google 的 Java 开发工具包 Guava 中的限流工具类 RateLimiter 和 Redisson 的限流 就是令牌桶的一个实现。令牌桶的实现思路类似于生产者和消费之间的关系。系统服务作为生产者,按照指定频率向桶(容器)中添加令牌,如 QPS 为 2,每 500ms 向桶中添加一个令牌,如果桶中令牌数量达到阈值,则不再添加。当然还有阿里开源的 Sentinel 就是不错的工具,Sentinel 以流量为切入点,从流量控制、熔断降级、系统负载保护等多个维度保护服务的稳定性。

请求执行作为消费者,每个请求都需要去桶中拿取一个令牌,取到令牌则继续执行;如果桶中无令牌可取,就触发拒绝策略,可以是超时等待,也可以是直接拒绝本次请求,由此达到限流目的。

2,实现原理:

-

令牌以固定速率生成并放入到令牌桶中;

-

如果令牌桶满了则多余的令牌会直接丢弃,当请求到达时,会尝试从令牌桶中取令牌,取到了令牌的请求可以执行;

-

如果桶空了,则拒绝该请求

系统会以恒定速度(r tokens/sec)往固定容量的令牌桶中放入令牌。令牌桶有固定的大小,如果令牌桶被填满,则会丢弃令牌。

会存在三种情况:

【请求速度 大于 令牌生成速度】当令牌被取空后,会被限流 【请求速度 等于 令牌生成速度】流量处于平稳状态 【请求速度 小于 令牌生成速度】请求可被正常处理,桶满则丢弃令牌

如图所示:

3,代码实现

首先是要发放令牌,要固定速率,那我们又得开个线程,定时往桶里投令牌,然后 Redission 提供了令牌桶算法的实现。

RateLimiter 限流体验:

public class TokenBucketRateLimiter {

public static final String KEY = "TokenBucketRateLimiter:";

/**

* 阈值

*/

private Long limit;

/**

* 添加令牌的速率,单位:个/秒

*/

private Long tokenRate;

public TokenBucketRateLimiter(Long limit, Long tokenRate) {

this.limit = limit;

this.tokenRate = tokenRate;

}

/**

* 限流算法

*/

public boolean triggerLimit(String path){

RedissonClient redissonClient = RedissonConfig.getInstance();

RRateLimiter rateLimiter = redissonClient.getRateLimiter(KEY + path);

// 初始化,设置速率模式,速率,间隔,间隔单位

rateLimiter.trySetRate(RateType.OVERALL, limit, tokenRate, RateIntervalUnit.SECONDS);

// 获取令牌

return rateLimiter.tryAcquire();

}

}

测试:

public class TokenBucketRateLimiterTest {

public static void main(String[] args) throws InterruptedException {

ThreadPoolExecutor threadPoolExecutor = new ThreadPoolExecutor(30, 50, 10, TimeUnit.SECONDS, new LinkedBlockingDeque<>(10));

TokenBucketRateLimiter tokenBucketRateLimiter = new TokenBucketRateLimiter(10L, 1L);

for (int i = 0; i < 8; i++) {

CountDownLatch countDownLatch = new CountDownLatch(20);

for (int j = 0; j < 20; j++) {

threadPoolExecutor.execute(() -> {

boolean isLimit = tokenBucketRateLimiter.triggerLimit("/test");

System.out.println(isLimit);

countDownLatch.countDown();

});

}

countDownLatch.await();

//休眠10s

TimeUnit.SECONDS.sleep(10L);

}

}

}

代码中限制 QPS 为 2,也就是每隔 500ms 生成一个令牌,但是程序每隔 250ms 获取一次令牌,所以两次获取中只有一次会成功。

17:19:06.797557:true 17:19:07.061419:false 17:19:07.316283:true 17:19:07.566746:false 17:19:07.817035:true 17:19:08.072483:false 17:19:08.326347:true 17:19:08.577661:false 17:19:08.830252:true 17:19:09.085327:false

思考

虽然演示了 Google Guava 工具包中的 RateLimiter 的实现,但是我们需要思考一个问题,就是令牌的添加方式,如果按照指定间隔添加令牌,那么需要开一个线程去定时添加,如果有很多个接口很多个 RateLimiter 实例,线程数会随之增加,这显然不是一个好的办法。显然 Google 也考虑到了这个问题,在 RateLimiter 中,是在每次令牌获取时才进行计算令牌是否足够的。它通过存储的下一个令牌生成的时间,和当前获取令牌的时间差,再结合阈值,去计算令牌是否足够,同时再记录下一个令牌的生成时间以便下一次调用。

下面是 Guava 中 RateLimiter 类的子类 SmoothRateLimiter 的 resync() 方法的代码分析,可以看到其中的令牌计算逻辑。

void resync(long nowMicros) { // 当前微秒时间

// 当前时间是否大于下一个令牌生成时间

if (nowMicros > this.nextFreeTicketMicros) {

// 可生成的令牌数 newPermits = (当前时间 - 下一个令牌生成时间)/ 令牌生成时间间隔。

// 如果 QPS 为2,这里的 coolDownIntervalMicros 就是 500000.0 微秒(500ms)

double newPermits = (double)(nowMicros - this.nextFreeTicketMicros) / this.coolDownIntervalMicros();

// 更新令牌库存 storedPermits。

this.storedPermits = Math.min(this.maxPermits, this.storedPermits + newPermits);

// 更新下一个令牌生成时间 nextFreeTicketMicros

this.nextFreeTicketMicros = nowMicros;

}

}

优点:

令牌桶算法是对漏斗算法的一种改进,除了能够起到限流的作用外,还允许一定程度的流量突发。

与漏桶算法相比,有可能导致短时间内的请求数上升(因为拿到令牌后,就可以访问接口,存在一瞬间将所有令牌拿走的情况),但不会有计数算法那样高的峰值(因为令牌数量是匀速增加的)。所以在应对突发流量的时候令牌桶表现的更佳。

一般自己调用自己的接口,接口会有一定的伸缩性,令牌桶算法,主要用来保护自己的服务器接口。

缺点:

例如令牌桶,假如系统上线时没有预热,那么可能会出现由于此时桶中还没有令牌,而导致请求被误杀的情况;

4.5:Redis 分布式限流

Redis 是一个开源的内存数据库,可以用来作为数据库、缓存、消息中间件等。Redis 是单线程的,又在内存中操作,所以速度极快,得益于 Redis 的各种特性,所以使用 Redis 实现一个限流工具是十分方便的。

下面的演示都基于Spring Boot 项目,并需要以下依赖。

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

代码实现:

public class RedissonConfig {

private static final String REDIS_ADDRESS = "redis://127.0.0.1:6379";

private static volatile RedissonClient redissonClient;

public static RedissonClient getInstance(){

if (redissonClient == null){

synchronized (RedissonConfig.class){

if (redissonClient == null){

Config config = new Config();

config.useSingleServer().setAddress(REDIS_ADDRESS);

redissonClient = Redisson.create(config);

return redissonClient;

}

}

}

return redissonClient;

}

}

实际上redis可以通过三种方式实现限流的目的,分别是

1、计数器算法

计数器算法是Redis实现限流的常见手段,其核心思想为统计单位时间内的请求数量并与阈值进行比较,当达到阈值时就拒绝后续访问,从而起到限制流量的目的。具体实现方法如下:

1.1 使用Redis的原子操作incr操作,实现计数器的自增。

1.2 通过Redis对key设置过期时间,例如设置一分钟后过期。

1.3 当计算器的值超过限制阈值时,拒绝访问,否则可以继续访问并重置计数器值。

需要注意的是,由于计数器算法只记录请求数量,无法区分不同类型的请求,可能会存在被恶意用户绕过的可能性。因此,这种方法适用于单一请求的场景,如接口限流。

/**

* @author: shenz

* @create: 2023-07-26 14:41

**/

@RestController

@RequestMapping("/redisTest")

public class RedisTestController {

@Autowired

private RedisTemplate redisTemplate;

private static DateTimeFormatter formatter = DateTimeFormatter.ofPattern("yyyy-MM-dd hh:mm");

@GetMapping("/Fixed")

public String testFixedWindow() {

String now = formatter.format(LocalDateTime.now());

Long count = redisTemplate.opsForValue().increment(now + ":fixed");

if (count > 5) {

return "不好意思,服务器正忙,请一分钟后再试......";

} else {

return "服务端正在处理";

}

}

}

2、漏桶算法

漏桶算法也是一种流量控制算法,和计数器算法相比,漏桶算法会对请求进行一个统一的速率限制,而非单纯地限制访问量。其主要思想为模拟水桶中的水流量,加入一个固定的速率加入水,如果水桶满了,就拒绝后续的请求,否则按照固定的速率处理请求。具体实现方法如下:

2.1 将漏桶看作一个固定大小的容器,以固定的速率漏出水。

2.2 使用Redis的List数据类型,将每个请求按照时间顺序加入List中,即水流进入水桶的过程。

2.3 使用Redis的过期机制,将List中已经达到一定时间的请求移出,即水从桶中漏出的过程。

2.4 当请求加入List时,判断List的长度是否达到桶的最大限制,如果超过限制,就拒绝请求,否则可以正常处理。

漏桶算法可用于应对各种请求,由于限制速率而非请求数量,不容易被恶意用户绕过,常用于对整个应用的限流控制。

/**

* @author: shenz

* @create: 2023-07-26 14:41

**/

@RestController

@RequestMapping("/redisTest")

public class RedisTestController {

@Autowired

private RedisTemplate redisTemplate;

@GetMapping("/Sliding")

public String testSlidingWindow() {

Long currentTime = System.currentTimeMillis();

System.out.println(currentTime);

if (redisTemplate.hasKey("limit")) {

// intervalTime是限流的时间

Long intervalTime = 60000L;

Integer count = redisTemplate.opsForZSet().rangeByScore("limit", currentTime - intervalTime, currentTime).size();

System.out.println(count);

if (count != null && count > 5) {

return "每分钟最多只能访问5次";

}

}

redisTemplate.opsForZSet().add("limit", UUID.randomUUID().toString(), currentTime);

return "访问成功";

}

}

3、令牌桶算法

令牌桶算法也属于流量控制算法,其主要思想为固定速率向令牌桶中添加令牌,一个请求需要获取令牌才能执行,当令牌桶中没有令牌时,请求将被拒绝。具体实现方法如下:

3.1 使用Redis的List数据类型,将一定数量的令牌添加到List中,表示令牌桶的容量。

3.2 使用Redis过期机制,每当有请求到来时,如果List中还有令牌,则可以正常处理请求,并从List中移除一个令牌,否则拒绝请求。

3.3 当令牌生成速度过快或者请求到来速度过慢时,可能会出现令牌桶溢出的情况。因此,可使用Redis的有序集合数据类型,记录每次执行的时间和执行次数,用于在下一次添加令牌时,调整添加令牌的数量,以适应实际情况。

令牌桶算法不仅能够限制并发数,而且可以控制请求速率,比较适合对底层资源进行保护,比如数据库连接池、磁盘IO等。

代码实现:

/**

* @author: shenz

* @create: 2023-07-26 14:41

**/

@RestController

@RequestMapping("/redisTest")

public class RedisTestController {

@Autowired

private RedisTemplate redisTemplate;

@Autowired

private Redisson redisson;

@GetMapping("/Token")

public String testTokenBucket() {

RRateLimiter rateLimiter = redisson.getRateLimiter("myRateLimiter");

// 最大流速 = 每10秒钟产生1个令牌

rateLimiter.trySetRate(RateType.OVERALL, 1, 10, RateIntervalUnit.SECONDS);

//需要1个令牌

if (rateLimiter.tryAcquire(1)) {

return "令牌桶里面有可使用的令牌";

}

return "不好意思,请过十秒钟再来~~~~~~~";

}

}

总结:

实际上主要分为窗口限流和桶限流两者各有优势。

-

窗口算法实现简单,逻辑清晰,可以很直观的得到当前的 QPS 情况,但是会有时间窗口的临界突变问题,而且不像桶一样有队列可以缓冲。

-

桶算法虽然稍微复杂,不好统计 QPS 情况,但是桶算法也有优势所在。

-

-

漏桶模式消费速率恒定,可以很好的保护自身系统,可以对流量进行整形,但是面对突发流量不能快速响应。

-

令牌桶模式可以面对突发流量,但是启动时会有缓慢加速的过程,不过常见的开源工具中已经对此优化。

-

细节比较:

-

固定窗口:实现简单,适用于流量相对均匀分布,对限流准确度要求不严格的场景。

-

滑动窗口:适用于对准确性和性能有一定的要求场景,可以调整子窗口数量来权衡性能和准确度

-

漏桶:适用于流量绝对平滑的场景

-

令牌桶:适用于流量整体平滑的情况下,同时也可以满足一定的突发流程场景

市面上也有很多好用的开源限流工具:

-

Guava RateLimiter ,基于令牌桶算法限流,当然是单机的;

-

Sentinel ,基于滑动窗口限流,支持单机,也支持集群

-

网关限流,很多网关自带限流方法,比如Spring Cloud Gateway、Nginx

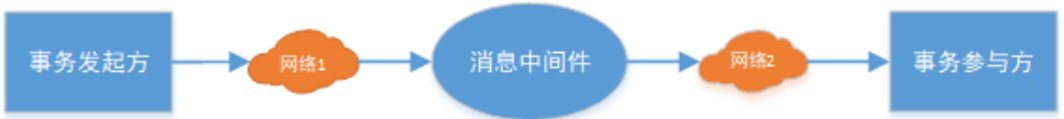

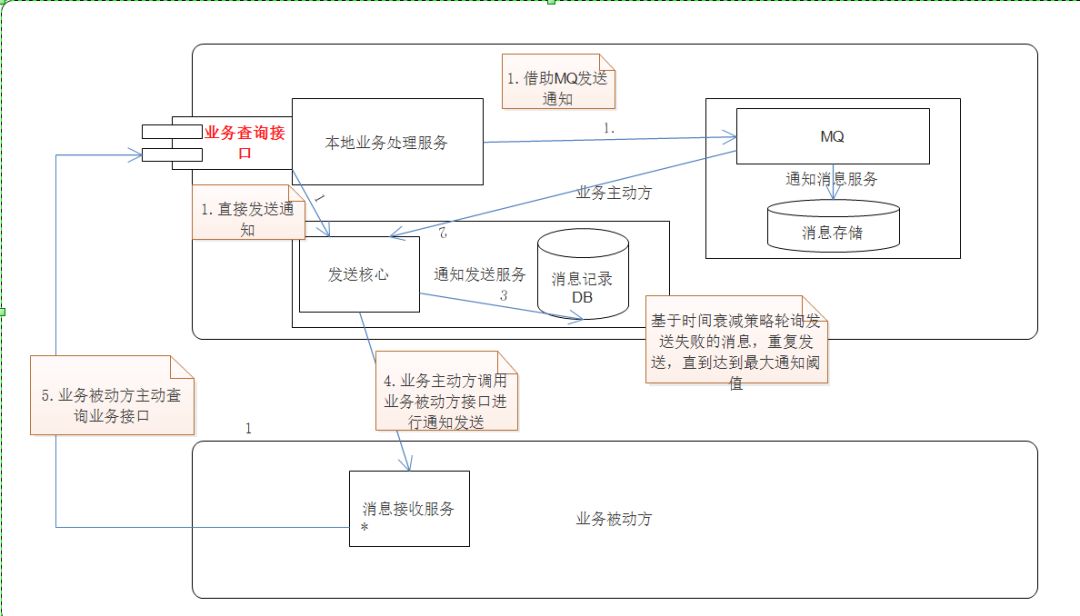

可靠消息最终一致性、最大努力通知

可靠消息最终一致性方案是指当事务发起方执行完成本地事务后发出一条消息到消息中间件,事务参与方(消息消费者)一定能够接收到消息并处理事务成功。

此方案强调的是只要消息发给事务参与方,则最终事务一定要达到一致。此方案用到MQ来确保最终一致性。

可靠消息最终一致性:基于本地消息表

本地消息表,作为可靠消息最终一致性的一种典型实现方案。最初由eBay提出,其亦是对BASE理论的体现、实践。其基本原理、思路很简单。这里以订单服务、库存服务为例展开说明。当客户下单后,需要先通过订单服务在订单表中插入一条订单记录,再通过库存服务实现对库存表中库存记录的扣减。但这里即会存在一个问题,由于订单表、库存表分别位于订单服务、库存服务的数据库。传统的本地事务显然无法解决这种跨服务、跨数据库的场景。而基于本地消息表的分布式事务方案则可以在对业务改动尽可能小的前提下保障数据的最终一致性

具体地,在事务发起方即这里订单服务的数据库中再增加一张本地消息表。向订单表中插入订单记录的同时,在本地消息表中也插入一条表示订单创建成功的记录。

由于此时订单表、本地消息表位于同一数据库当中,可以直接通过一个本地事务来保证对这两张表操作的原子性

与此同时,在订单服务中添加一个定时任务,不停轮询、处理本地消息表。具体地,将消息表中未被成功处理的记录通过MQ投递至库存服务。而库存服务在从MQ中接收到订单创建成功的消息后,对库存表进行库存扣减操作。在库存服务完成扣减后,通过某种方式告诉订单服务该条消息已经被成功消费、处理。这样订单服务即可将本地消息表中相关记录标记为成功处理的状态,以避免定时任务重复投递。这里库存服务确认消息消费成功的实现方式,可以直接通过MQ的Ack消息确认机制实现,也可以让库存服务再向订单服务发送一个处理完毕的消息来完成。

整个方案的示意图如下所示

可以看到,基于本地消息表的可靠消息最终一致性方案非常简单。

但在具体业务实践过程还是有一些需要注意的地方:

-

库存服务的库存扣减需要保证幂等性,一方面由于MQ存在自动重试机制,另一方面,当订单服务未收到库存服务对本次消息的消费确认时,则可能会导致定时任务下一次继续投递该消息至库存服务

-

根据实际业务需要,本地消息表中记录还应该设置一个合理的最大处理等待时间,以及时发现长时间无法得到有效处理的本地消息记录

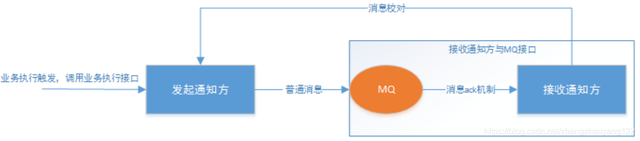

可靠消息最终一致性:基于RocketMQ的事务消息

通过基于本地消息表的可靠消息最终一致性方案可以看出,其本质上是通过引入本地消息表来保证本地事务与发送消息的原子性。

那如果说MQ本身能够直接保证消息发送与本地事务的原子性岂不是更方便了,为此在RocketMQ中提供了所谓的事务消息。这里我们来介绍下其基本机制,流程图如下所示

事务发起方首先会将事务消息发送到RocketMQ当中,但此时该条消息并不会对消费者可见,即所谓的半消息。

当RocketMQ确定消息已经发送成功后,事务发起方即会开始执行本地事务。

同时根据本地事务的执行结果,告知给RocketMQ相应的状态信息——commit、rollback。

具体地,当RocketMQ得到commit状态,则会将之前的事务消息转为对消费者可见、并开始投递;

当RocketMQ得到rollback状态,则会相应的删除之前的事务消息,保证了本地事务回滚的同时消息也不会投递到消费者侧,保障了二者的原子性。进一步地,如果RocketMQ未收到本地事务的执行状态时,则会通过事务回查机制定时检查本地事务的状态

案例搭建

这里利用Docker Compose搭建RocketMQ环境

# Compose 版本

version: '3.8'

# 定义Docker服务

services:

# Rocket MQ Name Server

RocketMQ-NameServer:

image: foxiswho/rocketmq:4.8.0

container_name: RocketMQ-NameServer

ports:

- "9876:9876"

command: sh mqnamesrv

networks:

rocket_mq_net:

ipv4_address: 130.130.131.10

# Rocket MQ Broker

RocketMQ-Broker:

image: foxiswho/rocketmq:4.8.0

container_name: RocketMQ-Broker

ports:

- "10909:10909"

- "10911:10911"

- "10912:10912"

environment:

NAMESRV_ADDR: "130.130.131.10:9876"

command: sh mqbroker -c /home/rocketmq/rocketmq-4.8.0/conf/broker.conf

depends_on:

- RocketMQ-NameServer

networks:

rocket_mq_net:

ipv4_address: 130.130.131.11

# Rocket MQ Console

RocketMQ-Console:

image: styletang/rocketmq-console-ng:1.0.0

container_name: RocketMQ-Console

ports:

- 8080:8080

environment:

JAVA_OPTS: "-Drocketmq.namesrv.addr=130.130.131.10:9876 -Dcom.rocketmq.sendMessageWithVIPChannel=false"

depends_on:

- RocketMQ-NameServer

networks:

rocket_mq_net:

ipv4_address: 130.130.131.12

# 定义网络

networks:

rocket_mq_net:

ipam:

config:

- subnet: 130.130.131.0/24

然后进入RocketMQ Broker容器,将配置文件broker.conf中的brokerIP1设置为宿主机IP,如下所示

订单服务

这里通过SpringBoot搭建一个事务的发起方——即订单服务。首先在POM中引入RocketMQ相关依赖

<dependencyManagement>

<dependencies>

<!--Spring Boot-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-dependencies</artifactId>

<version>2.3.2.RELEASE</version>

<type>pom</type>

<scope>import</scope>

</dependency>

</dependencies>

</dependencyManagement>

<dependencies>

<!-- Rocket MQ -->

<dependency>

<groupId>org.apache.rocketmq</groupId>

<artifactId>rocketmq-spring-boot-starter</artifactId>

<version>2.2.0</version>

</dependency>

</dependencies>

同时在application.yml中添加关于RocketMQ相关的配置,这里为避免由于消息发送超时而导致失败,调大了关于生产者发送超时时间的配置

rocketmq:

name-server: 127.0.0.1:9876

producer:

# 默认生产者组名

group: order-service

# 生产者发送超时时间, Unit: ms

send-message-timeout: 600000

需要注意的是,从RocketMQ-Spring 2.1.0版本之后,注解@RocketMQTransactionListener不能设置txProducerGroup、ak、sk,这些值均与对应的RocketMQTemplate保持一致。换言之,由于不同事务流程的事务消息需要使用不同的生产者组来发送,故为了设置生产者组名。需要通过@ExtRocketMQTemplateConfiguration注解来定义非标的RocketMQTemplate。定义非标的RocketMQTemplate时可自定义相关属性,如果不定义,它们取全局的配置属性值或默认值。由于该注解已继承自@Component注解,故无需开发者重复添加即可完成相应的实例化。这里我们自定义该非标实例的生产者组名

/**

* 自定义非标的RocketMQTemplate, Bean名与所定义的类名相同(但首字母小写)

*/

@ExtRocketMQTemplateConfiguration(group="tx-order-create")

public class ExtRocketMQTemplate1 extends RocketMQTemplate {

}

下面既是创建订单过程中本地事务的方法。对于RocketMQ回查本地事务执行结果时,则有两种思路,要么判断订单表中是否存在相关订单记录;要么单独增加一张事务日志表,每笔订单创建完成后向事务日志表插入相应事务ID的记录,这样回查时只需在事务日志表中判定是否存在相应事务ID的记录即可。而订单表、事务日志表由于在同一数据库下,可以直接利用本地事务保证原子性。这里我们采用后者的思路,即创建订单时,不仅在订单表插入订单记录,也在事务日志表中插入一条相应的记录。实现如下所示

@Service

@Slf4j

public class OrderService {

@Autowired

private TransactionLogMapper transactionLogMapper;

@Autowired

private OrderMapper orderMapper;

/**

* 创建订单

* @param order 订单记录

* @param txid 事务ID

*/

@Transactional

public void createOrder(Order order, String txid) {

// 创建订单

int result = orderMapper.insert(order);

// 插入失败

if( result!=1 ) {

new RuntimeException("create order fail");

}

// 写入事务日志

transactionLogMapper.insert( new TransactionLog(txid) );

}

}

...

/**

* 订单记录

*/

@Data

@Builder

@AllArgsConstructor

@NoArgsConstructor

@TableName("t_order")

public class Order {

@TableId(type = IdType.AUTO)

private Integer id;

/**

* 订单编号

*/

private String orderNum;

/**

* 商品名称

*/

private String name;

/**

* 商品数

*/

private Integer count;

}

...

/**

* 事务日志

*/

@Data

@Builder

@AllArgsConstructor

@NoArgsConstructor

@TableName("t_transaction_log")

public class TransactionLog {

@TableId(type = IdType.AUTO)

private int id;

/**

* 事务ID

*/

private String txid;

public TransactionLog(String txid) {

this.txid = txid;

}

}

然后定义事务消息的发送者OrderProducerService,通过刚刚定义的非标rocketMQTemplate发送事务消息到RocketMQ。

与此同时,还需要通过实现RocketMQLocalTransactionListener接口的executeLocalTransaction、checkLocalTransaction方法以用于调用业务Service执行本地事务、回查本地事务执行结果。特别地,在RocketMQLocalTransactionListener实现类上需要添加@RocketMQTransactionListener注解,并通过rocketMQTemplateBeanName属性指定相应的rocketMQTemplate实例名

@Service

@Slf4j

public class OrderProducerService {

/*

* 按名注入, 使用非标的rocketMQTemplate

*/

@Qualifier("extRocketMQTemplate1")

@Autowired

private RocketMQTemplate extRocketMQTemplate;

/**

* 发送事务消息

* @param order

* @param txid

*/

public void sendTransactionMsg(Order order, String txid) {

Message<Order> message = MessageBuilder

.withPayload( order )

.setHeader("txid", txid)

.build();

String topic = "order_create";

TransactionSendResult sendResult = extRocketMQTemplate.sendMessageInTransaction(topic, message, null);

LocalTransactionState localTransactionState = sendResult.getLocalTransactionState();

log.info("sendResult: {}", JSON.toJSON(sendResult));

}

@RocketMQTransactionListener(rocketMQTemplateBeanName="extRocketMQTemplate1")

public static class OrderTransactionListenerImpl implements RocketMQLocalTransactionListener {

@Autowired

private OrderService orderService;

@Autowired

private TransactionLogMapper transactionLogMapper;

/**

* 执行本地事务

* @param msg

* @param arg

* @return

*/

@Override

public RocketMQLocalTransactionState executeLocalTransaction(Message msg, Object arg) {

RocketMQLocalTransactionState state = RocketMQLocalTransactionState.COMMIT;

try {

String payload = new String((byte[]) msg.getPayload());

Order order = JSON.parseObject(payload, Order.class);

String txid = (String) msg.getHeaders().get("txid");

// 通过业务Service执行本地事务

orderService.createOrder(order, txid);

} catch (Exception e) {

// 本地事务执行失败, 故向RocketMQ返回 rollback 状态

log.info("Happen Exception: {}", e.getMessage());

state = RocketMQLocalTransactionState.ROLLBACK;

}

return state;

}

/**

* 回查本地事务的结果

* @param msg

* @return

*/

@Override

public RocketMQLocalTransactionState checkLocalTransaction(Message msg) {

// 获取事务ID

String txid = (String) msg.getHeaders().get("txid");

List<TransactionLog> transactionLogList = transactionLogMapper.selectList(

new QueryWrapper<TransactionLog>().eq("txid", txid)

);

// 事务日志表中无该事务ID的记录

if( CollectionUtils.isEmpty(transactionLogList) ) {

return RocketMQLocalTransactionState.ROLLBACK;