文章目录

- 解决问题

- 算法

- 人体解析

- AIParsing

- FPN

- 检测头

- 边缘引导解析头

- 实验

- 结论

论文: 《AIParsing: Anchor-Free Instance-Level Human Parsing》

github: https://github.com/31sy/AIParsing

解决问题

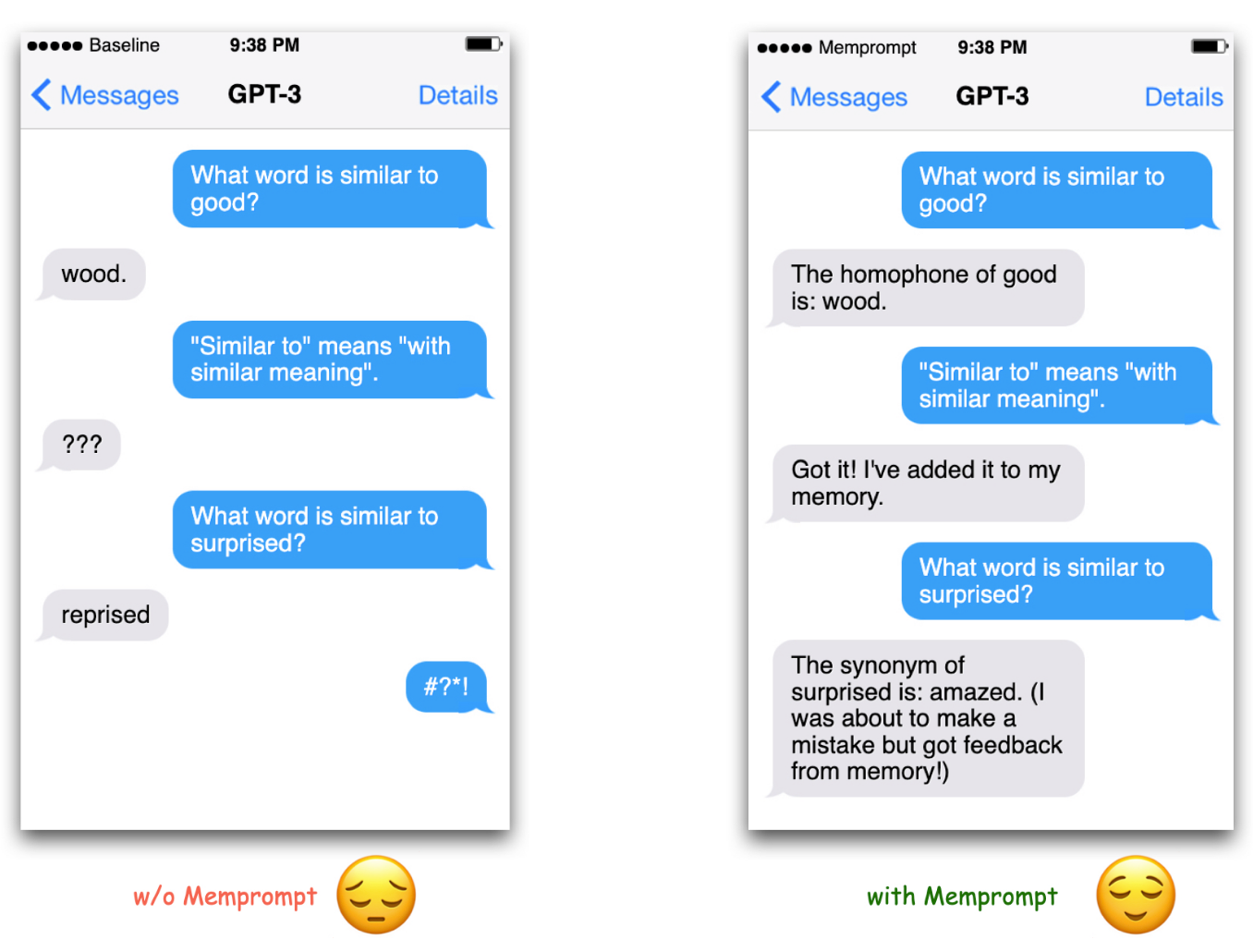

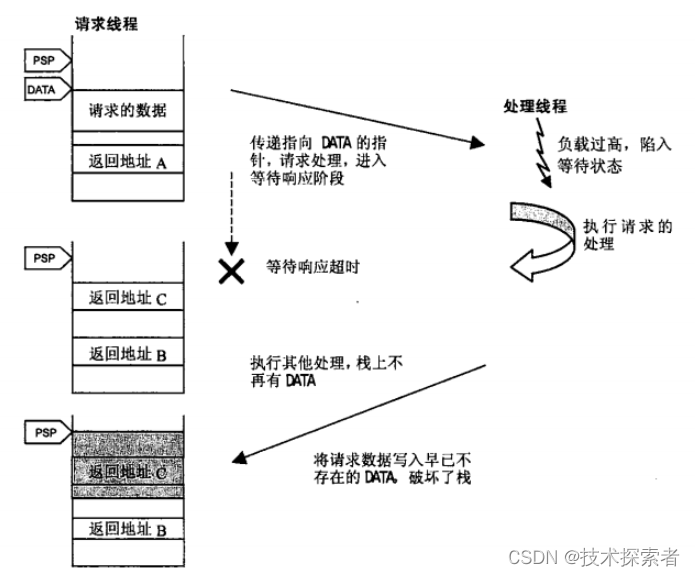

目前SOTA实例级人体解析模型使用二阶段基于anchor的检测器,需要设计anchor box,同时缺少像素级分析;为解决这两个问题,作者设计AIParsing包括两部分:anchor-free检测头、边缘引导解析头。

解决问题:

1、基于anchor的检测器对于超参比较敏感;

2、当前全卷积网络不足以预测精细化分割;

算法

人体解析

实例级人体解析可以分为三类:

1、bottom-up

首先预测全部人体解析结果,将解析结果关联不同人体;

2、two-stage top-down

首先检测人体框,依据人体框进行人体解析;需要两个模型;

3、one-stage top-down

与two stage区别在于是否使用end-to-end 方式,过程同样为先检测人体框、后进行人体解析,但仅使用一个模型;

AIParsing

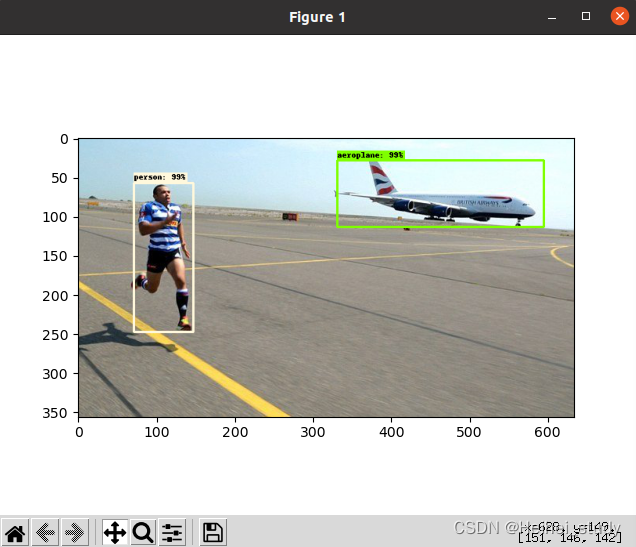

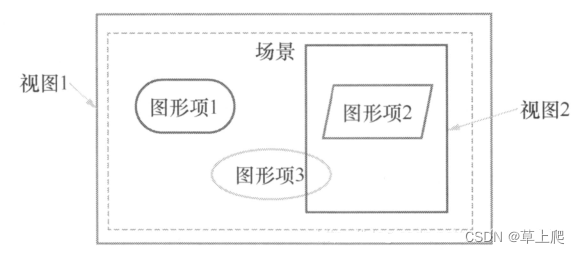

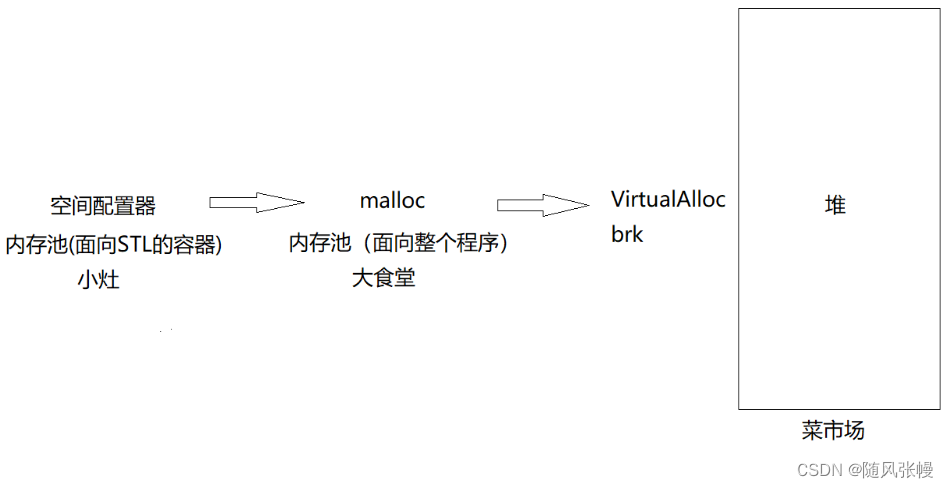

AIParsing如图3,包括三部分:FPN、实例人体检测头、边缘引导人体实例解析头

FPN

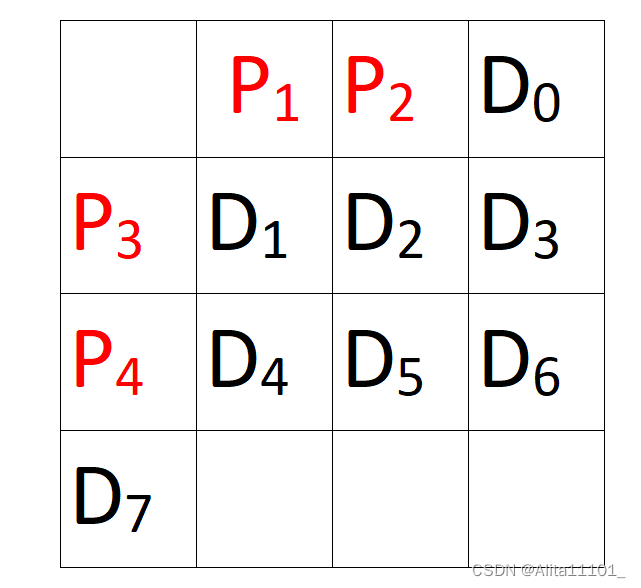

与原始FPN相比,增加P7层,去掉P2层,可用于处理大目标,作者统计CIHP、MHP2.0数据集发现74%、86%目标尺寸大于该图片尺寸10%;

检测头

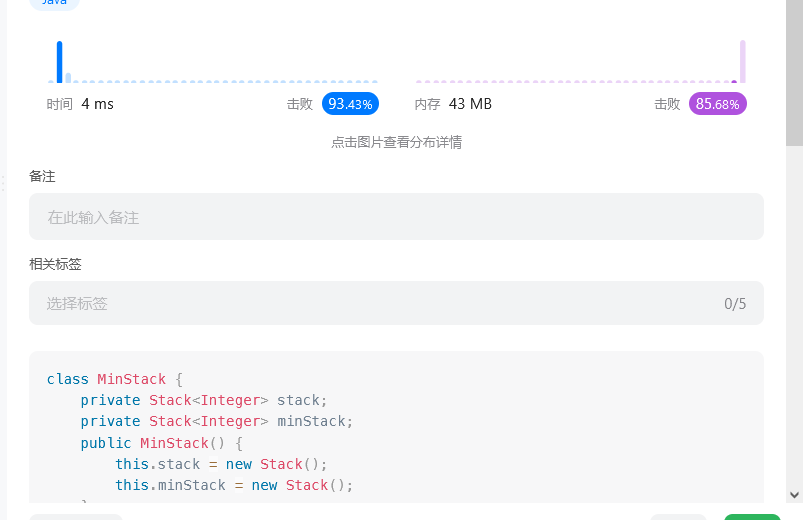

为减少anchor设计超参,作者使用anchor free检测器 FCOS

边缘引导解析头

损失函数包括检测头损失,预测头损失,精细化头损失

检测头损失如式2所示,

图3中人体部件上下文编码提供丰富上下文信息,有利于区分人体部件;

预测头包括预测部件分割及部件边缘轮廓;如式3、4

精细化头包括两部分:rescoring子网络估计mIoU得分,如图3;预测分割结果与gt计算mIoU损失;如式5

实验

SOTA实验

CIHP数据集实验结果如表1所示,

MHP v2.0数据集实验结果如表2所示,

VIP数据集实验结果如表3所示,

二阶段CIHP在mIoU上达到SOTA,但在AP性能表现不佳,CIHP对实例难区分,可能由于二阶段未利用检测器信息;

消融实验结果如表6所示

推理耗时情况如表9,其中AIParsing-light表示backbone及head卷积层channel减半;

失败案例如图7,一些高度重叠人体、距离近的人体以及与背景接近的人体实例区域;

结论

本文提出的AIParsing,融合anchor-free检测头以及边缘引导解析头,在实例级评估指标下达到SOTA性能;