Leetcode—2769. 找出最大的可达成数字【简单】

news2026/2/15 2:34:53

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/1691556.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!相关文章

深入理解python列表遍历:两种方法详解与实例

新书上架~👇全国包邮奥~ python实用小工具开发教程http://pythontoolsteach.com/3 欢迎关注我👆,收藏下次不迷路┗|`O′|┛ 嗷~~ 目录

一、引言

二、使用索引遍历列表

三、直接使用元素遍历列表

四、总结 一、引言 在编程过程…

【设计模式】JAVA Design Patterns——Callback(回调模式)

🔍目的 回调是一部分被当为参数来传递给其他代码的可执行代码,接收方的代码可以在一些方便的时候来调用它。 🔍解释 真实世界例子 我们需要被通知当执行的任务结束时。我们为调用者传递一个回调方法然后等它调用通知我们。 通俗描述 回调是一…

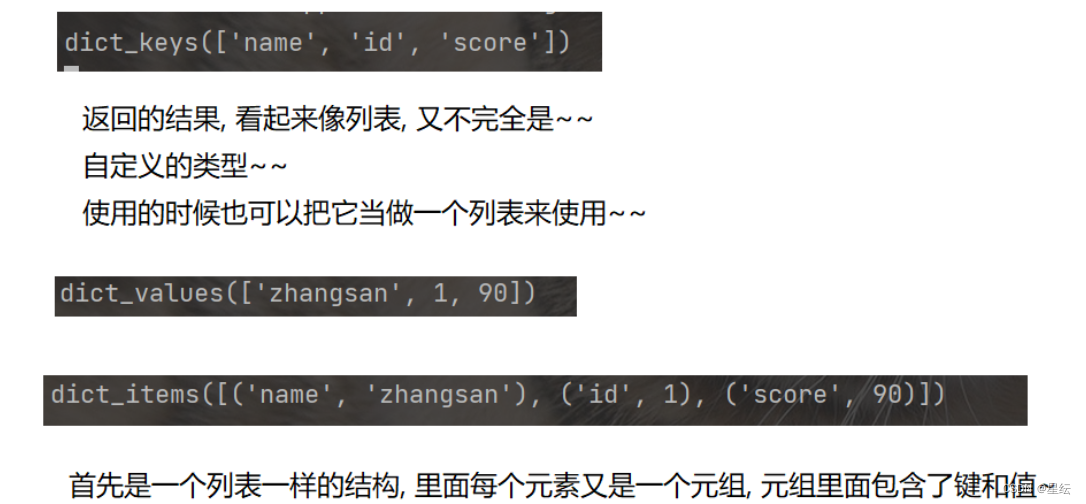

人生苦短,我学python之数据类型(上)

个人主页:星纭-CSDN博客

系列文章专栏:Python

踏上取经路,比抵达灵山更重要!一起努力一起进步!

目录

一.元组 (tuple)

二.集合(set) 三.字典(dict) 一.元组 &#…

科技前沿:IDEA插件Translation v3.6 带来革命性更新,翻译和发音更智能!

博主猫头虎的技术世界 🌟 欢迎来到猫头虎的博客 — 探索技术的无限可能! 专栏链接: 🔗 精选专栏: 《面试题大全》 — 面试准备的宝典!《IDEA开发秘籍》 — 提升你的IDEA技能!《100天精通鸿蒙》 …

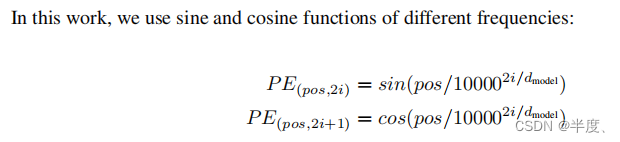

【论文速读】Transformer:Attention Is All You Need

Transformer:Attention Is All You Need 摘要模型架构注意力模型Scaled Dot-ProductMulti-Head Attention Position-wise Feed-Forward NetworksEmbeddings and SoftmaxPositional Encoding 摘要

我们提出了一种新的简单的网络架构,Transformer…

OSPF多区域组网实验(思科)

华为设备参考:OSPF多区域组网实验(华为)

技术简介

OSPF多区域功能通过划分网络为多个逻辑区域来提高网络的可扩展性和管理性能。每个区域内部运行独立的SPF计算,而区域之间通过区域边界路由器进行路由信息交换。这种划分策略适用…

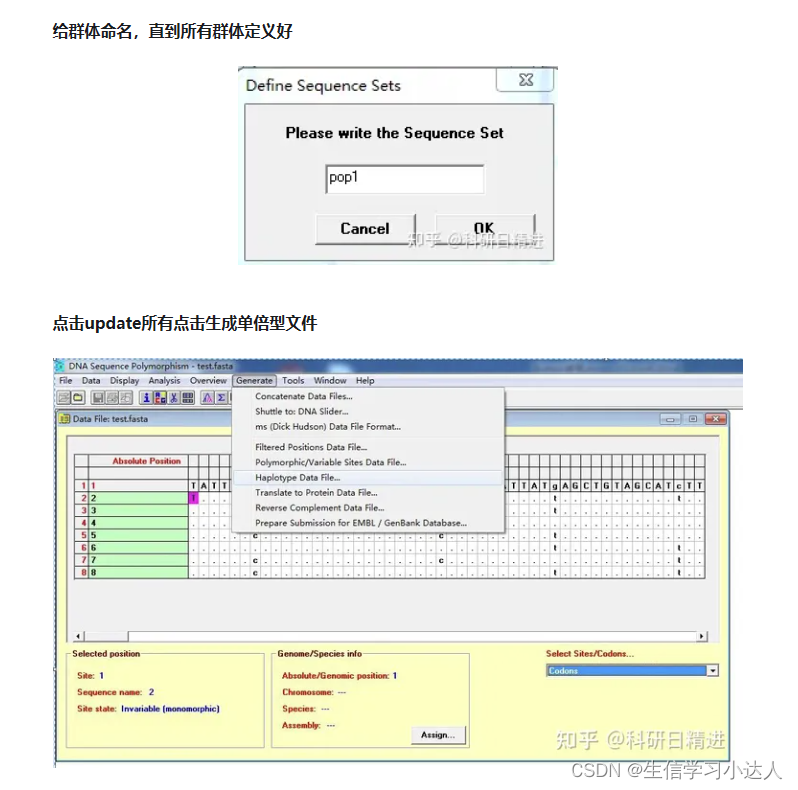

如何构建基因单倍型网络

一. 单倍型网络

单倍型网络图通常是指在遗传学和进化生物学中使用的一种图形表示法,用于描述不同个体或群体之间的遗传关系。这种图形通常用于研究基因或DNA序列在不同个体之间的变化和传递。在单倍型网络图中,节点表示不同的单倍型,而边表示…

自己搭建ntp服务器

1、背景

终端在使用过程中,发现联网后进行NTP(network time protocol,网络时间协议)校时过程中,经常出现校时失败的问题,特别是本地环境,因此需要在自己这边搭建测试环境。 2、搭建步骤

2.1 安葬服务器 sudo apt-get…

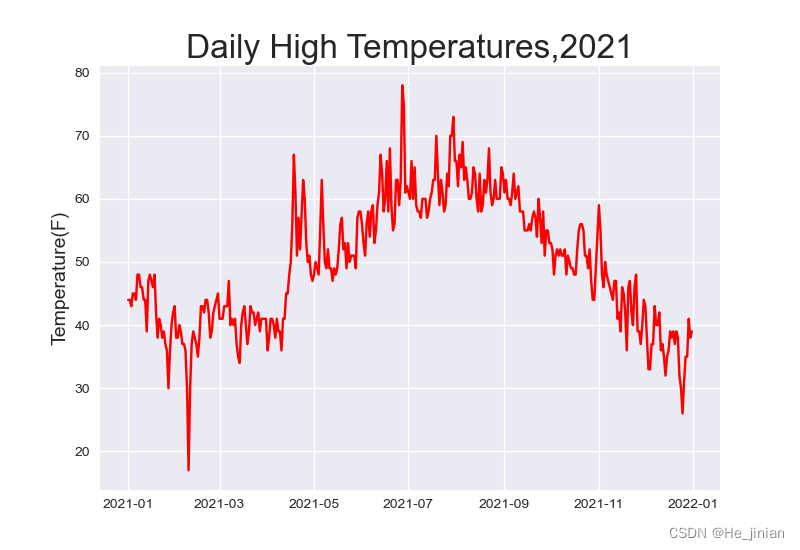

Python项目:数据可视化_下载数据【笔记】

源自《Python编程:从入门到实践》

作者: Eric Matthes 02 下载数据

2.1 sitka_weather_07-2021_simple.csv

from pathlib import Path

import matplotlib.pyplot as plt

import csv

from datetime import datetimepath Path(D:\CH16\sitka_weather_0…

今日早报 每日精选15条新闻简报 每天一分钟 知晓天下事 5月25日,星期六

每天一分钟,知晓天下事! 2024年5月25日 星期六 农历四月十八

1、 气象台:未来三天,北方雷雨侵扰,南方暴雨大暴雨将成片出现,今年首个台风生成在即。 2、 人社部:拟增加网络主播等19个新职业&am…

“高考钉子户”唐尚珺决定再战2024年高考

“高考钉子户”唐尚珺决定在2024年再次参加高考,这个选择确实很特别也很有趣。十几年连续参加高考,他已经积累了大量的备考经验和应试技巧。这样的经验对于高考辅导机构来说无疑是非常宝贵的资源,他如果选择去辅导机构当老师,应该…

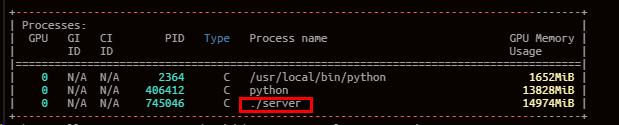

使用llama.cpp实现LLM大模型的格式转换、量化、推理、部署

使用llama.cpp实现LLM大模型的量化、推理、部署 大模型的格式转换、量化、推理、部署概述克隆和编译环境准备模型格式转换GGUF格式bin格式 模型量化模型加载与推理模型API服务模型API服务(第三方)GPU推理 大模型的格式转换、量化、推理、部署

概述 llama.cpp的主要目标是能够在…

微信小程序反编译/解包

微信小程序反编译/解包

环境与工具

操作系统:Windows 11 23H2

微信版本:3.9.10.19 Q:如何找到小程序文件位置? A:在微信的设置找到文件路径,小程序文件位于 \WeChat Files\Applet\。

Q:小程…

centos下yum -y install npm报没有可用软件包 npm

yum -y install npm安装报错 失败原因是因为缺少epel(epel是社区打造的免费开源发行软件包版本库,系统包含大概1万多个软件包),需要先安装epel-release 解决方法:

1、先安装epel-release

yum -y install epel-releas…

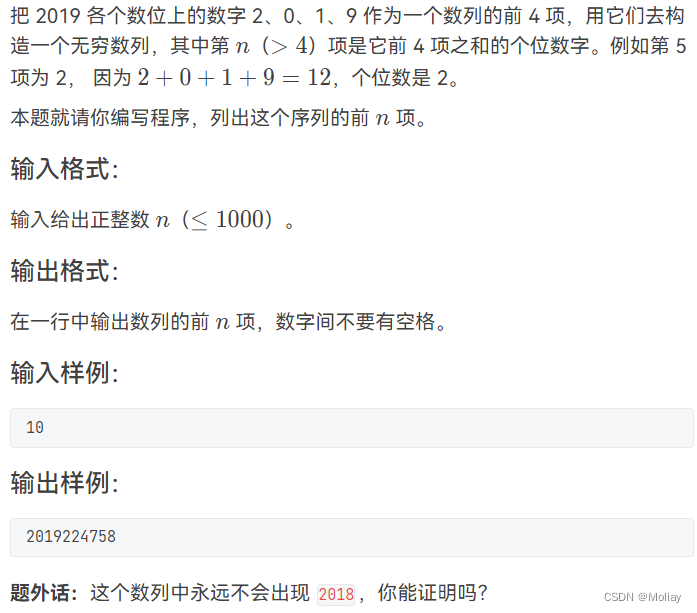

1106 2019数列

solution

维护长度为4的数组,对于第四位之后的数字,为所维护数组的所有元素之和 的个位数

#include<iostream>

using namespace std;

int main(){int n, a[4] {2, 0, 1, 9}, cnt 0, d;scanf("%d", &n);for(int i 0; i < n; …

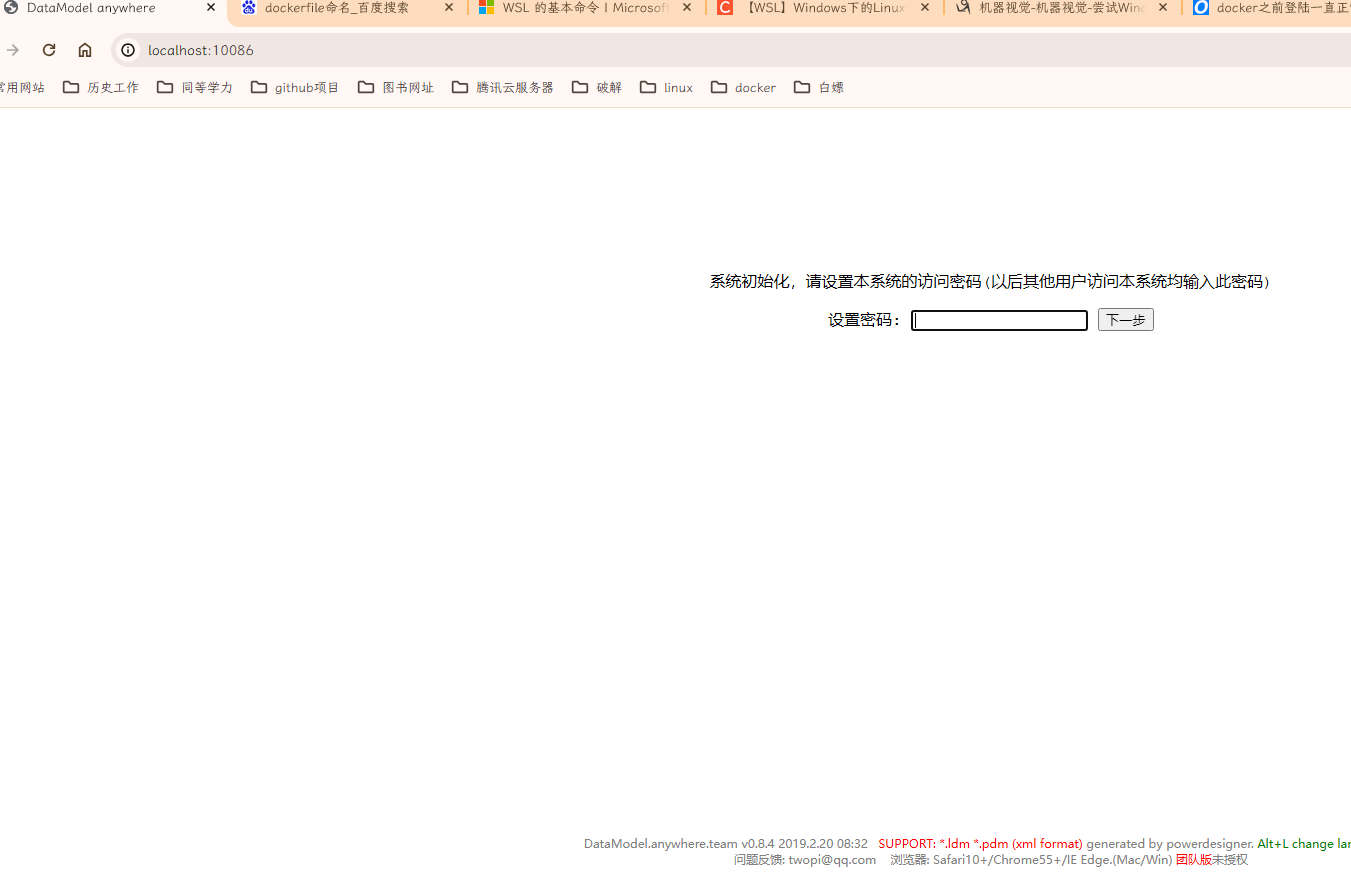

dmanywhere的docker制作

dmanywhere的docker制作

官网地址:

http://www.dmanywhere.cn/

下载相关执行文件。

Dockerfile的默认命名是“Dockerfile”,

在构建镜像时,如果没有指定Dockerfile文件,Docker通常会寻找名为“Dockerfile”的文件

1.Dockerf…

Python使用连接池操作MySQL

测试环境说明:Python版本是 3.8.10 ,DBUtils版本是3.1.0 ,pymysql版本是1.0.3

首先安装指定版本的连接池库DBUtils 、还有pymysql

pip install DBUtils3.1.0

pip install pymysql1.0.3创建文件 sqlConfig.py

# sqlConfig.pyimport pymysql…

vue2vue3为什么el-table树状表格失效?

上图所示,后端返回字段中有hasChildren字段。

解决树状表格失效方案:

从后端拿到数据后,递归去掉该字段,然后就能正常显示。(复制下方代码,直接用)

亲测有效,vue2、vue3通用

/**…

【飞舞的花瓣】飞舞的花瓣代码||樱花代码||表白代码(完整代码)

关注微信公众号「ClassmateJie」有完整代码以及更多惊喜等待你的发现。 简介/效果展示

这段代码是一个HTML页面,其中包含一个canvas元素和相关的JavaScript代码。这个页面创建了一个飘落花瓣的动画效果。

代码【获取完整代码关注微信公众号「ClassmateJie」回复“…