- show lab NUS&bytedance

- https://github.com/magic-research/magic-animate

- 问题引入

- 输入参考图片 I r e f I_{ref} Iref和动作序列 p 1 : N = [ p 1 , ⋯ , p N ] p^{1:N}=[p_1,\cdots,p_N] p1:N=[p1,⋯,pN],其中 N N N表示的是帧数,输出的是 N N N帧的视频,动作和动作序列保持一致,外观和参考图片保持一致;

- methods

- video diffusion model来保持帧间一致性,加入了temporal attentio模块;

- reference encoder来embed参考图片得到reference embedding y a y_a ya,实现上是复制了另外一份unet(不含temporal module),注入到vdm的方式是和middle以及upsample层的self attention层的hidden state进行concat;

- pose controlnet来获取motion condition y p 1 : K y_p^{1:K} yp1:K;

- 因为是逐段的生成,段与段之间衔接可能不连贯,所以采取了overlap+average得方式来处理;

- 训练的时候图片和视频统一训练;

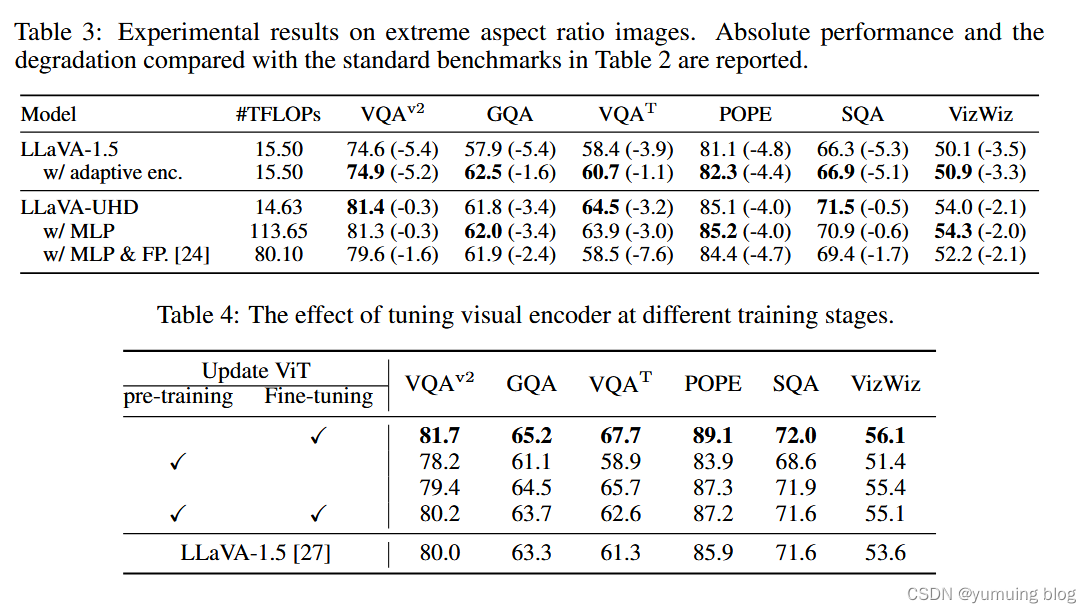

- 实验

- 数据集:Tiktok&TED-talks

![正点原子[第二期]Linux之ARM(MX6U)裸机篇学习笔记-16讲 EPIT定时器](https://img-blog.csdnimg.cn/direct/2c1364a5c1894b57b6167b3832854144.png)