优秀博士学位论文代表了各学科领域博士研究生研究成果的最高水平,本公众号近期将推出“优秀博士学位论文分享”系列文章,对人工智能领域2023年优秀博士学位论文进行介绍和分享,方便广大读者了解人工智能领域最前沿的研究进展。

“博士学位论文激励计划”(原优秀博士学位论文奖)是对博士研究生学位论文的一项重大奖励,由各大学会通过严格评选后颁布。中国计算机学会、中国自动化学会、中国人工智能学会等各大学会每年都会颁布该奖项。该奖项的目的是促进学术研究的卓越性,并鼓励产出高质量的博士论文。博士研究生如果能够荣获该奖项,则表明其学术研究生涯早期的成果受到了很高的认可。

本推文主要介绍上海交通大学杨学博士的研究成果,其博士论文《复杂场景下高精度有向目标检测的研究》荣获了2023年中国计算机学会“博士学位论文激励计划”(原优秀博士学位论文奖)。该论文聚焦研究复杂场景下高精度的有向目标检测算法。论文以有向目标检测为研究重点,在鲁棒有向目标检测器搭建、高效位姿参数估计、弱监督算法探索以及有向目标检测工具设计这四个方面来扩展和完善现有的算法。目前该论文已获得“博士学位论文激励计划”奖项。此外,本推文还对其指导老师严骏驰教授进行了介绍,以方便读者了解更多相关信息。本推文的作者为龙佰超,审校为许东舟和朱旺。

一、论文介绍

深度学习作为一门新兴的学科,它在海量数据和复杂数据的处理上展现出了强大的能力,因此被广泛应用于计算机视觉和图像处理任务中。

目标检测作为计算机视觉的基本任务之一,是包括实例分割,目标跟踪、行人再识别等视觉任务在内的基础,并在近二十年得到了广泛研究和快速发展。目标检测是指,针对给定的图像,通过图像处理和计算机视觉等算法,找到图中所感兴趣的目标并定位其精确的位置坐标以及识别出具体的类别信息。目标检测可以分为“通用目标检测”和“检测应用”两个研究课题,前者旨在探索在统一框架下检测不同类型目标的通用方法,以模拟人的视觉和认知,后者则是指特定应用场景下的检测,如行人检测、人脸检测、场景文字检测和遥感检测等。近年来,深度学习技术的飞速发展,促使目标检测领域取得显著突破,进而将目标检测推向空前关注的研究热点。然而,经典的水平框目标检测算法已经无法满足当前许多特殊场景(如遥感影像、场景文字等)的需求,因此有向目标检测技术应运而生。文章主要探究如何在复杂环境下设计高精准的有向目标检测器。

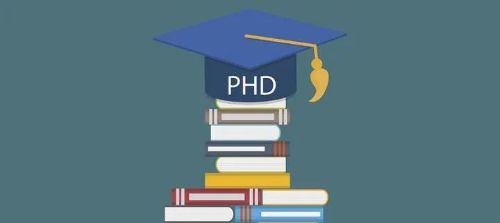

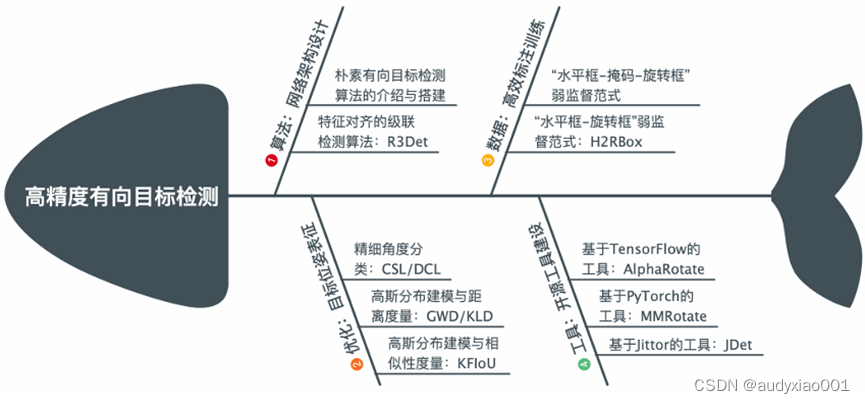

图1文章研究内容的整体脉络

鉴于有向目标检测巨大的应用前景、以及现存的困难与挑战,文章以有向目标检测为研究重点,在鲁棒有向目标检测器搭建(基准算法)、高效位姿参数估计(参数优化)、弱监督算法研究(训练数据)以及有向目标检测工具设计(集成工具)这四个方面来扩展和完善现有的算法,图1从这四个方面梳理了文章核心内容的整体脉络。

1. 有向目标检测器的网络架构设计

有向目标检测作为水平目标检测的一个扩展研究方向,其主要特点是估计框的冗余区域较少,在目标表示上更加精准。这对于密集场景非常友好。更重要的是有向目标检测保留了目标的方向信息,能为后续相关的任务提供重要的信息。目前有向目标检测算法均是基于经典水平检测算法改进的。第三章首先介绍了如何简单地将水平目标检测器改进成有向目标检测,包括介绍旋转框的不同定义、不同形式的锚框、旋转框重叠率的计算、回归参数的估计以及损失函数等基础知识。为了追求速度与精度的平衡,第三章提出了一种基于单阶段检测方法的级联有向检测器,该检测器采用了一种从粗到细的渐进式回归方法来快速准确地定位目标。考虑到级联检测器中存在的特征不对齐的问题,还设计了一个用于获得更准确特征的特征精修模块来提高检测性能。在多个公开的有向目标检测数据集上的大量实验结果表明,所提方法均有不错的表现。

第三章介绍了如何从一个水平目标价检测器(如单阶段检测器RetinaNet)到有向目标检测器的搭建,主要介绍了旋转框的不同定义、不同形式的锚框、旋转框重叠率的计算、回归参数的估计以及损失函数等基础知识,并在实验中比较和分析了不同锚框设置下有向目标检测器(RetinaNet-H和RetinaNet-R)的优缺点。然后设计了一个级联检测器R3Det来平衡速度与精度,同时通过设计了一个特征精修模块首次解决了单阶段有向目标检测中特征不对齐的问题。所提方法在众多公开数据集上得到了验证,并在当时的多个数据集上取得了最先进的性能。

2. 有向目标检测器的目标位姿表征

目标检测器定位的精准程度有很大一部分因素取决于检测器定位损失的设计,即位姿参数的估计机制。区别于水平框目标检测,有向目标检测往往会引入角度参数,这使得定位损失的设计变得更为复杂。第四章首先阐述了不同旋转框定义法下由角度参数和长宽两条边参数引起的边界不连续问题,并在特定旋转框定义法下通过将角度估计从回归问题转换成精细的分类问题予以初步解决,同时还通过分类的方式进一步实现了目标头部检测。随后第四章进一步提出了类正方形检测问题以及评估方式和回归损失不一致问题,并通过使用高斯分布建模与距离度量的方法统一解决了不同定义法下的边界不连续问题、类正方形检测问题和不一致问题,还进一步分析了高斯分布建模与距离度量可以实现高精度目标检测的原因。最后,在保留高斯分布建模的优势下继续采用相似性度量完善了对旋转重叠率损失的近似,并通过各类实验对第四章所提方法进行了有效性的验证以及给出总结与讨论。

第四章针对有向目标检测提出了三种亟待解决的问题:边界不连续问题、类正方形检测问题以及评估方式与损失函数不一致问题。第四章主要由三部分组成:

1) 第四章总结了发生边界不连续问题的主要原因是理想的估计结果超出了定义的范围,因此提出了一种在特定旋转框定义下方法,将角度估计从回归转为分类,以初步解决这一问题。同时为了实现精细的角度分类,第四章先提出了兼顾角度周期性和相邻角度容忍性的环形循环标签CSL,随后提出了密集编码标签DCL来降低模型的参数量和计算量,最后通过构建数据集、评价指标和头部分类的方式提出了目标头部检测任务。

2) 第四章提出了高斯分布建模来作为上述三种问题的统一解决方案,并将高斯分布距离(GWD,BCD和KLD)作为回归损失来优化检测器。通过梯度分析和尺度不变性证明,第四章发现使用KLD作为最终的回归损失可以取得显著的性能提升,尤其在高精度指标上表现突出。

3) 保留高斯分布建模优越性的前提下,第四章基于高斯分布相乘提出了相似性度量KFIoU来取代距离度量(如KLD)作为检测器最终的回归损失。相比之下,KFIoU可以更好地近似SkewIoU以更好地解决评估方式与损失函数不一致问题,并且不会引入任何超参数使得模型的训练变得稳定鲁棒。

虽然第四章所提出的方法均取得了不错的效果,但依然存在些许问题:

1) 目前文章分两步实现了头部检测,其流程还可以简化。如根据目标头部定义旋转框,则此时角度范围应该是[0◦,360◦),这样就可以通过CSL或者DCL同时实现有向/头部检测;

2) 第四章中的公式4.16只能进行五参数旋转矩形框的转换,即它不能直接应用于四边形/多边形检测。一种可行的方案是使用极大似然估计来估计点集对应的高斯分布,相关工作目前已在G-Rep中被提出;

3) 正方形目标的高斯分布是一个各向同性的圆形,这不适用于4.1.2小节提出的目标头部检测以及3-D目标检测中行人类别的朝向估计。目前,已有初步的朝向矫正方案在GWD和KLD的期刊扩展版本中被提出,期待未来更好的方法被提出。

3. 有向目标检测器的高效标注训练

目前有向目标检测已经在遥感影像、场景文字、自动驾驶等领域得到了初步的发展,然而许多现有的目标检测数据集均是用成本更低的水平边界框进行标注的,这导致暂时无法将这些数据集直接用到有向目标检测器的训练。第五章提出一种新的弱监督目标检测任务:基于水平边界框标注的有向目标检测。该类方法可以充分利用已有的海量水平框标注的目标检测数据集,减少重新标注的成本,同时提高检测器的性能。第五章首先阐述研究该项弱监督目标检测任务的动机,然后介绍“水平框-掩码-旋转框”和“水平框-旋转框”两种设计范式,最后通过实验分析这两种范式的优缺点并进行方法的总结与讨论。

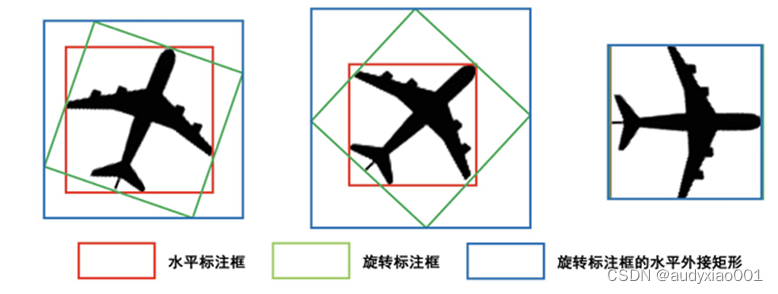

第五章首次在目标检测领域中提出了基于水平框标注训练的弱监督有向目标检测任务,并提出了“水平框-掩码-旋转框”(HBox-Mask-RBox)和“水平框-旋转框”(HBox-to-RBox)两种范式进行实现。前者主要结合水平框监督的实例分割算法(如BoxInst和BoxLevelSet)和取最小外接矩形的后处理操作进行实现,经过实验分析这类方法存在性能低、速度慢和显存高等诸多问题。而后者采用了自监督的网络架构,通过衡量输入图片在不同视图下估计结果的一致性实现了精准的旋转框估计,实验表明所提出的H2RBox方法不管在精度还是速度方面均优于HBox-Mask-RBox类方法,并与强监督有向目标检测方法在各方面都比较接近。虽然H2RBox已经在在弱监督有向目标检测上取得了初步的进展,但是H2RBox其实在AP75等高精度指标上表现并不好。一个原因是弱监督分支训练的模型所估计的水平框不一定准,另一个原因可能是有些类别水平标注框不一定就是旋转标注框的水平外接矩形,如图 2中的飞机所示。

图 2 水平标签框、旋转标签框和旋转标签框水平外接矩形的关系

在后续的研究中,H2RBox-v2通过引入对称自监督学习使得H2RBox的性能进一步提升,在部分数据集上追平甚至超越强监督算法。对称自监督学习近期也被逐渐应用于基于点监督的有向目标检测算法,如Point2RBox和PointOBB,简化流程的同时均有不错的性能。

4. 有向目标检测器的开源工具建设

目前最受欢迎的几个目标检测工具都是专注于水平目标检测,如MMDetection,Detectron2和SimpleDet。相比之下,有向目标检测在发展前期始终缺乏一个整合了大部分先进有向检测模型的工具用于评估和使用。为了解决这个问题,相关的工具陆续被开发出来。AerialDetection是较早基于MMDetection开发的专注于遥感影像的有向目标检测工具,然而它只提供了一些基准方法和有限的先进算法,并且缺乏维护以及后续新算法的集成。OBBDetection是另一个基于MMDetection开发的用于有向目标检测的开源工具,它支持了近9种不同的检测方法以及提供了一系列高效的处理大规模遥感影像的工具。可以看出目前的有向目标检测基准工具都使用PyTorch进行开发,具有深度学习框架类型单一、支持算法/数据集种类少、使用文档缺失、维护不完善等缺陷,阻碍了有向目标检测技术研究的进一步发展。第六章从学术研究、工业部署和国产化三个角度出发,分别基于TensorFlow、PyTorch和Jittor搭建了三种各具特色的有向目标检测工具:MMRotate、AlphaRotate和JDet。

第六章介绍了三种基于不同深度学习框架的有向目标检测工具。先从支持的算法/数据集的数量、使用文档、维护情况等角度将这三个检测工具与其他同类进行了比较。然后介绍了各检测工具的设计亮点以及使用教程,同时也列出了它们所支持的有向目标检测算法。每个检测工具都在标准数据集上比较了不同算法的性能,并且提供了相应权重和配置文件。论文希望所设计的有向目标检测工具能给学术界和工业界带来方便。三个有向目标检测工具还存在许多待提高的地方,会根据社区反应和讨论进行不断完善,也呼吁更多相关研究者加入到有向目标检测相关内容讨论和开发的队伍中来。

二、个人成果

杨学,浙江省绍兴人,电子信息与电气工程学院计算机科学与工程系2023届博士,首届吴文俊人工智能博士班成员,师从严骏驰教授。现任上海人工智能实验室青年研究员,研究方向为基础视觉。累计发表包括TPAMI、IJCV、NeurIPS 、CVPR等在内的CCF-A类论文24篇,其中以第一作者共发表论文16篇。谷歌学术总引用超5500次,2篇入选PaperDigest最具影响力AAAI21论文列表(第1名和第10名)。曾获CCF博士学位论文激励计划(全国9人)、CCF-CV新锐学者奖(全国3人)、上海交通大学优秀博士论文(全校15人/工学8人)、上海交通大学“学术之星”提名奖(全校20人)、并入选2022和2023年度由斯坦福大学评选的全球前2%顶尖科学家榜单。所开源的代码在社区累积获得星数超过万次,包括两个有较大影响力的有向目标检测框架AlphaRotate和MMRotate,同时还参与了国产开源框架Jittor版本有向目标检测框架JDet的维护。更多信息请查阅杨学博士个人主页:https://yangxue0827.github.io/。

三、指导老师——严骏驰教授简介

严老师为上海交通大学人工智能学院和电子信息与电气工程学院计算机系教授,研究领域主要集中在计算机视觉、机器学习及人工智能与其它学科的交叉领域。更多关于严老师团队研究工作的介绍,请读者查阅其实验室网站:https://thinklab.sjtu.edu.cn/。