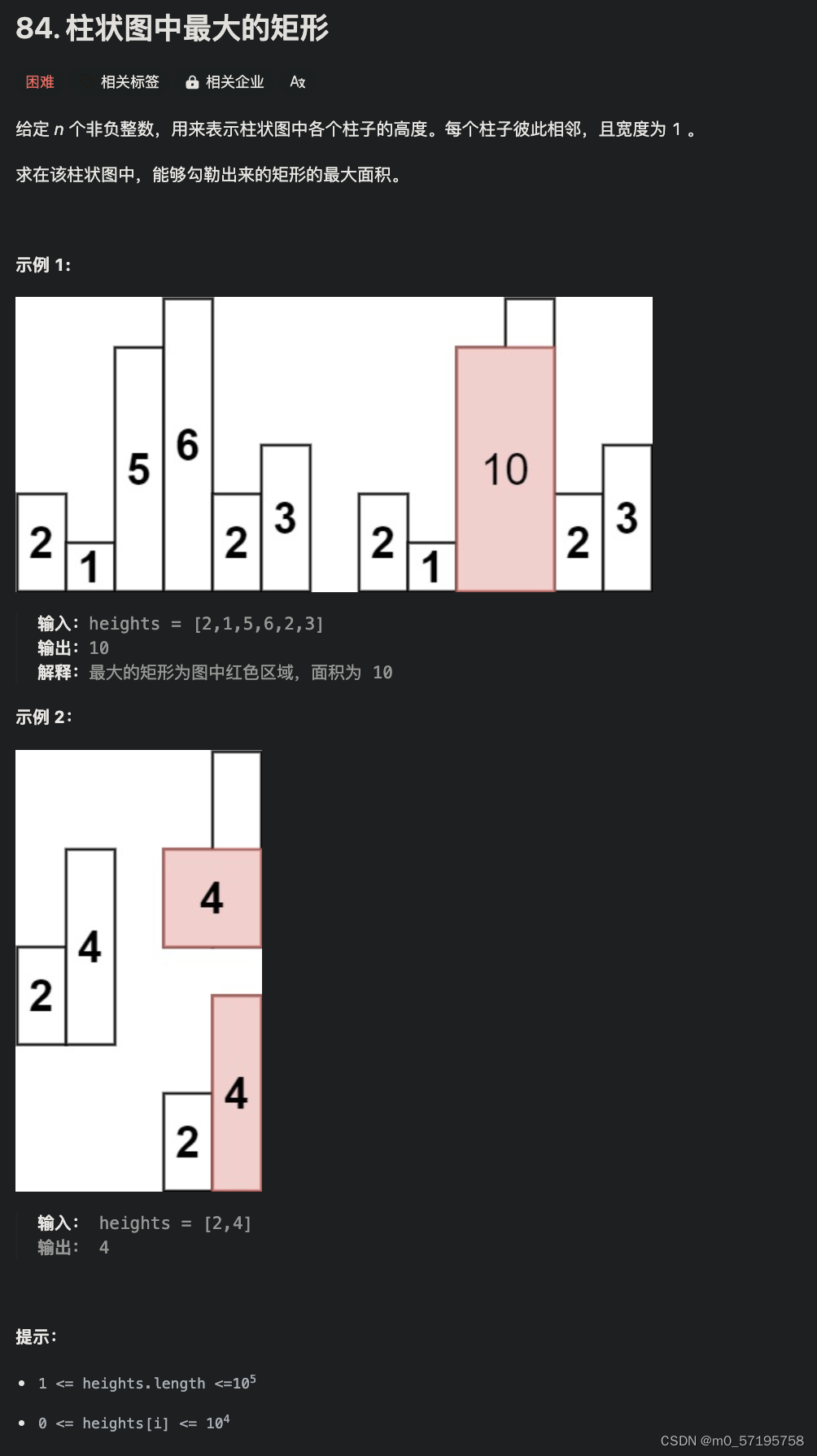

文章目录

- window安装docker-desktop

- 下载和启动lobe-chat

- AI大语言模型的选择

- lobe-chat设置大模型连接

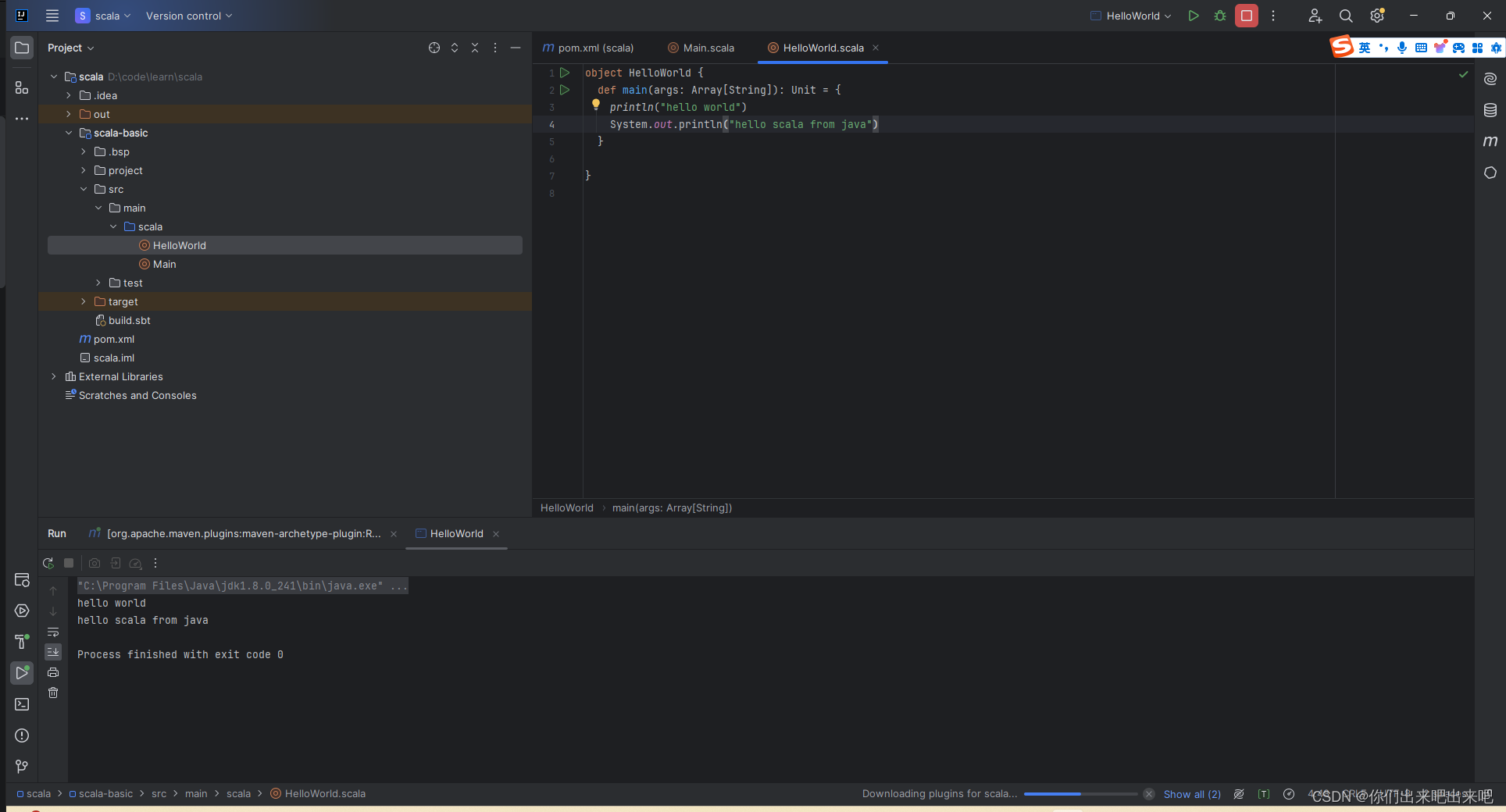

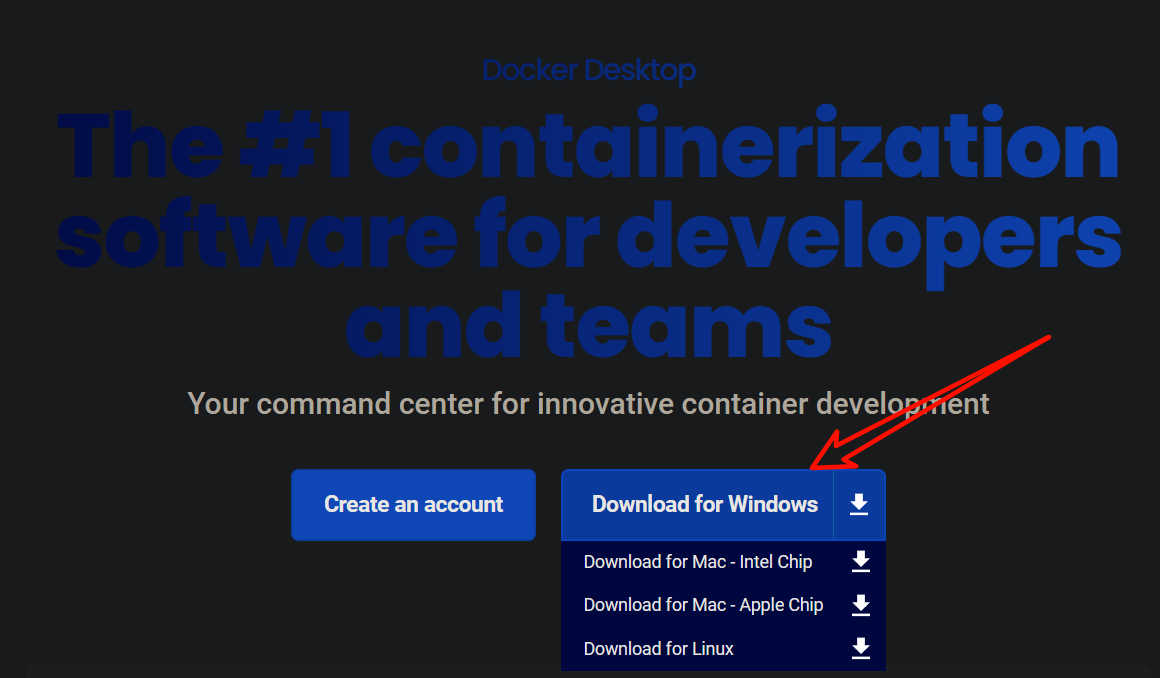

window安装docker-desktop

- docker-desktop下载地址

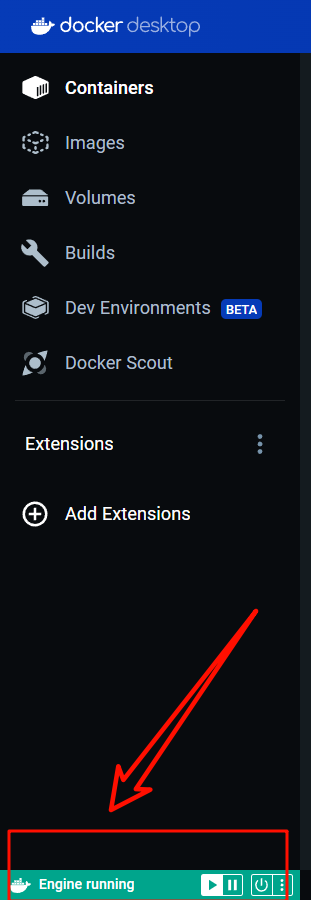

- 正常安装应用,然后启动应用,注意启动docker引擎

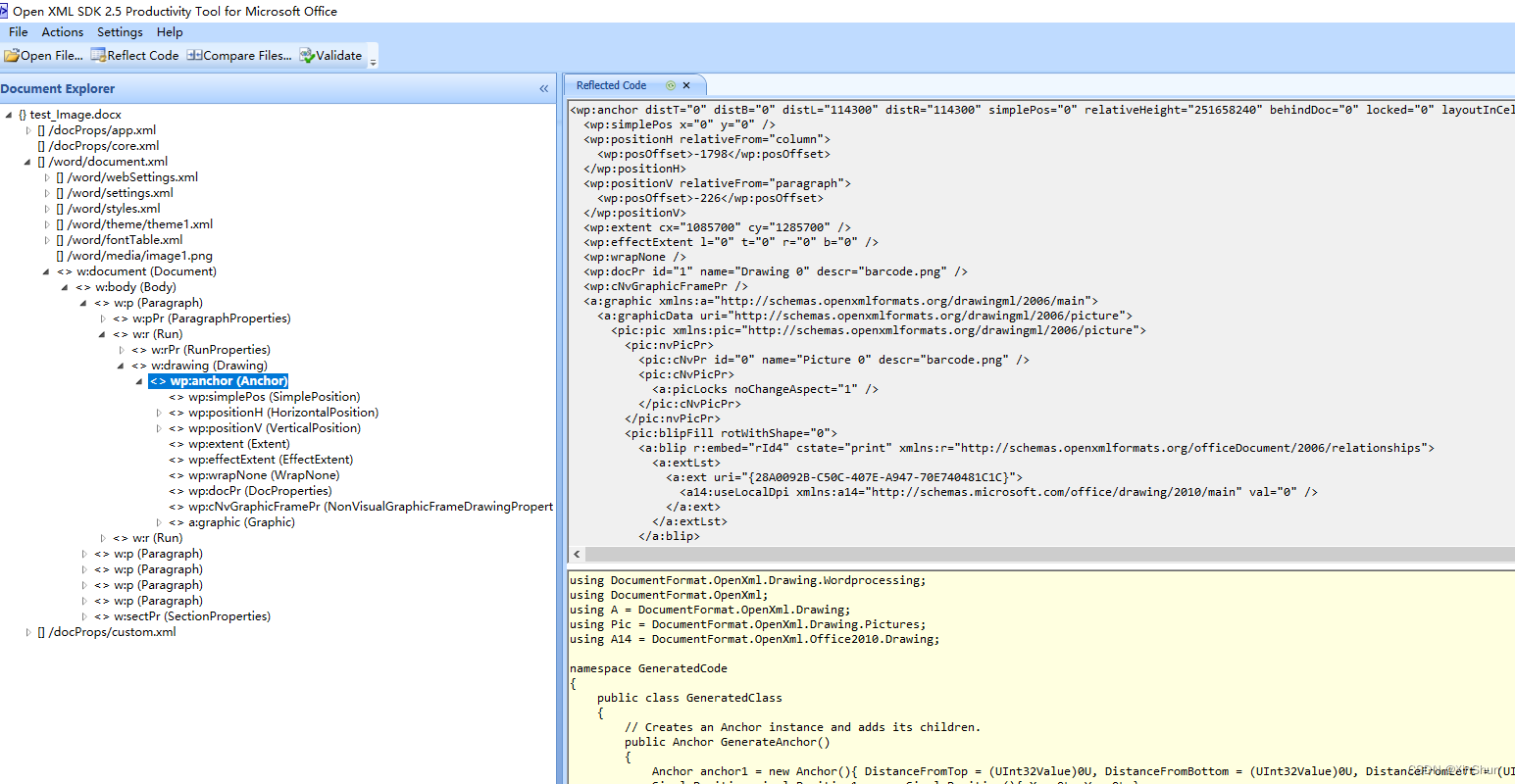

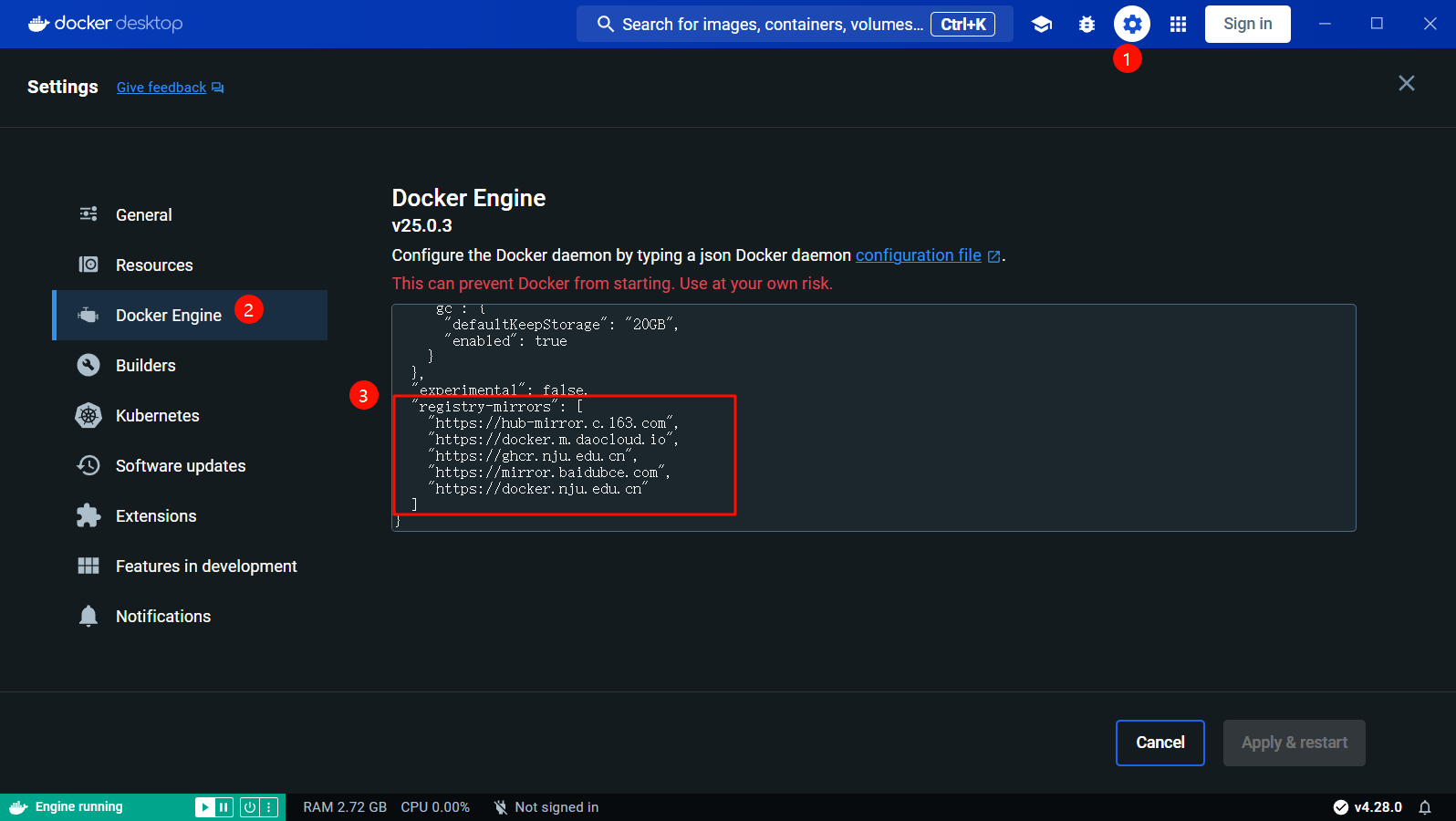

- 打开右上角的设置,进入Docker Engine设置配置镜像加速地址

- 这里作者的机器配置如下,以供参考,(作者的机器内存比较大一些,所以默认虚拟机内存较大)

{ "builder": { "gc": { "defaultKeepStorage": "20GB", "enabled": true } }, "experimental": false, "registry-mirrors": [ "https://hub-mirror.c.163.com", "https://docker.m.daocloud.io", "https://ghcr.nju.edu.cn", "https://mirror.baidubce.com", "https://docker.nju.edu.cn" ] }

下载和启动lobe-chat

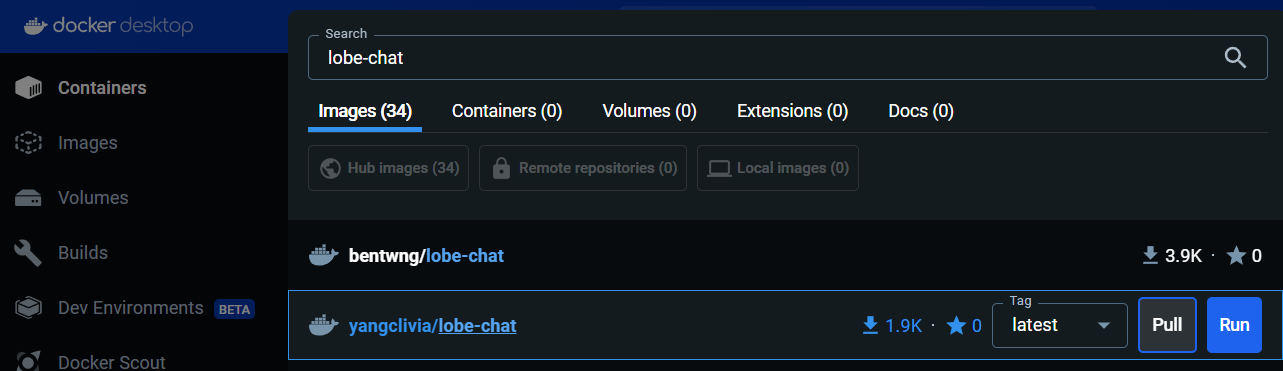

- 点击上面中间的搜索框,搜索

lobe-chat,点击拉取pull

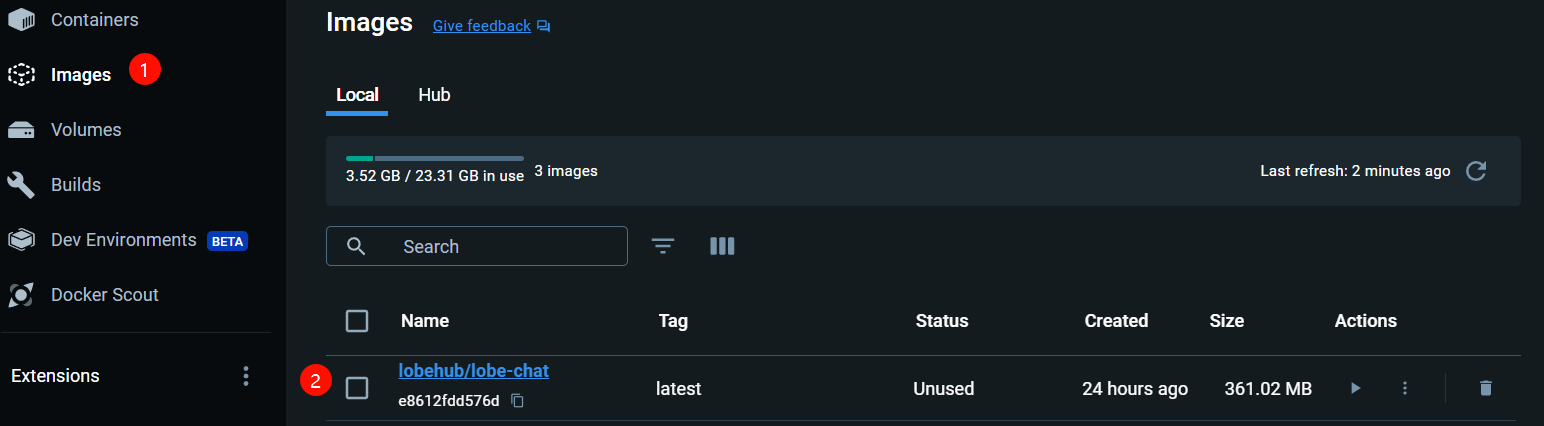

- 拉取成功后,即在

Images中可看到拉取的镜像文件

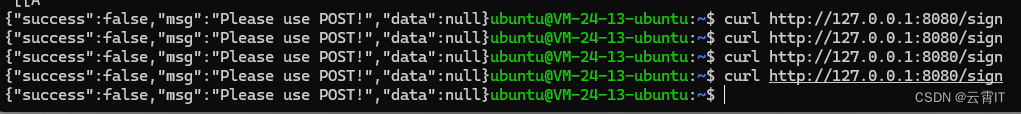

Win+R运行窗口,输入cmd进入终端,输入以下启动命令,然后访问lobe-chat地址http://localhost:3210/- 完整的部署文档

docker run -d -p 3210:3210 -e OPENAI_KEY=sk-xxx -e ACCESS_CODE=lobe66 --name lobe-chat lobehub/lobe-chat

AI大语言模型的选择

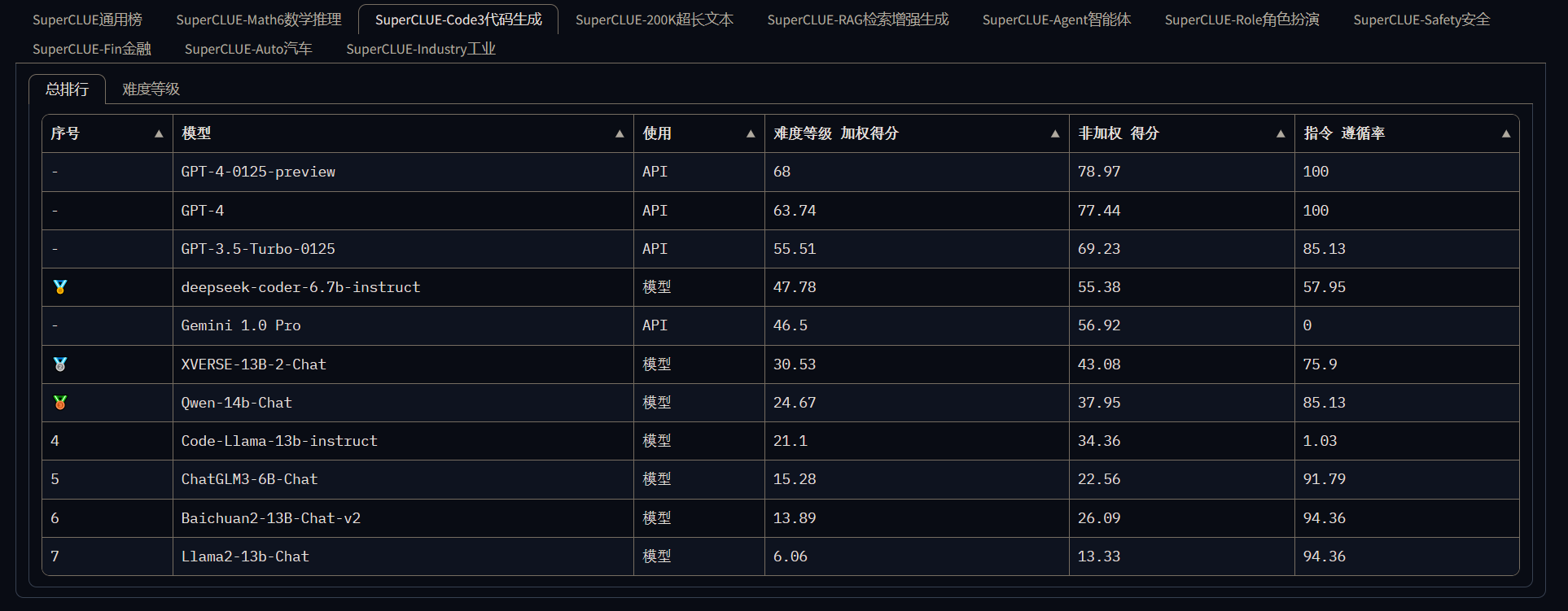

- AI大语言模型主要分为国外大模型和国内大模型。国外大模型:受限,或者不稳定。国内大模型,稳定,方便。

- 国内大模型排行榜:基于中文语言理解测评基准,包括代表性的数据集、基准(预训练)模型、语料库、排行榜。选择一系列有一定代表性的任务对应的数据集,做为测试基准的数据集,这些数据集会覆盖不同的任务、数据量、任务难度。

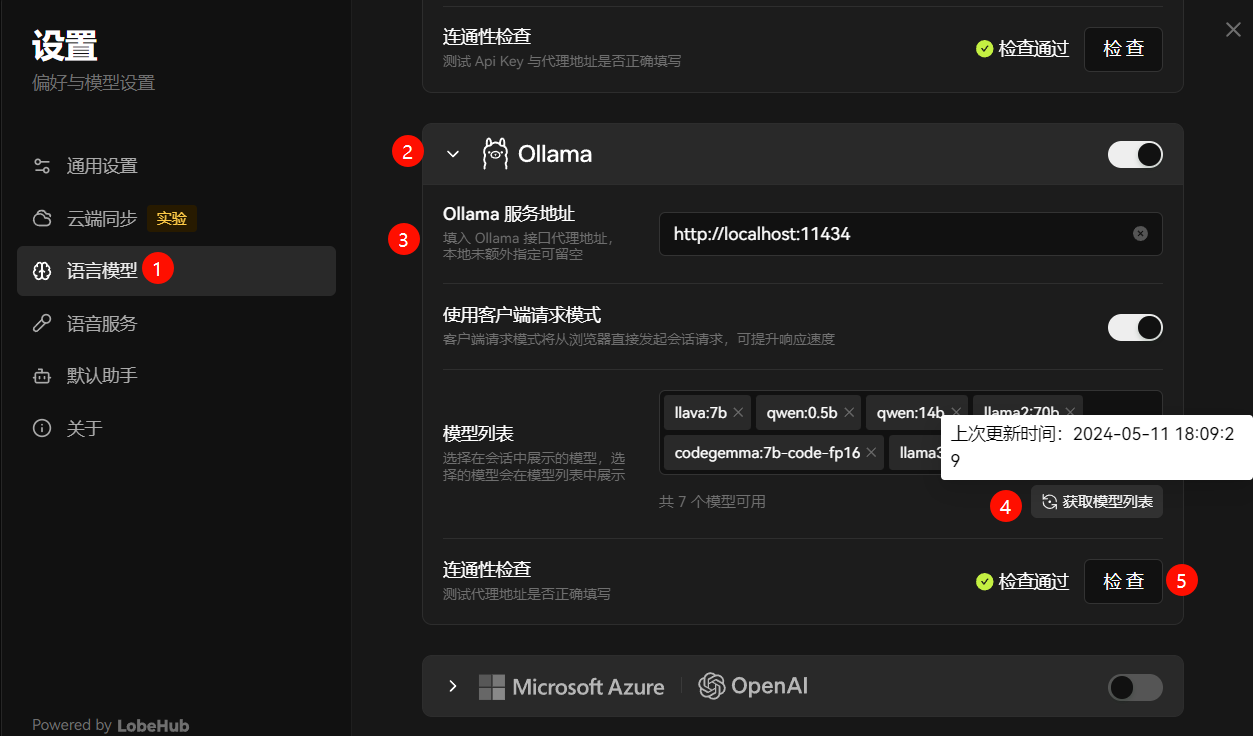

lobe-chat设置大模型连接

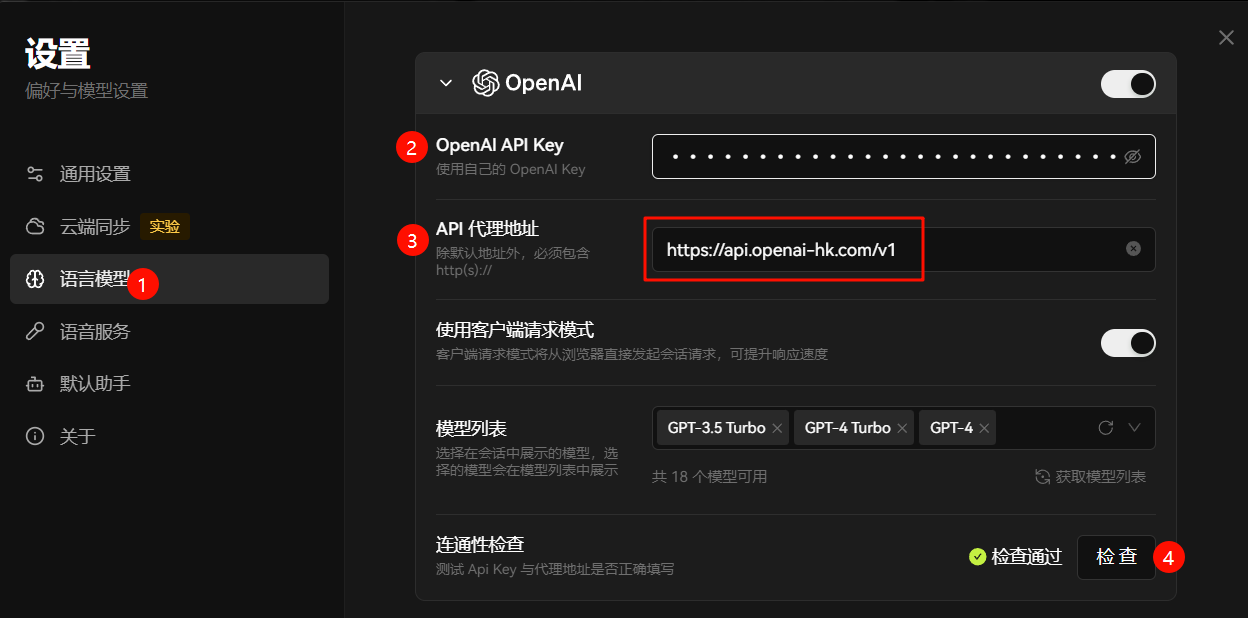

- 在设置中的语言模型中设置OpenAI连接,国内的朋友可以尝试

openai-hk,然后点击检查验证是否可行

- 注意API代理地址使用

https://api.openai-hk.com/v1

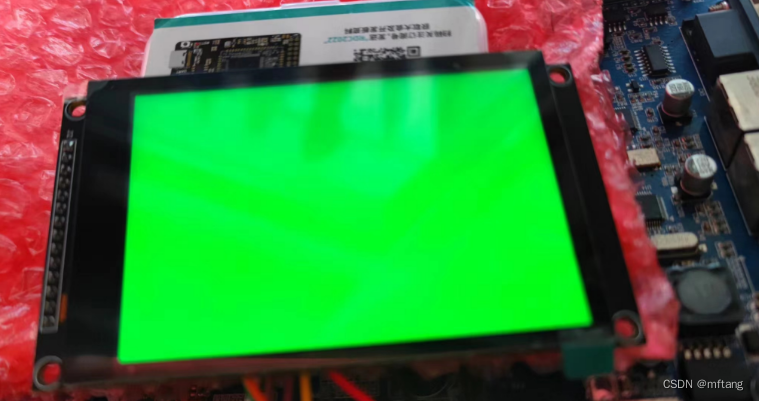

- 本地Ollama大模型服务的连接设置如下,然后点击检查验证是否可行

![[蓝桥杯]真题讲解:AB路线(BFS+分层图)](https://img-blog.csdnimg.cn/direct/75f3e9de755a4956bc72cb08e1bdb3e6.png)