23. Imagic: Text-Based Real Image Editing with Diffusion Models

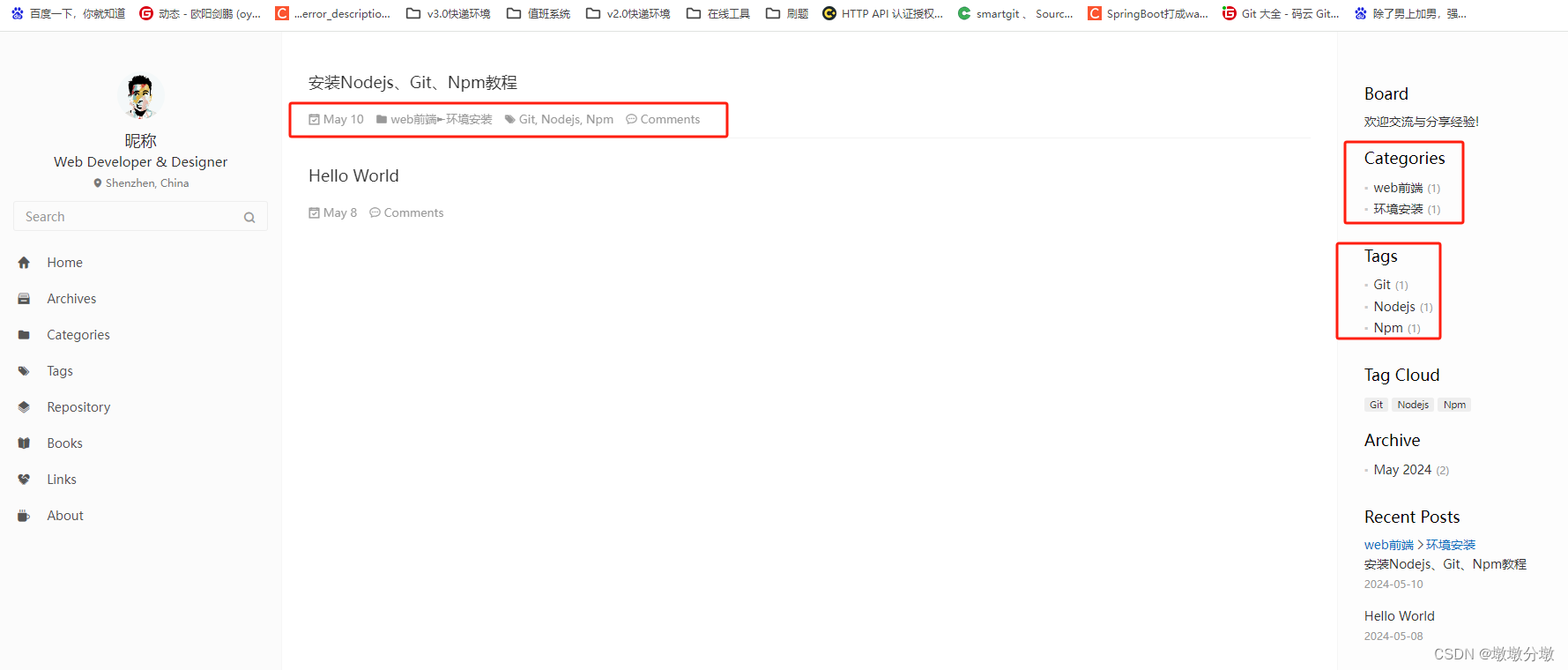

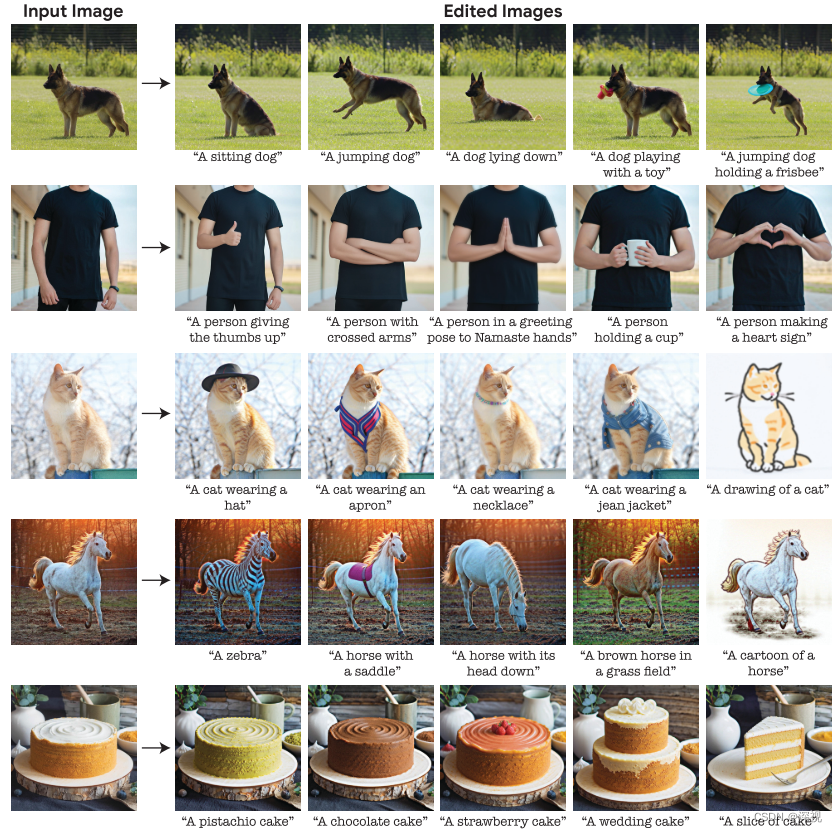

该文提出一种基于文本的真实图像编辑方法,能够根据纯文本提示,实现复杂的图像编辑任务,如改变一个或多个物体的位姿和组成,并且保持其他特征不变。相比于其他文本-图像编辑工作,Imagic具备更丰富的编辑方式,并且能够更好的保留编辑对象原有的特征。下面先展示一波结果,秀一下肌肉。可以看到编辑的效果非常逼真,而且是对图像中目标物体直接进行编辑,而不是重新生成一个新的对象。

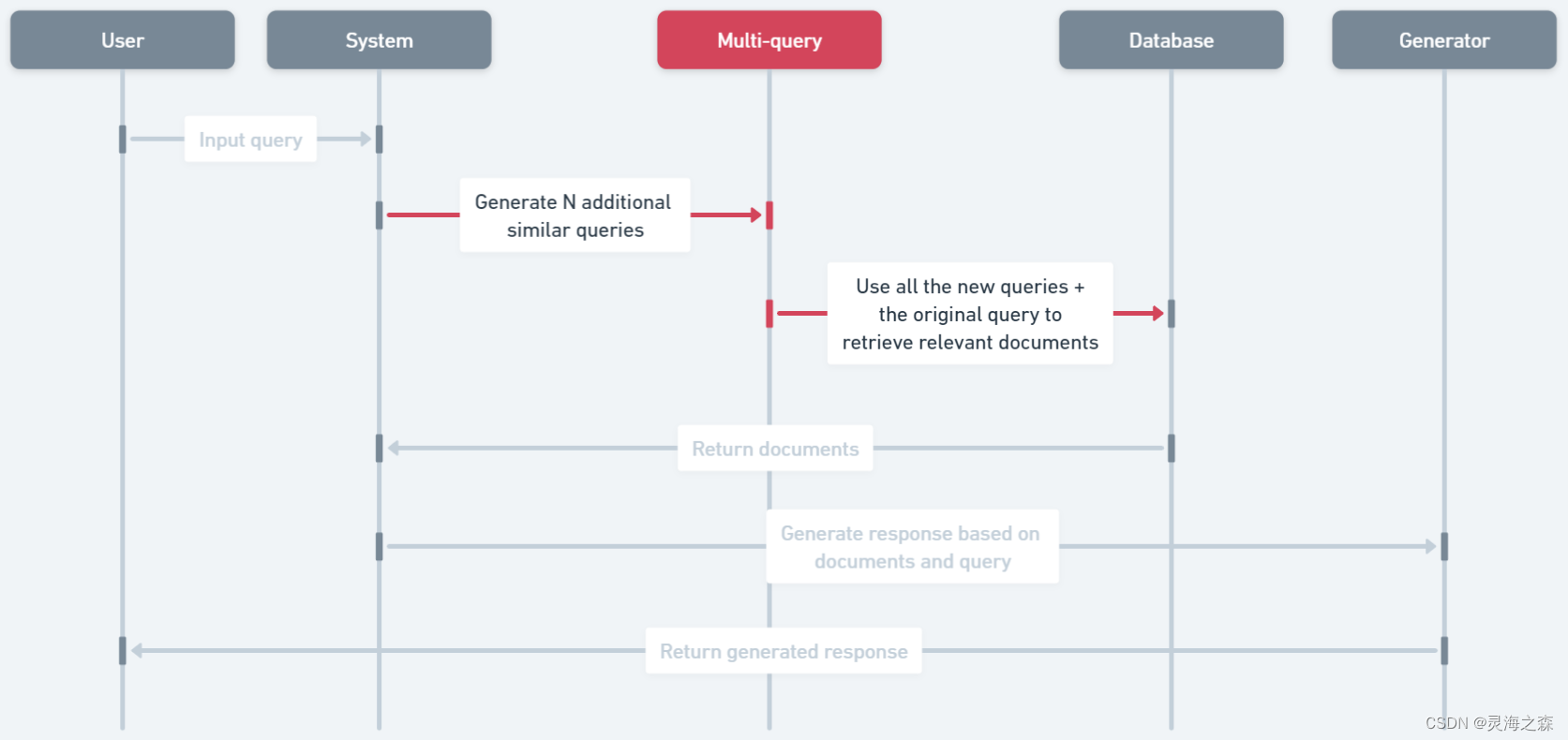

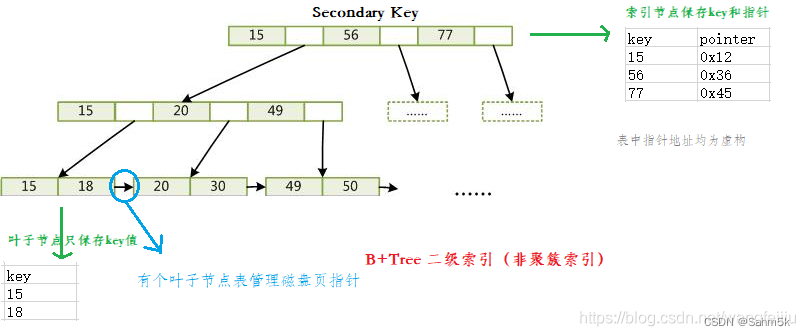

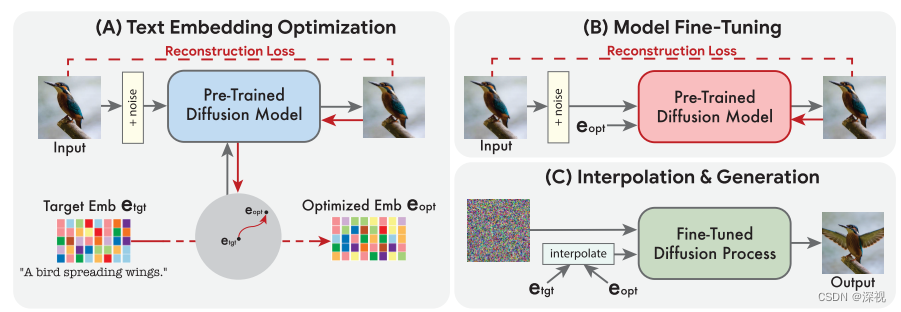

基于扩散模型的文本-图像编辑和生成的基础理论我这里就不再赘述了,不清楚的可以参考本博客该专栏下的其他文章。笼统点来讲,我们要把输入的文本描述转化为一个嵌入式向量,并将其作为一种条件信息引入到图像生成过程中,从而实现图像的编辑。本文提出的方法包含三个步骤:文本嵌入特征的优化,扩散模型的微调,以及特征插值与图像生成,如下图所示。

首先,输入的文本描述经过一个文本编码器得到一个目标文本特征

e

t

g

t

e_{tgt}

etgt,并使用一个预训练好的文本-图像生成模型

f

θ

f_{\theta}

fθ对文本特征

e

t

g

t

e_{tgt}

etgt进行优化,损失函数如下

L

(

x

,

e

,

θ

)

=

E

t

,

ϵ

[

∥

ϵ

−

f

θ

(

x

t

,

t

,

e

)

∥

2

2

]

\mathcal{L}(\mathbf{x},\mathbf{e},\theta)=\mathbb{E}_{t,\epsilon}\left[\left\|\boldsymbol{\epsilon}-f_{\theta}(\mathbf{x}_{t},t,\mathbf{e})\right\|_{2}^{2}\right]

L(x,e,θ)=Et,ϵ[∥ϵ−fθ(xt,t,e)∥22]其中初始的

e

\mathbf{e}

e就是我们上文得到的

e

t

g

t

e_{tgt}

etgt,在这个过程中生成模型

f

θ

f_{\theta}

fθ的参数是固定不变的。随着训练的过程,

e

t

g

t

e_{tgt}

etgt被不断地更新,使其与输入图像

x

x

x的特征更加对齐,最终得到优化后的文本特征

e

o

p

t

e_{opt}

eopt。

然后,我们再固定输入的文本特征

e

o

p

t

e_{opt}

eopt不变,还是用上面的损失函数,对生成模型

f

θ

f_{\theta}

fθ进行微调训练;同时如果还有其他的辅助模型,如提升分辨率的模型,也在这个过程中进行微调,只不过文本条件仍使用目标文本特征

e

t

g

t

e_{tgt}

etgt,而不是优化过的

e

o

p

t

e_{opt}

eopt。不要问为什么,问就是实验显示

e

t

g

t

e_{tgt}

etgt效果更好。

最后,我们使用一个线性插值函数来计算

e

t

g

t

e_{tgt}

etgt和

e

o

p

t

e_{opt}

eopt之间的插值,如下式

e

ˉ

=

η

⋅

e

t

g

t

+

(

1

−

η

)

⋅

e

o

p

t

\bar{\mathbf{e}}=\eta\cdot\mathbf{e}_{tgt}+(1-\eta)\cdot\mathbf{e}_{opt}

eˉ=η⋅etgt+(1−η)⋅eopt

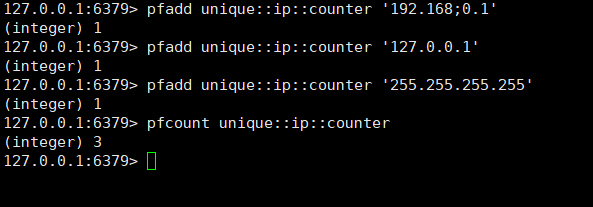

η

\eta

η是可调的超参数,将插值得到的条件

e

ˉ

\bar{\mathbf{e}}

eˉ输入到微调后的文本-图像生成模型中,即可得到对应的编辑结果。如下图所示,通过调整

η

\eta

η的大小,我们可以得到有原始图像到目标图像的渐进变化过程,作者表示

η

\eta

η取值为0.6-0.8时编辑的效果是最好的。

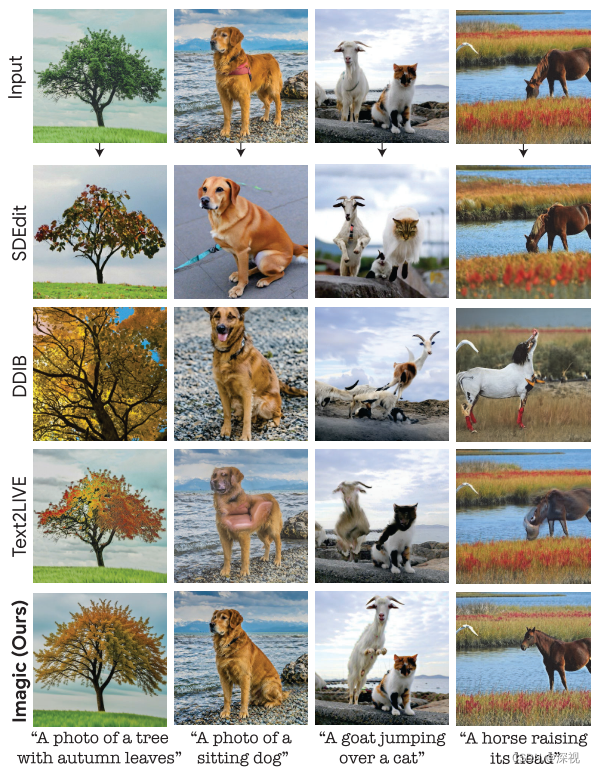

作者与许多现有的图像编辑方法进行了比较,结果如下图所示

![C++进阶 | [3] 搜索二叉树](https://img-blog.csdnimg.cn/direct/3c36f415464c466e821c201e522f0055.png)