【学习笔记】【Pytorch】十、搭建CIFAR-10 model结构和Sequential的使用

- 学习地址

- 主要内容

- 一、CIFAR-10 model结构介绍

- 二、代码实现

学习地址

PyTorch深度学习快速入门教程【小土堆】.

主要内容

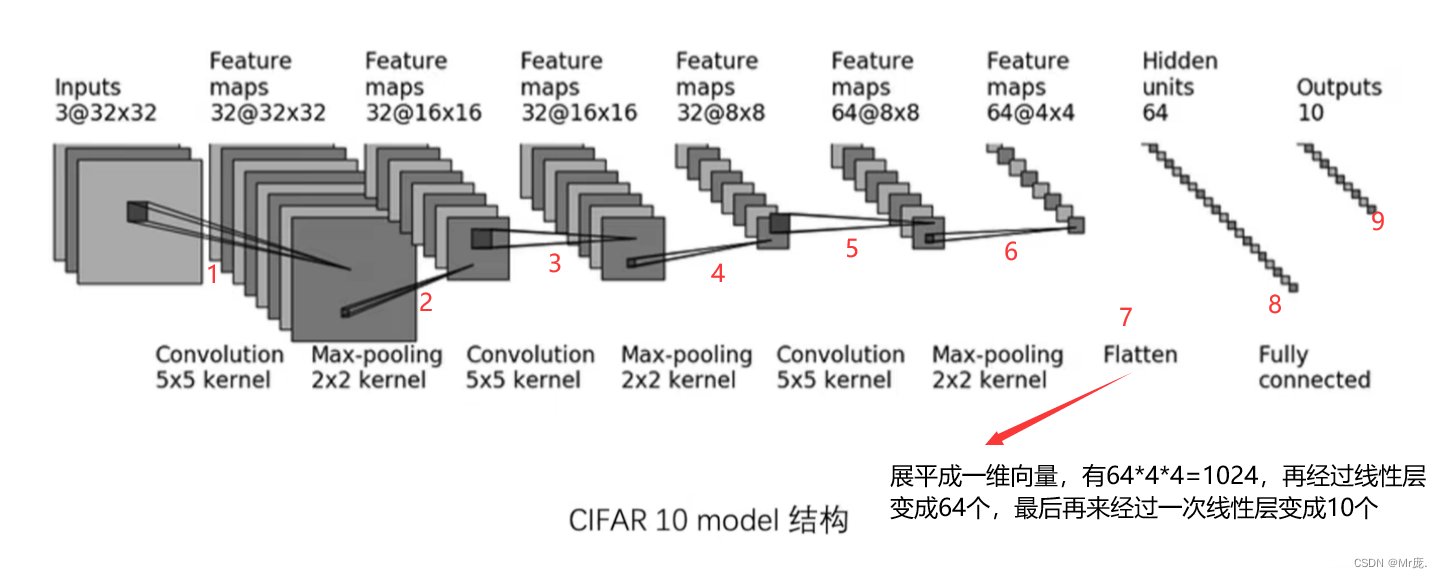

一、CIFAR-10 model结构介绍

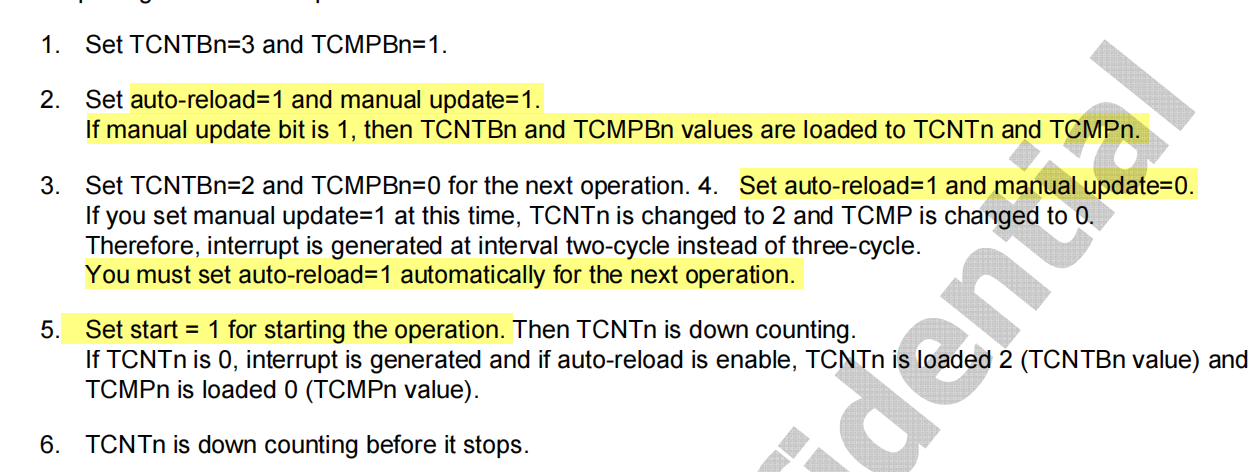

- input : 3@32x32,3通道32x32的图片 --> 特征图(Feature maps) : 32@32x32

即经过32个3@5x5的卷积层,输出尺寸没有变化(有x个特征图即有x个卷积核。卷积核的通道数与输入的通道数相等,即3@5x5)。

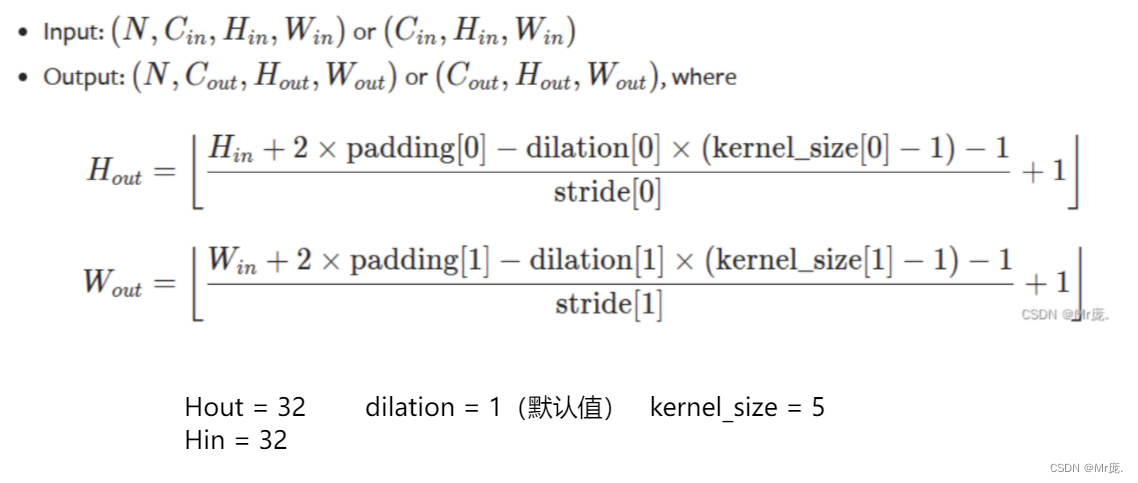

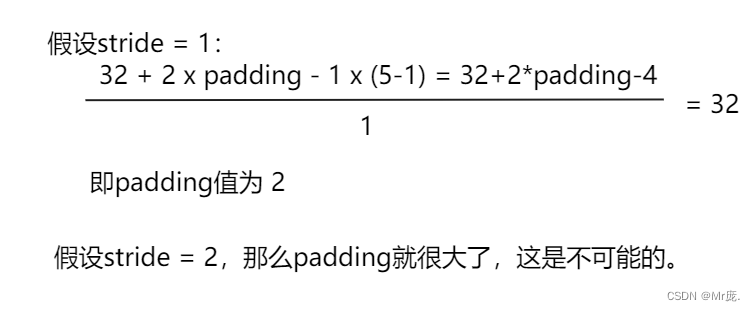

两种方法推导出padding = 2、stride = 1的值:- 公式法:

- 理论法:为保持输出尺寸不变,padding都是卷积核大小的一半,应该padding=kernel_size/2;奇数卷积核把中心格子对准图片第一个格子,卷积核在格子外有两层就padding=2。

- 公式法:

- input : 32@32x32 --> output : 32@16x16

即经过2x2的最大池化层,stride = 2(池化层的步长为池化核的尺寸),padding = 0,特征图尺寸减小一半。

3.input : 32@16x16 --> output : 32@16x16

即即经过32个3@5x5的卷积层,输出尺寸没有变化。padding = 2、stride = 1。

4.input : 32@16x16 --> output : 32@8x8

即经过2x2的最大池化层,stride = 2,padding = 0,通道数不变,特征图尺寸减小一半。

5.input : 32@8x8 --> output : 64@8x8

即即经过64个3@5x5的卷积层,输出尺寸没有变化。padding = 2、stride = 1。

6.input : 64@8x8 --> output : 64@4x4

即经过2x2的最大池化层,stride = 2,padding = 0,通道数不变,特征图尺寸减小一半。

二、代码实现

import torch

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear, Sequential

from torch.utils.tensorboard import SummaryWriter

class Model(nn.Module):

def __init__(self) -> None:

super().__init__() # 初始化父类属性

# self.conv1 = Conv2d(in_channels=3, out_channels=32,

# kernel_size=5, padding=2)

# self.maxpool1 = MaxPool2d(kernel_size=2)

# self.conv2 = Conv2d(in_channels=32,out_channels=32,

# kernel_size=5, padding=2)

# self.maxpool2 = MaxPool2d(kernel_size=2)

# self.conv3 = Conv2d(in_channels=32, out_channels=64,

# kernel_size=5, padding=2)

# self.maxpool3 = MaxPool2d(kernel_size=2)

# self.flatten = Flatten() # 展平为1维向量,torch.reshape()一样效果

# # 若是想检验1024是否正确,可以先写前面的层,看样例的输出大小,即可得到1024

# self.linear1 = Linear(in_features=1024, out_features=64)

# self.linear2 = Linear(in_features=64, out_features=10)

# sequential可以替代前面备注掉的代码段

self.model1 = Sequential(

Conv2d(3, 32, 5, stride=1, padding=2),

MaxPool2d(2),

Conv2d(32, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 64, 5, padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024, 64),

Linear(64, 10)

)

def forward(self, x):

# x = self.conv1(x)

# x = self.maxpool1(x)

# x = self.conv2(x)

# x = self.maxpool2(x)

# x = self.conv3(x)

# x = self.maxpool3(x)

# x = self.flatten(x)

# x = self.linear1(x)

# x = self.linear2(x)

#代替以上代码段

x = self.model1(x)

return x

model = Model() # 创建一个实例

print(model) # 打印模型结构

# 测试模型样例(也可以测试各层的输出是否正确)

input = torch.ones((64, 3, 32, 32))

print(input.shape) # torch.Size([64, 3, 32, 32])

output = model(input)

print(output.shape) # torch.Size([64, 10]),batch_size=64,10个参数

writer = SummaryWriter("./logs_seq") # 创建一个实例

writer.add_graph(model, input) # 显示模型结构

writer.close()

# tensorboard命令:tensorboard --logdir=logs_seq --port=6007

输出:

Model(

(model1): Sequential(

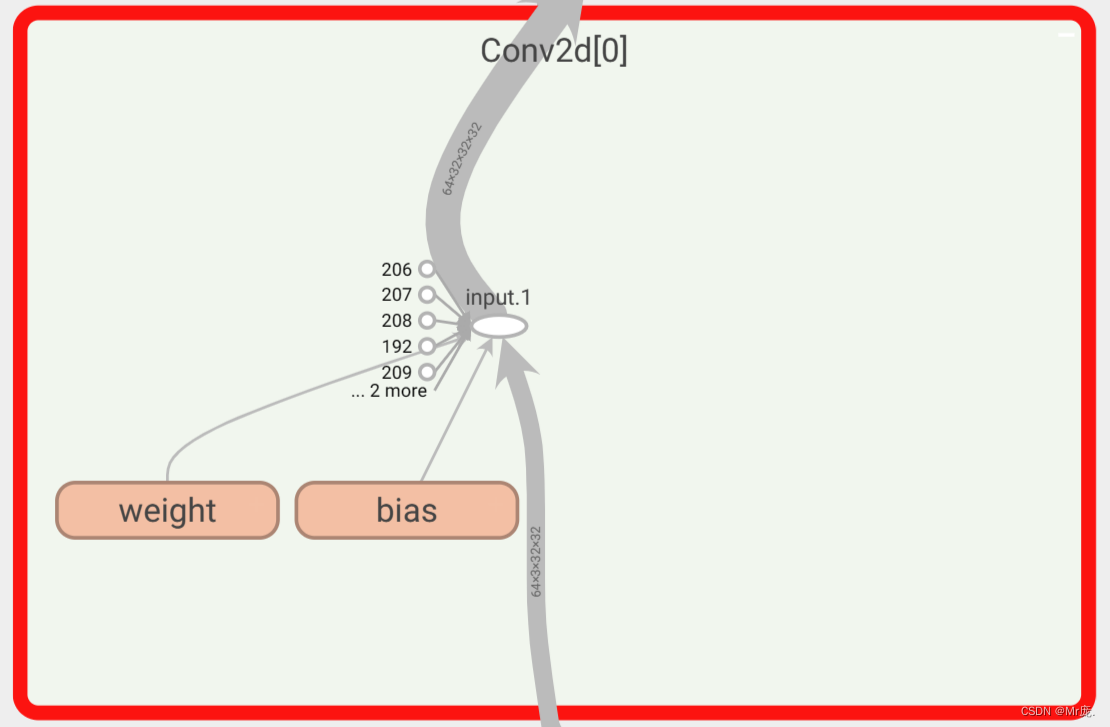

(0): Conv2d(3, 32, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(1): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(2): Conv2d(32, 32, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(3): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(4): Conv2d(32, 64, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(5): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(6): Flatten(start_dim=1, end_dim=-1)

(7): Linear(in_features=1024, out_features=64, bias=True)

(8): Linear(in_features=64, out_features=10, bias=True)

)

)

torch.Size([64, 3, 32, 32])

torch.Size([64, 10])

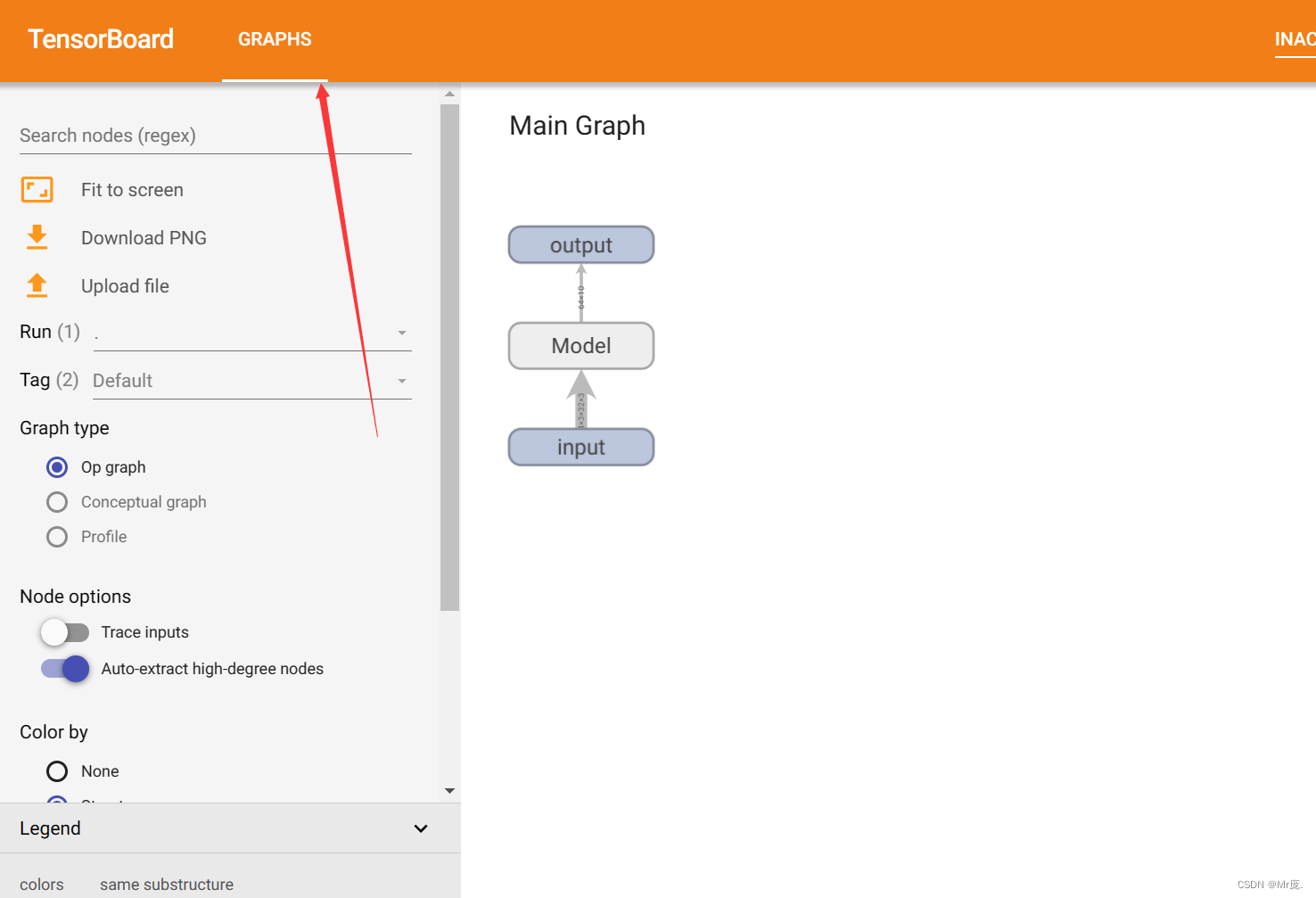

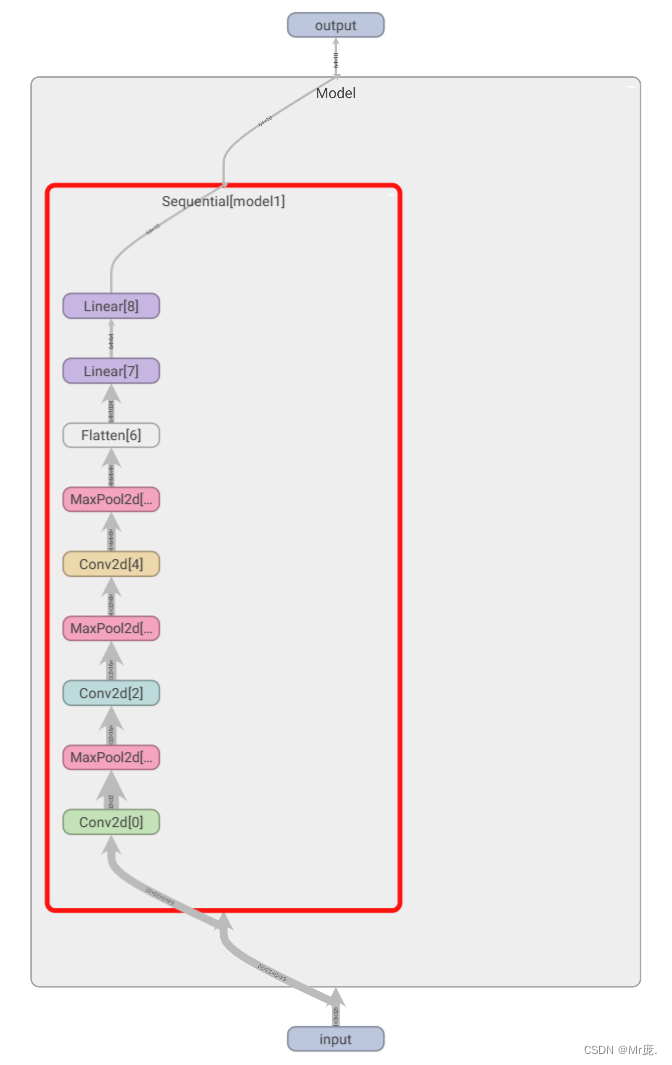

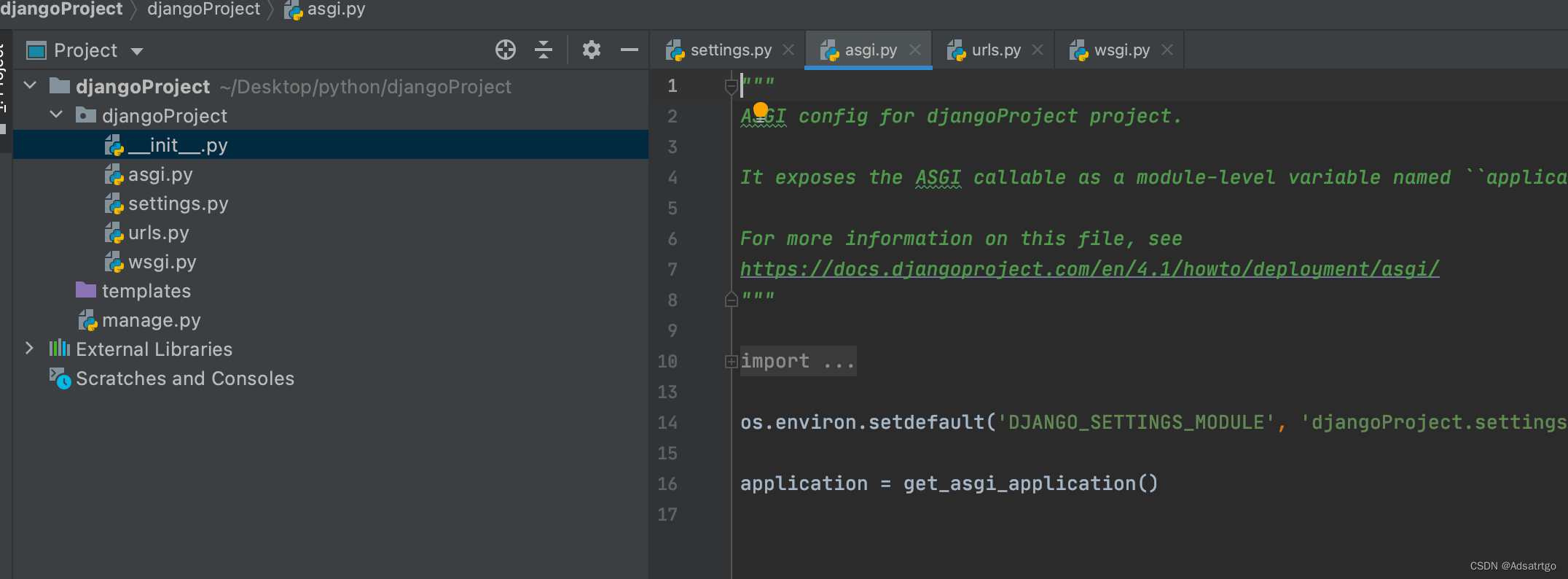

TensorBoard输出: