目录

- 一、相关和回归的概念

- (一)变量间的关系

- (二)Pearson(皮尔逊)相关系数

- 二、线性回归的概念和方程

- (一)回归分析概述

- (二)线性回归方程

- 三、线性回归模型的损失函数与参数估计

- (一)正规解方程法(最小二乘法)

- (二)梯度下降法

- 四、线性回归的正则化

一、相关和回归的概念

(一)变量间的关系

——函数关系和相关关系

(1)是一一对应的确定关系

(2)变量间关系不能用函数关系精确表达

1、函数关系的例子

- 某种商品的销售额 (y) 与销售量 (x) 之间的关系可表示为 y = p x y = p x y=px ( p p p为单价)

2、相关关系的例子

- 商品的消费量 ( y y y) 与居民收入 ( x x x) 之间的关系

- 父亲身高 ( y y y) 与子女身高 ( x x x) 之间的关系

3、相关关系的图示

(二)Pearson(皮尔逊)相关系数

随机变量

X

\color{red}X

X,

Y

\color{red}Y

Y,

D

=

{

(

x

1

,

y

1

)

,

(

x

2

,

y

2

)

,

⋯

,

(

x

m

,

y

m

)

}

\color{blue}D=\{ (x_1, y_1) , (x_2, y_2), \cdots, (x_m, y_m) \}

D={(x1,y1),(x2,y2),⋯,(xm,ym)}

μ

X

=

1

m

∑

i

=

1

m

x

i

,

μ

Y

=

1

m

∑

i

=

1

m

y

i

,

\mu_X=\frac{1}{m}\sum_{i=1}^mx_i,\mu_Y=\frac{1}{m}\sum_{i=1}^my_i,

μX=m1i=1∑mxi,μY=m1i=1∑myi,

σ

X

=

1

m

−

1

∑

i

=

1

m

(

x

i

−

μ

X

)

2

,

σ

Y

=

1

m

−

1

∑

i

=

1

m

(

y

i

−

μ

Y

)

2

,

\sigma_X=\sqrt{\frac{1}{m-1}\sum_{i=1}^m(x_i-\mu_X)^2},\sigma_Y=\sqrt{\frac{1}{m-1}\sum_{i=1}^m(y_i-\mu_Y)^2},

σX=m−11i=1∑m(xi−μX)2,σY=m−11i=1∑m(yi−μY)2,

C

o

v

(

X

,

Y

)

=

1

m

−

1

∑

i

=

1

m

(

x

i

−

μ

X

)

(

y

i

−

μ

Y

)

,

Cov(X,Y)=\frac{1}{m-1}\sum_{i=1}^m(x_i-\mu_X)(y_i-\mu_Y),

Cov(X,Y)=m−11i=1∑m(xi−μX)(yi−μY),

ρ

=

C

o

v

(

X

,

Y

)

σ

X

σ

Y

\boxed{ρ=\frac{Cov(X,Y)}{\sigma_X\sigma_Y}}

ρ=σXσYCov(X,Y)

- 相关系数 r r r 等于 X X X 与 Y Y Y 的协方差除以它们各自标准差的乘积

- 相关系数 r r r 的取值 [ − 1 , 1 ] [-1,1] [−1,1]

- 1表示完全正相关,-1表示完全负相关,0表示不相关

二、线性回归的概念和方程

(一)回归分析概述

回归分析指研究一组随机变量 ( X 1 , X 2 , ⋯ , X k ) (X_1, X_2,\cdots, X_k) (X1,X2,⋯,Xk) 和另一组变量 ( Y 1 , Y 2 , ⋯ , Y i ) (Y_1,Y_2,\cdots,Y_i) (Y1,Y2,⋯,Yi) 之间相关关系的统计分析方法。

- 按自变量:一元回归和多元回归

- 按因变量:简单回归和多重回归

- 按函数形式:线性回归和非线性回归

X i X_i Xi 是自变量, Y i Y_i Yi 是取连续值的因变量。

(二)线性回归方程

1、一元线性回归

一元线性回归由大体上有线性关系的一个自变量和一个因变量组成;模型是 Y = a + b x + ε Y=a+ bx +ε Y=a+bx+ε( X X X是自变量, Y Y Y是因变量, ε ε ε是随机误差)。

回归分析的任务就是寻找一条拟合直线,使得所有样本点到该直线的距离之和最小。

2、多元线性回归

如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。

h

(

x

)

=

θ

0

+

θ

1

x

1

+

θ

2

x

2

+

⋯

+

θ

n

x

n

+

ε

i

h(x)=\theta_0+\theta_1x_1+\theta_2x_2+\cdots+\theta_nx_n+\varepsilon_i

h(x)=θ0+θ1x1+θ2x2+⋯+θnxn+εi 令

x

0

=

1

x_0=1

x0=1,则上式可写成

h

θ

(

x

)

=

θ

T

X

=

X

T

θ

h_\theta(x)=\theta^TX=X^T\theta

hθ(x)=θTX=XTθ

θ

=

(

θ

0

θ

1

⋯

θ

n

)

,

X

=

(

x

0

x

1

⋯

x

n

)

\theta=\left(\begin{matrix}\theta_0\\\theta_1\\\cdots\\\theta_n\end{matrix}\right),X=\left(\begin{matrix}x_0\\x_1\\\cdots\\x_n\end{matrix}\right)

θ=

θ0θ1⋯θn

,X=

x0x1⋯xn

θ θ θ称为参数向量,也是要求解的一个量(注意:向量默认是列向量)

多元线性回归方程的直观解释:

三、线性回归模型的损失函数与参数估计

线性回归方程参数的求解:

线性回归分析的目标是求出线性回归方程中参数向量 θ θ θ 的值,这有两种方法。

① 正规解方程法(最小二乘法)

② 梯度下降法

(一)正规解方程法(最小二乘法)

1、线性回归模型方程

假设房屋价格与以下因子(自变量或者特征)存在线性关系,求解预测房屋 m m m 的价格(因变量或者预测量)。

| 面积 | 房间数 | 人口密度 | 房龄 | 价格 |

|---|---|---|---|---|

| 70 | 2 | 50 | 5 | 74.2 |

| 60 | 2 | 60 | 10 | 66.2 |

| 110 | 4 | 70 | 20 | 117.4 |

| 80 | 3 | 40 | 15 | 84.3 |

| 70 | 3 | 30 | 10 | 74.3 |

| 90 | 3 | 60 | 10 | m? |

2、将样本代入线性回归方程

f

(

X

)

f(X)

f(X) 为预测值,也写作

y

^

\hat{y}

y^,

y

y

y 为实际值。

{

f

(

X

)

=

θ

0

+

70

θ

1

+

2

θ

2

+

50

θ

3

+

5

θ

4

f

(

X

)

=

θ

0

+

60

θ

1

+

2

θ

2

+

60

θ

3

+

10

θ

4

f

(

X

)

=

θ

0

+

110

θ

1

+

4

θ

2

+

70

θ

3

+

20

θ

4

f

(

X

)

=

θ

0

+

80

θ

1

+

3

θ

2

+

40

θ

3

+

15

θ

4

f

(

X

)

=

θ

0

+

70

θ

1

+

3

θ

2

+

30

θ

3

+

10

θ

4

\left\{ \begin{array}{l} f(X)=\theta_0+70\theta_1+2\theta_2+50\theta_3+5\theta_4 \\[1ex] f(X)=\theta_0+60\theta_1+2\theta_2+60\theta_3+10\theta_4 \\[1ex] f(X)=\theta_0+110\theta_1+4\theta_2+70\theta_3+20\theta_4 \\[1ex] f(X)=\theta_0+80\theta_1+3\theta_2+40\theta_3+15\theta_4 \\[1ex] f(X)=\theta_0+70\theta_1+3\theta_2+30\theta_3+10\theta_4 \end{array} \right.

⎩

⎨

⎧f(X)=θ0+70θ1+2θ2+50θ3+5θ4f(X)=θ0+60θ1+2θ2+60θ3+10θ4f(X)=θ0+110θ1+4θ2+70θ3+20θ4f(X)=θ0+80θ1+3θ2+40θ3+15θ4f(X)=θ0+70θ1+3θ2+30θ3+10θ4

X

b

⋅

θ

=

[

1

X

1

(

1

)

X

2

(

1

)

⋯

X

n

(

1

)

1

X

1

(

2

)

X

2

(

2

)

⋯

X

n

(

2

)

⋯

⋯

1

X

1

(

m

)

X

2

(

m

)

⋯

X

n

(

m

)

]

⋅

[

θ

0

θ

1

θ

2

⋯

θ

n

]

=

f

(

X

)

X_b\cdot\theta=\left[ \begin{matrix} 1 & X_1^{(1)} & X_2^{(1)} & \cdots & X_n^{(1)} \\[1ex] 1 & X_1^{(2)} & X_2^{(2)} & \cdots & X_n^{(2)} \\[1ex] \cdots & & & & \cdots \\[1ex] 1 & X_1^{(m)} & X_2^{(m)} & \cdots & X_n^{(m)} \end{matrix} \right] \cdot\left[ \begin{matrix} \theta_0 \\[1ex] \theta_1 \\[1ex] \theta_2 \\[1ex] \cdots \\[1ex] \theta_n \end{matrix} \right] =f(X)

Xb⋅θ=

11⋯1X1(1)X1(2)X1(m)X2(1)X2(2)X2(m)⋯⋯⋯Xn(1)Xn(2)⋯Xn(m)

⋅

θ0θ1θ2⋯θn

=f(X)

- m m m 个样本(上标)

- n n n 个特征(下标)

- X X X: ( m , n + 1 ) (m,n+1) (m,n+1) 特征矩阵

- θ \theta θ:权重向量/系数向量

3、线性回归的损失函数

4、线性回归参数估计

目标:找到 θ 0 , θ 1 , θ 2 , ⋯ , θ n \theta_0,\theta_1,\theta_2,\cdots,\theta_n θ0,θ1,θ2,⋯,θn,使得平方损失函数 ∑ i = 1 m ( y ( i ) − y ^ ( i ) ) 2 \sum_{i=1}^m(y^{(i)}-\hat{y}^{(i)})^2 i=1∑m(y(i)−y^(i))2 尽可能小。 其中 y ^ ( i ) = θ 0 + θ 1 X 1 ( i ) + θ 2 X 2 ( i ) + . . . + θ n X n ( i ) \hat{y}^{(i)}=\theta_0+\theta_1X_1^{(i)}+\theta_2X_2^{(i)}+...+\theta_nX_n^{(i)} y^(i)=θ0+θ1X1(i)+θ2X2(i)+...+θnXn(i)

5、补充:均方误差(MSE)函数

在线性回归中使用的损失函数是“平方损失函数” (quadratic loss function) L ( Y , f ( X ) ) = ( Y − f ( X ) ) 2 L(Y,f(X))=(Y-f(X))^2 L(Y,f(X))=(Y−f(X))2 即 E ( ω , b ) = ∑ i = 1 m ( y i − ω x i − b ) 2 E_{(\omega,b)}=\sum_{i=1}^m(y_i-\omega x_i-b)^2 E(ω,b)=i=1∑m(yi−ωxi−b)2

但是在计算的时候,常常多出一个2,并且表示成平均损失的形式:

L

o

s

s

(

ω

,

b

)

=

E

(

ω

,

b

)

=

1

2

m

∑

i

=

1

m

(

f

(

x

i

)

−

y

i

)

2

=

1

2

m

∑

i

=

1

m

(

y

i

−

ω

x

i

−

b

)

2

\begin{aligned} Loss(\omega,b)=E_{(\omega,b)}&=\frac{1}{2m}\sum_{i=1}^m(f(x_i)-y_i)^2\\ &=\frac{1}{2m}\sum_{i=1}^m(y_i-\omega x_i-b)^2 \end{aligned}

Loss(ω,b)=E(ω,b)=2m1i=1∑m(f(xi)−yi)2=2m1i=1∑m(yi−ωxi−b)2

平方损失函数下,样本数越多误差越大;相比于前面的平方损失函数,均方误差函数(mean-square error,MSE)既克服了样本数量的影响,同时它也仅仅是在平方损失函数前面增加了一个常量系数( 1 2 m \frac{1}{2m} 2m1),因此后面通过平方损失函数最小化求解参数的计算过程对它同样适用。

6、损失函数的向量化表示

损失函数 ∑ i = 1 m ( y ( i ) − y ^ ( i ) ) 2 \begin{aligned}\sum_{i=1}^m(y^{(i)}-\hat{y}^{(i)})^2\end{aligned} i=1∑m(y(i)−y^(i))2, y = ( y ( 1 ) ⋯ y ( m ) ) y=\left(\begin{matrix}y^{(1)}\\\cdots\\y^{(m)}\end{matrix}\right) y= y(1)⋯y(m) , y ^ = X b ⋅ θ = ( y ^ ( 1 ) ⋯ y ^ ( m ) ) \hat{y}=X_b\cdot\theta=\left(\begin{matrix}\hat{y}^{(1)}\\\cdots\\\hat{y}^{(m)}\end{matrix}\right) y^=Xb⋅θ= y^(1)⋯y^(m) ,

根据 ∑ p i 2 = P T P \begin{aligned}\sum p_i^2=P^TP\end{aligned} ∑pi2=PTP,进行向量化: ( y − X b ⋅ θ ) T ( y − X b ⋅ θ ) (y-X_b\cdot\theta)^T(y-X_b\cdot\theta) (y−Xb⋅θ)T(y−Xb⋅θ) J ( θ ) = θ T X b T X b θ − 2 ( X b θ ) T y + y T y J(\theta)=\boxed{\theta^TX_b^TX_b\theta}-\boxed{2(X_b\theta)^Ty}+y^Ty J(θ)=θTXbTXbθ−2(Xbθ)Ty+yTy

对 θ \theta θ 求偏导,并令其等于0: 2 X b T X b θ − 2 X T y = 0 2X_b^TX_b\theta-2X^Ty=0 2XbTXbθ−2XTy=0 X b T X b θ = X b T y X_b^TX_b\theta=X_b^Ty XbTXbθ=XbTy θ = ( X b T X b ) − 1 X b T y \theta=(X_b^TX_b)^{-1}X_b^Ty θ=(XbTXb)−1XbTy

参数 θ θ θ 的推导过程:

当 X b T X b X_b^TX_b XbTXb 可逆时,上述解称为线性回归权系数向量的最小二乘解(基于均分误差/平方误差最小化)。上面两个黑色框的求导结果是根据下面两条函数对向量和矩阵的求导规则:

- 当 A A A 是实对称矩阵时,有 ∂ ( a T A x ) ∂ x = 2 A x \begin{aligned}\frac{\partial (a^TAx)}{\partial x}=2Ax\end{aligned} ∂x∂(aTAx)=2Ax

- ∂ ( a T x ) ∂ x = ∂ ( x T a ) ∂ x = a \begin{aligned}\frac{\partial (a^Tx)}{\partial x}=\frac{\partial (x^Ta)}{\partial x}=a\end{aligned} ∂x∂(aTx)=∂x∂(xTa)=a

7、最小二乘解的缺点

- 当 X b T X b X_b^TX_b XbTXb 不可逆时无法求解;

- 即使可逆,逆矩阵求解可能计算很复杂;

- 求得的权系数向量 θ \theta θ 可能不稳定,即样本数据的微小变化可能导致 θ \theta θ 的巨大变化,从而使得回归模型不稳定,缺乏泛化能力。

(二)梯度下降法

1、基本概念

梯度下降(Gradient Descent)法适合特征个数多、样本数多、其他方法内存无法满足要求的情况下使用。

梯度下降算法是一种求局部最优解的数值计算方法,该方法的整体思路是通过迭代来逐渐调整参数使得损失函数达到最小值。

2、基本思想

目标:找到 θ 0 , θ 1 , θ 2 , ⋯ , θ n \theta_0,\theta_1,\theta_2,\cdots,\theta_n θ0,θ1,θ2,⋯,θn,使得损失函数 ∑ i = 1 m ( y ( i ) − y ^ ( i ) ) 2 \begin{aligned}\sum_{i=1}^m(y^{(i)}-\hat{y}^{(i)})^2\end{aligned} i=1∑m(y(i)−y^(i))2 尽可能小。

比如我们在一座大山上的某处位置,由于我们不知道怎么下山,于是决定走一步算一步,也就是在每走到一个位置的时候,求解当前位置的梯度,沿着梯度的负方向,也就是当前最陡峭的位置向下走一步,然后继续求解当前位置梯度,向这一步所在位置沿着最陡峭最易下山的位置走一步。 这样一步步的走下去,一直走到觉得我们已经到了山脚。当然这样走下去,有可能我们不能走到山脚,而是到了某一个局部的山峰低处。

3、梯度下降法举例

梯度下降法举例(1):

损失函数: J ( θ ) = θ 2 J(\theta)=\theta^2 J(θ)=θ2

对 θ θ θ 求导: J ′ ( θ ) = 2 θ J'(θ)=2θ J′(θ)=2θ

设: θ 0 = 1 θ^0=1 θ0=1 步长: α = 0.4 \alpha=0.4 α=0.4

θ 0 = 1 θ^0=1 θ0=1

θ 1 = θ 0 − α ⋅ J ′ ( θ 0 ) = 1 − 0.4 × 2 = 0.2 θ^1=θ^0-α\cdot J'(θ^0)=1-0.4\times2=0.2 θ1=θ0−α⋅J′(θ0)=1−0.4×2=0.2

θ 2 = θ 1 − α ⋅ J ′ ( θ 1 ) = 0.2 − 0.4 × 0.4 = 0.04 θ^2=θ^1-α\cdot J'(θ^1)=0.2-0.4\times0.4=0.04 θ2=θ1−α⋅J′(θ1)=0.2−0.4×0.4=0.04

θ 3 = θ 2 − α ⋅ J ′ ( θ 2 ) = 0.04 − 0.4 × 0.08 = 0.008 θ^3=θ^2-α\cdot J'(θ^2)=0.04-0.4\times0.08=0.008 θ3=θ2−α⋅J′(θ2)=0.04−0.4×0.08=0.008

θ 4 = θ 3 − α ⋅ J ′ ( θ 3 ) = 0.008 − 0.4 × 0.016 = 0.0016 θ^4=θ^3-α\cdot J'(θ^3)=0.008-0.4\times0.016=0.0016 θ4=θ3−α⋅J′(θ3)=0.008−0.4×0.016=0.0016

梯度下降法举例(2):

J

(

θ

)

=

θ

1

2

+

θ

2

2

J(θ)=θ_1^2+θ_2^2

J(θ)=θ12+θ22

θ 0 = ( 1 , 3 ) θ^0=(1,3) θ0=(1,3) α = 0.1 \alpha=0.1 α=0.1

∇ J ( θ ) = ⟨ 2 θ 1 , 2 θ 2 ⟩ \nabla J(θ)=\langle2θ_1,2θ_2\rangle ∇J(θ)=⟨2θ1,2θ2⟩

θ 0 = ( 1 , 3 ) θ^0=(1,3) θ0=(1,3)

θ 1 = θ 0 − α ⋅ ∇ J ( θ ) = ( 1 , 3 ) − 0.1 ⋅ ( 2 , 6 ) = ( 0.8 , 2.4 ) θ^1=θ^0-\alpha\cdot\nabla J(θ)=(1,3)-0.1\cdot(2,6)=(0.8,2.4) θ1=θ0−α⋅∇J(θ)=(1,3)−0.1⋅(2,6)=(0.8,2.4)

θ 2 = θ 1 − α ⋅ ∇ J ( θ ) = ( 0.8 , 2.4 ) − 0.1 ⋅ ( 1.6 , 4.8 ) = ( 0.64 , 1.92 ) θ^2=θ^1-\alpha\cdot\nabla J(θ)=(0.8,2.4)-0.1\cdot(1.6,4.8)=(0.64,1.92) θ2=θ1−α⋅∇J(θ)=(0.8,2.4)−0.1⋅(1.6,4.8)=(0.64,1.92)

θ 3 = ( 0.5124 , 1.536 ) θ^3=(0.5124,1.536) θ3=(0.5124,1.536)

θ

4

=

(

0.4096

,

1.228800000000001

)

θ^4=(0.4096,1.228800000000001)

θ4=(0.4096,1.228800000000001)

⋮

\vdots

⋮

θ

10

=

(

0.1073741824000003

,

0.32212254720000005

)

θ^{10}=(0.1073741824000003,0.32212254720000005)

θ10=(0.1073741824000003,0.32212254720000005)

⋮

\vdots

⋮

θ

50

=

(

1.141798154164342

e

−

05

,

3.42539442494306

e

−

05

)

θ^{50}=(1.141798154164342e^{-05},3.42539442494306e^{-05})

θ50=(1.141798154164342e−05,3.42539442494306e−05)

⋮

\vdots

⋮

θ

100

=

(

1.6296287810675902

e

−

10

,

4.8888886343202771

e

−

10

)

θ^{100}=(1.6296287810675902e^{-10},4.8888886343202771e^{-10})

θ100=(1.6296287810675902e−10,4.8888886343202771e−10)

4、梯度下降法的步骤

(1)确定当前位置的损失函数的梯度 ∂ ∂ θ i J ( θ 0 , θ 1 , . . . , θ n ) \begin{aligned}\frac{\partial}{\partial\theta_i}J(θ_0,θ_1,...,θ_n)\end{aligned} ∂θi∂J(θ0,θ1,...,θn)

(2)用步长 α \alpha α 乘以损失函数的梯度,得到当前位置下降的距离 α ∂ ∂ θ i J ( θ 0 , θ 1 , . . . , θ n ) \begin{aligned}\alpha\frac{\partial}{\partial\theta_i}J(θ_0,θ_1,...,θ_n)\end{aligned} α∂θi∂J(θ0,θ1,...,θn)

(3)确定是否所有的 θ i θ_i θi,梯度下降的距离都小于 ε ε ε,如果小于 ε ε ε 则算法终止,当前所有的 θ i θ_i θi 即为最终结果。否则进入步骤(4)。

(4)更新所有的 θ i θ_i θi, θ i θ_i θi 的更新表达式如下。更新完毕后继续转入步骤(1)。 θ i = θ i − α ∂ ∂ θ i J ( θ 0 , θ 1 , . . . , θ n ) θ_i=θ_i-\begin{aligned}\alpha\frac{\partial}{\partial\theta_i}J(θ_0,θ_1,...,θ_n)\end{aligned} θi=θi−α∂θi∂J(θ0,θ1,...,θn)

5、步长过大或过小的情况

6、梯度下降法的种类

- 批量梯度下降法BGD:在更新参数时使用所有的样本来进行更新

- 随机梯度下降法SGD:仅仅选取一个样本 j j j 来求梯度

- 小批量梯度下降法MBGD:对于 m m m 个样本,抽取其中 x x x 个子样本来迭代

7、模型评价

R

2

R^2

R2为0时,模型最差;

R

2

R^2

R2为1时,模型最好;

R

2

R^2

R2越大,模型越好。

训练集上的 R 2 R^2 R2:拟合程度好;测试集上的 R 2 R^2 R2:泛化能力强。

四、线性回归的正则化

(一)正则化线性回归

为防止过拟合,引入了正则化(regularization)技术,就是在原来损失函数的后面加上一个关于模型系数的正则化项:

直观理解,因为正则化项的存在,当新的目标函数

J

(

ω

)

J(\omega)

J(ω) 取得最小值时,

L

(

ω

)

L(\omega)

L(ω) 也不至于因为过小而产生过拟合。

正则化项可以理解成对模型参数的一种惩罚,在最小化误差的同时,使得模型参数变得更小(模型参数越小,甚至趋向于0,将降低模型复杂度,防止过拟合)。

(二) l 2 l_2 l2正则化与岭回归

在原来线性回归的均方误差后面增加

l

2

l_2

l2 范数做正则项,就是岭回归(ridge regression):

J

(

ω

)

=

1

2

m

∑

i

=

1

m

(

f

(

ω

,

x

i

)

−

y

i

)

2

+

α

2

∥

ω

∥

2

2

J(\omega)=\frac{1}{2m}\sum_{i=1}^m(f(\omega,x_i)-y_i)^2+\frac{\alpha}{2}\lVert\omega\rVert_2^2

J(ω)=2m1i=1∑m(f(ω,xi)−yi)2+2α∥ω∥22

ω

∗

=

a

r

g

m

i

n

J

(

ω

)

\omega^*=argminJ(\omega)

ω∗=argminJ(ω) 其中

∥

ω

∥

2

2

=

ω

0

2

+

ω

1

2

+

.

.

.

+

ω

n

2

\lVert\omega\rVert_2^2=\omega_0^2+\omega_1^2+...+\omega_n^2

∥ω∥22=ω02+ω12+...+ωn2。

岭回归求得的权重系数虽然都比较小,接近于0但不等于0,说明它是比较均衡的对待多个特征。

(三) l 1 l_1 l1正则化与 L a s s o Lasso Lasso回归

在原来线性回归的均方误差后面增加 l 1 l_1 l1 范数做正则项,就是稀疏线性回归(Lasso regression):

J ( ω ) = 1 2 m ∑ i = 1 m ( f ( ω , x i ) − y i ) 2 + α 2 ∥ ω ∥ 1 J(\omega)=\frac{1}{2m}\sum_{i=1}^m(f(\omega,x_i)-y_i)^2+\frac{\alpha}{2}\lVert\omega\rVert_1 J(ω)=2m1i=1∑m(f(ω,xi)−yi)2+2α∥ω∥1 ω ∗ = a r g m i n J ( ω ) \omega^*=argminJ(\omega) ω∗=argminJ(ω) 其中 ∥ ω ∥ 1 = ∣ ω 0 ∣ + ∣ ω 1 ∣ + . . . + ∣ ω n ∣ \lVert\omega\rVert_1=|\omega_0|+|\omega_1|+...+|\omega_n| ∥ω∥1=∣ω0∣+∣ω1∣+...+∣ωn∣。

L a s s o Lasso Lasso回归求得的权重系数多数都为0,体现出稀疏性,说明它具有特征选择的能力。

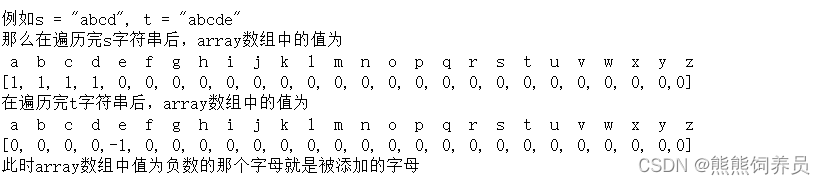

(四)比较 l 1 l_1 l1与 l 2 l_2 l2正则化

超参数𝛼既不能过大也不能太小:𝛼过大,使得正则项的作用加强,会削弱拟合效果𝛼过小,惩罚力度不够,防止过拟合效果不明显。

![[qnx] 通过zcu104 SD卡更新qnx镜像的步骤](https://img-blog.csdnimg.cn/direct/c7eb82c8f7d84fc0ae73e83b0dee9ac0.png)