目录:

- 1. 某瓣电影top250首页电影信息的获取!

- 1.创建项目:

- 2.创建爬虫文件:

- 3.运行爬虫文件:

- 4.设置请求头:

- 5.获取到电影名字:

- 5.1 使用shell交互式平台:

- 5.1.1 首先:打开我们的shell交互式平台。

- 5.2.2 第二步:在shell交互式平台中匹配我们所需的电影数据。

- 5.2.3 第三步:从selector对象中提取电影名字

- 6.将获取到的电影的信息存储到text文本中

- 6.1 首先:操作items.py文件

- 6.2 第二步:在爬虫文件中操作数据,使其与管道建立桥梁

- 6.3 第三步:我们要将数据提交给管道,所以需要打开管道

- 6.4 第四步:现在数据已经可以交给管道,那么管道就要对数据进行处理

- 7.实现效果:

1. 某瓣电影top250首页电影信息的获取!

1.创建项目:

scrapy startproject douban

2.创建爬虫文件:

scrapy genspider db www.summer.com

(注意:这个域名是可以随便写的【但是必须要写哦!】,等爬虫文件生成之后再更改为我们所需的即可!)

# -*- coding: utf-8 -*-

import scrapy

class DbSpider(scrapy.Spider):

name = 'db'

allowed_domains = ['评论区有']

start_urls = ['评论区有']

def parse(self, response):

print("*********")

print("*********")

print("*********")

print("*********")

print("*********")

print(response.text)

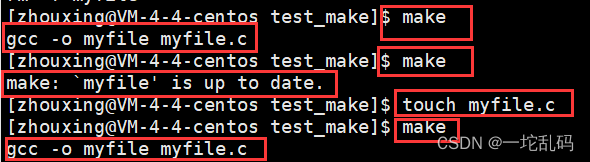

3.运行爬虫文件:

scrapy crawl db

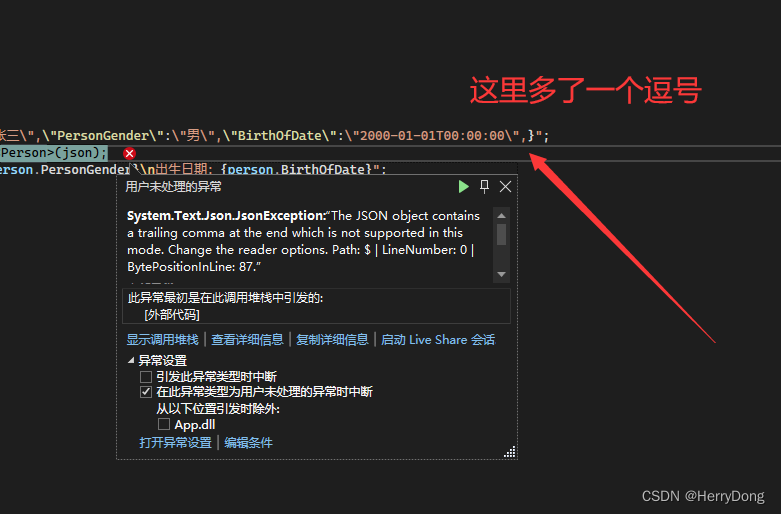

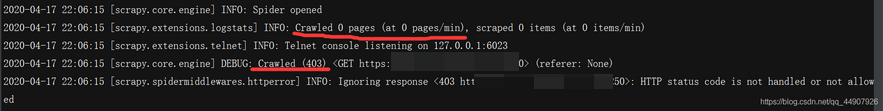

但是,我们运行之后发现又没有获取到数据哎!

造成这样的原因是:回想爬虫的基础,我们如果直接这样向网页发送请求进行爬取,那服务端一眼就看到咱是scrapy了,它还会理咱嘛?所以我们要设置请求头!

4.设置请求头:

在配置文件settings.py中找到如下代码取消注释并加入爬取网页请求头的User-Agent即可!

5.获取到电影名字:

到现在,我们运行爬虫文件,Scrapy框架已经可以获取到网页的首页数据。那么,我们如何筛选出我们想要的电影的名字呢?

考虑到我们如果利用xpath匹配,可能要多次尝试才能正确匹配到,那就需要我们一次又一次的运行咱的项目,多麻烦啊!咱都这样想了,人家大牛也这样想啊,所以,在这里有个贼帅贼帅的牛皮的方法:

5.1 使用shell交互式平台:

(注意1:它是遵循settings设置的;2:一定要到咱的项目文件夹下运行)

具体操作步骤如下:

- 首先:cd到我们项目的文件路径下。

- 然后:输入命令scrapy shell url (start_urls) 即可!

这样:它其实就请求到了此url的数据(跟上面运行爬虫文件得到的数据一模一样)!!!

5.1.1 首先:打开我们的shell交互式平台。

- 在此项目的terminal中:输入命令

scrapy shell 评论区的start urls

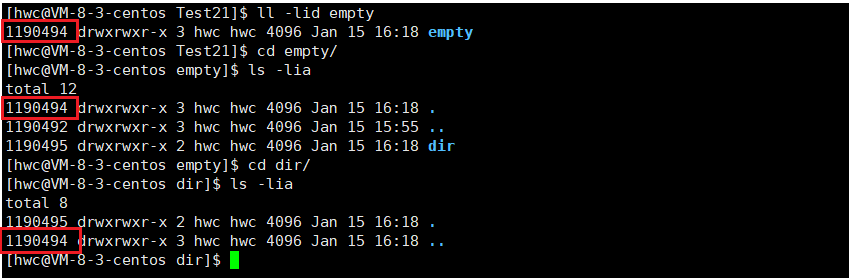

5.2.2 第二步:在shell交互式平台中匹配我们所需的电影数据。

- 输入:

response.xpath('//div[@class="info"]/div/a/span[1]/text()')

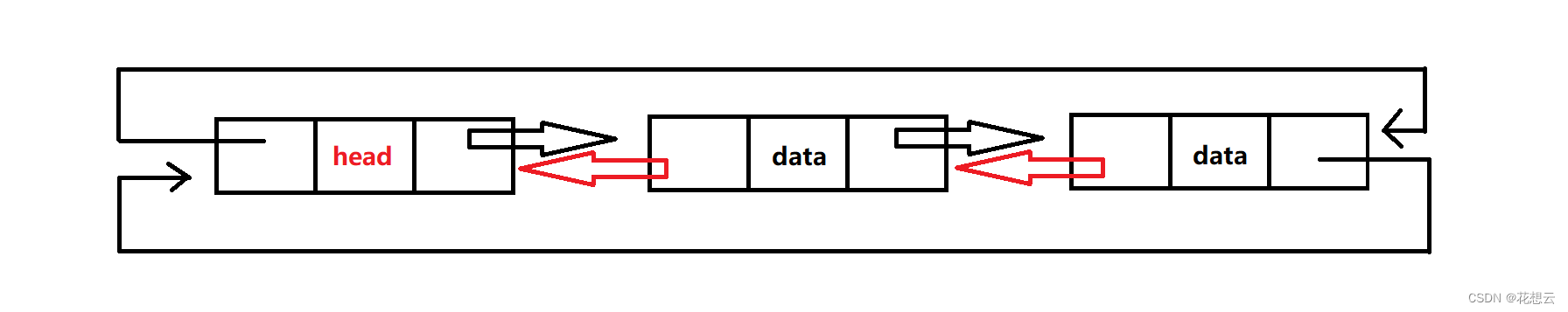

会发现:这得到的是一个selector对象!

而我们得到的数据就是用的response对象自带的xpath匹配到的(生成了response之后就会自动生成selector对象)!

与我们正常用的xpath不同,它获取到的数据在selector对象里,如上图:

5.2.3 第三步:从selector对象中提取电影名字

使用selector对象的方法.extract()。这个方法可以提取到selector对象中data对应的数据。

response.xpath('//div[@class="info"]/div/a/span[1]/text()').extract()

6.将获取到的电影的信息存储到text文本中

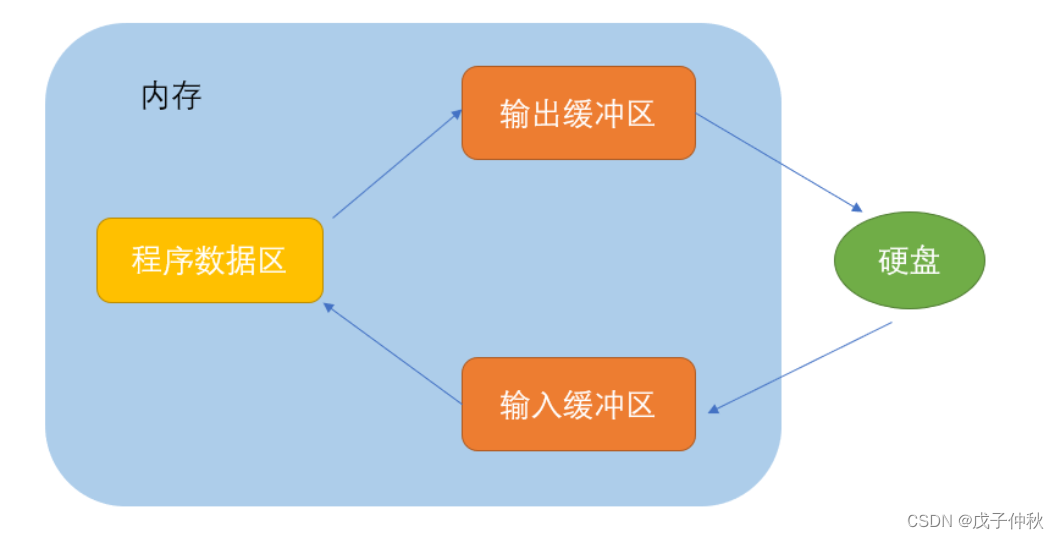

注意:如果想要存储数据,就要用到管道。

这就涉及到了items.py文件(定义结构化数据字段)和pipelines.py文件(管道文件)。

6.1 首先:操作items.py文件

-

因为我们只需要存储一个信息,所以定义一个字段名即可!

-

定义公共输出数据格式,Scrapy提供了Item类。Item对象是用于收集剪贴数据的简单容器。它们提供了一个类似词典的API,提供了一种方便的语法来声明它们的可用字段。 scray.Item对象是用于收集抓取数据的简单容器,使用方法和python的字典类似。编辑项目目录下items.py文件。

-

然后我们只需要在爬虫中导入我们定义的Item类,实例化后用它进行数据结构化。

# -*- coding: utf-8 -*-

# Define here the models for your scraped items

#

# See documentation in:

# https://docs.scrapy.org/en/latest/topics/items.html

import scrapy

class DoubanItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

#需要定义字段名 就像数据库那样,有字段名,才能插入数据(即存储数据)

# Field代表的是字符串类型!!!

films_name=scrapy.Field() #定义字段名

6.2 第二步:在爬虫文件中操作数据,使其与管道建立桥梁

到目前为止,我们通过scrapy写出的爬虫还看不出优越性在哪里,并且上面的爬虫还有个很严重的问题,就是对文件的操作。每次调用parse方法会打开文件关闭文件,这极大的浪费了资源。parse函数在解析出我们需要的信息之后,可以将这些信息打包成一个字典对象或scray.Item对象(一般都是item对象),然后返回。这个对象会被发送到item管道,该管道会通过顺序执行几个组件处理它。每个item管道组件是一个实现简单方法的Python类。他们收到一个item并对其执行操作,同时决定该item是否应该继续通过管道或者被丢弃并且不再处理。

item管道的典型用途是:

- 清理HTML数据

- 验证已删除的数据(检查项目是否包含某些字段)

- 检查重复项(并删除它们)

- 将已爬取的item进行数据持久化

# -*- coding: utf-8 -*-

import scrapy

from ..items import DoubanItem #因为我们要使用包含定义字段名的类,所以需要导入

class DbSpider(scrapy.Spider):

name = 'db'

allowed_domains = ['评论区']

start_urls = ['评论区']

def parse(self, response):

# 获取电影信息数据

films1_name=response.xpath('//div[@class="info"]/div/a/span[1]/text()').extract()

# 交给管道存储

# 使用DoubanItem

item=DoubanItem() #创建对象

item["films_name"]=films1_name #值是个列表,因为xpath匹配到的数据都扔到列表里了!

# item可以理解为一个安全的字典 用法与字典相同

print("item里面是:",dict(item)) #可以转换为字典

return item #交给引擎 引擎要交给管道,需要打开管道

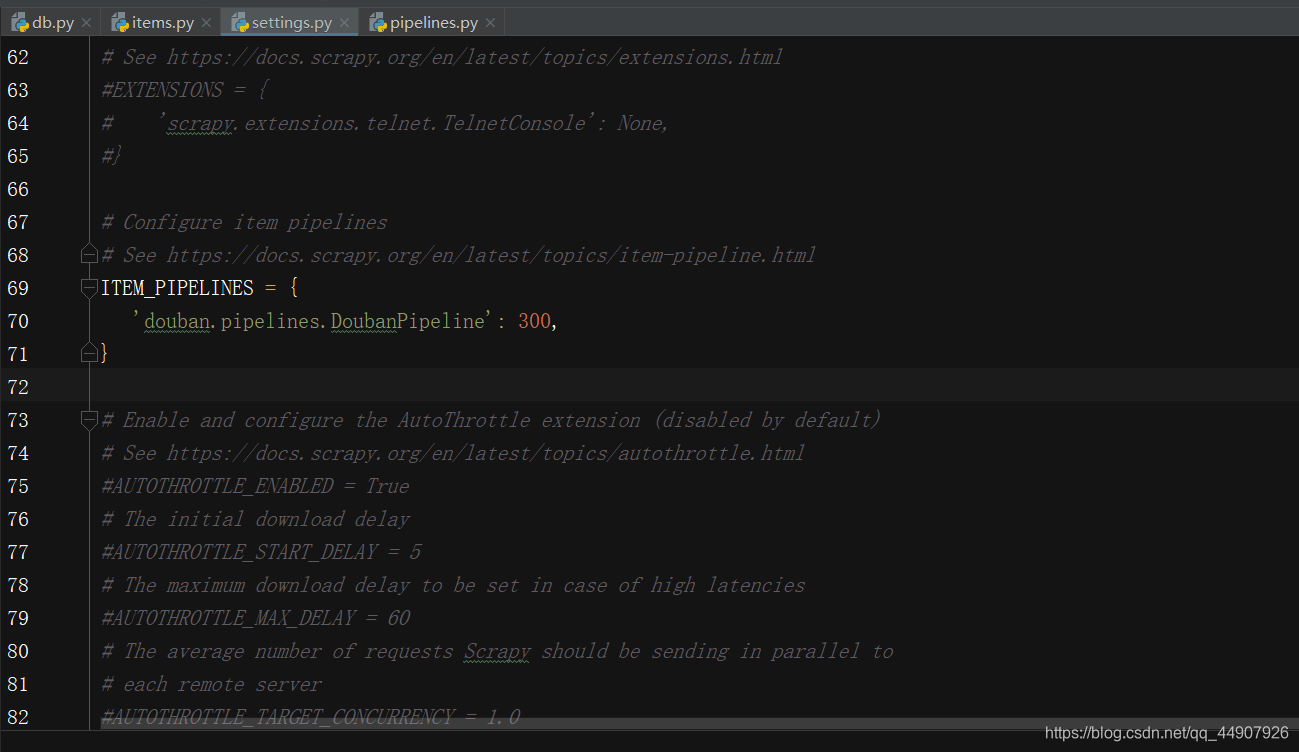

6.3 第三步:我们要将数据提交给管道,所以需要打开管道

- 要激活这个管道组件,必须将其添加到ITEM_PIPELINES设置中,在settings.py文件中:

(在此设置中为类分配的整数值决定了它们运行的顺序:按照从较低值到较高值的顺序进行。

注意:这个管道的目的只是介绍如何编写项目管道,如果要将所有爬取的item存储到json文件中,则应使用Feed导出,在运行爬虫时加上如下参数:

scrapy crawl bd -o films.json)

6.4 第四步:现在数据已经可以交给管道,那么管道就要对数据进行处理

就是操作pipelines.py文件

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://docs.scrapy.org/en/latest/topics/item-pipeline.html

import json

class DoubanPipeline(object):

def process_item(self, item, spider):

#为了能写进text json.dumps将dic数据转换为str

json_str=json.dumps(dict(item),ensure_ascii=False)

with open("films.text","w",encoding="utf-8") as f:

f.write(json_str)

return item

7.实现效果: