文章目录

- 前言

-

- 理解SVM

-

- 核心概念

- SVM的优势

- SVM的劣势

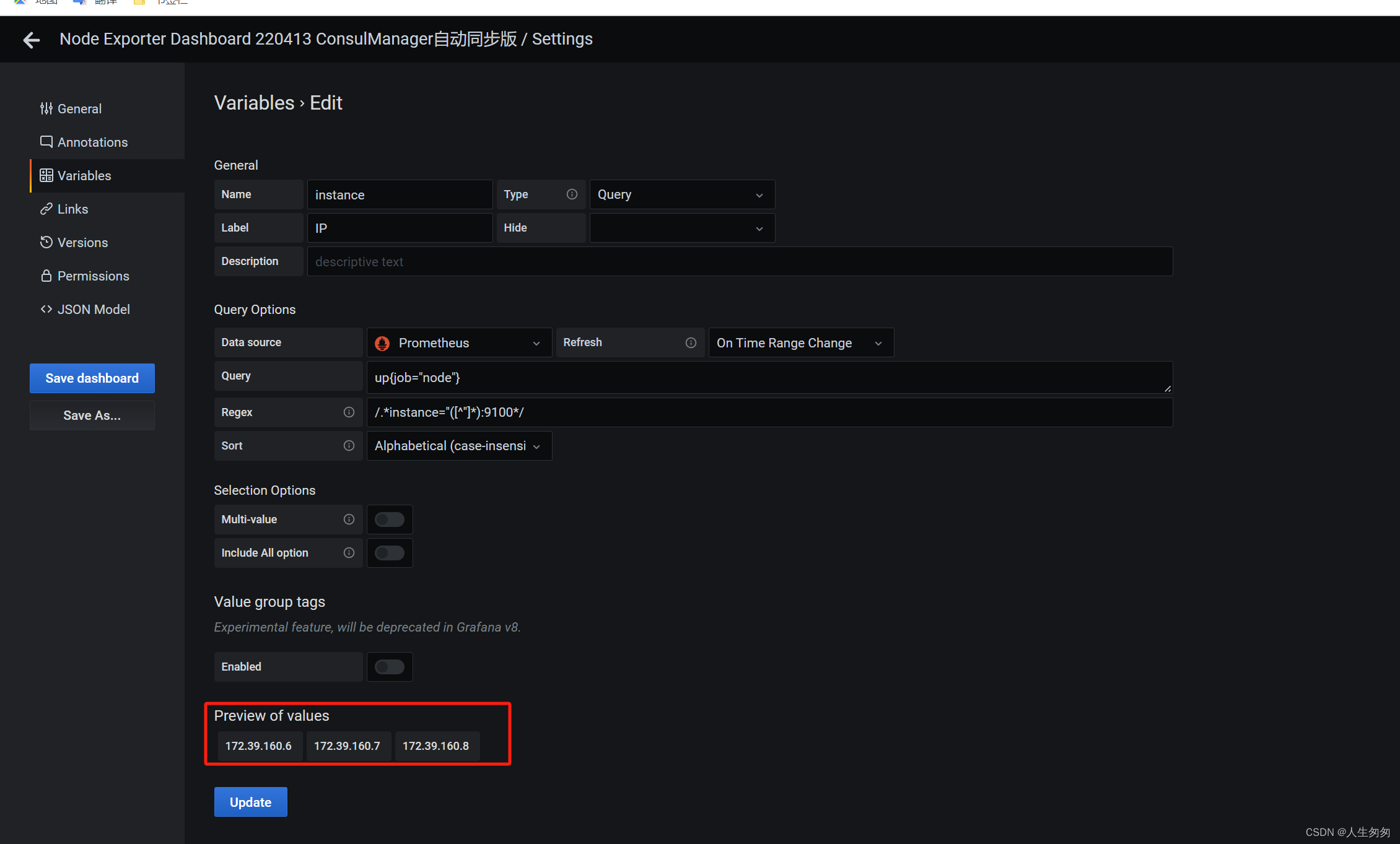

- Scikit-learn中的SVM实现

-

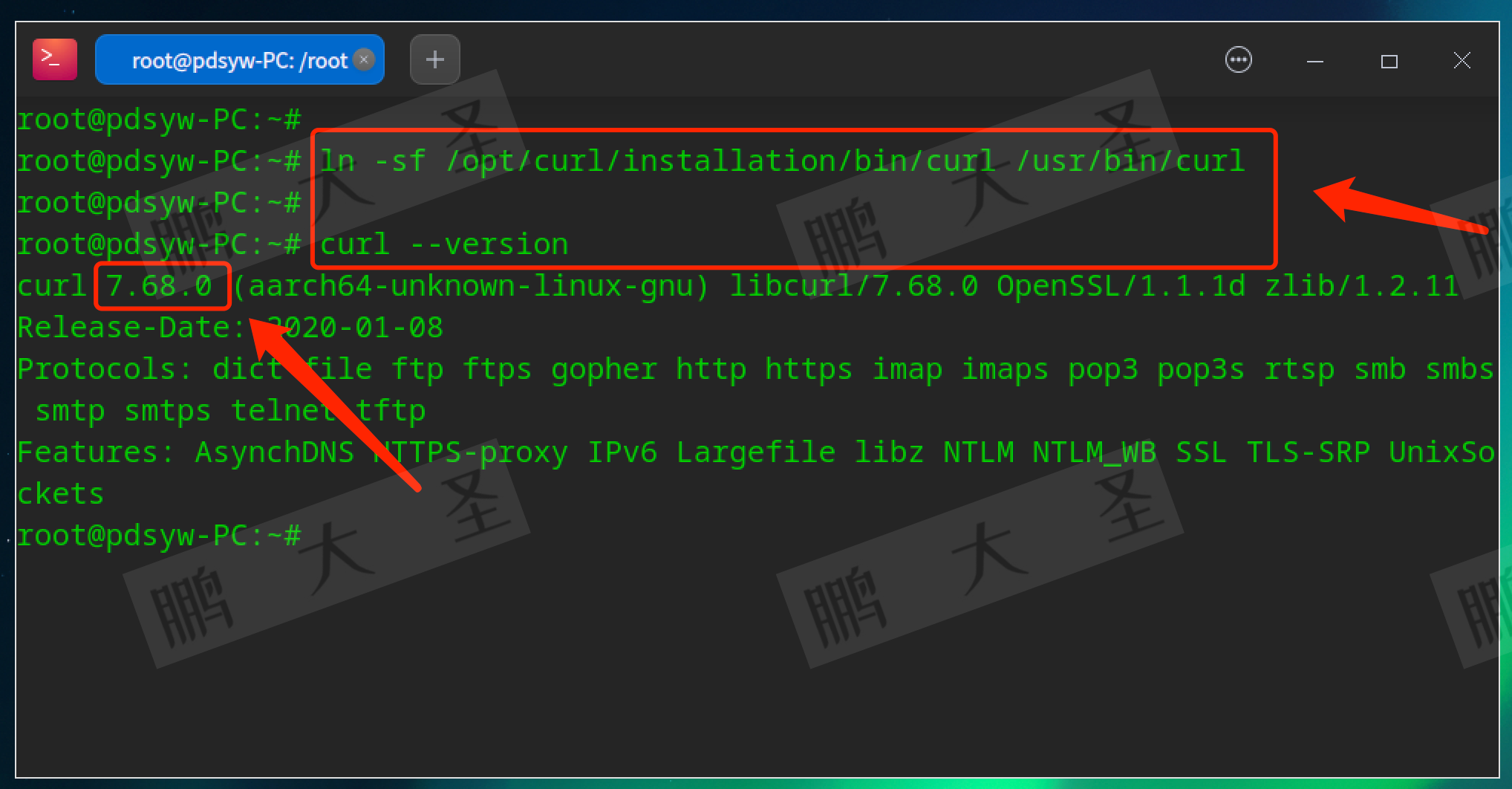

- 安装与导入

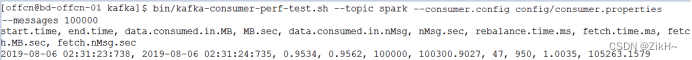

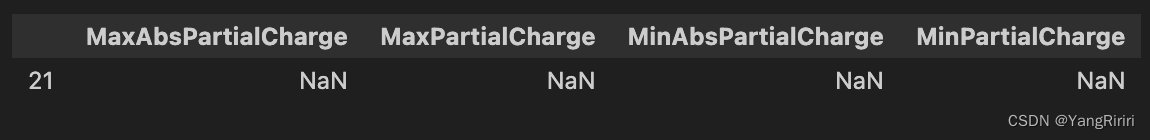

- 数据准备

- SVM分类

- SVM回归

- 调优与最佳实践

- 总结

前言

支持向量机(SVM)是一种强大的机器学习算法,用于解决分类、回归和异常检测问题。它的核心思想是找到一个最优超平面,使得不同类别之间的边界最大化。本文将介绍如何使用Scikit-learn在Python中实现SVM,并逐步讲解其在分类和回归任务中的应用。

理解SVM

核心概念

- 支持向量:数据集中距离最优超平面最近的数据点,它们直接影响超平面的位置和方向。

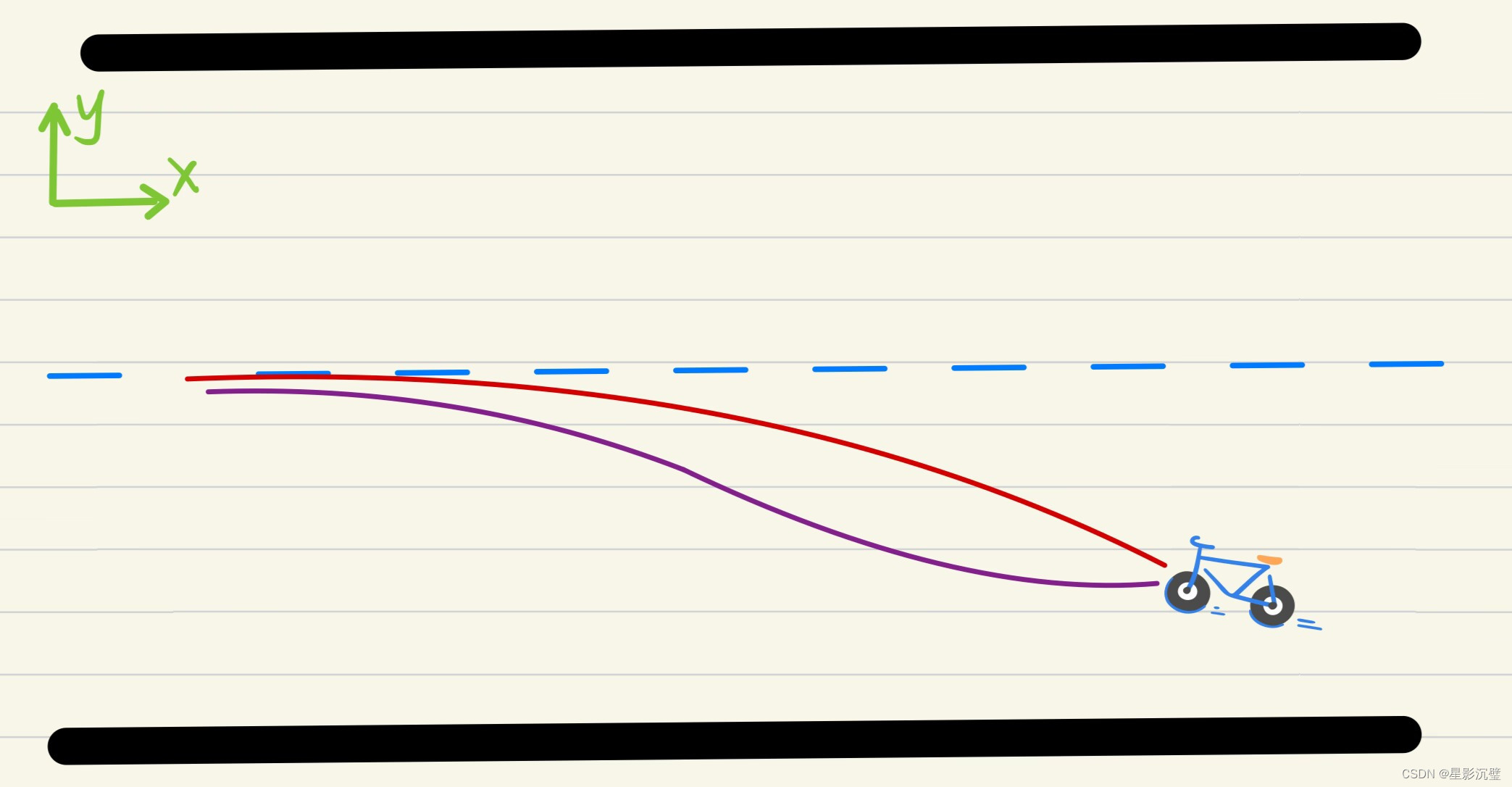

- 超平面:在n维空间中,超平面是一个将数据分割开的n-1维的平面,用于分类或回归分析。

- 间隔:超平面与支持向量之间的距离,SVM算法的目标就是最大化这个间隔。

- 核函数:用于在高维空间中找到最优超平面的技巧,常见的有线性核、多项式核和径向基函数(RBF)核。

SVM的优势

- 效果好:尤其在数据维度高的情况下,SVM经常能提供良好的结果。

- 泛化能力强:通过最大化间隔来控制模型的复杂度,从而避免过拟合。

- 多核技巧:可以通过不同的核函数来处理线性不可分数据。

SVM的劣势

- 参数选择敏感:如核函数的选择、正则化参数C的设定等,对最终结果有很大影响。