传统卷积神经网络,内存需求大、运算量大导致无法在移动设备以及嵌入式设备上运行。模型研究得初衷就是服务于社会,应用到实际生活中,让深度学习技术服务于生活。

万物互联时代,智能终端部署模型到本地,不需连接因特网/云服务器,在边缘终端进行边缘计算。保障数据隐私,不依赖网络,无数据网络和通信延时,进行本地推理实时计算。云端训练模型,将训练的模型部署在终端(端云协同)。

目录

MobileNet概述

DW卷积(Depthwise convolution)

PW卷积(Pointwise Cov)

深度可分离卷积(Depthwise Separable Conv)

MobileNetV1网络模型

嵌入式软硬件设计,部署硬件终端需要注重算力和模型轻量化和加速推理。

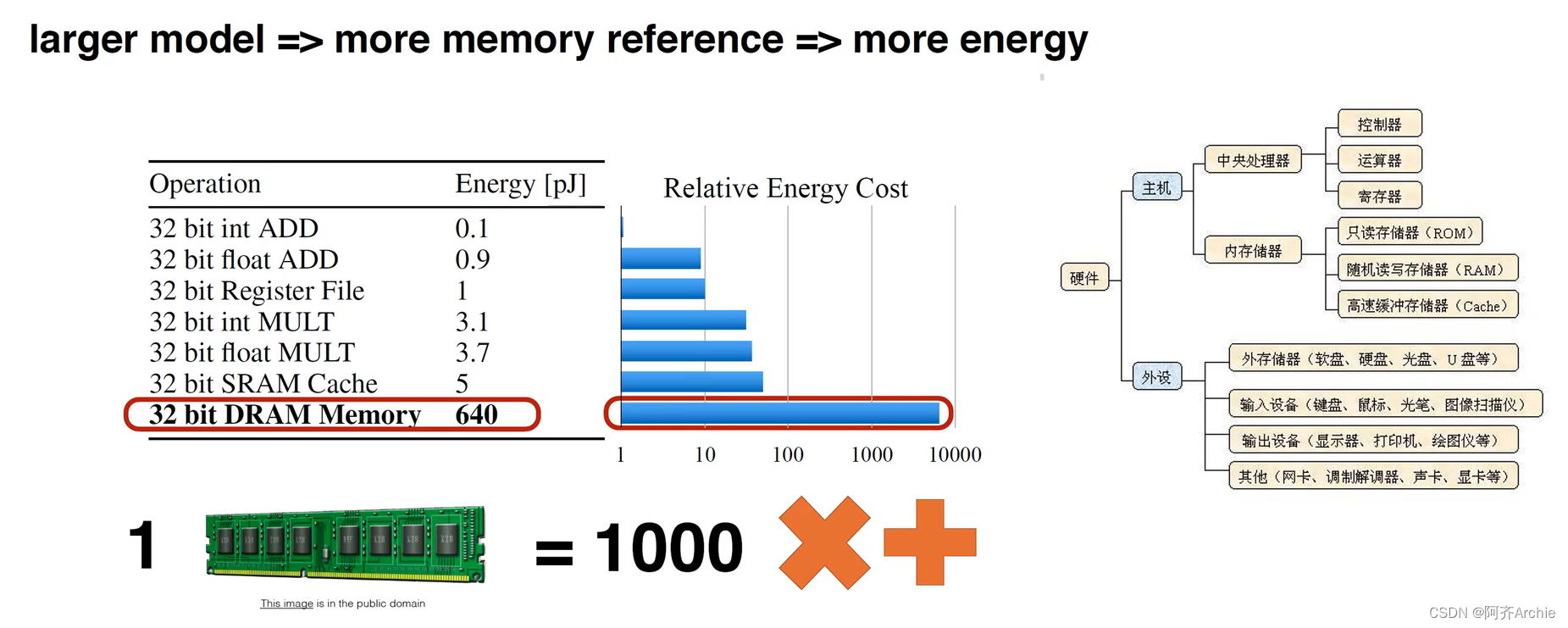

如下图为各种运算在计算机中的运算能耗。例如32bit的整数加法运算是0.1p焦耳,32浮点数是0.9,内存SDRAM是640能耗,内存的读取是非常消耗能量的。

轻量化网络的核心目标就是减少内存的读写(减少参数、权重量、feature map卷积卷积神经网络中间层的输出结果、使内存读写更加规则、加速矩阵运算等来减少内存读写)

MobileNe