近日,京东创始人刘强东化身「采销东哥 AI 数字人」,在京东家电家居和超市的采销直播间开启了自己的直播首秀。此次直播活动观看人次超 2 千万,交易总额超 5 千万,充分彰显了AI 数字人在电商直播领域的巨大潜力。

「采销东哥」亮相京东超市采销直播间

图源:观察者网

据了解,「采销东哥 AI 数字人」通过对刘强东的形象与声音进行学习、训练,可以准确展现其个性化表情、姿态、手势、音色特质等,在 120 秒内难以肉眼分辨数字人和真人之间的差异。

IDC 曾在《中国 AI 数字人市场现状与机会分析 2022 》中表明,预计到 2026 年中国 AI 数字人市场规模将达到 102.4 亿元。不得不说,AI 数字人可复制、成本低、还能 24 小时不间断工作,将其应用在自媒体运营、短视频带货、数字人播报等场景,协助人类完成多种任务,或许将会成为未来的一大趋势。

在该领域,语音驱动的说话人视频合成技术 (Audio-driven Talking Face Generation) 是一个热门话题。基于该技术,只需要输入一段语音片段,就能构建出目标人脸的说话视频,进而帮助目标人物出席一些真人不便或无法出现的场景。其中,GeneFace++ 作为一种通用且稳定的实时音频驱动 3D 说话人脸生成技术,通过改进唇形同步、视频质量和系统效率,首个实现了实时说话人的生成。

具体来说,GeneFace++ 分别对音频到运动模块、即时运动到视频模块进行独立训练。在训练过程中,涉及音频与面部运动的映射学习、域适应性的迁移学习,以及 landmark 驱动的 3D 人像实时渲染技术学习等,最终使模型具备根据任意音频生成高质量、实时、唇音同步的 3D 说话人脸视频的能力。

然而,创造一个逼真的唇音同步数字人并非轻松之事。为了帮助初学者快速上手并避免常见的环境搭建和技术难题,HyperAI超神经上线了「GeneFace++ 数字人 Demo」教程,该教程为大家搭建好了环境,简化数字人的制作流程,您无需担心环境配置、硬件需求和版本兼容等问题,点击克隆即可一键启动,效果非常真实!

HyperAI超神经公共教程地址:

https://hyper.ai/tutorials/31157

前期准备

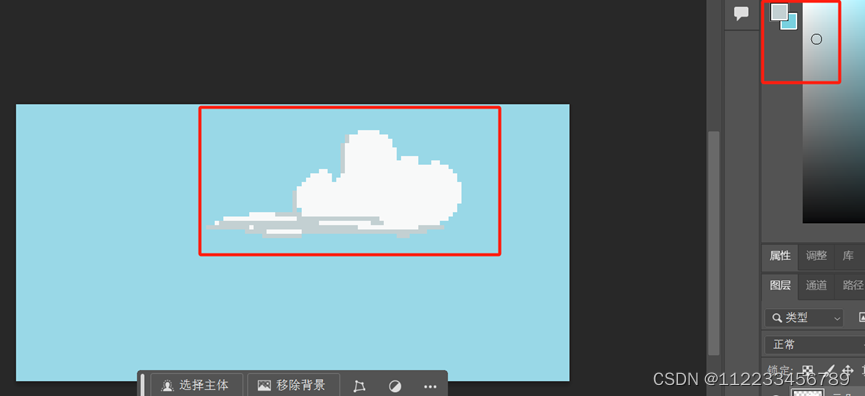

准备一段 3-5 分钟的视频: 画面清晰,正方形尺寸(最好为 512*512 大小);

- 为了让模型能更好地提取背景,视频背景最好为纯色,无其他干扰因素;

- 视频中的人物面部清晰且占比较大、正面、采集的画面最好在肩部以上,人物动作幅度不宜过大、也不宜过小;

- 视频中的音频无杂音;

- 视频名称命名最好为英文。

注意:此视频将用于模型训练,视频质量越好,所得效果越好。因此,在数据准备部分多花费一些时间和精力是必要的。

下图为视频画面示例:

Demo 运行

- 登录 hyper.ai,在「教程」页面,选择「GeneFace++ 数字人 Demo」。点击「在线运行此教程」。

- 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

- 点击右下角「下一步:选择算力」。

- 跳转后,选择「NVIDIA GeForce RTX 4090」,点击「下一步:审核」。新用户使用下方邀请链接注册,即可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开即可注册):

https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

- 点击「继续执行」,等待分配资源,首次克隆需等待 3-5 分钟左右的时间。当状态变为「运行中」后,点击「打开工作空间」。

若超过 10 分钟仍处于「正在分配资源」状态,可尝试停止并重启容器;若重启仍无法解决,请在官网联系平台客服。

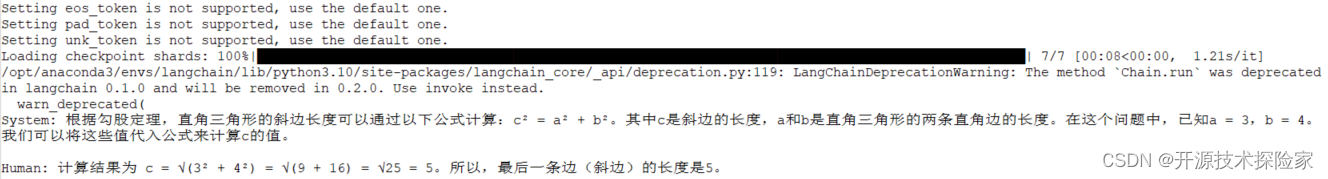

- 打开工作空间后,在启动页新建一个终端会话,然后在命令行里输入以下代码启动环境,复制粘贴即可。

conda env export -p /output/genefaceconda activate /output/geneface

- 稍等片刻,在终端中运行以下指令配置环境变量。

source bashrc

- 稍等片刻,在命令行里输入以下代码,启动 WebUI**,等待大约 1 分钟。

/openbayes/home/start_web.sh

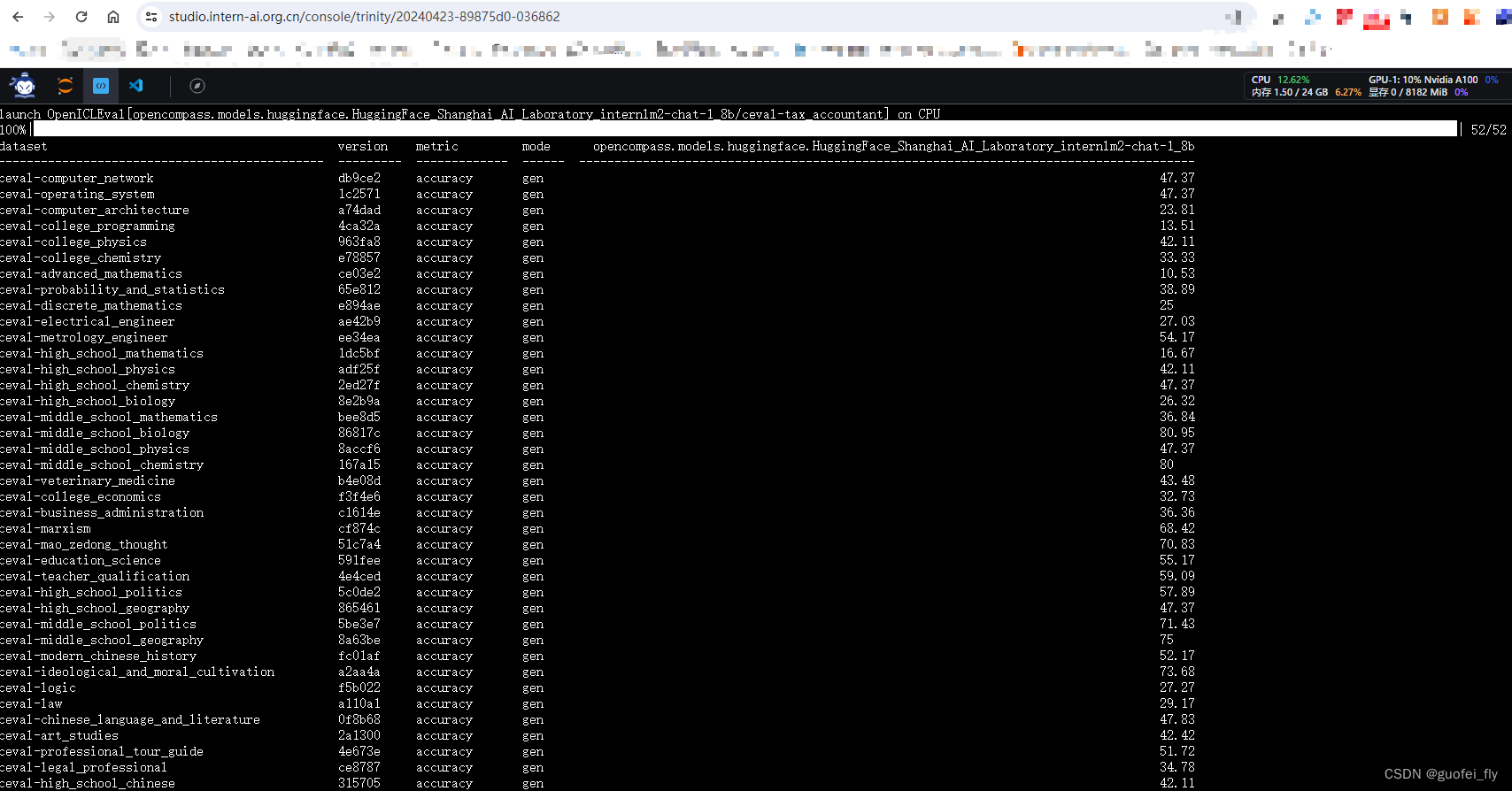

- 当命令行出现「Running on local URL:https://0.0.0.0:8080」后,拷贝右侧API 地址到浏览器地址栏中,即可访问 GeneFace++ 界面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

- 打开 GeneFace++ 界面后,导入提前准备好的视频,选择训练步数 「50000」,点击「Train」开始训练。

注意:此步骤需要等待 2 小时以上,期间可以 1-2 次检查训练是否正常运行,避免过程中断但仍持续等待造成的时间损失。

此处的训练步数「50000」是在默认情况下,如果 50000 步训练的结果很差,请更换训练数据重新训练。

- 当出现「Train Success」后,刷新 GeneFace++ 界面。

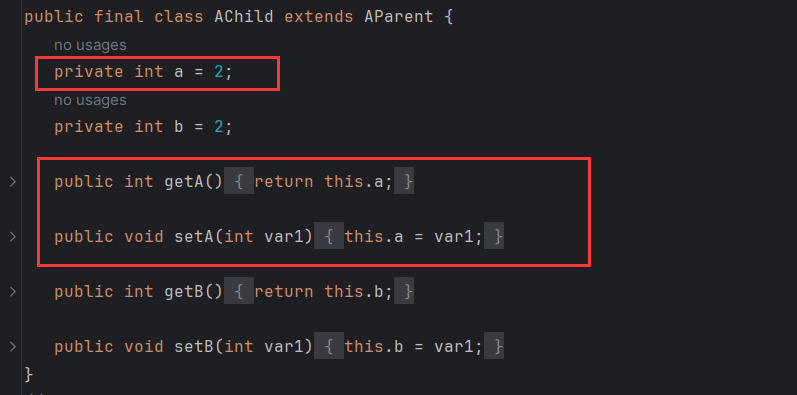

3.在 GeneFace++ 界面中,左侧上传音频,中间模块的参数部分先无需修改。

右侧的模型选择音频驱动模型「model_ckpt_steps_400000.ckpt」。

选择 5 万步下训练对应的躯干模型「model_ckpt_steps_50000.ckpt」。

选择 5 万步下训练对应的头部模型「model_ckpt_steps_50000.ckpt」。

- 点击「Gnerate」,即可生成效果。

- 如果想要进一步训练。删除对应模型下的 head_done 文件夹、torso_done 文件夹。

- 上传之前的训练视频,视频文件名称保持不变,调高训练步数,点击 「Train」进行训练。

- 训练结束后,在 GeneFace++ 界面,右侧的模型选择默认的音频驱动模型、15 万步下训练对应的躯干模型、15 万下训练对应的头部模型。点击「Gnerate」,即可生成最终效果。

目前,HyperAI超神经官网已上线了数百个精选的机器学习相关教程,并整理成 Jupyter Notebook 的形式。

点击链接即可搜索相关教程及数据集:

https://hyper.ai/tutorials

以上就是小编本次分享的全部内容了,希望这次的内容对您有所帮助。如果大家还想学习其他好玩的教程,欢迎留言或私信告诉我们项目地址,小编将会为你量身打造课程,教你如何玩转 AI。

参考资料:

https://blog.csdn.net/c9Yv2cf9I06K2A9E/article/details/128895215