LLM使用方法介绍,持续更新

1. LLM本地搭建与运行

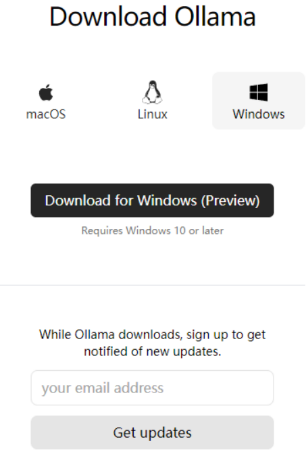

1. Ollama的安装

- 网址:https://ollama.com/

- 点击Download选择对应的操作系统下载安装软件,软件默认安装在C盘无法选择路径;

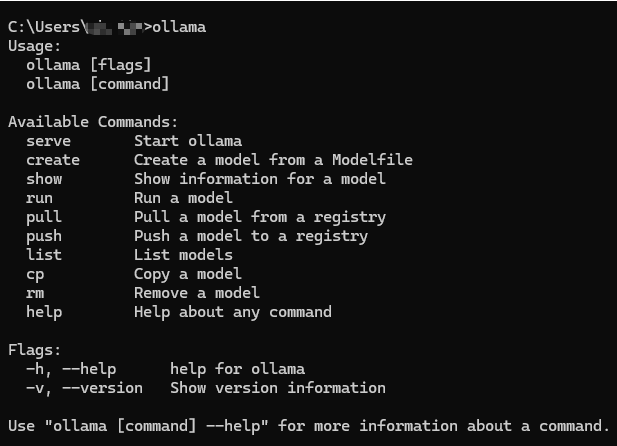

- 安装完成后,Win+R进入终端执行:ollama,出现如下图所示表示安装成功

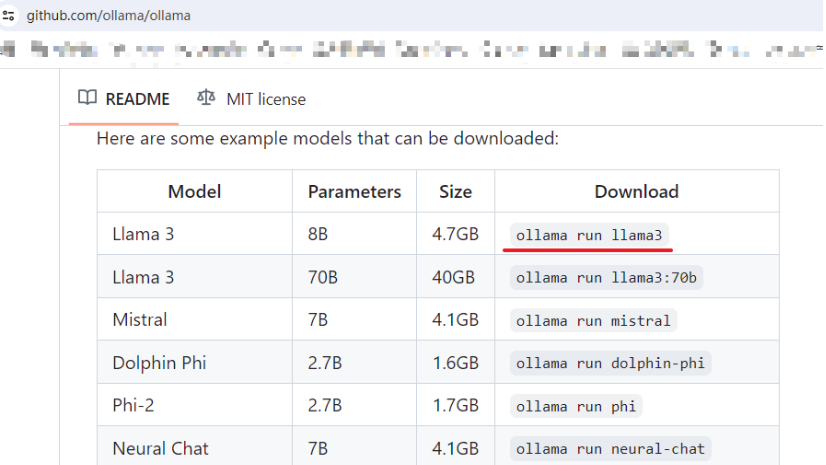

2. Llama 3的安装与运行

- 打开:https://github.com/ollama/ollama,找到下载对应版本的运行命令

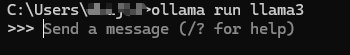

- 在终端执行对应命令即可下载,下载完成即可在终端输入对话;

- 输入对话测试即可

3. Open WebUI的安装与运行

Open WebUI 是一个仿照 ChatGPT 界面,为本地大语言模型提供图形化界面的开源项目,可以非常方便的调试、调用本地模型。你能用它连接你在本地的大语言模型(包括 Ollama 和 OpenAI 兼容的 API),也支持远程服务器。

2. Colab微调大模型

待更新 。。。

3. 百度千帆大模型的API调用

1.创建应用

https://console.bce.baidu.com/qianfan/ais/console/applicationConsole/application

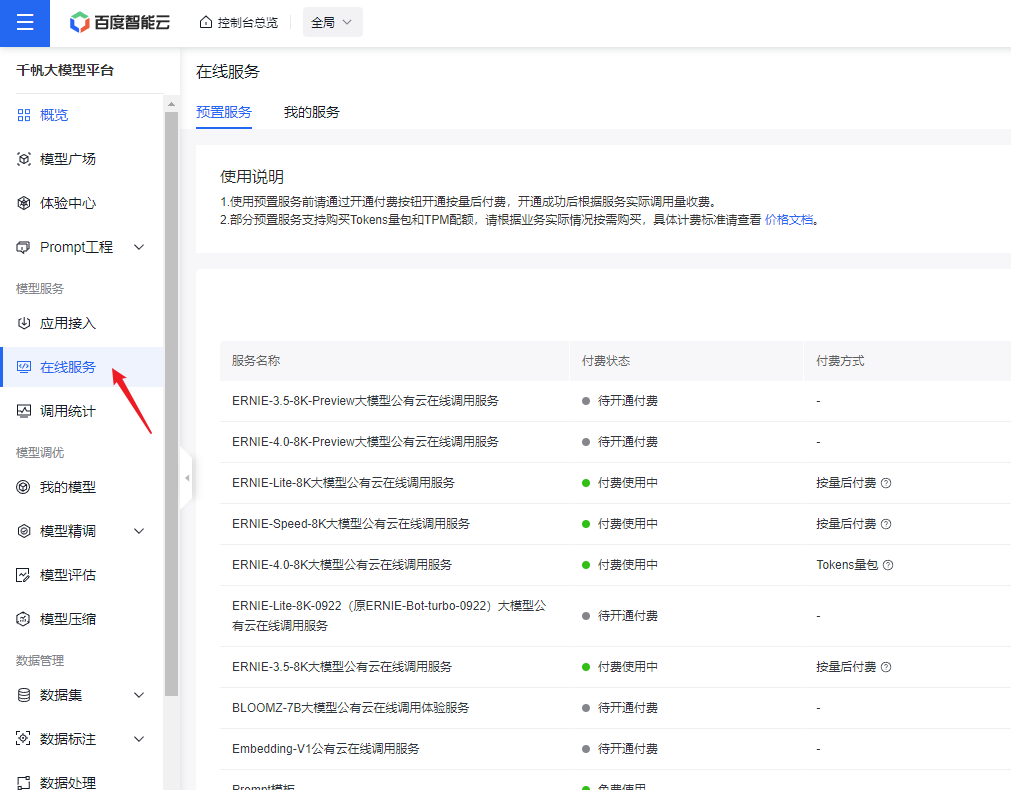

2.开通大模型服务

根据自己需要开通对应大模型,当然也可以不开通。在后续的体验中心和代码在线调试中选择免费的大模型即可;

3.体验中心

https://console.bce.baidu.com/qianfan/ais/console/onlineTest

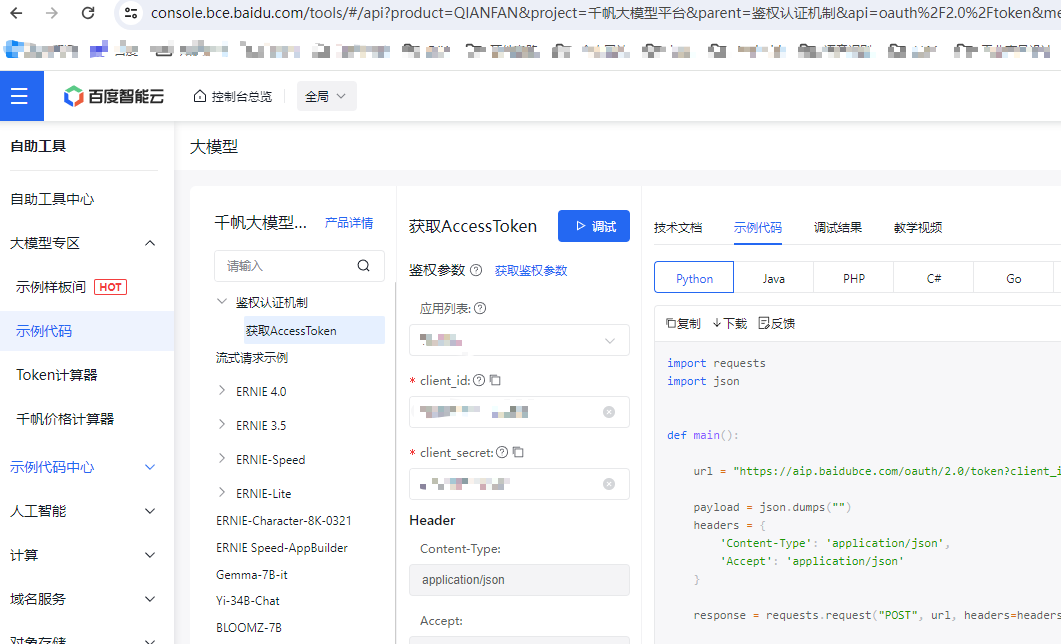

4. 示例代码在线调试

https://console.bce.baidu.com/tools/#/index,复制示例代码到自己工程即可使用;