深入理解VGG网络

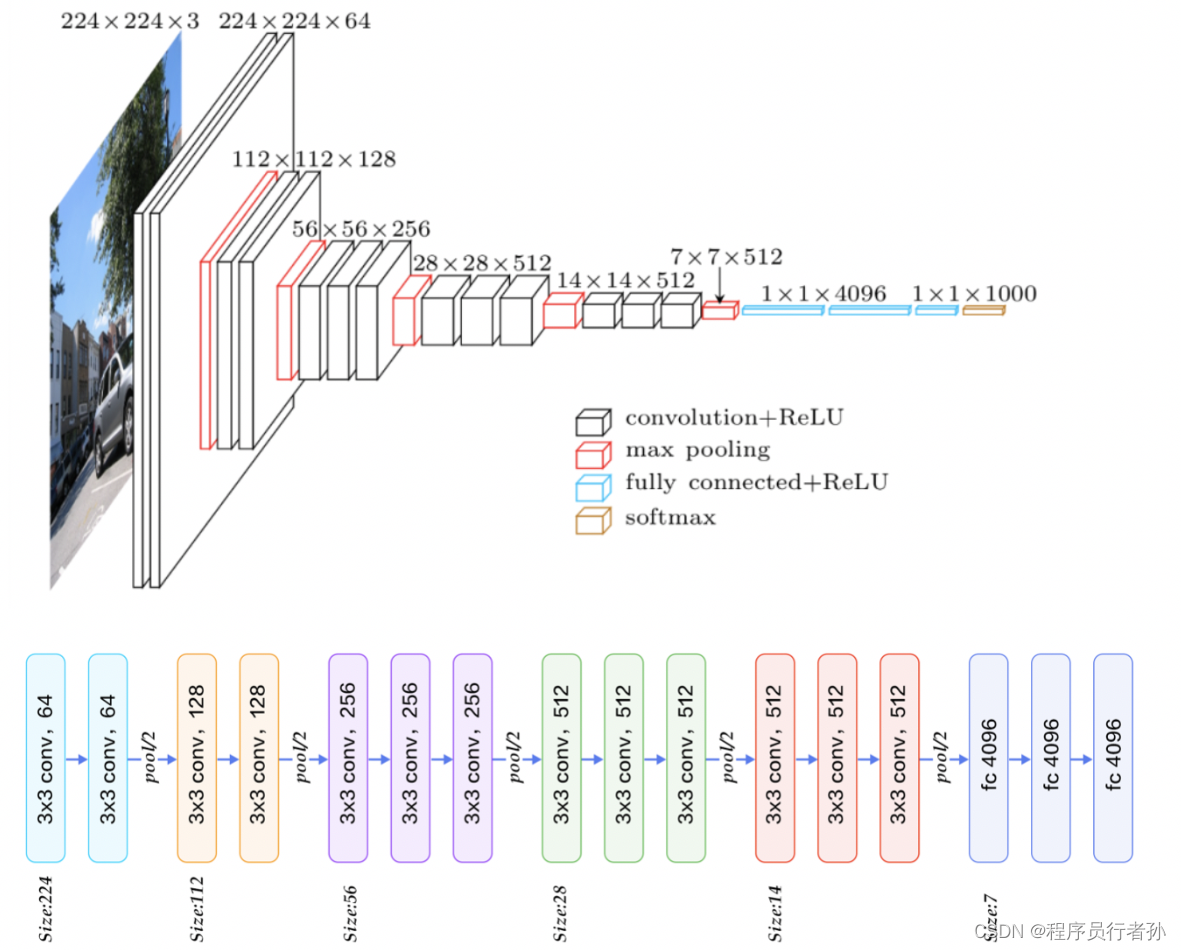

VGG网络是深度学习领域中一个非常经典的卷积神经网络(CNN)架构,由牛津大学的视觉几何组(Visual Geometry Group)提出。它在2014年的ImageNet挑战赛中取得了第二名的好成绩,并且在随后的许多计算机视觉任务中都显示出了强大的性能。VGG网络的设计哲学在于其简洁和一致性,它完全由3x3的卷积核和2x2的最大池化层构成,没有使用任何特殊的层,如1x1卷积或Inception模块。

VGG网络的关键特性:

- 深度:VGG网络非常深,基础模型有16层(VGG16)和19层(VGG19)两种。

- 卷积核大小:整个网络中只使用了3x3的卷积核,这使得网络能够捕捉到更细粒度的图像特征。

- 全连接层:在卷积层之后,VGG网络使用全连接层来进行分类。

- 激活函数:VGG网络使用了ReLU作为激活函数,这有助于缓解梯度消失问题。

- 均一化:在卷积层和池化层之后,VGG网络使用了局部响应归一化(LRN),这有助于提高网络的训练速度和性能。

VGG网络的原理

VGG网络,全称Visual Geometry Group网络,是一种用于图像识别和分类的深度学习模型。它之所以强大,是因为它采用了一种简单而有效的设计原则,通过多个层次的卷积和池化操作来提取图像特征,最终实现对图像内容的精确识别。下面,我将用一种更通俗易懂的方式来解释VGG网络的工作原理。

1. 基础构件:卷积层

想象一下,卷积层就像是一张有很多小窗口的网,这些小窗口覆盖在图像上,通过这些窗口观察图像的局部区域。每个小窗口都有自己的一组数字(称为权重),它们与图像的相应部分相乘,然后加起来,得到一个数值。这个过程在图像上重复进行,每次移动小窗口一点,从而得到图像的局部特征。

2. 非线性激活:ReLU

在每个卷积操作后,VGG网络使用一种称为ReLU的非线性激活函数。ReLU的作用就像是个开关,它只允许大于0的数值通过,而将小于或等于0的数值关闭。这有助于网络捕捉到更丰富的特征,并且简化了计算。

3. 降采样:池化层

池化层的作用是减小图像的空间尺寸,即图像的宽度和高度。这通常通过取一个小区域的最大值来实现,这样即使图像内容发生微小的移动,网络的输出也不会有太大变化,从而增强了网络的泛化能力。

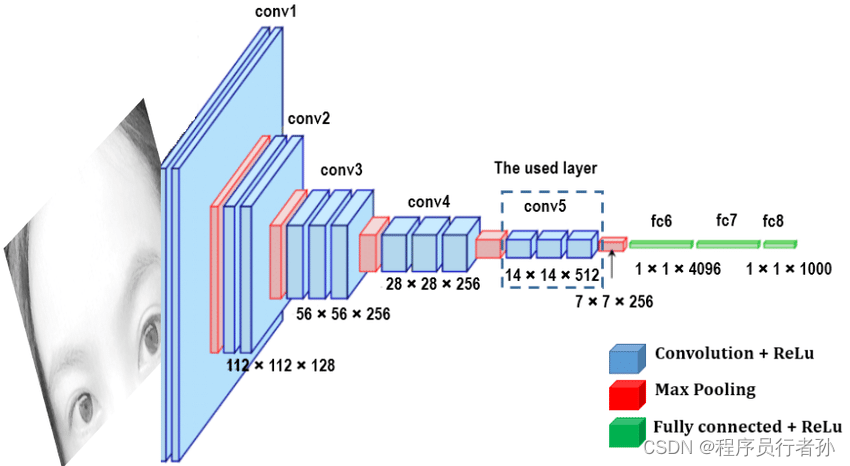

4. 逐层抽象:深度

VGG网络通过堆叠多个卷积层和池化层,逐步将图像的原始像素信息转换成更高级的特征表示。网络的深层能够捕捉到更复杂的视觉模式,比如从边缘到形状,再到完整的物体。

5. 分类决策:全连接层

在卷积和池化层之后,网络使用全连接层来做出最终的分类决策。全连接层将前面层级提取的高级特征转换成一个固定长度的向量,每个维度代表一个类别的概率。

6. 输出概率:Softmax

最后,VGG网络使用Softmax函数将全连接层的输出转换成概率分布,这样每个类别都有一个介于0到1之间的数值,所有类别的概率之和为1。这样,我们就可以简单地选择概率最高的类别作为网络的预测结果。

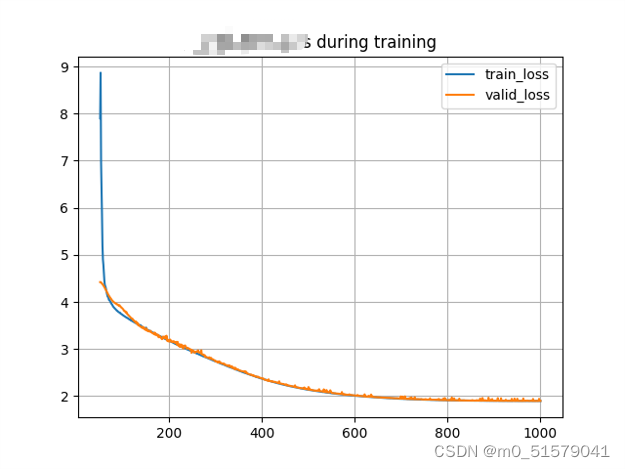

7. 训练过程

在训练VGG网络时,我们首先给网络提供大量标记好的图像,然后通过比较网络的预测结果和实际的标签来计算错误。接着,我们使用一种称为反向传播的算法来更新卷积层中的权重,以减少预测错误。这个过程重复进行,直到网络的性能达到满意的水平。

VGG网络的设计哲学在于其简洁和一致性,它证明了通过增加网络的深度,可以显著提高图像识别的性能。尽管VGG网络在参数数量和计算资源上有较高的需求,但它为深度学习领域提供了宝贵的洞见,并启发了后续许多更高效网络架构的设计。

VGG网络的结构详解:

VGG网络的结构可以概括为连续的卷积层、池化层,然后是几个全连接层,最后是一个softmax层来进行分类。下面是VGG16的一个简化版的结构图:

[Convolutional layer: 64 filters, 3x3, same padding]

[Activation layer: ReLU]

[Convolutional layer: 64 filters, 3x3, same padding]

[Activation layer: ReLU]

[Max Pooling layer: 2x2, stride 2]

[LRN layer]

...

[Fully Connected layer: 4096 units]

[Activation layer: ReLU]

[Dropout]

[Fully Connected layer: 4096 units]

[Activation layer: ReLU]

[Dropout]

[Fully Connected layer: number of classes]

[Softmax]

VGG网络的实现:

以下是使用Python和TensorFlow库实现VGG16网络的一个更详细的示例。这个示例包括了局部响应归一化层,并且展示了如何构建一个完整的VGG16模型。

import tensorflow as tf

from tensorflow.keras import layers, models

def conv_block(input_tensor, filters):

x = layers.Conv2D(filters, (3, 3), padding='same', activation='relu')(input_tensor)

x = layers.Conv2D(filters, (3, 3), padding='same', activation='relu')(x)

x = layers.MaxPooling2D((2, 2))(x)

x = layers.LocalResponseNormalization()(x)

return x

def create_vgg(input_shape, num_classes):

inputs = layers.Input(shape=input_shape)

# 构建VGG16的卷积块

x = conv_block(inputs, 64)

x = conv_block(x, 128)

x = conv_block(x, 256)

x = conv_block(x, 256)

x = conv_block(x, 512)

x = conv_block(x, 512)

# 将卷积层的输出展平

x = layers.Flatten()(x)

# 添加全连接层

x = layers.Dense(4096, activation='relu')(x)

x = layers.Dropout(0.5)(x)

x = layers.Dense(4096, activation='relu')(x)

x = layers.Dropout(0.5)(x)

# 添加输出层

outputs = layers.Dense(num_classes, activation='softmax')(x)

# 创建模型

model = models.Model(inputs=inputs, outputs=outputs)

return model

# 定义输入图像的大小和类别数量

input_shape = (224, 224, 3) # 例如,224x224 RGB图像

num_classes = 1000 # ImageNet有1000个类别

# 创建VGG模型

vgg_model = create_vgg(input_shape, num_classes)

# 编译模型

vgg_model.compile(optimizer='rmsprop',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 显示模型结构

vgg_model.summary()

VGG网络的训练和应用:

在实际应用中,你需要准备一个适当的数据集,并进行数据预处理,如归一化和数据增强。此外,由于VGG网络的参数数量较多,训练可能需要较长的时间,并且需要大量的计算资源。为了加速训练过程,可以使用预训练的VGG模型作为特征提取器,或者进行迁移学习。

结论:

VGG网络是深度学习领域中一个非常重要的里程碑,它不仅在ImageNet上取得了好成绩,而且对后续的深度学习模型设计产生了深远的影响。尽管现在有更先进的模型,如ResNet和Inception,但VGG网络仍然是深度学习入门和理解卷积神经网络(CNN)结构的一个非常好的起点。通过研究VGG网络,我们可以更好地理解深度学习模型的工作原理,以及如何设计和优化这些模型。

希望这篇博客能帮助你更深入地理解VGG网络的结构和工作原理。如果你有任何问题或想要进一步讨论,请随时留言。

![[docker] 数据的持久化 - Volume bind mounts](https://img-blog.csdnimg.cn/direct/7da2727413344ee89f02ca8ac2b4903d.png)