在这篇技术博文中,我们将深入探讨LangChain框架中的ReAct对话模型,以及如何利用它构建高效的智能对话系统。ReAct模型通过反应堆(Reactor)处理对话中的各种情况,实现了对复杂对话场景的有效解构。结合思维链(Chain of Thought, CoT),ReAct框架能够提升大模型的推理能力和可解释性,使其在处理任务时更加可靠和实用。

ReAct对话模型的核心概念

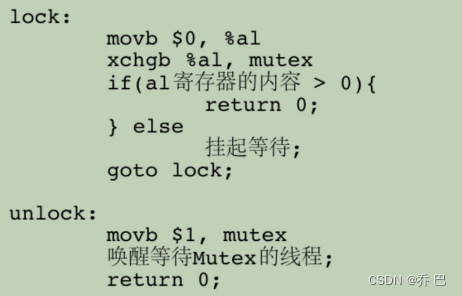

ReAct对话模型的核心是反应堆,这是一个高度可配置的组件,能够对输入的文本进行自定义处理。通过在不同的反应堆之间传递输入文本,我们可以实现对不同任务的解构和组合。这种模型的设计允许大模型在推理过程中同时利用内部知识和外部信息,从而提供更准确和实际的回应。

思维链(CoT)的结合与优势

思维链是ReAct框架中的一个关键特性,它允许大模型在推理过程中生成推理轨迹和操作。这不仅使得代理能够系统地执行动态推理来创建、维护和调整操作计划,而且还支持与外部环境(例如Google搜索、Wikipedia)的交互,将额外信息合并到推理中。这种结合显著提高了大模型的可解释性和可信度,使得用户能够更好地理解和信任代理的决策过程。

实现ReAct框架的智能代理

在LangChain中,我们可以通过Agent类来封装和实现ReAct框架。这使得大模型具备了极大的自主性,从一个仅依赖内部知识的聊天Bot,转变为一个能够使用工具的智能代理。以下是一个使用ReAct框架的实践示例:

import os

from langchain.agents import load_tools

from langchain.agents import initialize_agent

from langchain.agents import AgentType

from langchain_openai import ChatOpenAI

# 设置API密钥

os.environ["OPENAI_API_KEY"] = "替换为你的API密钥"

os.environ["SERPAPI_API_KEY"] = "替换为你的API密钥"

# 导入所需的库和模型

llm = ChatOpenAI(

openai_api_key=os.environ["OPENAI_API_KEY"],

base_url='https://api.chatanywhere.tech/v1',

model='gpt-3.5-turbo',

temperature=0.7,

)

# 加载工具

tools = load_tools(["serpapi", "llm-math"], llm=llm)

# 初始化代理

agent = initialize_agent(tools, llm, agent=AgentType.ZERO_SHOT_REACT_DESCRIPTION, verbose=True)

# 运行代理

response = agent.run("目前市场上玫瑰花的平均价格是多少?如果我在此基础上加价15%卖出,应该如何定价?")

print(response)

在这个示例中,我们首先设置了必要的API密钥,并初始化了所需的库和工具。然后,我们创建了一个ChatOpenAI模型实例,并加载了一些工具,如serpapi和llm-math。最后,我们初始化了一个代理,并运行了一个任务,即查询市场上玫瑰花的平均价格,并计算加价15%后的新价格。通过打印响应,我们可以看到代理如何结合搜索结果和数学计算来得出结论。

总结与展望

通过ReAct框架和思维链的结合使用,LangChain中的智能代理能够自动形成一个完善的思考与行动链条,并给出正确的答案。这个思维链条中,智能代理有思考、有观察、有行动,成功通过搜索和计算两个操作,完成了任务。这种能力不仅提高了代理的效率,也增强了其在复杂对话场景中的适应性和实用性。随着技术的不断发展,我们期待看到更多创新的应用出现,以推动智能对话系统的进步,并为用户提供更加丰富和智能的交互体验。