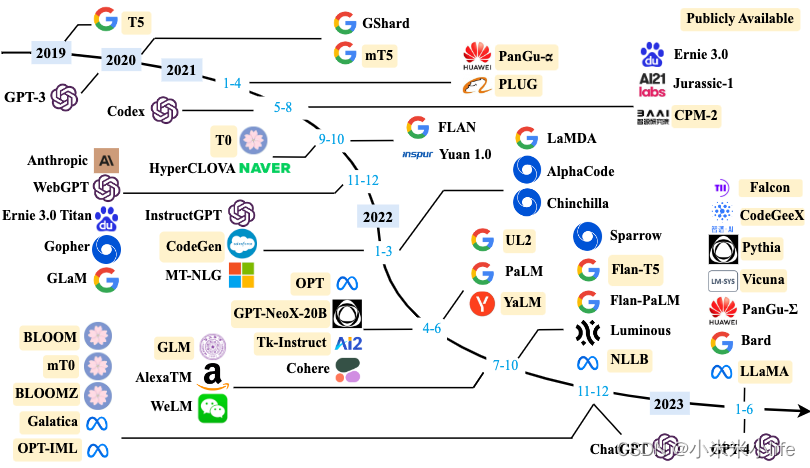

过往历史

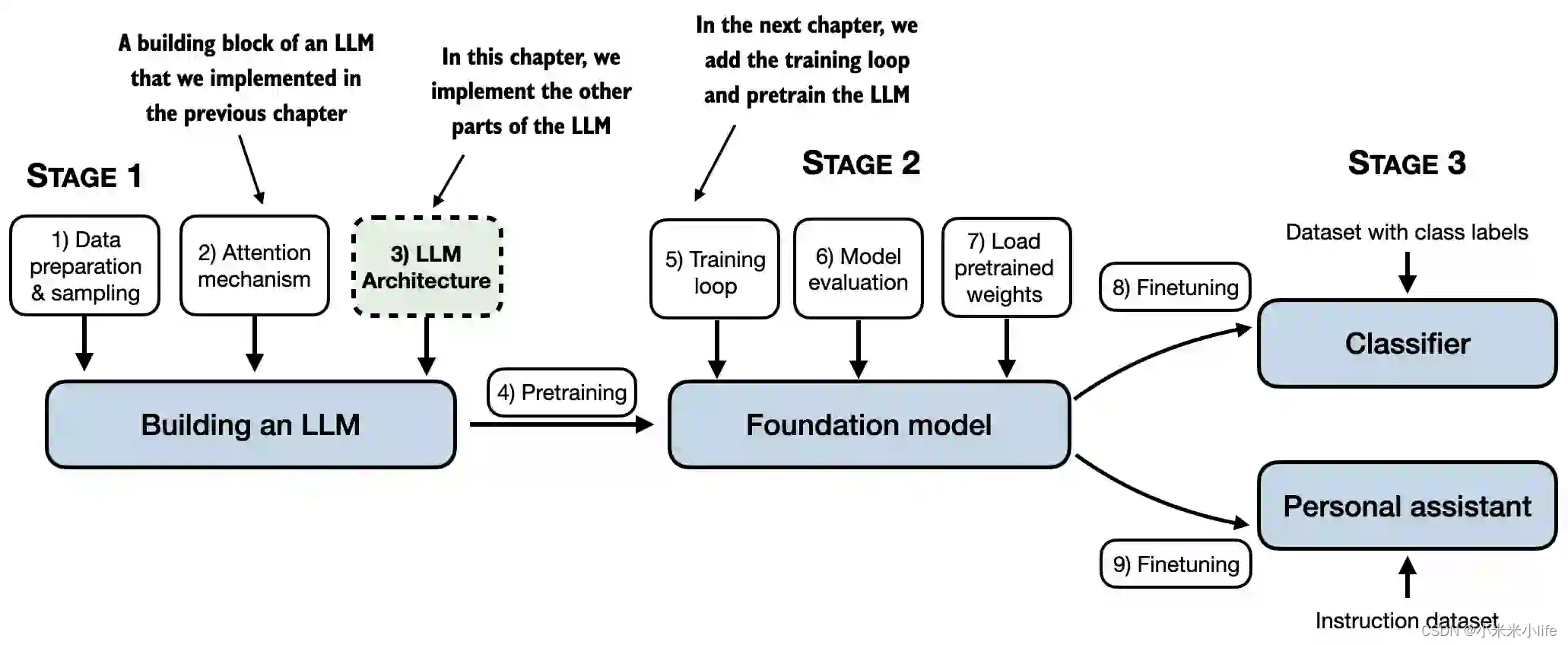

大体框架

手戳GPT2-small

一些概念

- pytorch

- 注意力机制(Transformer)

- LLM

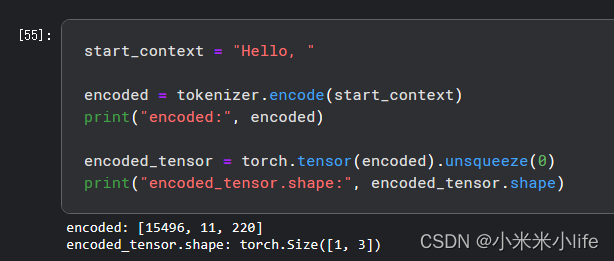

过程

- 模型参数

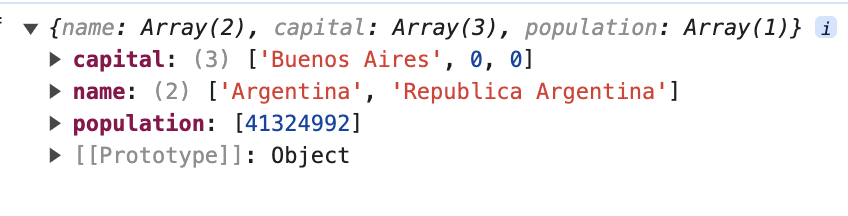

GPT_CONFIG_124M = {

"vocab_size": 50257, # 词表大小

"ctx_len": 1024, # 上下文长度

"emb_dim": 768, # 嵌入维度

"n_heads": 12, # 注意力头(attention heads)的数量

"n_layers": 12, # 模型层数

"drop_rate": 0.1, # Dropout rate

"qkv_bias": False # Query-Key-Value bias

}

- 激活函数

在LLM中,除了ReLU之外,还使用了其他类型的激活函数;其中两个值得注意的例子是:

GELU(Gaussian Error Linear Unit):其精确版本定义为

G

E

L

U

(

x

)

=

x

⋅

ϕ

(

x

)

GELU(x)=x \cdot \phi (x)

GELU(x)=x⋅ϕ(x),其中

ϕ

(

x

)

\phi(x)

ϕ(x)是标准高斯分布的累积分布函数。

SwiGLU(Sigmoid-Weighted Linear Unit)

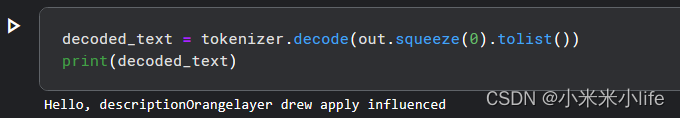

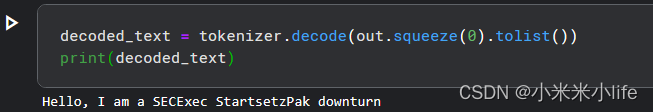

结果

![[入门]测试层级-ApiHug准备-测试篇-005](https://img-blog.csdnimg.cn/img_convert/016ed28023b501ad5080767a14c9e45c.gif)