前言

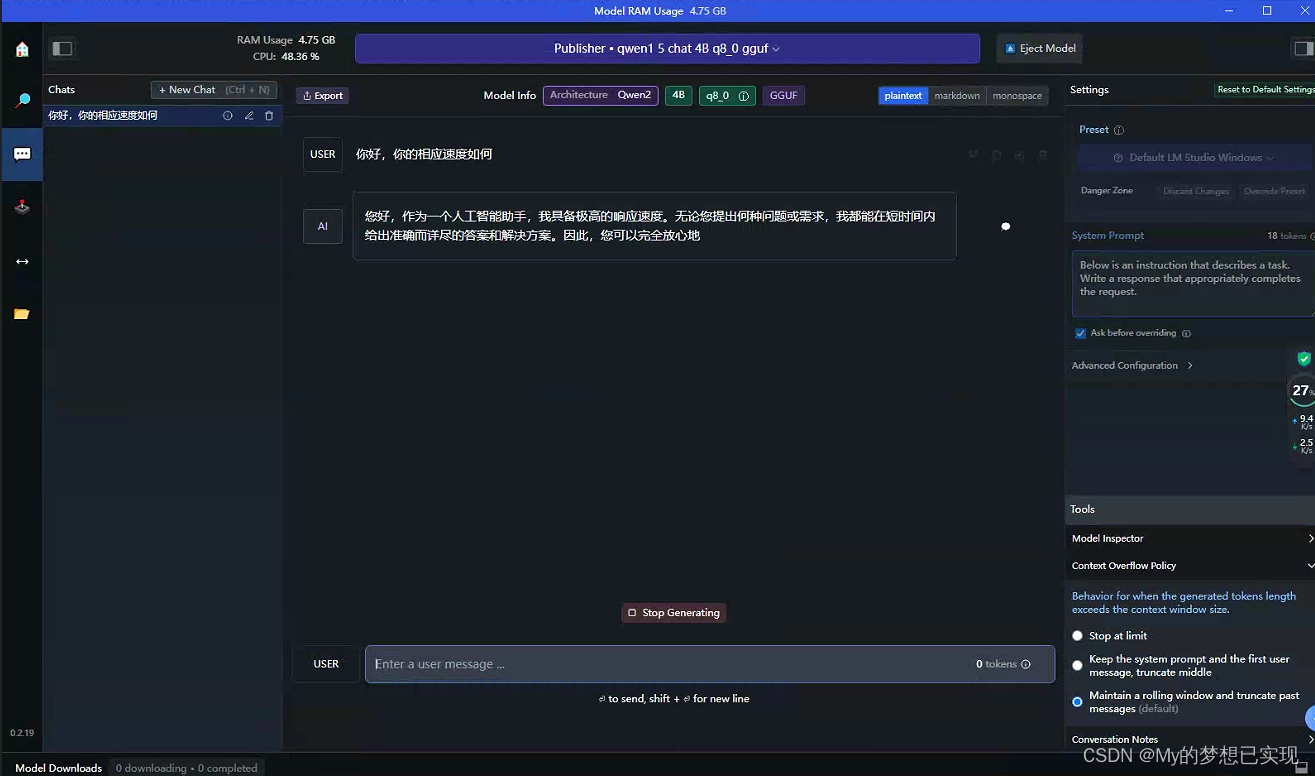

之前文章,我们采用了Koblod运行Yi-34B大模型,本文采用LM Studio来运行千问模型。

LM Studio并没有开源,但是可以免费使用,他是目前本地进行模型测试最好的工具了。

在这里,依然使用Windows 10进行部署和测试,没有GPU。

注意:LM的运行速度相比较Kobold两者差不多,而且也提供WEB服务,稍后也研究下他的API功能,LM的功能更多一些有待开发。

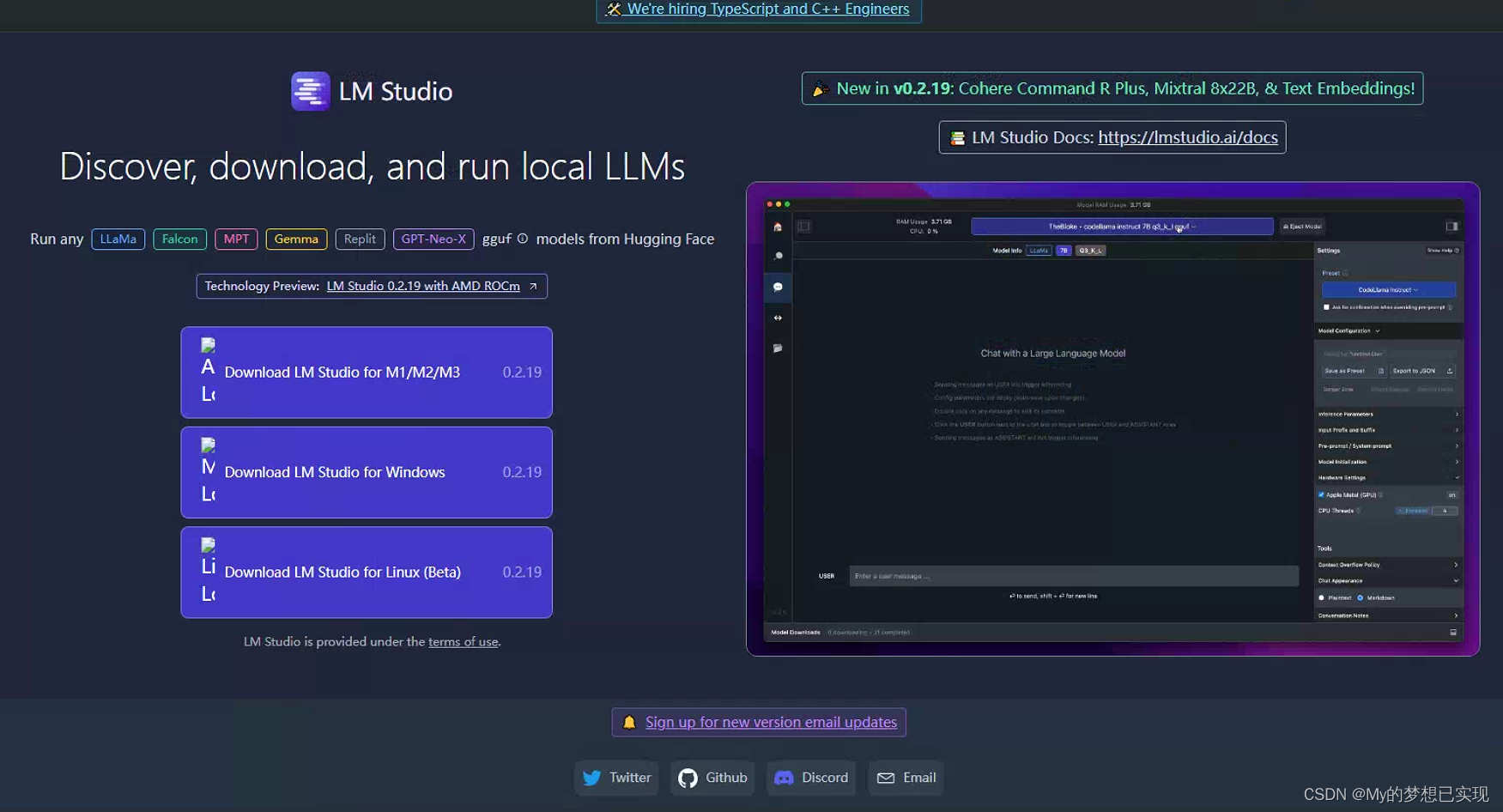

一、LM Studio下载

下载地址:LM Studio - Discover, download, and run local LLMs

二、模型下载

下载地址:AI快站 - HuggingFace模型免费加速下载

我们要从这里选择需要的模型。其他模型资源如下:

1.其他模型资源

- 国内厂商模型

| 序号 | 厂商 | 访问地址 |

|---|---|---|

| 1 | 阿里通义千问 | AI快站 - HuggingFace模型免费加速下载 |

| 2 | 百川智能 | AI快站 - HuggingFace模型免费加速下载 |

| 3 | CodeFuse | AI快站 - HuggingFace模型免费加速下载 |

| 4 | 上海人工智能实验室 | AI快站 - HuggingFace模型免费加速下载 |

| 5 | 智谱 | AI快站 - HuggingFace模型免费加速下载 |

| 6 | 智源人工智能研究院 | AI快站 - HuggingFace模型免费加速下载 |

| 7 | FlagAlpha | AI快站 - HuggingFace模型免费加速下载 |

| 8 | 零一万物 | AI快站 - HuggingFace模型免费加速下载 |

- 海外厂商模型

| 序号 | 厂商 | 访问地址 |

|---|---|---|

| 1 | AI快站 - HuggingFace模型免费加速下载 | |

| 2 | codefuse-ai | AI快站 - HuggingFace模型免费加速下载 |

| 3 | mosaicml | AI快站 - HuggingFace模型免费加速下载 |

| 4 | bigcode | AI快站 - HuggingFace模型免费加速下载 |

| 5 | lmsys | AI快站 - HuggingFace模型免费加速下载 |

| 6 | NousResearch | AI快站 - HuggingFace模型免费加速下载 |

| 7 | OpenAssistant | AI快站 - HuggingFace模型免费加速下载 |

| 8 | tiiuae | AI快站 - HuggingFace模型免费加速下载 |

| 9 | bigscience | AI快站 - HuggingFace模型免费加速下载 |

| 10 | diffusers | AI快站 - HuggingFace模型免费加速下载 |

| 11 | microsoft | AI快站 - HuggingFace模型免费加速下载 |

| 12 | runwayml | AI快站 - HuggingFace模型免费加速下载 |

| 13 | HuggingFaceH4 | AI快站 - HuggingFace模型免费加速下载 |

| 14 | garage-bAInd | AI快站 - HuggingFace模型免费加速下载 |

| 15 | openai | AI快站 - HuggingFace模型免费加速下载 |

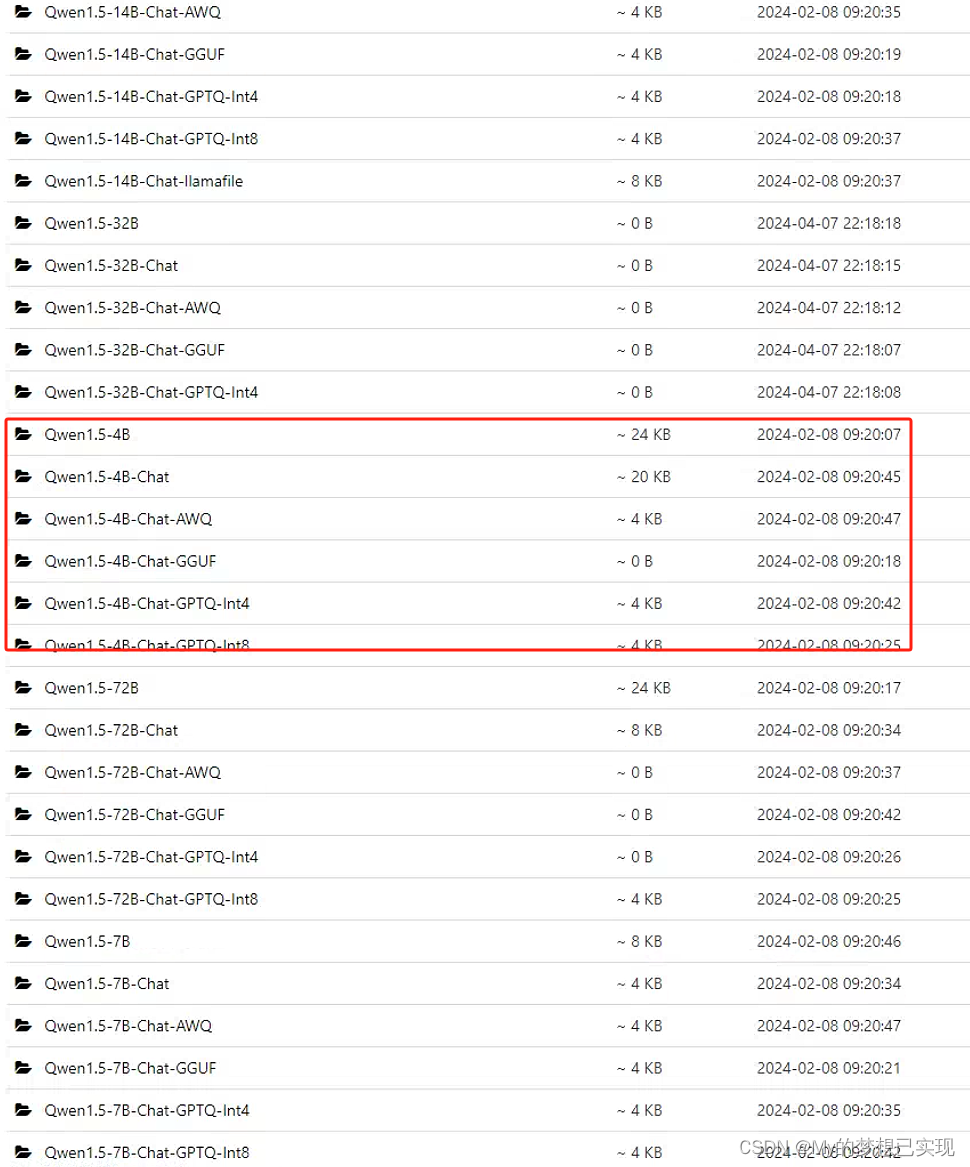

2.需要的模型

本次部署,我们依然选择4B,当然还是选择了GGUF格式,稍后我还要部署到服务器端。

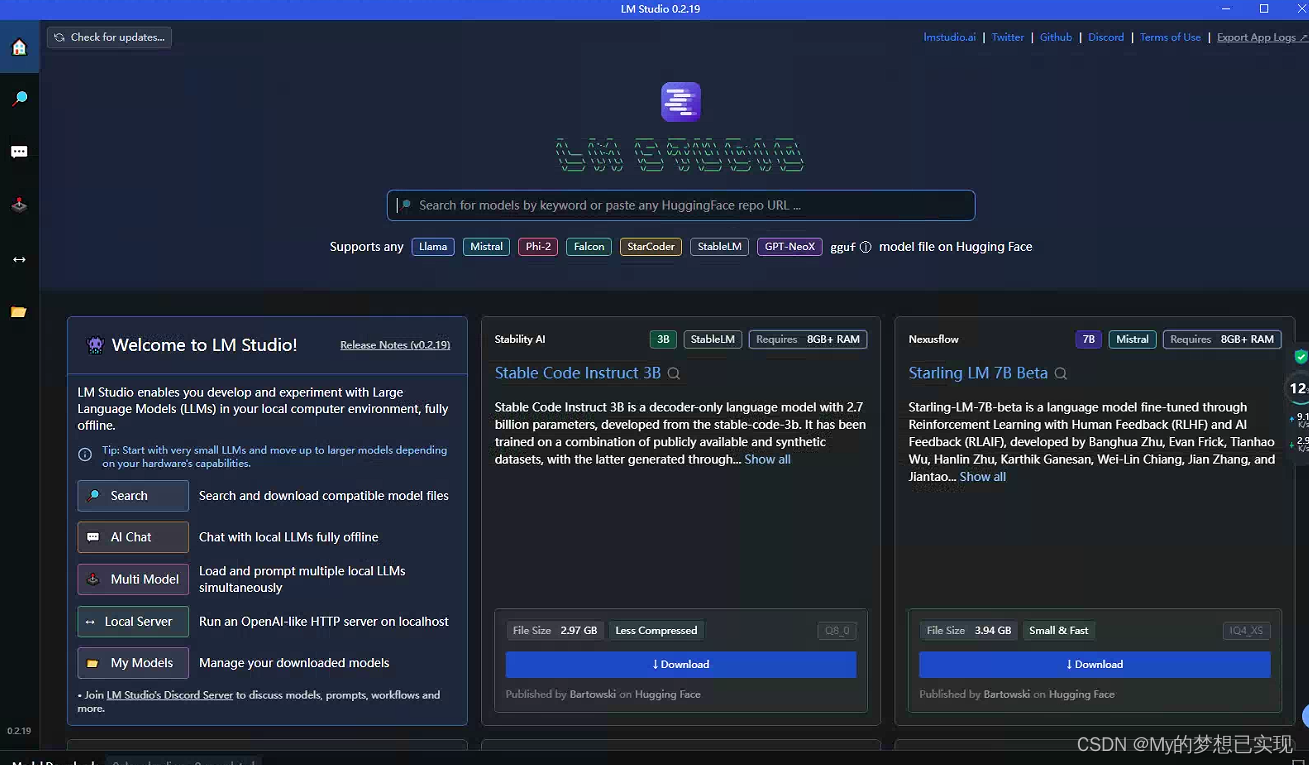

三、安装和打开LM Studio

双击 LM Studio setup.exe,稍等片刻,它会自动安装到C盘,可以挪走,也可以不动。

四、加载和使用模型

1.创建模型文件夹

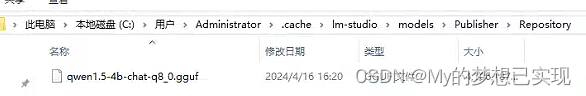

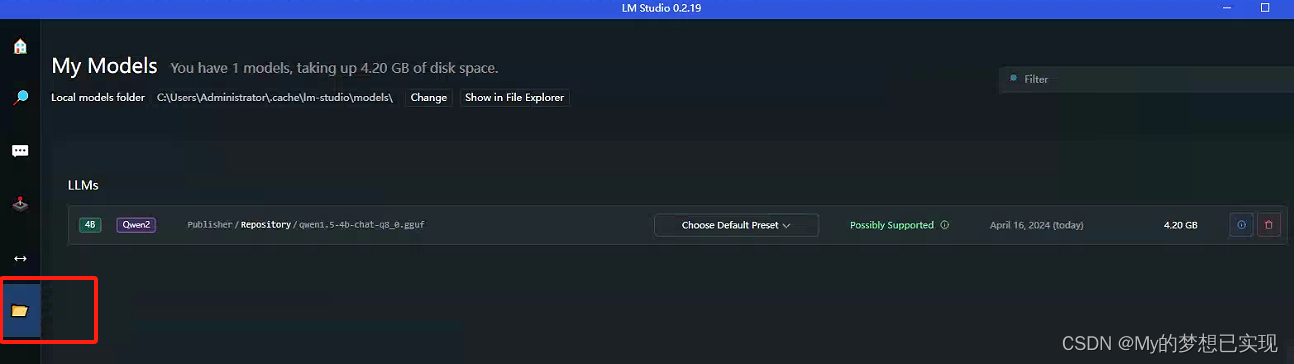

我们先把已经下载好的本地模型,放到它指定的目录下,否则就无法加载模型,其中有两个文件夹第一次可能需要手动建立Publisher和Repository,他俩是上下级关系 。

C:\Users\Administrator\.cache\lm-studio\models\Publisher\Repository将我们需要用的模型拷贝进来

2.重新启动LM

重启后,我们就可以去查看自己的模型了。

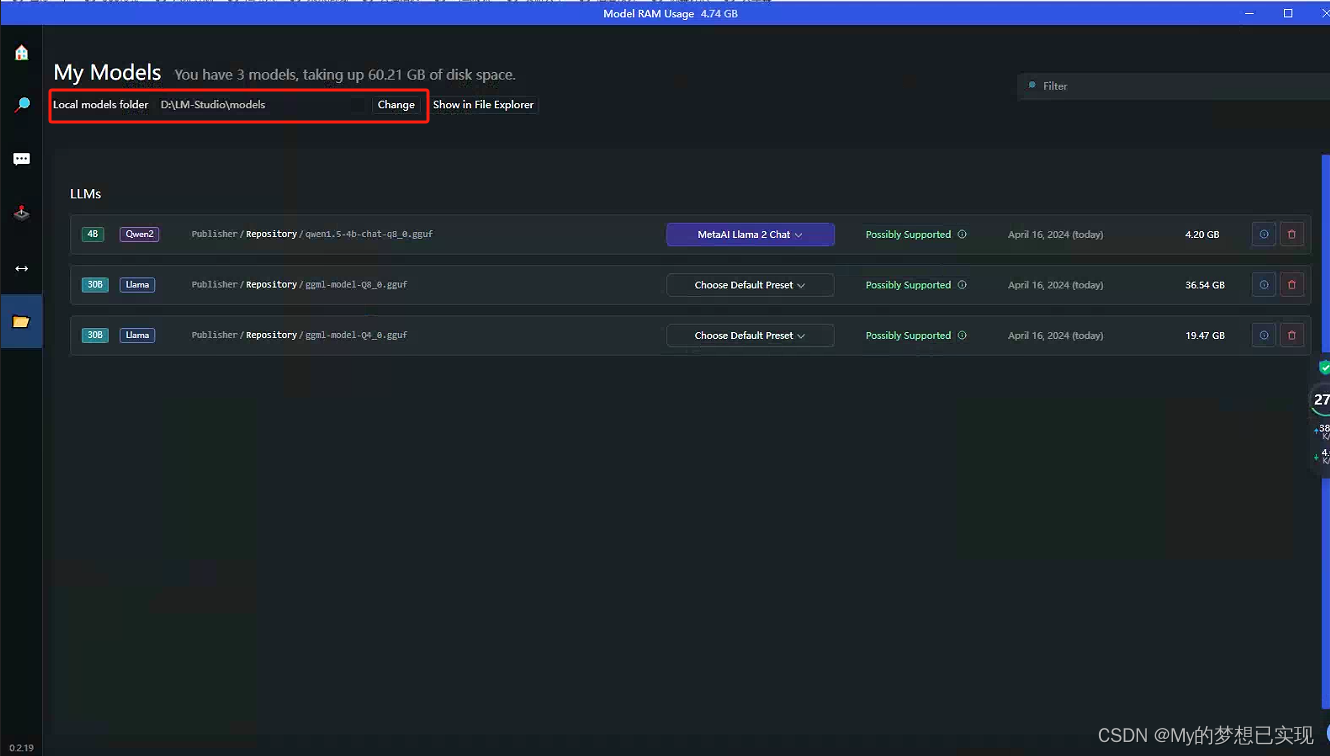

3.修改模型文件夹

D:\LM-Studio\models\Publisher\Repository

#新建Publisher和Repository在选择模型的时候,只选择到 models这一级就可以了,多选无效。

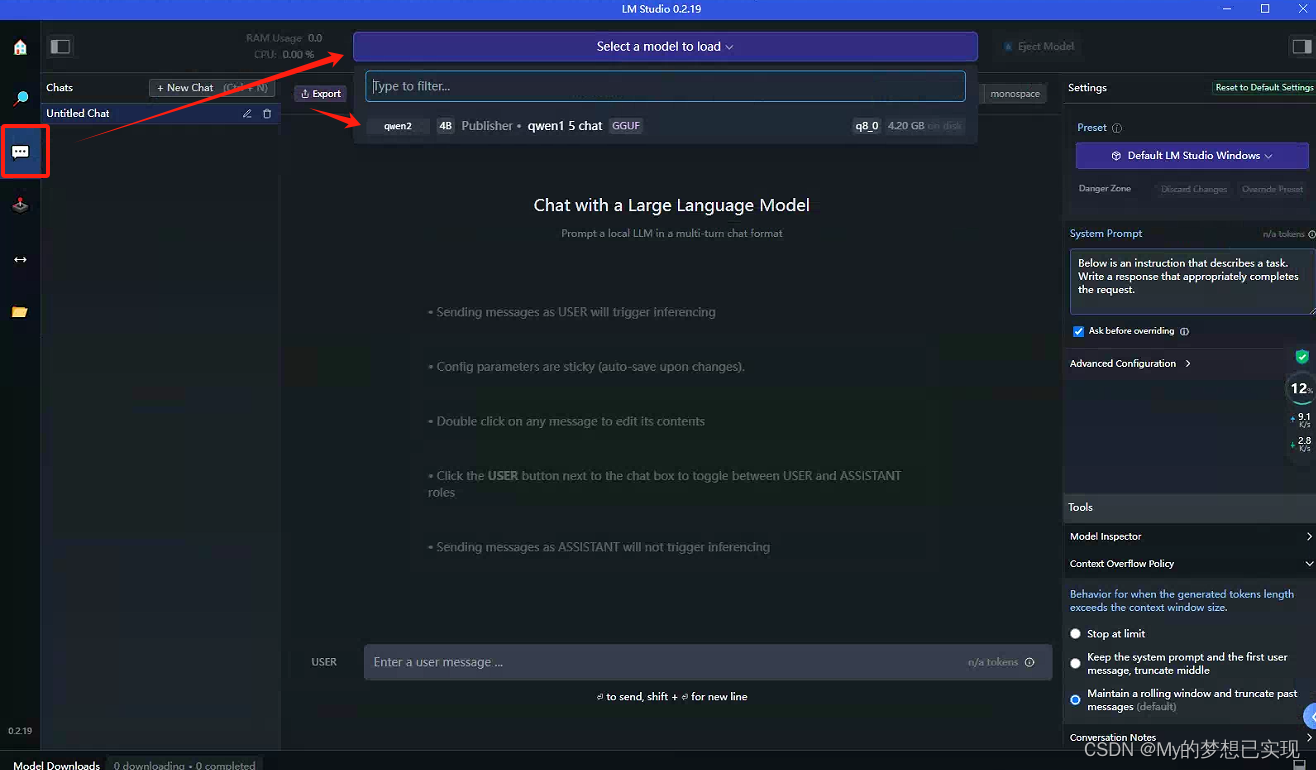

4.使用AI对话

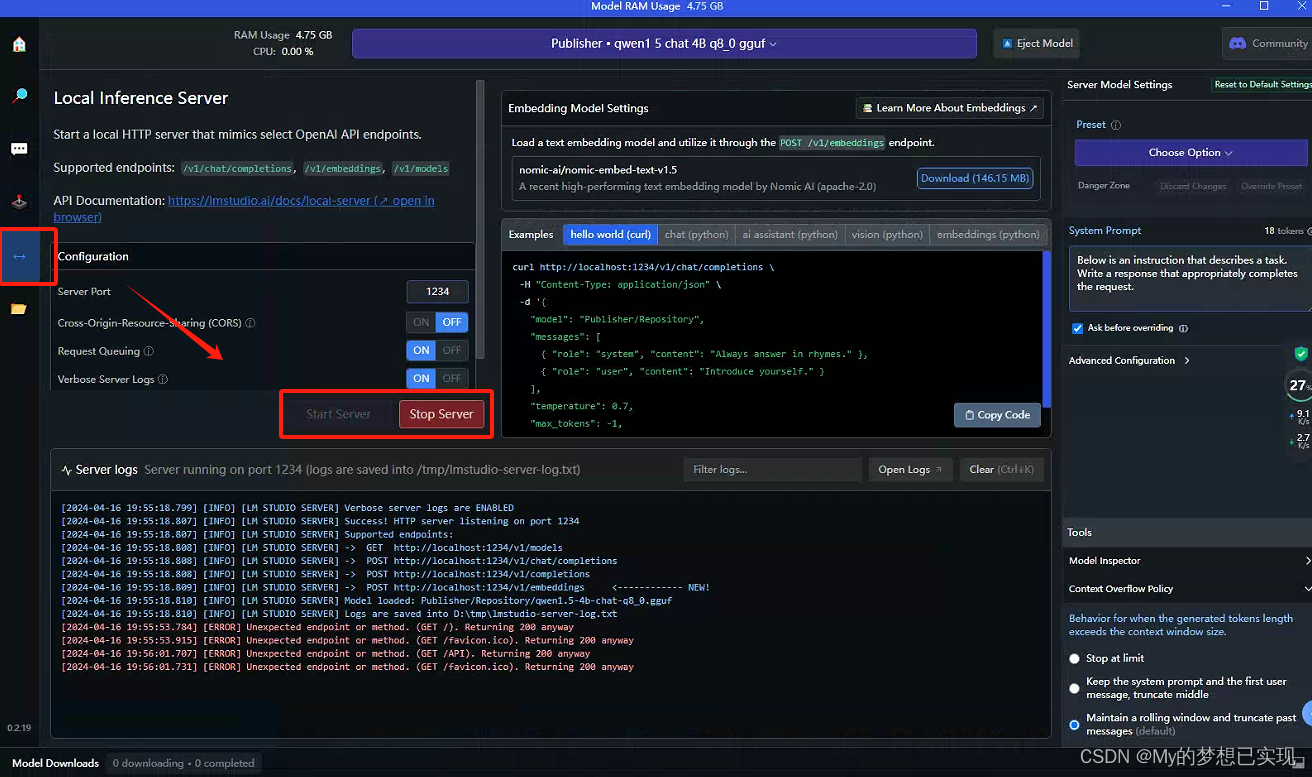

五、LS的API功能

API文档:Local LLM Server | LM Studio

由于时间问题,稍后再做整理和测试。

六、最后

Kobold和LM Studio各有千秋吧,一个是简单,另外一个就是功能多。所以在使用的时候我们可以根据自己的需求来选择。

![民航电子数据库:[E14024]事务内变更操作次数超过最大许可值10000,可通过系统参数max_trans_modify适当调整限制](https://img-blog.csdnimg.cn/direct/bf0860dc511c428ea02b5b76e388ad9b.jpeg)