CPU是中央处理单元,那么GPU是什么呢?

CPU的作用是计算机的运算核心和控制核心,GPU作用是什么呢?

CPU的大小叫着内存大小,那GPU的大小叫什么呢?

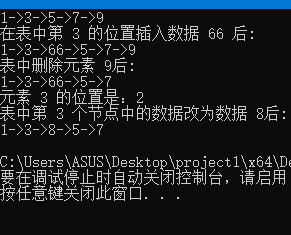

下面我们来聊聊GPU

说起GPU,先来看看我们更为熟知的是CPU,CPU它是负责处理所有的计算任务和运行程序。但随着技术的发展,人们发现,处理图形和视频这类视觉信息的计算量巨大,如果只靠CPU来处理,不仅效率低,还会让电脑变得非常慢。于是,GPU应运而生,它就像一个专门负责美工和视觉效果的小组,当需要处理图像时,CPU就会把这些任务交给GPU来完成。

1、GPU定义

CPU是中央处理单元,那么GPU是什么呢?

GPU,全称为图形处理单元(Graphics Processing Unit),是一种专门设计来处理图形和视频渲染的微处理器。你可以把它想象成电脑或手机里的一个小而强大的大脑,专门负责处理所有与视觉相关的事情。

2、GPU作用

CPU的作用是计算机的运算核心和控制核心,GPU作用是什么呢?

GPU是显卡的核心组件,它决定了显卡的图形处理性能。显卡不仅用于显示图像,还在游戏、设计、科学计算和人工智能等领域发挥着重要作用。

3、GPU单位

CPU的大小叫着内存大小,那GPU的大小叫什么呢?

GPU的大小通常被称为显存容量(Video RAM,VRAM)。显存是显卡上用于存储图像数据、纹理、帧缓冲区等的内存。目前,主流的显存容量有128MB、256MB、512MB、1024MB(1GB)、2GB、4GB、6GB、8GB、10GB、12GB、16GB等。高端显卡甚至可以拥有更大的显存,例如32GB或48GB。显存的大小对于处理高分辨率图像、3D游戏和AI相关任务非常重要。

一、GPU的事迹

2016年,NVIDIA黄仁勋亲手将第一台DGX-1 GPU超级计算机捐给成立还不到一年的OpenAI,马斯克被邀请见证。2023年OpenAI推出ChatGPT席卷全球,带起了一场轰轰烈烈的AI变革。

两位顶级大佬...

以下是关于早期图形加速器、GPU的诞生与发展,以及深度学习和AI与GPU的关系的真实信息:

- 早期的图形加速器

-

- 在个人电脑的早期,图形处理主要依赖于CPU。然而,随着3D游戏和复杂图形应用的出现,对图形处理能力的需求日益增长。

- 早期图形加速器的发展包括了3Dfx的Voodoo系列。这些加速器通过提供专用的3D渲染硬件,显著提升了图形性能。

- GPU的诞生与早期发展

-

- 1999年,NVIDIA推出了GeForce 256,被认为是第一款真正的GPU。它将顶点变换、光照和片元计算集成到一块芯片上,极大地提高了3D图形的处理能力。

- 可编程GPU和通用计算

-

- 随着时间的推移,GPU开始具备可编程性,不仅能处理图形任务,还能执行更广泛的计算任务。

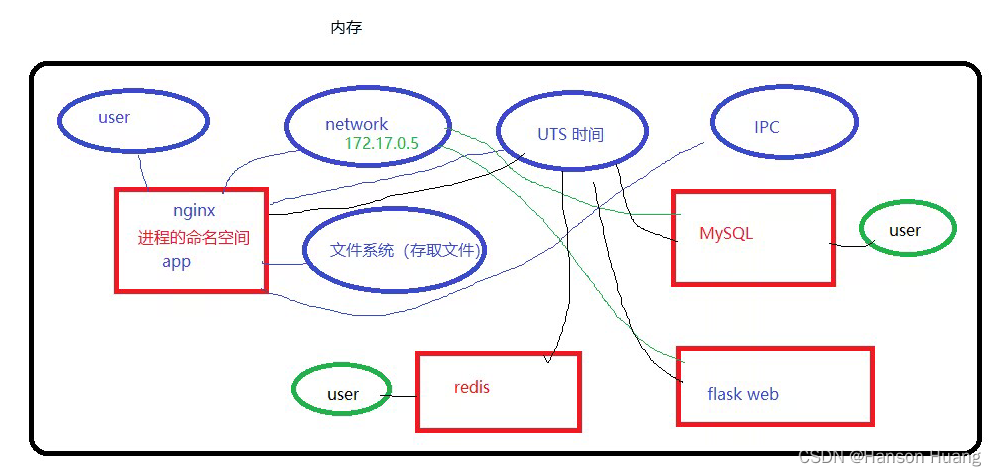

- NVIDIA的CUDA和AMD的Stream技术使GPU能用于科学计算、数据分析和机器学习等领域。

- 深度学习和AI的兴起

-

- GPU的并行处理能力使其成为深度学习和人工智能研究的理想选择。

- Google Brain项目使用GPU加速了神经网络的训练,标志着GPU在AI领域的应用开始受到重视。如今,GPU在AI模型的训练和推理中扮演着关键角色。

二、GPU的工作原理

GPU的工作原理其实很简单。它内部有成百上千个小核心,这些核心可以同时处理大量的数据。当你打开一个游戏或者视频,GPU就会把这些图像数据分解成小块,然后分给这些小核心去处理。因为这些小核心可以同时工作,所以GPU的处理速度非常快。

三、GPU和CPU

GPU与CPU的外形类似,它们之间的关系可以类比于工厂中的工人和机器人。CPU就像工厂中的工人,能够处理各种复杂的任务,但每次只能专注于一个任务。而GPU则像工厂中的机器人,每个机器人只能做简单的工作,但它们数量众多,可以同时处理许多重复性的任务。在需要处理大量并行任务时,如渲染复杂的3D场景或训练深度学习模型,GPU的并行处理能力就显得尤为重要。GPU允许某些计算比传统CPU上运行相同的计算速度快10倍至100倍。

四、GPU & AI

1、GPU与AI

在最近的英伟达GPU技术大会(GTC)上,黄仁勋介绍了一款更大、更强的Blackwell架构GPU,这款芯片被命名为B200。这款GPU的设计在多个方面实现了突破,特别是在处理AI相关任务方面的性能得到了全面提升。

2、AI芯片

随着人工智能技术的不断进步和应用场景的不断扩展,AI芯片作为AI技术的核心硬件,将在未来发挥越来越重要的作用。

首先,AI芯片将更加智能化和高效化。随着技术的不断进步,AI芯片将具备更强大的计算能力和更高效的并行处理能力,能够满足人工智能应用对大规模数据处理和复杂计算的需求。同时,AI芯片也将更加智能化,能够根据不同的应用需求进行自适应调整和优化,提高计算效率和精度。

其次,AI芯片将更加多样化。目前市场上已经出现了多种类型的AI芯片,包括GPU、FPGA、ASIC等。未来,随着应用场景的不断扩展,AI芯片将更加多样化,满足不同领域和不同应用的需求。