参考:

https://github.com/ollama/ollama

https://github.com/open-webui/open-webui

ollama最为大模型后端服务

open-webui前端聊天页面

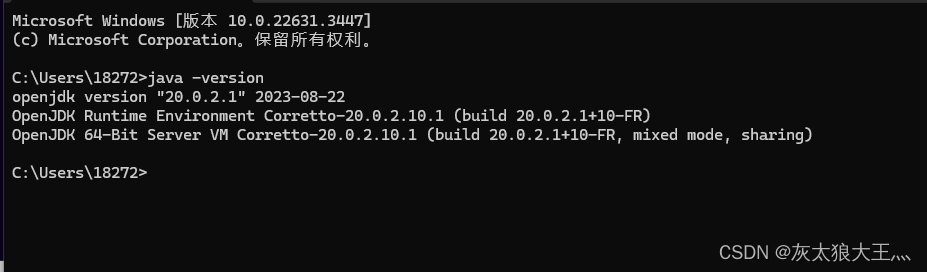

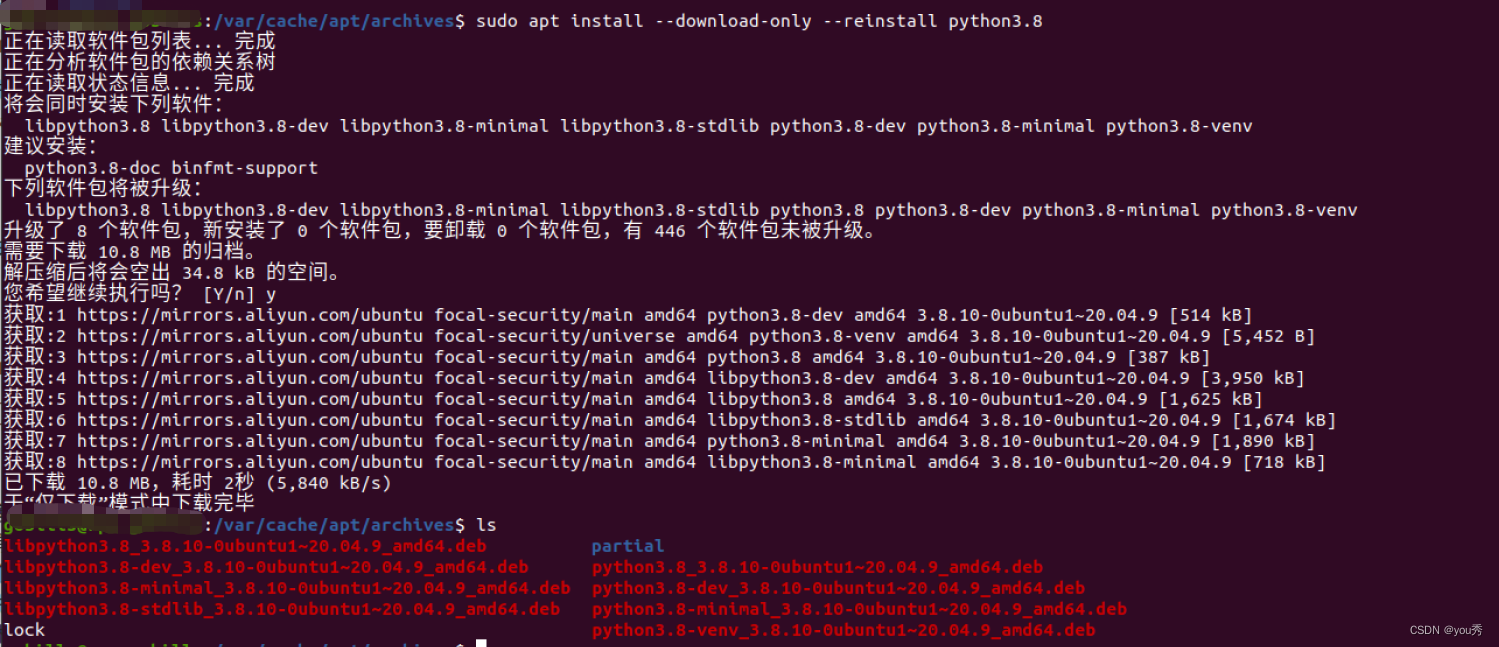

ollama直接下载客服端安装win cpu安装推理;open-webui使用docker安装

1、ollama

安装好后可以直接运行,cpu使用不稳定比较慢

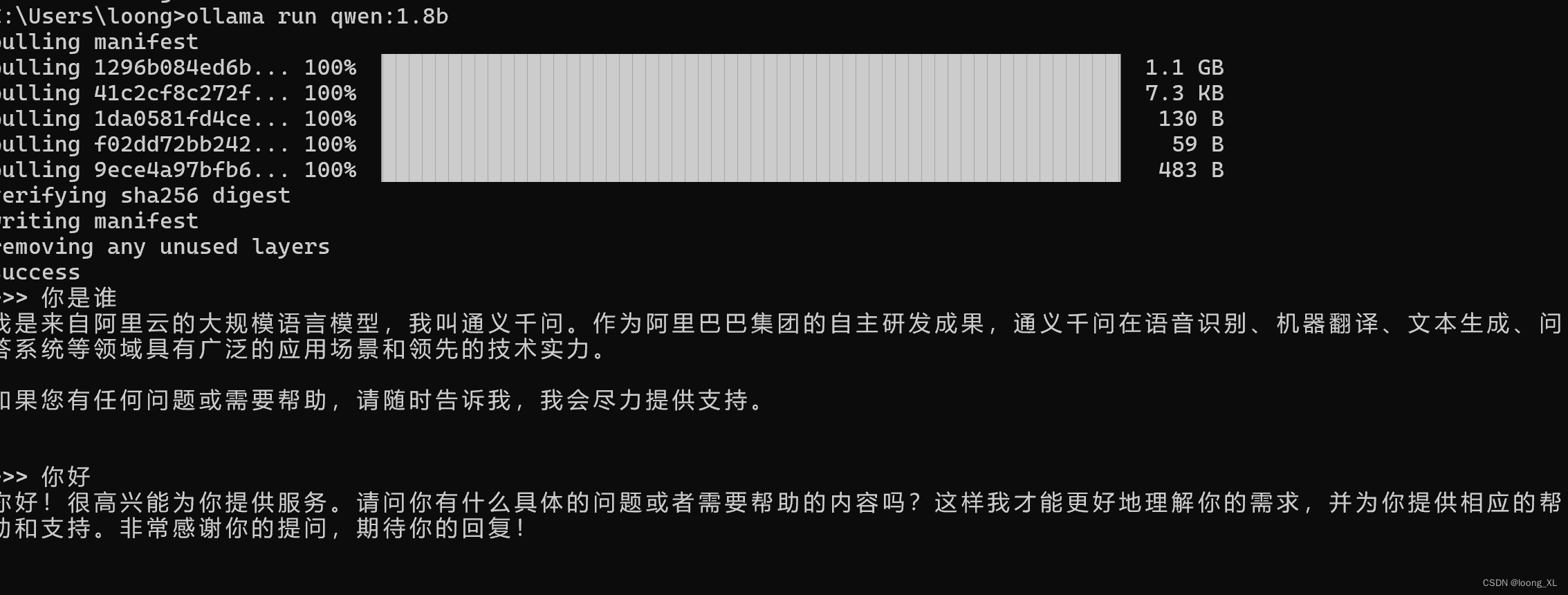

ollama run qwen:1.8b

具体可下载模型列表:https://ollama.com/library

2、open-webui

本地安装ollama运行后可以使用下面运行

docker run -d -p 3000:8080 --add