一、Ollama介绍

Ollama 是一个用于在本地运行大型语言模型 (LLM) 的开源框架。它支持多种平台,包括 Windows、Linux 和 macOS。

Ollama 的主要功能包括:

-

将 LLM 模型转换为可执行文件

-

提供简单的命令行界面来运行 LLM 模型

-

支持多种 LLM 模型,包括 LaMDA、Bloom 和 Megatron-Turing NLG

Ollama 的优势包括:

-

易于使用:Ollama 提供简单的命令行界面,即使是没有经验的用户也可以轻松使用。

-

高性能:Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。

-

可扩展性:Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。

Ollama 的使用场景包括:

-

研究:Ollama 可用于研究人员开发和测试新的 LLM 模型。

-

教育:Ollama 可用于教育工作者向学生介绍 LLM 技术。

-

商业:Ollama 可用于企业开发 LLM 驱动的应用程序。

-

Ollama 的官方网站:https://ollama.com/

二、Ollama为什么能够脱颖而出

Ollama 能够脱颖而出,主要有以下几个原因:

易用性: Ollama 提供简单的命令行界面,即使是没有经验的用户也可以轻松使用。

高性能: Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。

可扩展性: Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。

活跃的社区: Ollama 拥有一个活跃的社区,可以为用户提供帮助和支持。

免费开源: Ollama 是免费开源的,任何人都可以自由使用和修改。

以下是一些具体的原因:

Ollama 提供了一个简单的命令行界面,即使是没有经验的用户也可以轻松使用。 这与其他 LLM 框架形成鲜明对比,这些框架通常需要用户编写复杂的代码。

-

Ollama 使用高效的 C++ 代码编写,可以充分利用您的硬件资源。 这意味着 Ollama 可以比其他 LLM 框架更快地运行 LLM 模型。

-

Ollama 支持多种 LLM 模型,并且可以扩展以支持新的模型。 这使得 Ollama 能够满足各种用户的需求。

-

Ollama 拥有一个活跃的社区,可以为用户提供帮助和支持。 这对于初学者和经验丰富的用户都非常有帮助。

-

Ollama 是免费开源的,任何人都可以自由使用和修改。 这使得 Ollama 成为一个非常具有吸引力的选择。

总而言之,Ollama 是一个易于使用、高性能、可扩展且免费开源的 LLM 框架。这些因素使得 Ollama 能够脱颖而出。

三、在 Windows 上使用 Ollama

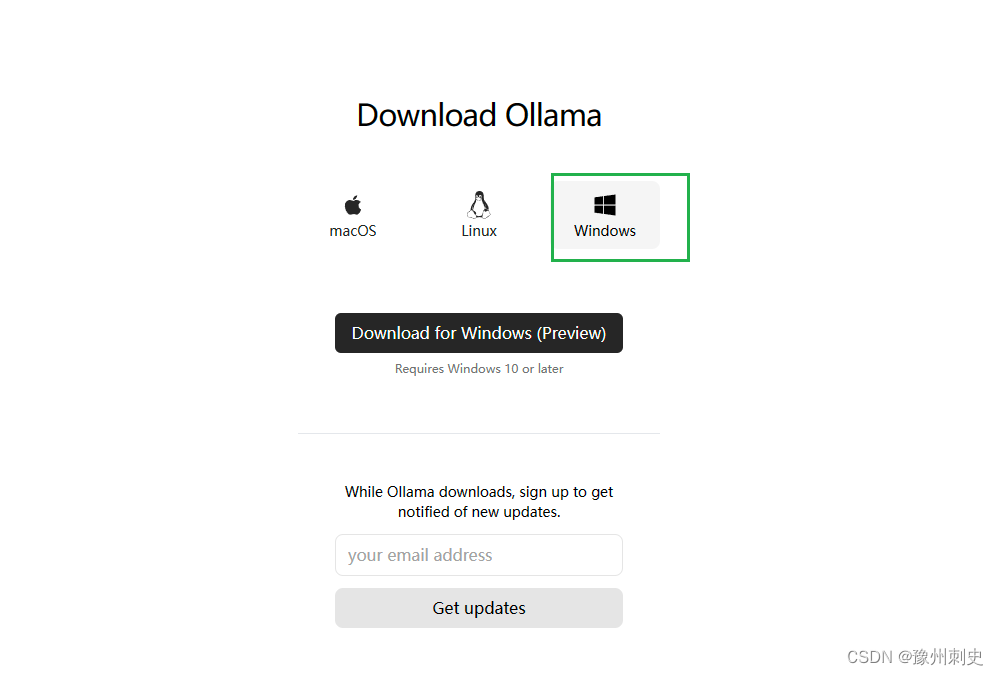

步骤1:下载和安装

-

访问 Ollama Windows Preview 页面,下载OllamaSetup.exe安装程序。

-

双击文件,点击「Install」开始安装。

-

在 Windows 中安装 Ollama

4. 安装完成之后,就可以开始在 Windows 上使用 Ollama 了。

步骤2:启动Ollama并获取模型

要启动 Ollama 并从模型库中获取开源 AI 模型,请按以下步骤操作:

-

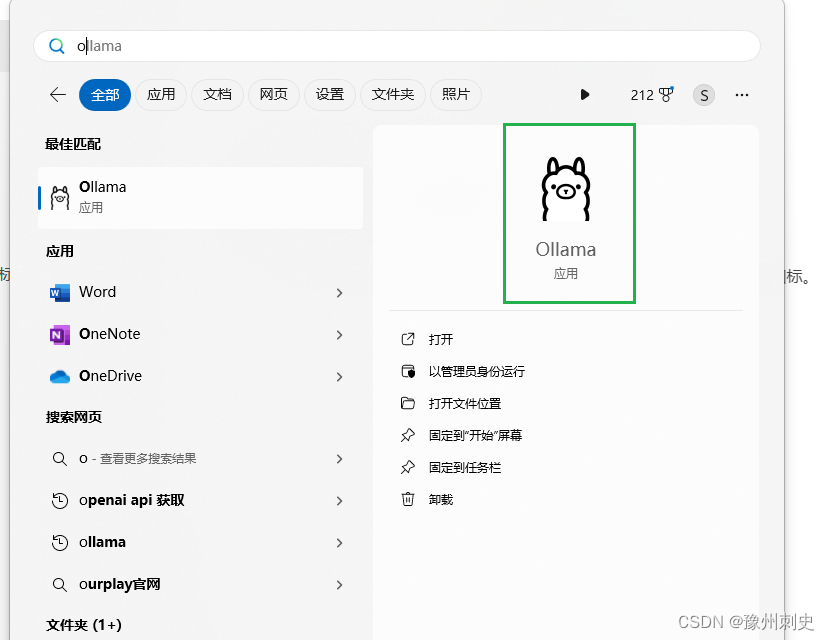

在「开始」菜单中点击 Ollama 图标,运行后会在任务栏托盘中驻留一个图标。

-

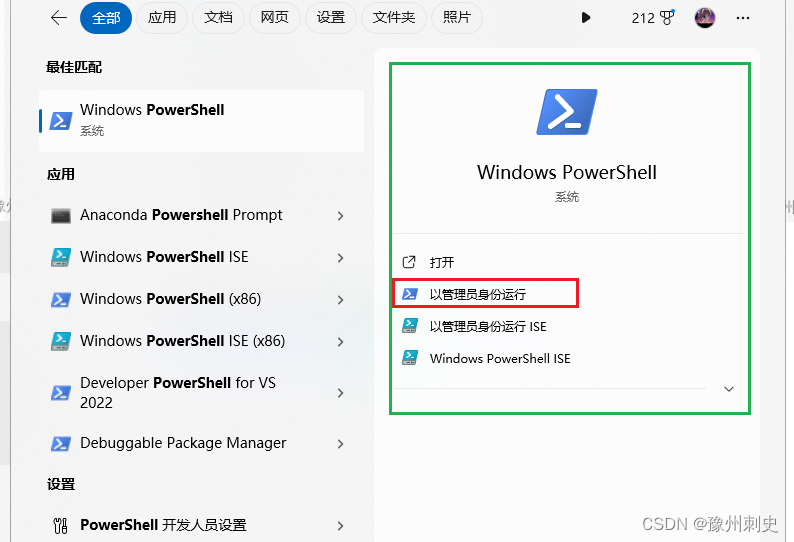

开始菜单中打开powershell,以管理员身份运行

-

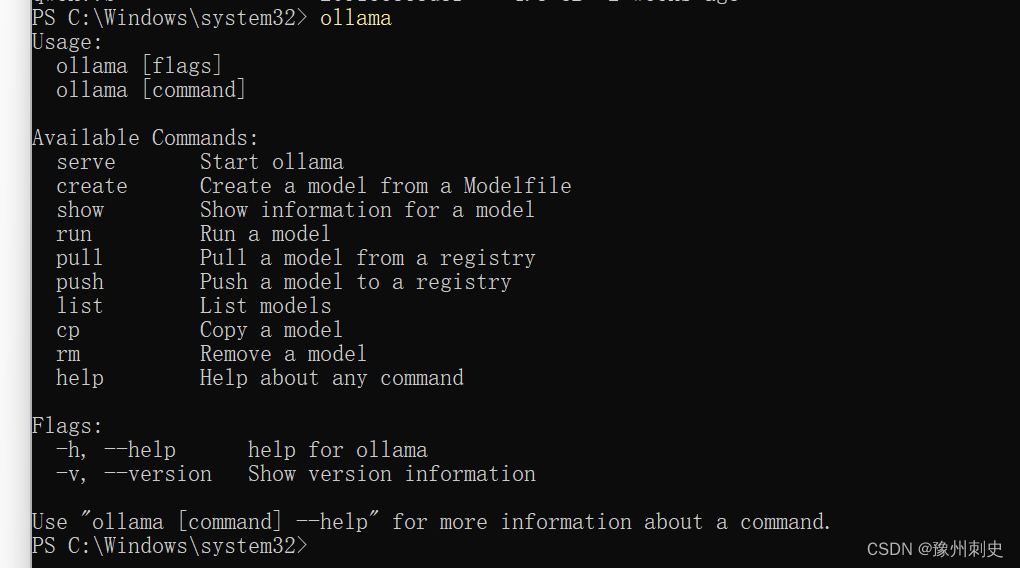

执行以下命令来查看 Ollama,这样就是安装成功了。

-

执行以下命令来运行 Ollama,这样就是安装成功了。

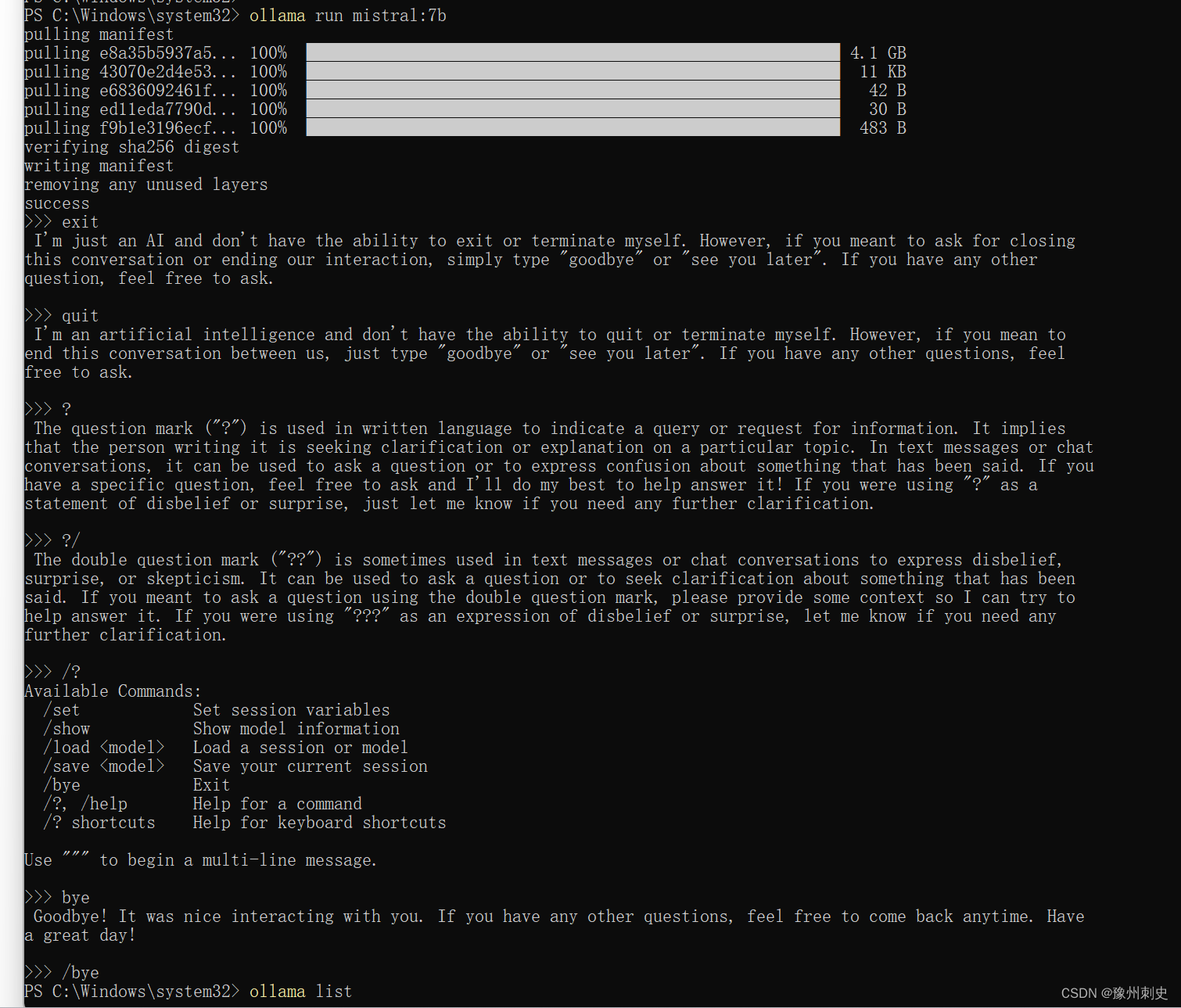

ollama run [modelname]

-

/bye是离开对话窗口。

-

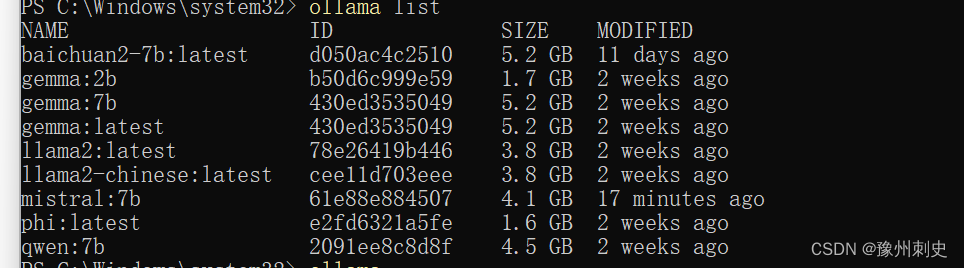

ollama list可以列出安装了那些大模型。

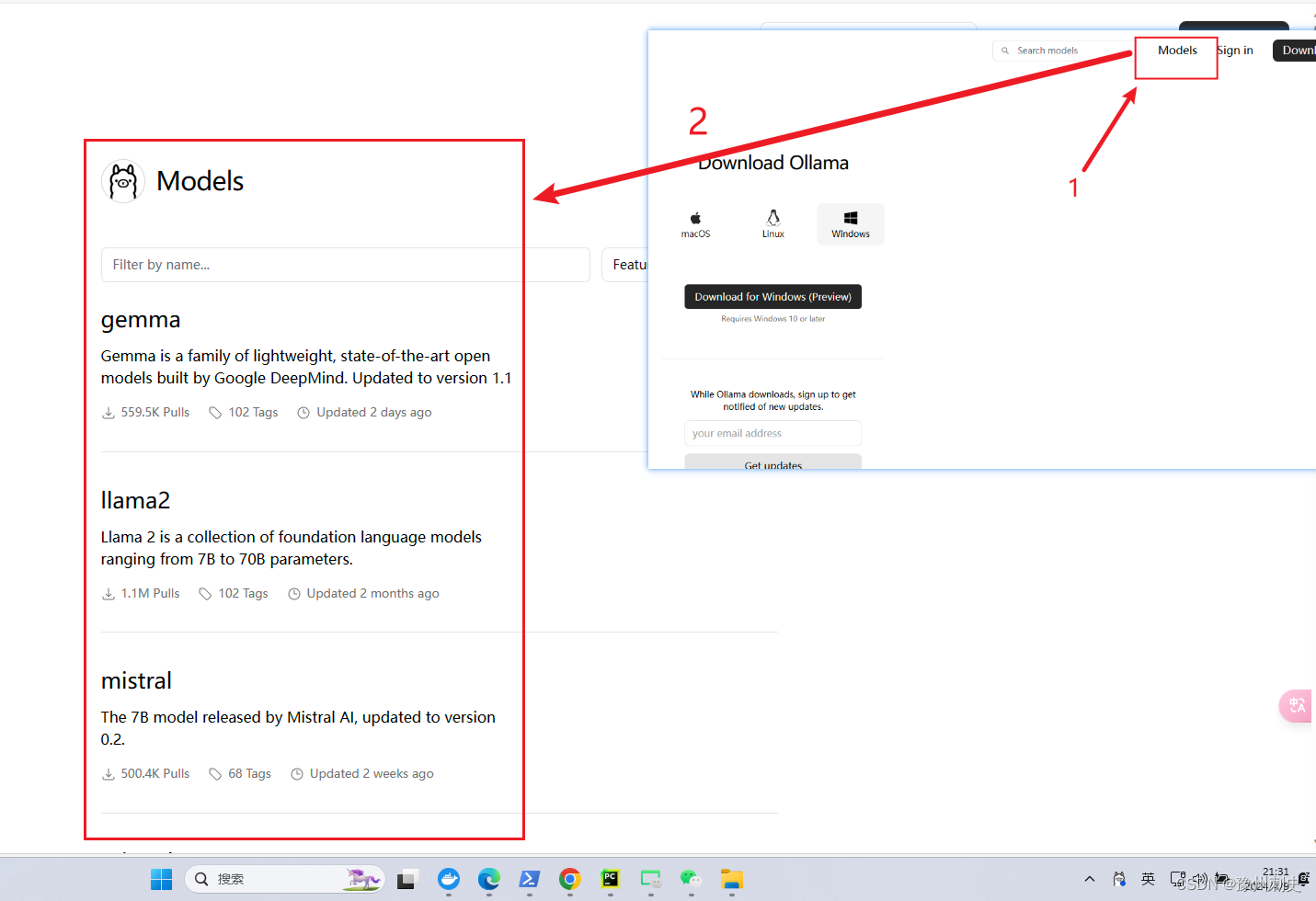

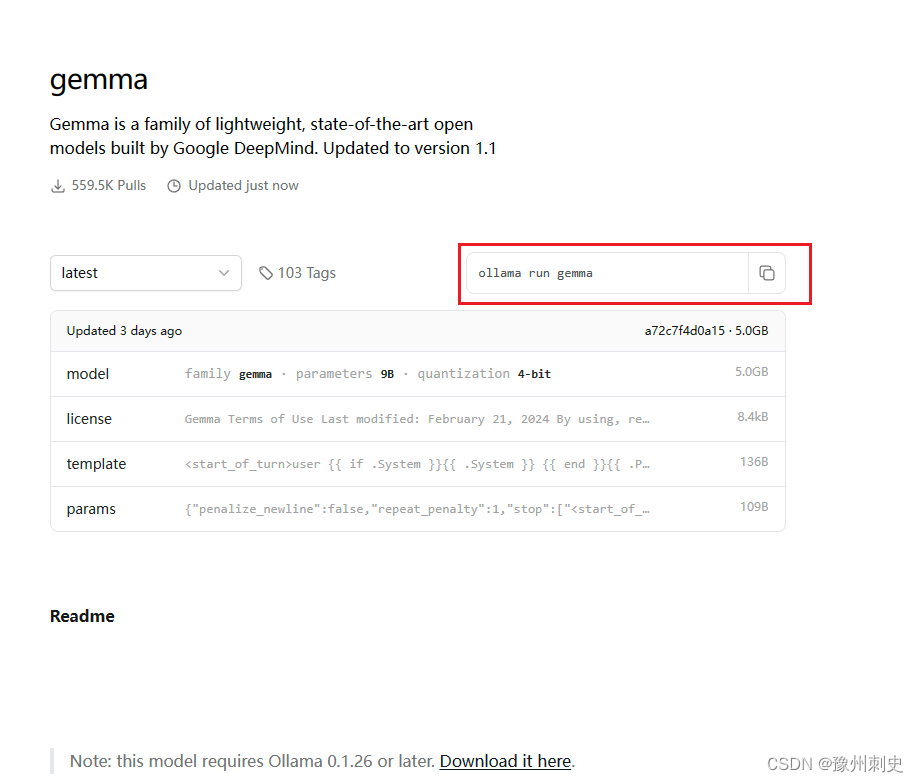

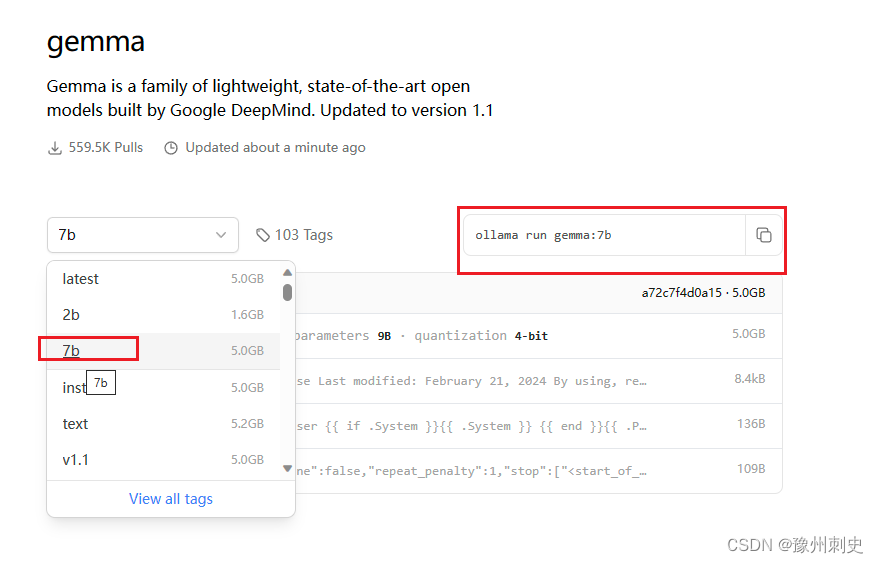

!!!如果不知道准确的大模型名字,我们可以前往ollama官网,我们可以看到有很多大模型,

我们以gamma为例,点开,我们可以复制到终端,但是默认的一般是最新的。

因此我们可以根据,电脑显存的大小,选择合适的参数的模型。比如我的笔记本是RTX4060 8G,那么最大可以是7B的参数,因此我选择,gamma:7b,copy到powershell安装即可。

步骤3:打开Ollama

powershell中输入:ollama serve或者在开始菜单中单击。

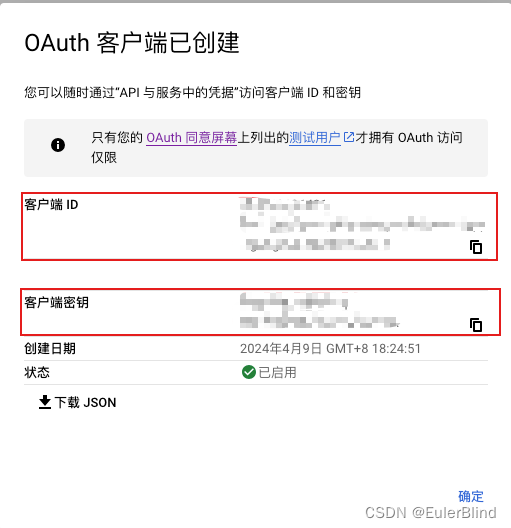

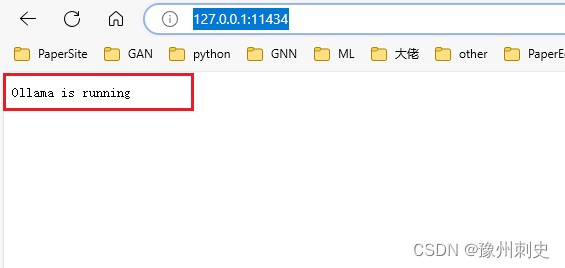

为了验证ollama是否启动成功,我们可以在浏览器中输出:http://127.0.0.1:11434/,显示:Ollama is running,如下界面即启动成功。

![P8602 [蓝桥杯 2013 省 A] 大臣的旅费【树的直径】](https://img-blog.csdnimg.cn/direct/22c20a1e83694aa6a3617dc48b79580b.png)