嗨嗨嗨!兄弟姐妹大家好哇!今天我们来学习ajax的get和post请求

一、了解ajax

Ajax(Asynchronous JavaScript and XML)是一种在 Web 开发中用于创建交互式网页应用程序的技术。通过 Ajax,网页可以在不重新加载整个页面的情况下,与服务器进行异步通信,从而实现动态加载内容和更新页面的部分内容。

在 Ajax 中,最常用的请求方法是 GET 和 POST。GET 请求用于从服务器获取数据,而 POST 请求用于向服务器提交数据。通过 GET 请求,可以向服务器发送查询参数,服务器根据这些参数返回相应的数据。这使得网页能够动态地获取和显示数据,而无需刷新整个页面。

二、ajax的get请求

Ajax 是一种在 Web 开发中用于创建交互式网页应用程序的技术。在爬取包含 Ajax 请求的网页时,通常需要模拟这些请求,以获取完整的数据。Python 爬虫可以通过模拟这些 Ajax 请求来获取动态加载的内容。

要实现爬取包含 Ajax 请求的网页,通常需要以下步骤:

- 分析网页:使用开发者工具或类似工具分析网页,找到包含 Ajax 请求的 URL、请求方法、请求参数等信息。

- 模拟请求:使用 Python 的网络请求库(如 requests)构造并发送与 Ajax 请求相同的请求。

- 解析响应:解析 Ajax 请求的响应内容,提取所需的数据。

- 循环请求:如果需要获取多页数据,可以根据网站的分页规则构造多个请求。

以下是一个简单的示例,演示如何使用 Python 爬虫模拟 Ajax 的 GET 请求:

import requests

url = '<https://api.example.com/data>'

params = {

'param1': 'value1',

'param2': 'value2'

}

response = requests.get(url, params=params)

if response.status_code == 200:

data = response.json()

print(data)

else:

print('请求失败:', response.status_code)

在这个示例中,我们使用了 requests 库发送了一个带有参数的 GET 请求,并将响应解析为 JSON 格式的数据。请注意,实际的 Ajax 请求可能需要更复杂的参数配置和数据解析。

案列:

(1)爬取豆瓣电影前10页的数据

要爬取豆瓣电影前10页的数据,首先需要找到豆瓣电影的网页地址和Ajax请求的接口。以豆瓣电影Top250为例,网页地址为 https://movie.douban.com/top250,Ajax请求接口为 https://movie.douban.com/j/chart/top_list?type=11&interval_id=100%3A90&action=&start=0&limit=20。

接下来,我们可以编写Python代码来模拟Ajax请求,实现爬取豆瓣电影Top250前10页的数据。以下是一个示例代码:

import requests

import json

import time

url = '<https://movie.douban.com/j/chart/top_list>'

params = {

'type': '11', # 类型为电影Top250

'interval_id': '100:90', # 区间为100年代到90年代

'action': '', # 未指定动作

'start': '0', # 起始位置,每页20个

'limit': '20' # 每页数量

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/100.0.4896.75 Safari/537.36'

}

movies_data = []

for page in range(10): # 爬取前10页

params['start'] = str(page * 20) # 计算每页起始位置

try:

response = requests.get(url, params=params, headers=headers)

if response.status_code == 200:

movies = response.json()

movies_data.extend(movies)

time.sleep(1) # 每次请求后暂停1秒,减少请求频率

else:

print('请求失败:', response.status_code)

break

except requests.exceptions.RequestException as e:

print('请求异常:', e)

break

# 打印所有电影信息

for movie in movies_data:

print(f"电影名称:{movie['title']}")

print(f"评分:{movie['score']}")

print(f"链接:{movie['url']}")

print()

请注意,豆瓣网站有反爬虫机制,频繁的请求可能会被拒绝。建议在开发爬虫时遵守网站的规定,避免对网站造成过大的负担。

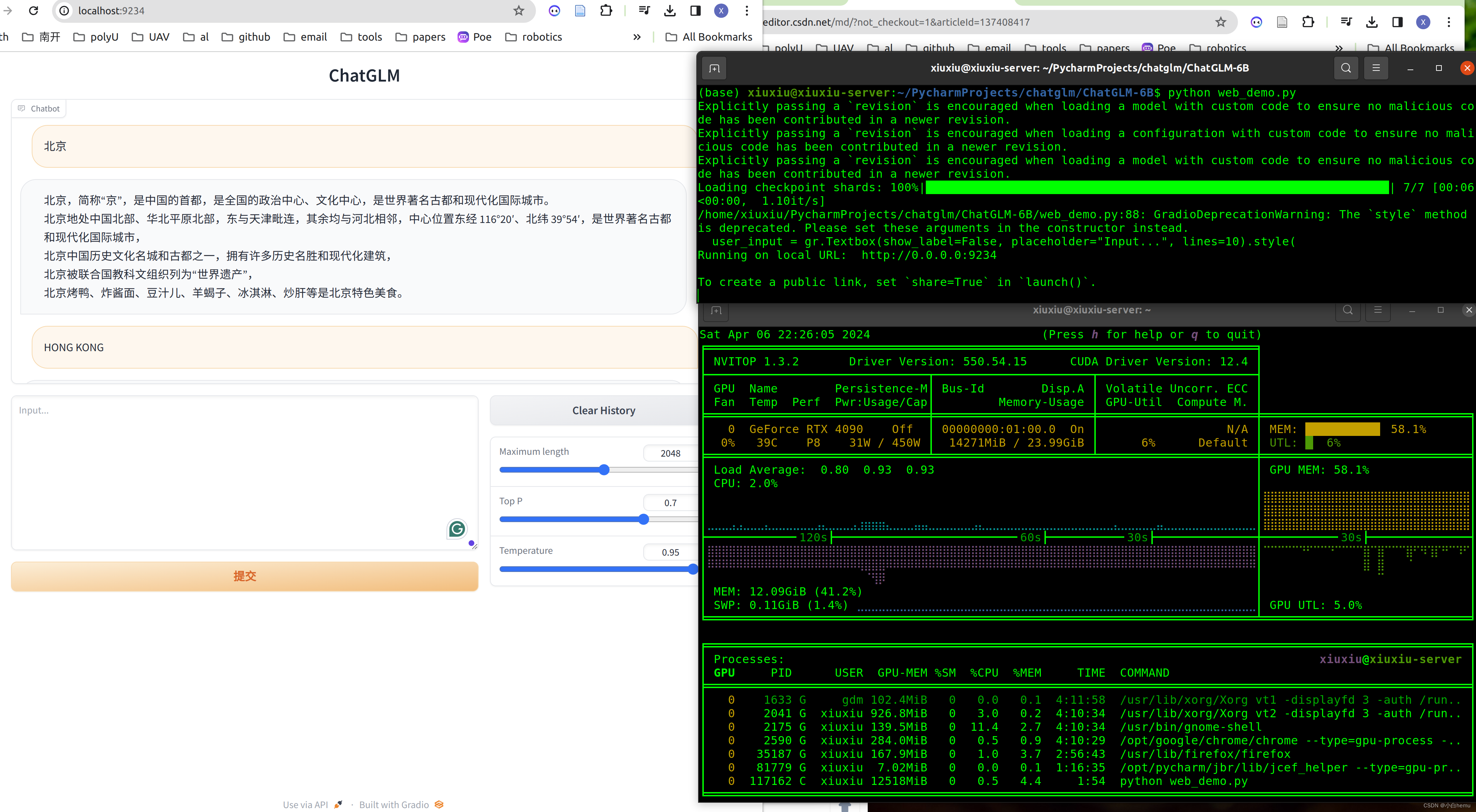

结果:

(2)

贴近实际情况的示例,演示如何使用Python的Requests库和Beautiful Soup库爬取一个使用Ajax加载的网页。我们将从一个示例网站获取数据,该网站使用Ajax加载商品信息,并且商品信息支持分页。

假设我们要爬取的网站是 https://www.example.com/products,该网站上有关于商品的信息,商品信息通过Ajax加载,每次加载10个商品,我们需要模拟点击“加载更多”按钮来获取所有商品信息。

import requests

from bs4 import BeautifulSoup

import json

url = '<https://www.example.com/products>'

params = {

'page': 1, # 第一页商品

'limit': 10 # 每页10个商品

}

products_data = []

while True:

response = requests.get(url, params=params)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# 找到商品数据所在的标签

products = soup.find('div', class_='products-list')

if not products:

break

# 提取商品数据

for product in products.find_all('div', class_='product'):

product_info = {

'name': product.find('h3').text.strip(),

'price': product.find('span', class_='price').text.strip(),

'description': product.find('p', class_='description').text.strip()

}

products_data.append(product_info)

# 判断是否还有下一页商品

if soup.find('a', class_='load-more'):

params['page'] += 1

else:

break

else:

print('请求失败:', response.status_code)

break

# 打印所有商品信息

for product_info in products_data:

print(f"商品名称:{product_info['name']}")

print(f"价格:{product_info['price']}")

print(f"描述:{product_info['description']}")

print()

请注意,实际网站的商品加载可能会有更复杂的逻辑和参数,您需要根据具体情况调整代码。同时,注意网站的爬取规则,不要对网站造成过大的负担或违反其使用规定。

三、ajax的post请求

Python 爬虫中的 Ajax POST 请求指的是使用 Python 发送模拟浏览器发送的 POST 请求,以获取网页上通过 Ajax 加载的动态内容。Ajax 是一种在 Web 开发中使用的技术,能够在不刷新整个页面的情况下,通过异步请求与服务器进行通信,并更新页面的部分内容。

要实现 Python 爬虫的 Ajax POST 请求,一般需要以下步骤:

- 分析请求:使用开发者工具分析网页,找到需要获取数据的 Ajax 请求的 URL、请求方式、请求参数等信息。

- 构造请求:使用 Python 的 requests 库构造 POST 请求,并设置请求头部信息,模拟浏览器发送请求。

- 发送请求:发送构造好的 POST 请求到服务器,并获取返回的响应数据。

- 处理响应:解析响应数据,提取需要的信息,如 JSON 格式的数据或 HTML 内容。

下面是一个示例,演示了如何使用 Python 爬虫发送 Ajax 的 POST 请求:

import requests

url = '<https://example.com/api/data>'

data = {

'param1': 'value1',

'param2': 'value2'

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/100.0.4896.75 Safari/537.36',

'X-Requested-With': 'XMLHttpRequest' # 模拟 Ajax 请求的关键头部信息

}

response = requests.post(url, data=data, headers=headers)

if response.status_code == 200:

result = response.json()

print(result)

else:

print('请求失败:', response.status_code)

在这个示例中,我们使用 requests 库发送了一个带有数据的 POST 请求,并设置了模拟 Ajax 请求的关键头部信息 'X-Requested-With': 'XMLHttpRequest'。根据实际情况,你可能需要调整 URL、数据和请求头部信息。

案例:

面是一个示例,演示了如何使用 Python 爬虫模拟登录并发送带有身份验证信息的 Ajax POST 请求来获取登录后的数据:

import requests

# 登录页面 URL

login_url = '<https://example.com/login>'

# 登录表单数据

login_data = {

'username': 'your_username',

'password': 'your_password'

}

# 登录请求,使用 session 保持会话状态

session = requests.Session()

response = session.post(login_url, data=login_data)

if response.status_code == 200:

# 登录成功后的操作

# 获取登录后页面的数据,假设为 <https://example.com/data>

data_url = '<https://example.com/data>'

data_response = session.post(data_url)

if data_response.status_code == 200:

# 处理数据

data = data_response.json()

print(data)

else:

print('获取数据失败:', data_response.status_code)

else:

print('登录失败:', response.status_code)

在这个示例中,我们首先发送了一个 POST 请求来模拟登录。如果登录成功,会话将保持,然后我们使用相同的会话发送了另一个带有身份验证信息的 POST 请求来获取登录后的数据。这种方式可以模拟用户在浏览器中的操作,获取登录后才能访问的数据。

四、总结

总的来说,在使用Python进行网络爬虫时,要根据具体的需求和目标网站的接口设计选择合适的请求方式。GET请求适合用于获取数据,而POST请求适合用于提交数据。通过**requests**库,我们可以方便地发送这两种类型的AJAX请求,并获取服务器响应。使用正确的请求方式能够更有效地进行数据采集和处理,提高爬虫的效率和可靠性。