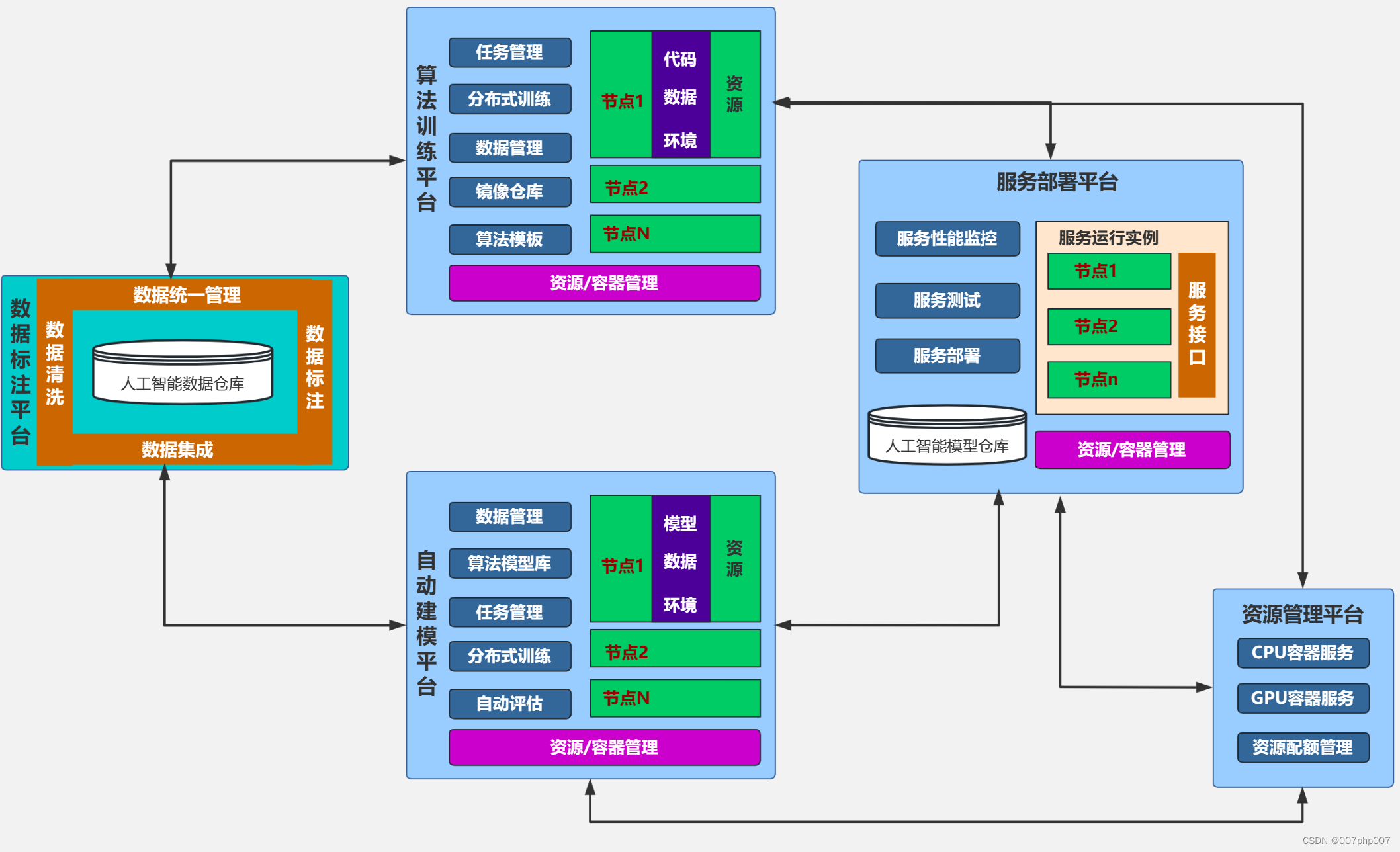

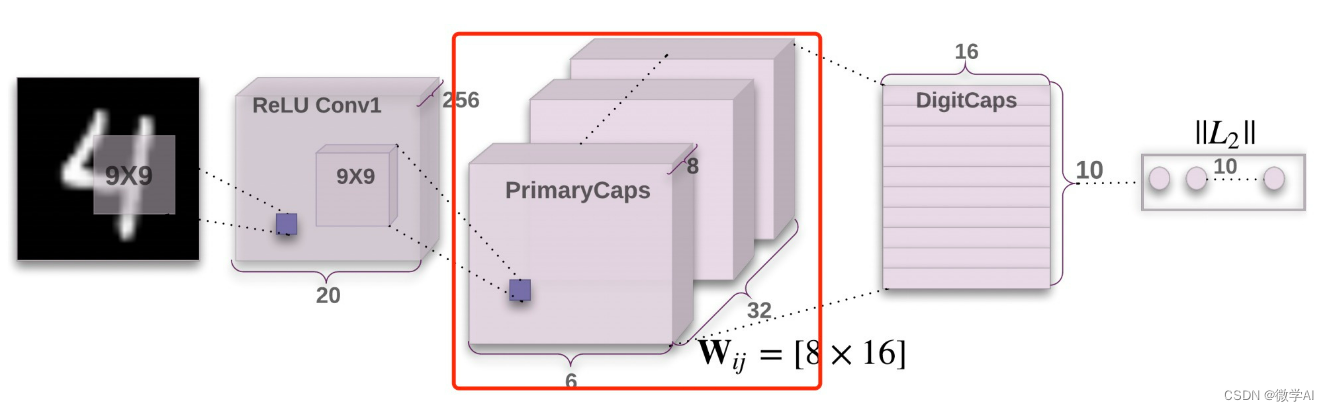

大家好,我是微学AI,今天给大家介绍一下人工智能(pytorch)搭建模型26-基于pytorch搭建胶囊模型(CapsNet)的实践,CapsNet模型结构介绍。CapsNet(Capsule Network)是一种创新的深度学习模型,由计算机科学家Geoffrey Hinton及其团队提出。该模型在图像识别、物体检测、姿态估计等领域展现出显著优势。相较于传统卷积神经网络,CapsNet的核心在于引入了“胶囊”概念,每个胶囊代表一种特定特征或对象的概率性实例化参数,能够捕捉到输入数据的更多复杂信息,如方向、大小、比例等。在模型结构上,CapsNet主要包括动态路由算法和胶囊层两个关键部分。动态路由过程允许高层次胶囊通过迭代投票机制选择性地从低层次胶囊接收信息,从而实现对输入空间中潜在实体的精确建模。而胶囊层则包含多个胶囊,每个胶囊输出一个向量,其长度表示相应特征的存在概率,方向则编码特征的具体属性。

CapsNet通过独特的胶囊结构和动态路由机制,有效提升了模型在处理具有复杂空间关系问题时的表现,为计算机视觉领域带来了新的解决方案。

文章目录

- 一、胶囊网络的主要应用场景

- 1.1 图像分类任务

- 1.2 物体检测与分割

- 二、胶囊网络模型结构详解

- 2.1 基本单元——胶囊

- 2.2 动态路由算法

- 四、CapsNet模型的数学原理

- 五、CapsNet模型的代码实现

一、胶囊网络的主要应用场景

1.1 图像分类任务

在深度学习领域中,胶囊网络(Capsule Network)作为一种新型的神经网络架构,尤其在图像分类任务上展现出了其独特的优势和应用价值。

首先,在传统的图像分类任务中,如MNIST手写数字识别、CIFAR-10/100小图像分类等,胶囊网络通过模仿人类视觉系统的工作原理,利用“胶囊”来捕获物体的实例属性,如位置、大小、方向等,并通过动态路由算法更新这些信息,从而更准确地识别图像中的对象,即使在存在轻微变形、视角变化或部分遮挡的情况下也能保持较高的分类准确性。

在复杂图像场景下的细粒度图像分类问题中,例如衣物属性识别、人脸表情分类、医学图像分析等,胶囊网络能够更好地捕捉并保持图像的局部特征与整体结构之间的关系,避免了传统卷积神经网络在处理这类问题时容易丢失空间信息和忽视实体间关系的问题。胶囊网络在图像分类任务上的另一个重要应用是实现少样本学习或者是一类新的样本的学习,它能够在有限的训练数据下快速泛化,对于新类别具有较好的适应性和推广性。

胶囊网络在图像分类任务中的主要应用场景包括但不限于基础图像分类、细粒度图像分类以及对有限样本的学习,其独特的设计使其在处理这些问题时展现出更高的性能和更强的鲁棒性。

1.2 物体检测与分割

在计算机视觉领域中,胶囊网络作为一种先进的深度学习模型,在物体检测与分割任务上展现出了强大的性能和潜力。

首先,对于物体检测任务,传统的深度学习方法如 Faster R-CNN、YOLO 等在处理复杂场景和小目标检测时可能会遇到困难。而胶囊网络通过引入“胶囊”这一概念,能够更好地捕捉物体的空间布局和姿态信息,从而更准确地定位和识别图像中的物体。每个胶囊代表一种特定的物体特征或部件,通过动态路由算法计算胶囊间的激活关系,可以有效解决物体变形、旋转等问题,提高物体检测的精度和鲁棒性。

在图像分割任务上,胶囊网络同样表现出色。图像分割要求模型不仅能识别出图像中的物体,还要精确到像素级别的分类。胶囊网络通过其独特的设计,能够对图像进行更细致的解析,输出每个像素所属物体类别的概率分布图,实现对物体边界的精准分割。例如,基于胶囊网络的 CapsNet 可以在医疗影像分析、自动驾驶等领域中,对病灶区域、车辆、行人等进行高精度的像素级分割,为后续的决策分析提供详尽的信息支持。

因此,无论是物体检测还是图像分割,胶囊网络都以其独特的优势拓宽了应用范围,提升了任务处理效果,成为当前计算机视觉研究的重要方向之一。

二、胶囊网络模型结构详解

2.1 基本单元——胶囊

在胶囊网络模型中,其核心创新点和基本构建单元就是“胶囊”(Capsule)。传统的神经网络通常使用激活函数处理线性输入,输出的是标量值,而胶囊则是一种能够输出向量的神经网络单元,它不仅包含对象是否存在(即激活程度)的信息,还包含了对象的各种属性信息,如位置、大小、方向等。

每个胶囊可以被看作是一个小型神经网络模块,负责从输入数据中提取特定类型的特征,并以向量的形式表达这些特征的属性。例如,在图像识别任务中,一个胶囊可能代表物体的一部分或整个物体,其输出向量的长度表示该物体存在的概率或实例参数,而方向则编码了物体的特定属性,如姿态。

在胶囊网络中,各层胶囊间通过动态路由算法进行信息传递,这种机制使得高层次的胶囊能够依据低层次胶囊的投票结果来判断相应特征是否出现以及其属性如何,从而提高了模型对复杂场景的理解和建模能力,增强了模型的鲁棒性和准确性。

2.2 动态路由算法

在胶囊网络模型中,动态路由算法扮演着核心角色,它是实现胶囊网络内部信息高效传递和整合的关键机制。动态路由算法的主要目标是确定并优化不同层次胶囊之间的连接权重,以便于高阶胶囊能够精确地捕获低阶胶囊的激活模式。

具体来说,动态路由过程始于低层胶囊输出的向量表示,这些向量包含了丰富的局部特征信息。每个高阶胶囊通过预测向量与所有低阶胶囊的输出进行加权求和,这里的权重并非预先设定,而是在路由过程中动态计算得出。

该算法采用迭代投票的方式进行,首先初始化所有到更高层胶囊的输入权重,然后进入循环迭代过程。在每次迭代中,每个高阶胶囊基于当前接收的输入向量计算其自身激活概率,并据此更新与低阶胶囊之间的耦合系数(即路由权重)。这个过程不断重复,直至耦合系数稳定或达到预设的最大迭代次数。

最终,动态路由算法使得高阶胶囊能够更好地识别并聚合来自低阶胶囊的特征,形成更复杂、更具语义的特征表示,从而有效提升了模型对图像等复杂数据的理解和表达能力。

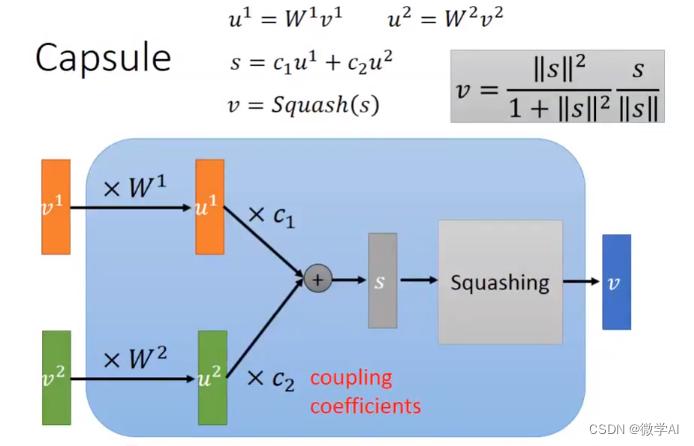

四、CapsNet模型的数学原理

在CapsNet中,胶囊是一个神经网络单元,它能够封装一组向量,每个向量代表特定实例参数(如位置、大小、姿态等)。不同于传统神经网络中的标量激活值,胶囊输出的是一个向量,其模长表示相应特征的存在概率,方向则编码特征的具体属性。

- 动态路由算法(Dynamic Routing):

动态路由是CapsNet的核心机制,用于在不同层次的胶囊之间传递信息。设低层胶囊 u i u_i ui的输出为 m i m_i mi,高层胶囊 v j v_j vj的预测输出为 u ^ j \hat{u}_j u^j,则更新公式如下:

c i j = exp ( b i j ) ∑ k exp ( b i k ) v j = ∑ i c i j ⋅ s q u a s h ( m i ⋅ W i j ) c_{ij} = \frac{\exp(b_{ij})}{\sum_k \exp(b_{ik})} \\ v_j = \sum_i c_{ij} \cdot squash(m_i \cdot W_{ij}) cij=∑kexp(bik)exp(bij)vj=i∑cij⋅squash(mi⋅Wij)

其中, b i j b_{ij} bij是通过迭代更新得到的耦合系数, W i j W_{ij} Wij是连接两个胶囊层的权重矩阵, s q u a s h ( ⋅ ) squash(\cdot) squash(⋅)函数用于压缩输入向量的长度并保持方向不变,通常定义为:

s q u a s h ( x ) = ∥ x ∥ 2 1 + ∥ x ∥ 2 x ∥ x ∥ squash(x) = \frac{\|x\|^2}{1 + \|x\|^2} \frac{x}{\|x\|} squash(x)=1+∥x∥2∥x∥2∥x∥x

- Capsule Layer:

在CapsNet中,每一层胶囊层都会执行上述动态路由过程,以实现对输入空间中潜在实体及其属性的高效建模。

- Reconstruction Layer:

CapsNet还包括一个解码器网络,用于从最高层胶囊的输出重建输入图像,这有助于训练过程中的正则化,并使得胶囊学习到更具判别性的特征。这部分涉及的数学原理主要与常规深度学习中的卷积或全连接层相关。

以上为CapsNet模型的部分数学原理,实际当中模型结构会更复杂,包括多层初级胶囊层、主胶囊层以及重构层的设计等。

五、CapsNet模型的代码实现

以下是一个基于PyTorch实现的CapsNet(Capsule Network)的基本模型结构示例代码。请注意,由于篇幅和复杂性限制,这里仅提供核心模型结构部分,完整的训练和测试代码需要您根据实际项目需求进行补充。

import torch

from torch import nn

class PrimaryCaps(nn.Module):

def __init__(self, in_channels=256, out_capsules=8, out_capsule_dim=8, kernel_size=9, stride=2):

super(PrimaryCaps, self).__init__()

self.capsules = nn.ModuleList([

nn.Conv2d(in_channels=in_channels, out_channels=out_capsules, kernel_size=kernel_size, stride=stride, padding=0)

for _ in range(out_capsules)])

def forward(self, x):

u = [capsule(x) for capsule in self.capsules]

u = torch.stack(u, dim=1)

u = u.view(x.size(0), -1, 1, 1)

return squash(u)

def squash(vectors, axis=-1):

s_squared_norm = (vectors ** 2).sum(axis=axis, keepdim=True)

scale = s_squared_norm / (1 + s_squared_norm)

return scale * vectors / torch.sqrt(s_squared_norm)

class CapsuleLayer(nn.Module):

def __init__(self, num_capsules, num_routes, in_capsule_dim, out_capsule_dim, routing_iterations=3):

super(CapsuleLayer, self).__init__()

self.in_capsule_dim = in_capsule_dim

self.out_capsule_dim = out_capsule_dim

self.num_routes = num_routes

self.num_capsules = num_capsules

self.routing_iterations = routing_iterations # 添加这一行,将routing_iterations保存为类的属性

self.W = nn.Parameter(torch.randn(1, num_routes, in_capsule_dim, out_capsule_dim))

def forward(self, x):

batch_size = x.size(0)

x = x.unsqueeze(1)

W = self.W.repeat(batch_size, 1, 1, 1)

u_hat = torch.matmul(W, x)

b_ij = torch.zeros(batch_size, self.num_routes, self.num_capsules).to(x.device)

for i in range(routing_iterations):

c_ij = squash(b_ij)

s_j = (u_hat @ c_ij.permute(0, 2, 1)).squeeze(dim=-1)

v_j = squash(s_j)

if i != routing_iterations - 1:

b_ij = b_ij + (x @ u_hat.permute(0, 2, 1)).squeeze(dim=-1).unsqueeze(dim=-1)

return v_j

# 示例:构建一个简单的CapsNet模型

class CapsNet(nn.Module):

def __init__(self):

super(CapsNet, self).__init__()

self.conv_layer = nn.Conv2d(1, 256, kernel_size=9, stride=1)

self.primary_capsules = PrimaryCaps(in_channels=256, out_capsules=32, out_capsule_dim=8)

self.digit_capsules = CapsuleLayer(num_capsules=10, num_routes=32 * 6 * 6, in_capsule_dim=8, out_capsule_dim=16)

def forward(self, x):

x = self.conv_layer(x)

x = self.primary_capsules(x)

x = self.digit_capsules(x)

return x

# 创建模型实例并查看模型结构

model = CapsNet()

print(model)

以上代码实现了CapsNet中的主要组件:初级胶囊层(PrimaryCaps)和动态路由的胶囊层(CapsuleLayer)。在实际应用中,你可能还需要添加额外的重构网络层以进一步处理输出胶囊的预测向量,并定义损失函数如Margin Loss等。同时,别忘了对模型进行训练和验证。