当我们使用BERT或其他类似的预训练语言模型时,将句子转换为token的过程通常涉及以下几个步骤:

-

初始化Tokenizer:首先,我们需要导入相应的Tokenizer类,并根据需求选择合适的预训练模型进行初始化。

-

分词(Tokenization):分词是将句子分割成单词或者子词(subword)的过程。这个过程通常包括将句子转换为小写(如果使用的模型支持小写输入)、识别并标记单词边界、将单词分割为子词(如果使用的是基于WordPiece或Byte-Pair Encoding的模型),等等。

-

添加特殊Token:在分词之后,通常需要添加一些特殊的Token,如

[CLS](用于表示序列的开头)、[SEP](用于分隔不同的句子或文本段落)、以及可能的填充(padding)或掩码(mask)Token。 -

Token转换为ID:最后,Tokenizer将每个Token映射为对应的ID(整数表示),以便模型能够理解和处理。

下面是一个详细说明如何实现将句子转换为token的示例代码:

from transformers import BertTokenizer

# 1. 初始化Tokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 2. 输入句子

text = "Hello, how are you?"

# 3. 分词并添加特殊Token

tokens = tokenizer.tokenize(text)

tokens_with_special_tokens = ['[CLS]'] + tokens + ['[SEP]']

# 4. Token转换为ID

input_ids = tokenizer.convert_tokens_to_ids(tokens_with_special_tokens)

# 打印结果

print("原始句子:", text)

print("Tokenized结果:", tokens_with_special_tokens)

print("Token转换为ID:", input_ids)

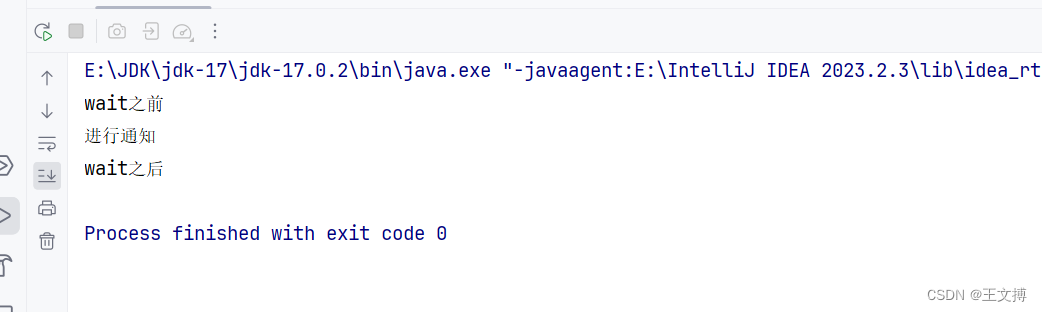

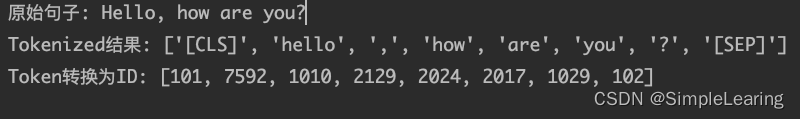

代码结果

在这个示例中,我们首先导入了BertTokenizer类,并使用from_pretrained方法加载了预训练的BERT模型(这里使用的是bert-base-uncased)。然后,我们创建了一个Tokenizer对象,并将要tokenize的句子传递给Tokenizer的tokenize方法,得到了tokenized的结果。

注意,以上代码只是一个简单的示例,实际应用中可能还会涉及到其他的处理步骤,比如长度截断、填充、掩码等。 另外,不同的预训练模型可能具有不同的Tokenizer实现,因此在使用时需要根据具体的模型进行调整。