Transformer 模型中增加一个 Token 对计算量的影响

- Transformer 模型中增加一个 Token 对计算量的影响

- 1. Transformer 模型简介

- 2. Token 对计算量的影响

- 3. 增加一个 Token 的计算量估算

- 4. 应对策略

- 5. 结论

Transformer 模型中增加一个 Token 对计算量的影响

Transformer 模型作为自然语言处理领域的一种重要模型,在机器翻译、文本生成等任务中取得了巨大成功。在 Transformer 模型中,Token 是模型输入的基本单位,增加 Token 的数量会直接影响模型的计算量和内存消耗。本文将详细探讨在 Transformer 模型中增加一个 Token 对计算量的影响,并分析其原因和应对策略。

1. Transformer 模型简介

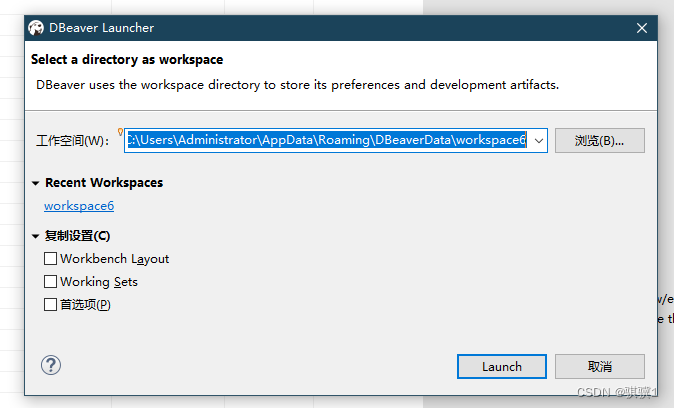

Transformer 模型是由 Vaswani 等人于2017年提出的,它完全基于自注意力机制(Self-Attention)实现了对输入序列的处理。Transformer 模型由编码器(Encoder)和解码器(Decoder)组成,每个部分都由多个相同的层堆叠而成。

2. Token 对计算量的影响

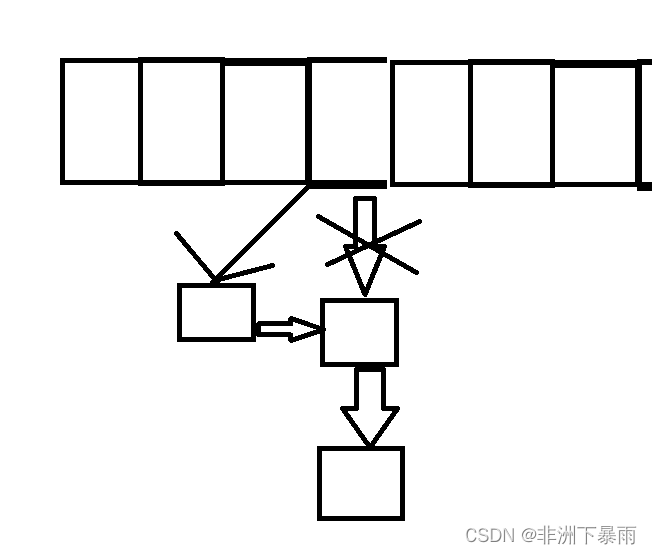

在 Transformer 模型中,每个 Token 都要经过多层的自注意力机制和前馈神经网络(Feedforward Neural Network)进行处理。增加一个 Token 将会引起以下计算量的变化:

- 自注意力机制计算量:每个 Token 都要计算与其他 Token 的注意力权重,增加一个 Token 将导致注意力矩阵的大小增加,从而增加自注意力机制的计算量。

- 前馈神经网络计算量:每个 Token 都要通过前馈神经网络进行处理,增加一个 Token 将导致前馈神经网络的输入维度增加,进而增加计算量。

- 参数量增加:增加一个 Token 还将导致模型的参数量增加,因为每个 Token 都有对应的查询、键和值向量,这些参数数量与 Token 的数量成正比。

3. 增加一个 Token 的计算量估算

假设原来的 Transformer 模型中有 N N N 个 Token,每个 Token 的嵌入维度为 d model d_{\text{model}} dmodel,则增加一个 Token 后的计算量增加可以估算如下:

- 自注意力机制计算量增加:自注意力机制的计算量与输入序列的长度 N N N 的平方成正比,因此增加一个 Token 后,自注意力机制的计算量将增加大约 O ( N 2 ) O(N^2) O(N2)。

- 前馈神经网络计算量增加:前馈神经网络的计算量与输入序列的长度 N N N 成正比,因此增加一个 Token 后,前馈神经网络的计算量也将增加大约 O ( N ) O(N) O(N)。

- 参数量增加:增加一个 Token 将会增加模型的参数量,假设每个 Token 对应的参数量为 d model d_{\text{model}} dmodel,则增加一个 Token 后,模型的参数量将增加 d model d_{\text{model}} dmodel。

综合以上估算,增加一个 Token 会导致自注意力机制的计算量增加 O ( N 2 ) O(N^2) O(N2),前馈神经网络的计算量增加 O ( N ) O(N) O(N),同时模型的参数量增加 d model d_{\text{model}} dmodel。这些增加会使得模型的计算复杂度和存储需求增加,需要根据具体情况进行权衡和优化。

4. 应对策略

针对增加一个 Token 导致的计算量增加,可以采取以下策略来缓解:

- 稀疏注意力机制:使用稀疏注意力机制来减少自注意力机制的计算量,如使用局部注意力机制或者只计算相对较近的 Token 的注意力权重。

- 模型剪枝:通过模型剪枝技术来减少模型的参数量,从而降低计算量和内存消耗。

- 硬件加速:利用硬件加速器如 GPU 或 TPU 来加速模型的计算,从而缩短训练和推理时间。

5. 结论

增加一个 Token 将直接影响 Transformer 模型的计算量和内存消耗,需要综合考虑模型的设计和应用场景,采取合适的策略来缓解计算量增加带来的问题。在实际应用中,需要根据任务的需求和资源的限制,选择合适的模型配置和优化方法,以达到性能和效率的平衡。

版权声明:

原创博主:牛哄哄的柯南

博主原文链接:https://keafmd.blog.csdn.net/

个人博客链接:https://www.keafmd.top/

看完如果对你有帮助,感谢点击下面的点赞支持!

[哈哈][抱拳]

加油!

共同努力!

Keafmd

感谢支持牛哄哄的柯南,期待你的三连+关注~~

keep accumulate for my dream【共勉】

↓ ↓ ↓ 合作 交流 ↓ ↓ ↓