加利福尼亚州,洛杉矶 - 一项由南加州大学计算机科学系的研究人员进行的新研究,通过创新的数学方法,对OpenAI公司的最新语言模型GPT-3.5-Turbo的内部结构进行了深入分析。研究团队通过一系列精心设计的“暴力提问”实验,成功地估计了该模型的嵌入大小大约为4096,从而为理解这一先进人工智能系统的能力提供了新的视角。

嵌入大小是衡量语言模型复杂性和理解能力的关键指标。在Transformer模型架构中,嵌入大小直接关联到模型能够处理的信息量和理解的深度。研究人员利用奇异值分解(SVD)技术,通过分析模型的输出,确定了GPT-3.5-Turbo的知识维度上限。当模型无法输出新的有价值信息时,即表明已达到其嵌入大小所定义的理解能力极限。

该研究的主要作者Matthew Finlayson表示:“我们的工作不仅仅是对GPT-3.5-Turbo进行了一次技术层面的剖析,更是对当前大型语言模型能力的一次重要评估。通过确定嵌入大小,我们能够更好地理解这些模型的潜在能力和局限性。”

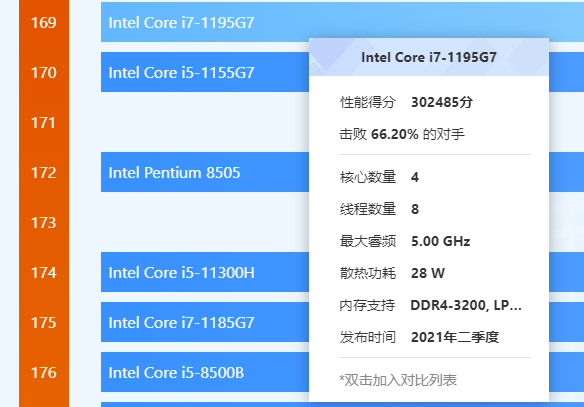

根据以往的数据,嵌入大小为4096的模型通常拥有大约70亿个参数。这一发现对于理解GPT-3.5-Turbo的整体架构和性能具有重要意义。研究人员还指出,尽管他们的估计与公开的开源模型相符,但实际的参数量可能会因模型架构的其他细节而有所变化。

此次研究不仅为人工智能领域的研究人员提供了宝贵的见解,也为公众了解这些日益强大的技术工具提供了透明度。随着人工智能技术的不断进步,对这些模型的深入理解和有效监管变得尤为重要。

关于研究团队: 该研究由南加州大学计算机科学系的Matthew Finlayson、Xiang Ren、Swabha Swayamdipta和Thomas Lord共同完成。他们的研究成果已在arXiv上发表,供学术界和公众审阅。