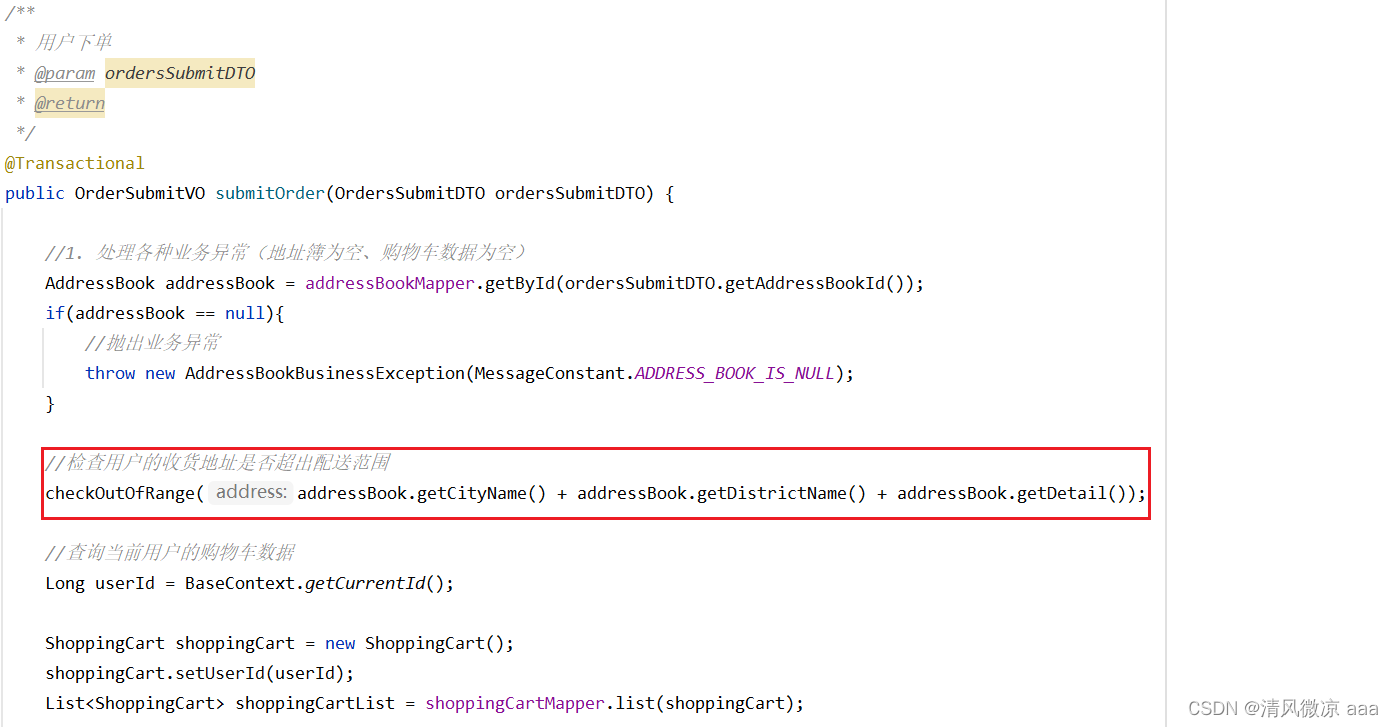

任务设定

- 鲜花养护(保持花的健康、如何浇水、施肥等)

- 鲜花装饰(如何搭配花、如何装饰场地等)

如果接到的是第一类问题,你要给ChatBot A指示;如果接到第二类的问题,你要给ChatBot B指示。

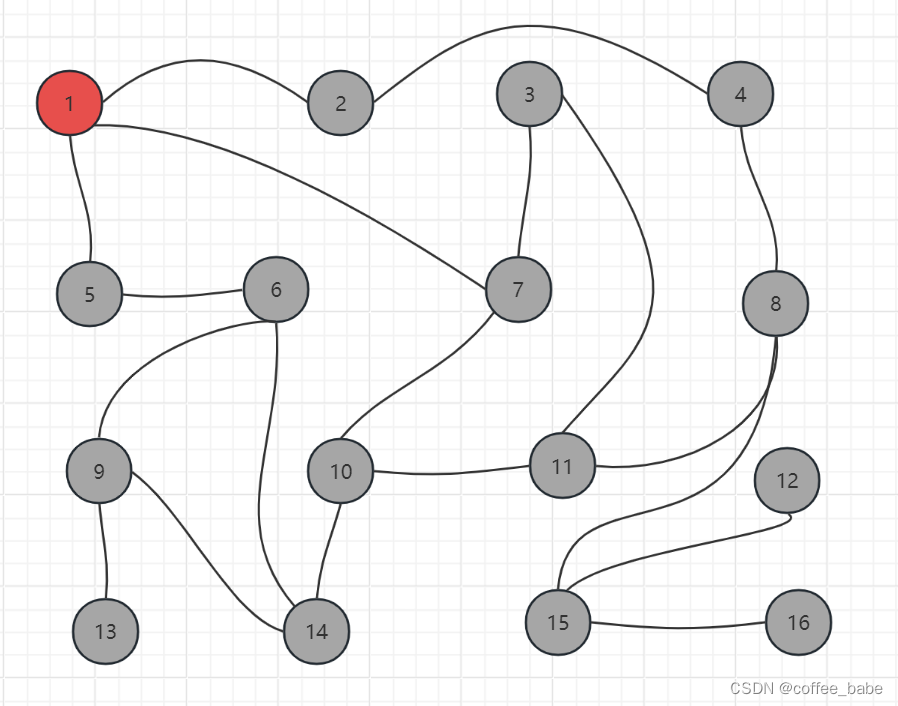

整体框架

RouterChain,也叫路由链,能动态选择用于给定输入的下一个链。我们会根据用户的问题内容,首先使用路由器链确定问题更适合哪个处理模板,然后将问题发送到该处理模板进行回答。如果问题不适合任何已定义的处理模板,它会被发送到默认链.

具体步骤如下:

- 构建处理模板:为鲜花护理和鲜花装饰分别定义两个字符串模板。

- 提示信息:使用一个列表来组织和存储这两个处理模板的关键信息,如模板的键、描述和实际内容。

- 初始化语言模型:导入并实例化语言模型。

- 构建目标链:根据提示信息中的每个模板构建了对应的LLMChain,并存储在一个字典中。

- 构建LLM路由链:这是决策的核心部分。首先,它根据提示信息构建了一个路由模板,然后使用这个模板创建了一个LLMRouterChain。

- 构建默认链:如果输入不适合任何已定义的处理模板,这个默认链会被触发。

- 构建多提示链:使用MultiPromptChain将LLM路由链、目标链和默认链组合在一起,形成一个完整的决策系统。

具体实现

构建提示信息的模板

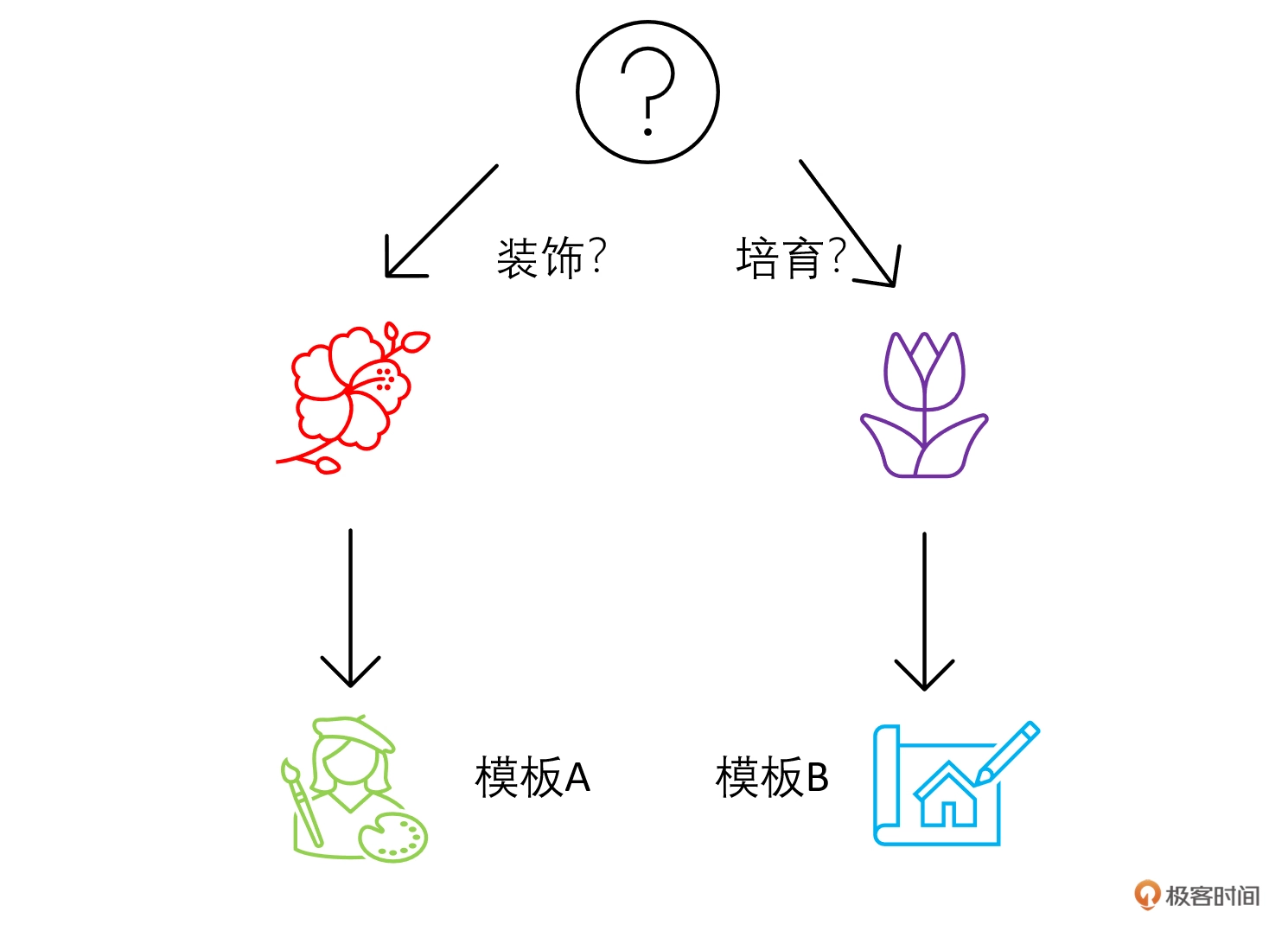

# 构建两个场景的模板

flower_care_template = """你是一个经验丰富的园丁,擅长解答关于养花育花的问题。

下面是需要你来回答的问题:

{input}"""

flower_deco_template = """你是一位网红插花大师,擅长解答关于鲜花装饰的问题。

下面是需要你来回答的问题:

{input}"""

# 构建提示信息

prompt_infos = [

{

"key": "flower_care",

"description": "适合回答关于鲜花护理的问题",

"template": flower_care_template,

},

{

"key": "flower_decoration",

"description": "适合回答关于鲜花装饰的问题",

"template": flower_deco_template,

}]

初始化语言模型

# 初始化语言模型

from langchain.llms import OpenAI

import os

os.environ["OPENAI_API_KEY"] = '你的OpenAI Key'

llm = OpenAI()

构建目标链

# 构建目标链

from langchain.chains.llm import LLMChain

from langchain.prompts import PromptTemplate

chain_map = {}

for info in prompt_infos:

prompt = PromptTemplate(template=info['template'],

input_variables=["input"])

print("目标提示:\n",prompt)

chain = LLMChain(llm=llm, prompt=prompt,verbose=True)

chain_map[info["key"]] = chain

目标链提示是这样的:

目标提示:

input_variables=['input']

output_parser=None partial_variables={}

template='你是一个经验丰富的园丁,擅长解答关于养花育花的问题。\n下面是需要你来回答的问题:\n

{input}' template_format='f-string'

validate_template=True

目标提示:

input_variables=['input']

output_parser=None partial_variables={}

template='你是一位网红插花大师,擅长解答关于鲜花装饰的问题。\n 下面是需要你来回答的问题:\n

{input}' template_format='f-string'

validate_template=True

构建路由链

# 构建路由链

from langchain.chains.router.llm_router import LLMRouterChain, RouterOutputParser

from langchain.chains.router.multi_prompt_prompt import MULTI_PROMPT_ROUTER_TEMPLATE as RounterTemplate

destinations = [f"{p['key']}: {p['description']}" for p in prompt_infos]

router_template = RounterTemplate.format(destinations="\n".join(destinations))

print("路由模板:\n",router_template)

router_prompt = PromptTemplate(

template=router_template,

input_variables=["input"],

output_parser=RouterOutputParser(),)

print("路由提示:\n",router_prompt)

router_chain = LLMRouterChain.from_llm(llm,

router_prompt,

verbose=True)