概述

三维重建是一种将物理世界中的实体转换为数字模型的计算机技术。其基本概念是通过对物理世界中的物体或场景进行扫描或拍摄,并使用计算机算法将其转换为三维数字模型。抽象意义上的三维模型指的是:形状和外观的组合,并且可以渲染成不同视角下真实感强烈的RGB图像。

三维重建技术可以应用于许多领域,如建筑设计、游戏开发、虚拟现实等。通过三维重建技术,可以快速、准确地获取物体的几何形状、纹理、颜色等信息,从而实现更高质量的渲染和呈现效果。

三维重建技术的实现方式有很多种,如通过多视角立体重建、激光扫描、结构光扫描等方式进行。近年来,随着深度学习等技术的发展,深度神经网络也被应用于三维重建技术中,取得了令人瞩目的成果。三维重建技术的发展和应用将进一步推动数字化建设的发展和普及。这些突破性进展为三维重建技术的持续演进提供了强大动力,进一步推动了数字化建设的普及和发展。

神经辐射场(Neural Radiance Fields,简称NeRF)是一种基于神经网络的三维场景重建方法,它能够从二维图像数据中恢复出逼真的三维场景。NeRF利用神经网络模拟了一个场景中每个点的辐射量和密度,从而实现了高质量的三维重建。

自NeRF首次亮相以来,它在计算机图形学、计算机视觉和增强现实等领域引起了广泛的关注和应用前景。该技术的出现改变了传统的三维重建方法,其生成的模型更加逼真、细节丰富,能够捕捉到真实场景中的光照、阴影等复杂效果。

在人工智能领域,NeRF也成为了研究热点之一。越来越多的研究者将其应用于图像生成、虚拟现实、智能交互等方面,并在各大顶会如ICCV(International Conference on Computer Vision)、CVPR(Conference on Computer Vision and Pattern Recognition)等发表了相关论文。这些论文不断地推动着NeRF技术的发展,并在理论和应用上取得了新的突破。

传统的三维重建方法存在着一系列缺陷,例如在最终重建的模型中可能出现孔洞、纹理混叠,同时由于体素分辨率的限制,很多细节会丢失。

与传统方法相比,NeRF技术能够实现照片级别的新视角合成,重建的模型细节更加丰富。它通过利用稀疏的输入视图集来优化底层的连续体积场景函数,从而实现了对复杂场景视图的最佳综合结果。NeRF生成的模型不会出现空洞,而且能够还原更多细节,提供更逼真的三维重建效果。

由于该技术吸引了众多研究者的关注,NeRF的发展速度也非常迅速。随着更多人投入研究,并不断改进和优化该技术,它在三维重建、图像合成等领域的应用前景十分广阔。

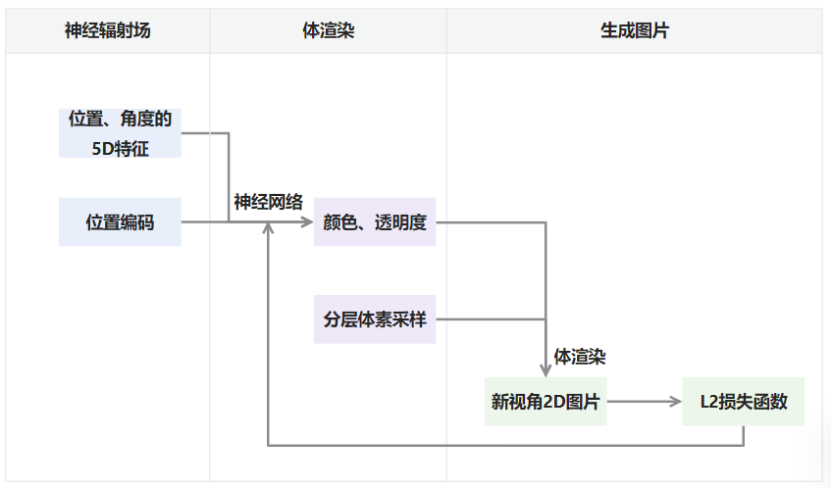

NeRF整体框架

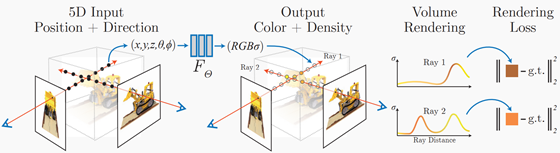

NeRF的工作流程可以分为两个主要步骤:

-

学习场景的辐射场函数:

- 首先,通过神经网络学习场景的辐射场函数。这一步的输入是三维空间中的坐标和方向,输出则是对应点的颜色和透明度值。通过训练神经网络,模型能够从输入的坐标和方向信息中学习到场景中每个点的颜色和透明度信息,从而实现对三维信息的编码。

-

体渲染:

- 其次是体渲染,这一步分为以下几个子步骤:

- 将场景分成小的体素。

- 对每个体素内的光线进行采样。

- 通过对所有采样点的辐射场函数进行加权平均,得到最终的像素颜色值。这相当于对体素中的辐射场进行了积分,从而得到了最终的图像。

- 在计算像素颜色值时,考虑到点的透明度,透明度越高,该点在射线下的颜色反应在像素上的权重越小。

- 其次是体渲染,这一步分为以下几个子步骤:

NeRF还使用了一些技巧来提高重建质量和效率,如位置编码技术和分层体素采样技术。位置编码技术用于将输入坐标进行编码,以便模型更好地处理坐标信息;而分层体素采样技术通过对采样进行分层,可以减少渲染时间,提高渲染效率。这些技术的应用进一步改善了NeRF的重建质量和效率,使其成为一种强大而高效的三维重建方法。

辐射场原理

辐射场是一个五维函数,用来描述辐射在空间中的传播行为和相互作用。在计算机图形学和计算机视觉领域,辐射场常被用于表示三维场景中的光照和颜色信息,可应用于渲染、重建、纹理合成等任务。

辐射场由三个空间维度 ( x , y , z ) (x,y,z) (x,y,z)图片和两个方向维度 ( θ , φ ) (\theta,\varphi) (θ,φ)图片组成,分别表示辐射在空间中的位置和光线的方向。这种表示方法使得辐射场能够描述光线在介质中的传播、反射、折射、散射等现象,同时考虑介质中的吸收、发射等能量转换过程。

神经辐射场可被视为从空间位置和视角方向到颜色图片和透明度图片的映射函数。通过神经网络学习,它能够对三维场景中的光照、颜色和透明度等信息进行建模,从而实现对场景的精确重建和逼真渲染。这种基于神经网络的辐射场表示方法为实现高质量的三维重建和图像合成提供了一种强大的工具。

辐射场用数学公式可以表达为:

F

(

x

,

y

,

z

,

θ

,

φ

)

=

(

c

(

x

,

y

,

z

,

θ

,

φ

)

,

σ

(

x

,

y

,

z

,

θ

,

φ

)

)

F(x,y,z,\theta,\varphi)=(c(x,y,z,\theta,\varphi),\sigma(x,y,z,\theta,\varphi))

F(x,y,z,θ,φ)=(c(x,y,z,θ,φ),σ(x,y,z,θ,φ))

其中

f

θ

f_{\theta}

fθ是一个神经网络模型,

θ

\theta

θ是模型参数。

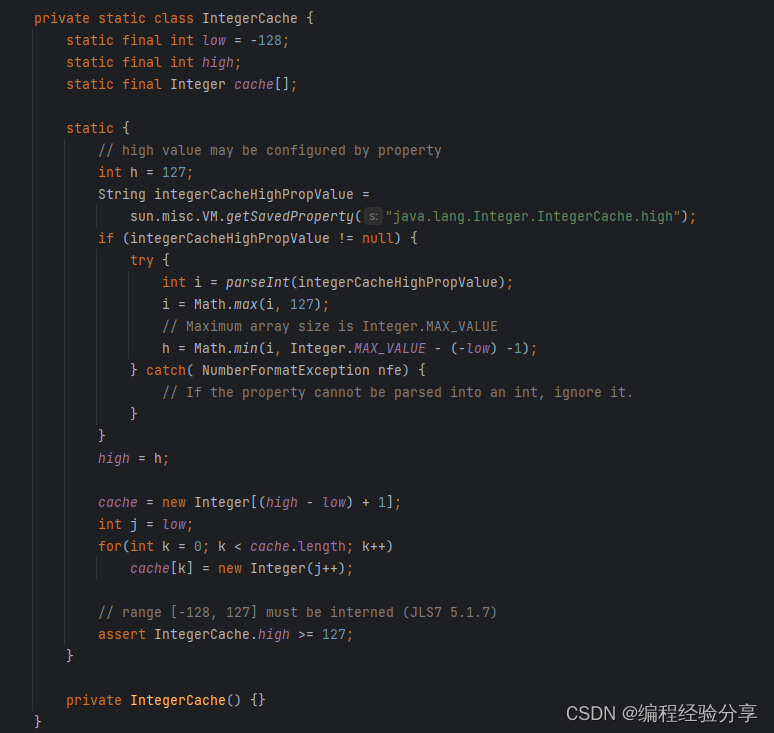

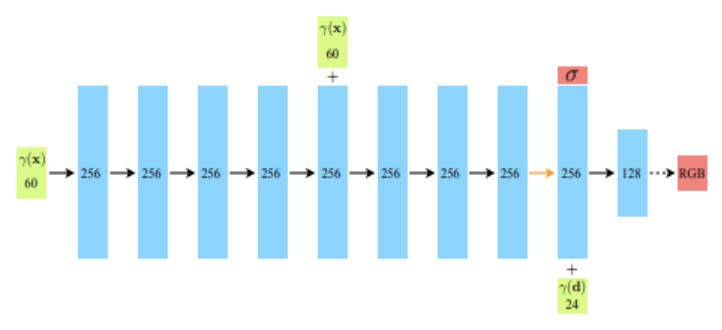

神经网络架构如下图所示,这里采用的是全连接的形式,绿色为输入,红色为输出,其中代表输入位置、角度映射出的维向量,这里我们可以看出,透明度和视角无关而颜色和视角有关:

体渲染

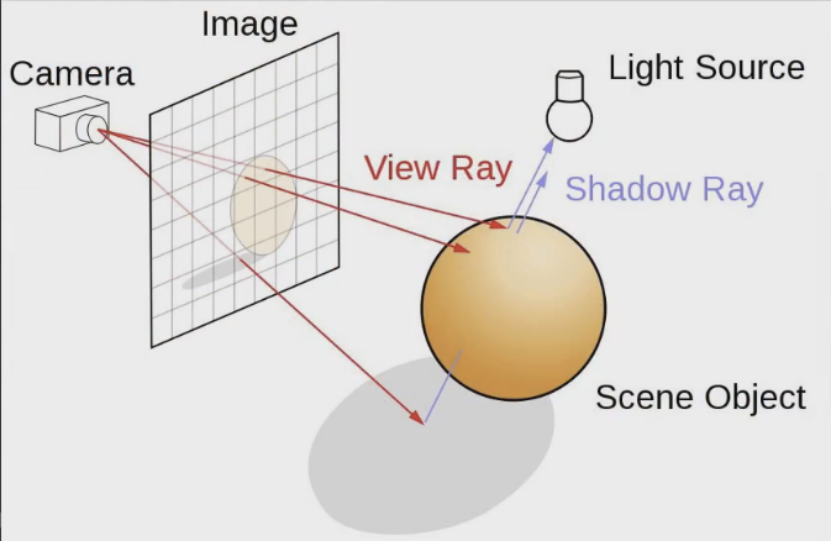

体渲染是一种用于可视化三维数据的方法,其目的是将数据中的体素(Voxel)转换为图像,以便显示其内部结构和特征。在体渲染的过程中,通常涉及到光线传播、颜色合成和光照计算等关键步骤,通过这些步骤可以实现高质量的体渲染效果。

体渲染中最基本的方法是基于光线投影(Ray Casting)的体积光线渲染(Volume Ray Casting)。其核心思想是在三维体素数据上投射光线,并沿着光线路径计算体素的透明度和颜色,从而生成最终的渲染图像。具体而言,这个过程包括以下步骤:

-

光线投射: 从相机或视点位置出发,沿着图像平面上的像素位置向场景内部发射光线。

-

体素采样: 在每条光线上进行采样,以遍历沿光线路径的体素。

-

光线-体素相交计算: 计算光线与体素相交的位置和密度信息。

-

颜色合成: 根据相交位置的密度信息,计算体素的颜色,并将其与之前采样的颜色进行合成。

-

透明度计算: 根据体素的密度信息,计算光线传播过程中的透明度,以调整最终像素的颜色值。

光线传播过程中,透明度和颜色的计算通常基于体素的密度和光线与体素交点的位置和方向等信息。在体渲染中,常用的透明度传输函数(Opacity Transfer Function)和颜色传输函数(Color Transfer Function)可以用于调整渲染效果。

在NeRF中,体渲染可以用以下公式来表示:

C

(

x

)

=

∫

0

t

m

a

x

T

(

x

+

t

ω

)

c

(

x

+

t

ω

)

σ

(

x

+

t

ω

)

d

t

C(x)=\int_{0}^{t_{m a x}}T(x+t\omega)c(x+t\omega)\sigma(x+t\omega)d t

C(x)=∫0tmaxT(x+tω)c(x+tω)σ(x+tω)dt

其中 c ( x ) c_{(x)} c(x)代表投影点的颜色, T ( x ) T_{(x)} T(x)代表光线从物体到观测点沿途的透明度的累和,图片和图片分别代表神经辐射场输出的三维空间的颜色和透明度,图片表示光线与数据集的最大交点,图片表示光线的方向。

应用

神经辐射场目前广泛用于3D建模、自动驾驶、导航系统等领域。为训练自动驾驶系统,英伟达利用NeRF创建出用于大规模训练的虚拟环境 NVIDIA DRIVE Sim 平台,重建出整个旧金山市区的3D环境;NeRF 技术还可以加速元宇宙的发展,为 VR 和 AR 硬件设备提供独特的三维内容,例如,在 VR 游戏或元宇宙世界中,NeRF 可以用来创建高度精细的 3D 场景,增强沉浸式体验。在 AR 应用中,NeRF 可以用来创建更加逼真的虚拟物体,还原文物等模型。