前言

一年多前,OpenAI重塑了聊天机器人,彻底推动大模型技术的突飞猛进,一个月前,OpenAI又重塑了视频生成,当sora的热度还在持续时,没想到OpenAI在机器人领域也出手了,和Figure联合打造的人形机器人,边与人类自然流畅对话、边干活(给人类苹果、整理桌面)

第一部分 Figure人形机器人

1.1 史无前例:Figure人形机器人的惊艳时刻

1.2 机器人与人类流畅对话并流畅干活背后的原理

Figure 的创始人 Brett Adcock 和 AI 团队的负责人 Corey Lynch 在 X 上解释了此次视频中机器人互动背后的原理

此次的突破,由 OpenAI 与 Figure 共同做出。OpenAI 提供负责提供视觉推理和语言理解,而 Figure 的神经网络提供快速、低水平、灵巧的机器人动作

机器人所做出的所有行为都是出于已经学习过,内化了的能力,而不是来自远程操作

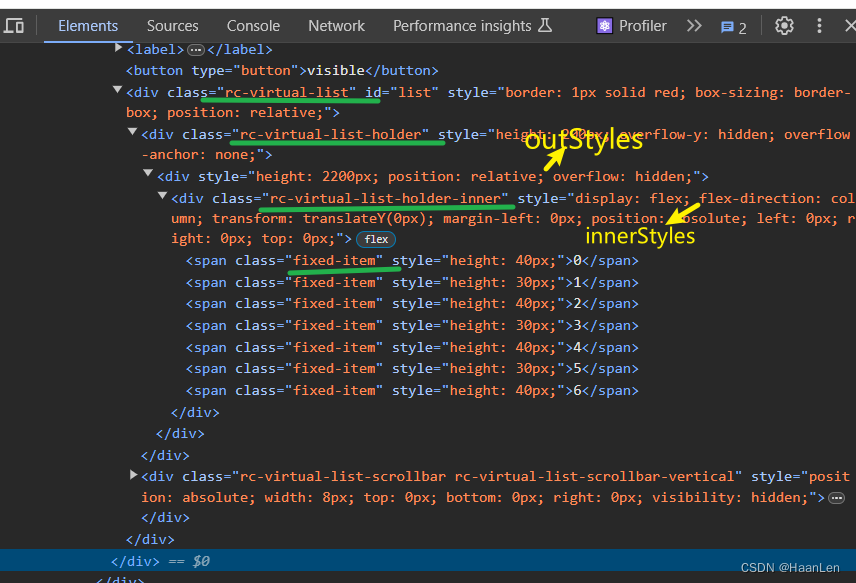

整个流程为:图像 + speech to text =》VLM推理得到response =》speak出来,具体则如下

- 研究人员将机器人摄像头中的图像输入(Figure 的机载摄像头以 10hz 的频率拍摄图像),和机载麦克风捕获的语音中的文本转录到由 OpenAI 训练的,可以理解图像和文本的多模态模型(VLM)中

- 由该模型处理对话的整个历史记录,得出语言响应

- 最后通过文本到语音的方式将其回复给人类

同样的模型,也负责决定在机器人上运行哪些学习的闭环行为来完成给定的命令,将特定的神经网络权重加载到 GPU 上并执行策略

这也是为什么这个机器人,属于「端到端」的机器人控制。从语言输入开始,模型接管了一切处理,直接输出语言和行为结果,而不是中间输出一些结果,再加载其他程序处理这些结果

1.2.1 OpenAI的VLM模型

OpenAI 的模型的多模态能力,是机器人可以与世界交互的关键,我们能够从视频中展示中看到许多类似的瞬间,比如:

- 描述一下它的周围环境

- 做出决定时使用常识推理。例如,「桌子上的盘子和杯子等餐具接下来很可能会进入晾衣架」

- 将「我饿了」等模棱两可的高级请求转化为一些适合上下文的行为,例如「递给对方一个苹果」

- 用简单的英语描述*为什么*它会执行特定的操作。例如,「这是我可以从桌子上为您提供的唯一可食用的物品」

而模型能力的强大,使其还能够拥有短期记忆,比如视频中展示的「你能把它们放在那里吗?」「它们」指的是什么?「那里」又在哪里?正确回答需要反思记忆的能力

1.2.2 机器人动作的预测与执行

而具体的双手动作,可以分成两步来理解:

首先,互联网预训练模型对图像和文本进行常识推理,以得出高级计划。如视频中展示的:Figure 的人形机器人快速形成了两个计划:1)将杯子放在碗碟架上,2)将盘子放在碗碟架上。

其次,大模型以 200hz 的频率生成的 24-DOF 动作(手腕姿势和手指关节角度),充当高速「设定点(setpoint)」,供更高速率的全身控制器跟踪。全身控制器确保安全、稳定的动力,如保持平衡

所有行为均由Transformer 策略驱动(比如mobile aloha所用过的ACT算法),将像素直接映射到动作