摘要

本文提出了一种三维混合残差注意感知分割网络,称为RA-UNet,用于提取肝脏感兴趣区域(VOI)并从这个感兴趣区域(VOI)中分割肿瘤。这个网络的基本架构为三维UNet。它结合了低层次特征图和高层次特征图提取上下文信息,注意力模块是不断堆叠的,这样注意力感知特征就会随着网络自适应的变化。

本文的具体贡献如下::首先,将残差块堆叠到我们的架构中,允许更深层次的架构,并可以处理梯度消失问题。其次,注意机制可以具有聚焦图像特定部分的能力。通过注意模块的堆叠,可以实现不同类型的注意,从而实现注意感知特征自适应变化。

方法

网络体系结构概述

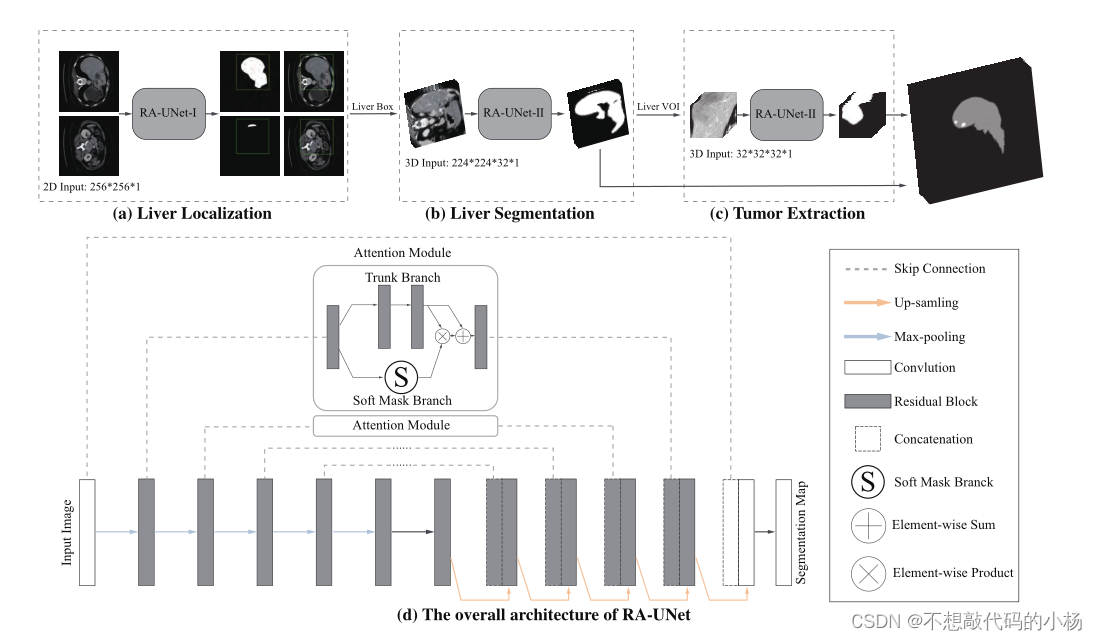

整体的网络架构如下图所示:

所提出的网络主要包括三个主要阶段。依次提取肝脏和肿瘤。为了减少整体计算时间,我们使用了一种基于剩余注意机制和U-Net连接的2D剩余注意感知U-Net (RA-UNet),命名为RA-UNet- i,标记出一个粗糙的肝脏边界框。接下来,3D RA-UNet(称为RA-UNet- ii)被训练以获得精确的肝脏VOI。最后,将先前的肝脏VOI送往第二个RAUNet-II提取肿瘤区域。

RA-UNet网络结构

RA-UNet的网络体系结构如上图中(d)所示

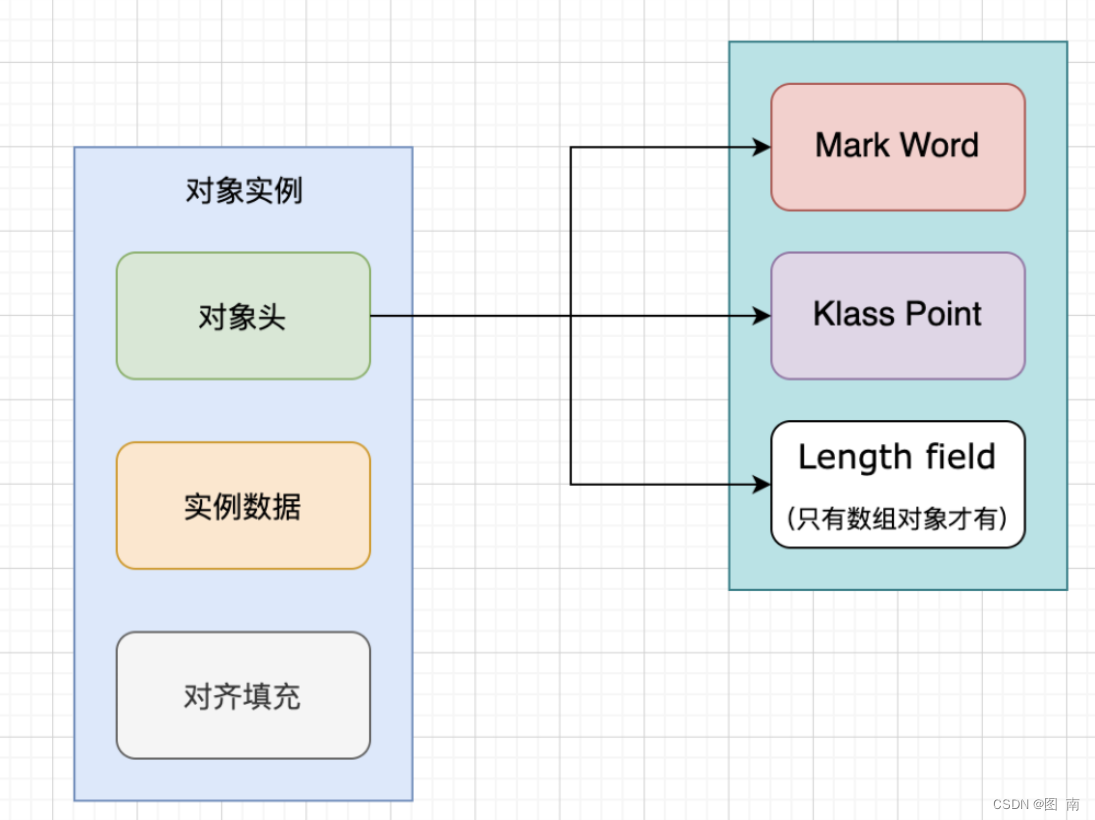

RA-UNet以UNet为基本的架构,由一个编码器和一个解码器对称的分布在架构的两侧,上下文信息由编码器在跳跃连接中传播,这使得提取更复杂的层次特征成为可能。解码器接受具有不同复杂性的特征,并以从粗到细的方式重建特征。

残差学习学习机制:

在本文的研究中,除了第一层和最后一层(图2(d)),其余的块都进行了堆叠,以释放深度神经网络的能力,使其“深入”。通过使用身份映射作为跳过连接和添加后激活,堆叠剩余块解决了神经网络结构层面的梯度消失问题。

残差块由三个部分组合而成:BN层,Relu激活层和卷积层

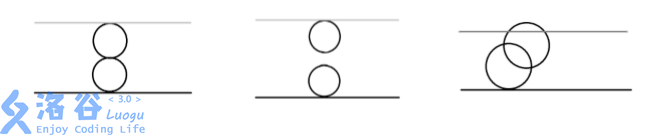

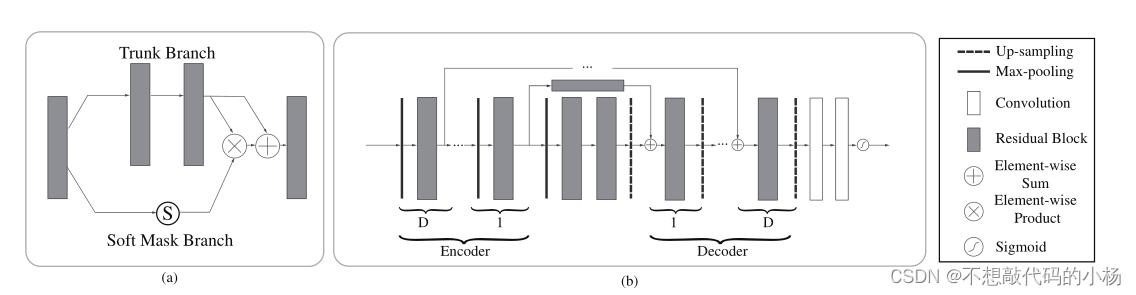

注意力残差机制:

如果只对注意模块进行朴素堆叠,性能会下降。注意残差机制将注意模块分为主干分支Soft mask分支,其中主干分支用于处理原始特征,Soft Mask分支用于构造身份映射。注意力残差机制的计算过程用公式可以表示为

![]()

其中S(x)的值为[0,1]。如果S(x)接近于0,OA(x)将近似于原始特征映射F(x)。软掩码分支S(x)选择相同的特征,抑制来自主干分支的噪声,在注意残留机制中起着最重要的作用。

SoftMax分支具有编码器解码器结构,在注意残差机制,设计了增强优良特征和减小主干分支噪声的注意残差机制,软掩码分支中的编码器包含一个最大池化操作、一个残差块和一个连接到相应解码器的长范围残差块,其中在残差块和上采样操作之后执行元素和。在软掩码的编码器和解码器部分之后,加入两个卷积层和一个sigmoid层对输出进行归一化。注意残差模块如下图所示

一般来说,注意残留机制可以通过主干分支保持原始的特征信息,并通过软掩膜分支关注那些肝脏肿瘤特征。

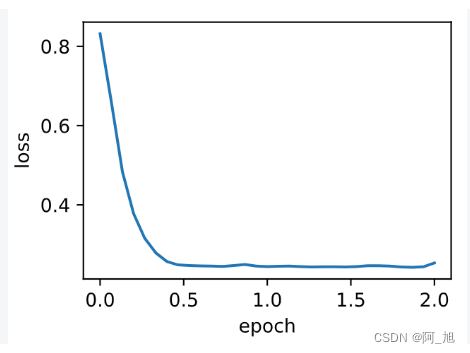

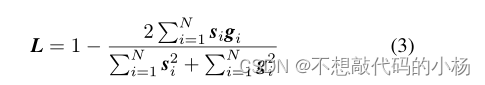

损失函数

在本研究中,我们采用了基于[36]中提出的Dice系数的损失函数。损失L定义如下:

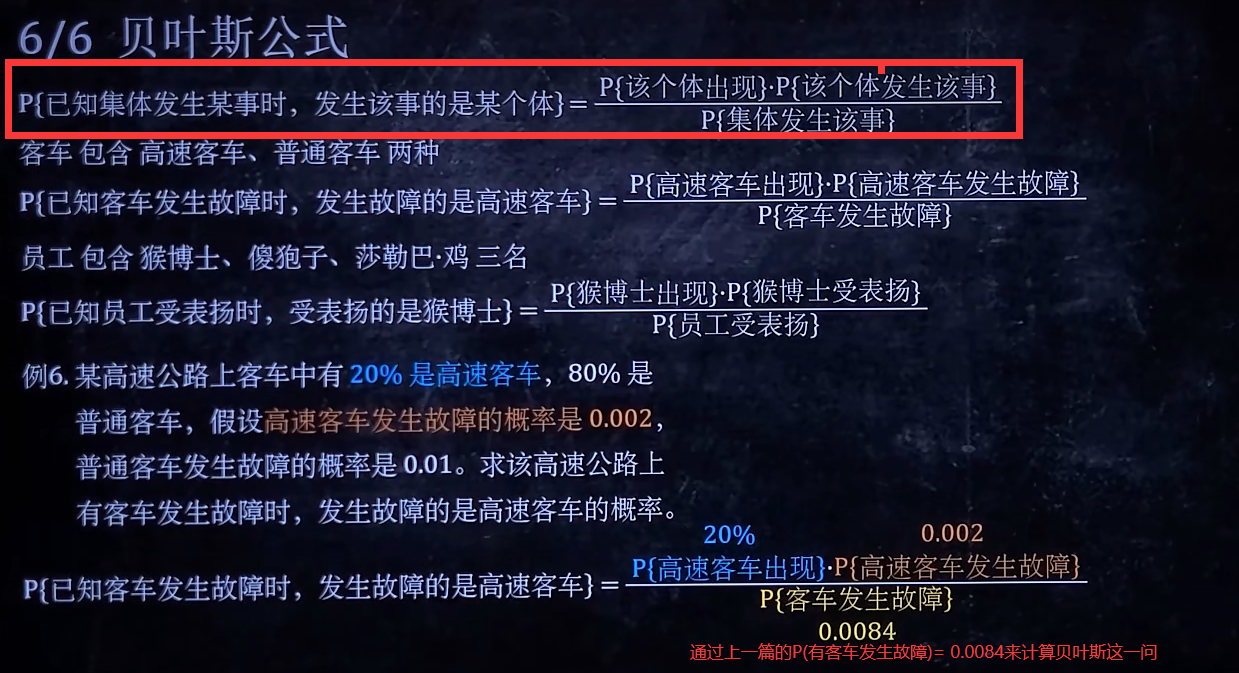

总结

提出了一种有效和高效的混合架构,用于从CT体积中自动提取肝脏和肿瘤。我们介绍了一种新的3D剩余注意力感知肝脏和肿瘤分割神经网络RA-UNet,它允许以像素到像素的方式提取3D结构。该网络充分利用了U-Net、剩余学习和注意剩余机制的优势。首先,注意感知特征随注意模块的使用而自适应变化。其次,将剩余块堆叠到我们的架构中,使架构深入,解决梯度消失的问题。最后,利用U-Net获取多尺度注意力信息,并将低层次特征与高层次特征进行整合。