CNN-LSTM-Attention介绍:

CNN-LSTM-Attention混合神经网络是一种结合了卷积神经网络(CNN)、长短期记忆神经网络(LSTM)和注意力机制(Attention)的模型。这种混合神经网络结合了CNN对空间特征的提取、LSTM对时间序列特征的建模以及注意力机制对关键信息的聚焦,适用于处理既包含空间特征又包含时间序列特征的复杂数据。

卷积神经网络(CNN):

CNN适用于处理图像等具有空间结构的数据,通过卷积层和池化层可以有效提取图像中的局部特征,并具有平移不变性。在CNN-LSTM-Attention模型中,CNN负责提取输入数据的空间特征,如图像中的纹理、形状等信息。

长短期记忆神经网络(LSTM):

LSTM适用于处理时间序列数据,能够捕捉数据中的长期依赖关系,并且具有记忆单元来处理序列数据的记忆和遗忘。在CNN-LSTM-Attention模型中,LSTM负责对时间序列特征进行建模,如文本数据中的语义、句子顺序等信息。

注意力机制(Attention):

注意力机制允许模型动态地聚焦于输入的不同部分,从而提高模型对关键信息的关注程度。在CNN-LSTM-Attention模型中,注意力机制可以帮助模型在处理复杂数据时更好地选择关键特征,提高模型的表现能力。

通过整合CNN、LSTM和注意力机制,CNN-LSTM-Attention混合神经网络可以同时处理空间特征和时间序列特征,适用于视频分析、自然语言处理等领域,能够更全面地理解和利用数据的多种特征,从而提高模型的性能和泛化能力。

部分网络搭建代码:

lgraph = layerGraph(); % 建立空白网络结构

tempLayers = [

sequenceInputLayer([f_, 1, 1], "Name", "sequence") % 建立输入层,输入数据结构为[f_, 1, 1]

sequenceFoldingLayer("Name", "seqfold")]; % 建立序列折叠层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

tempLayers = convolution2dLayer([1, 1], 32, "Name", "conv_1"); % 卷积层 卷积核[1, 1] 步长[1, 1] 通道数 32

lgraph = addLayers(lgraph,tempLayers); % 将上述网络结构加入空白结构中

tempLayers = [

reluLayer("Name", "relu_1") % 激活层

convolution2dLayer([1, 1], 64, "Name", "conv_2") % 卷积层 卷积核[1, 1] 步长[1, 1] 通道数 64

reluLayer("Name", "relu_2")]; % 激活层

lgraph = addLayers(lgraph, tempLayers); % 将上述网络结构加入空白结构中

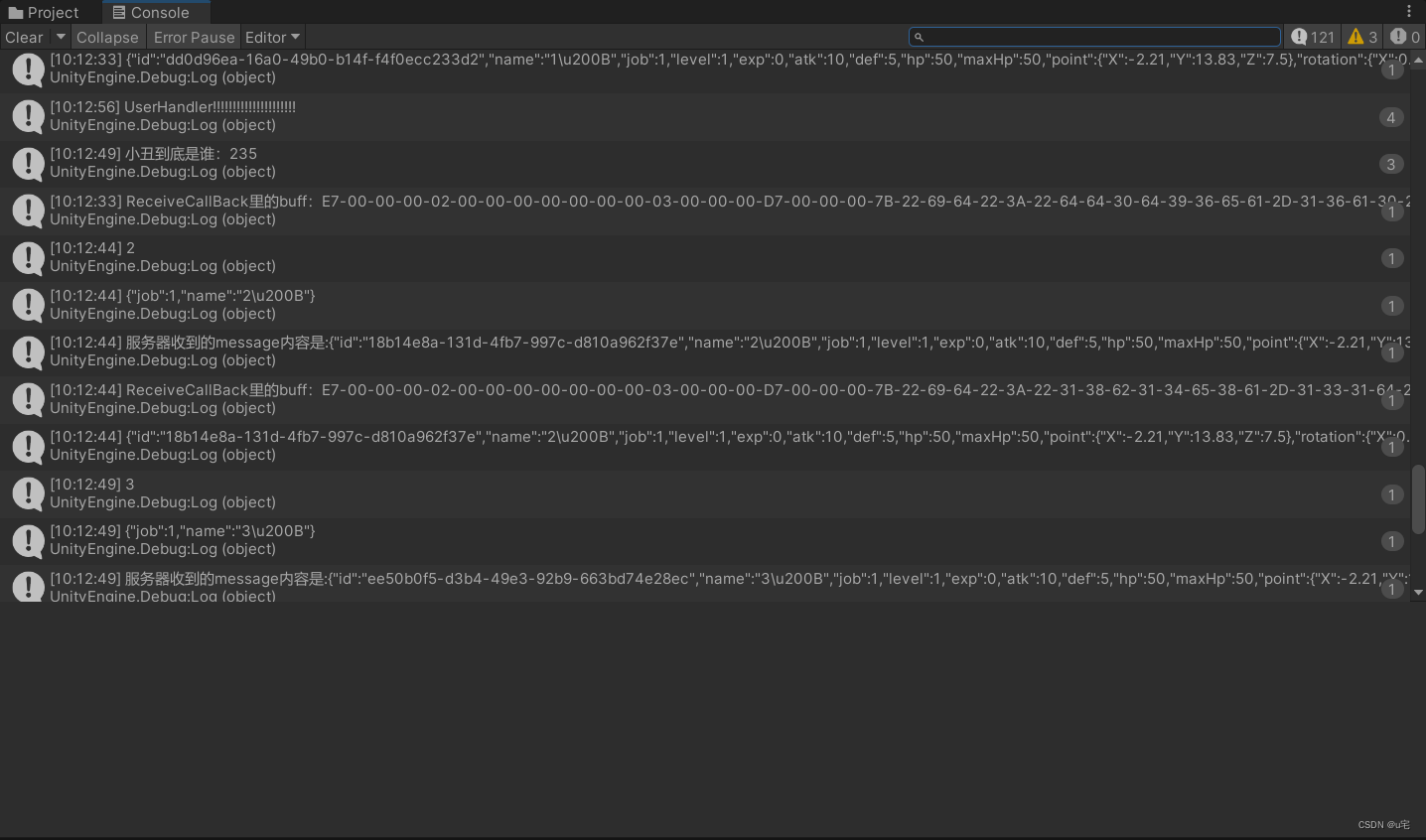

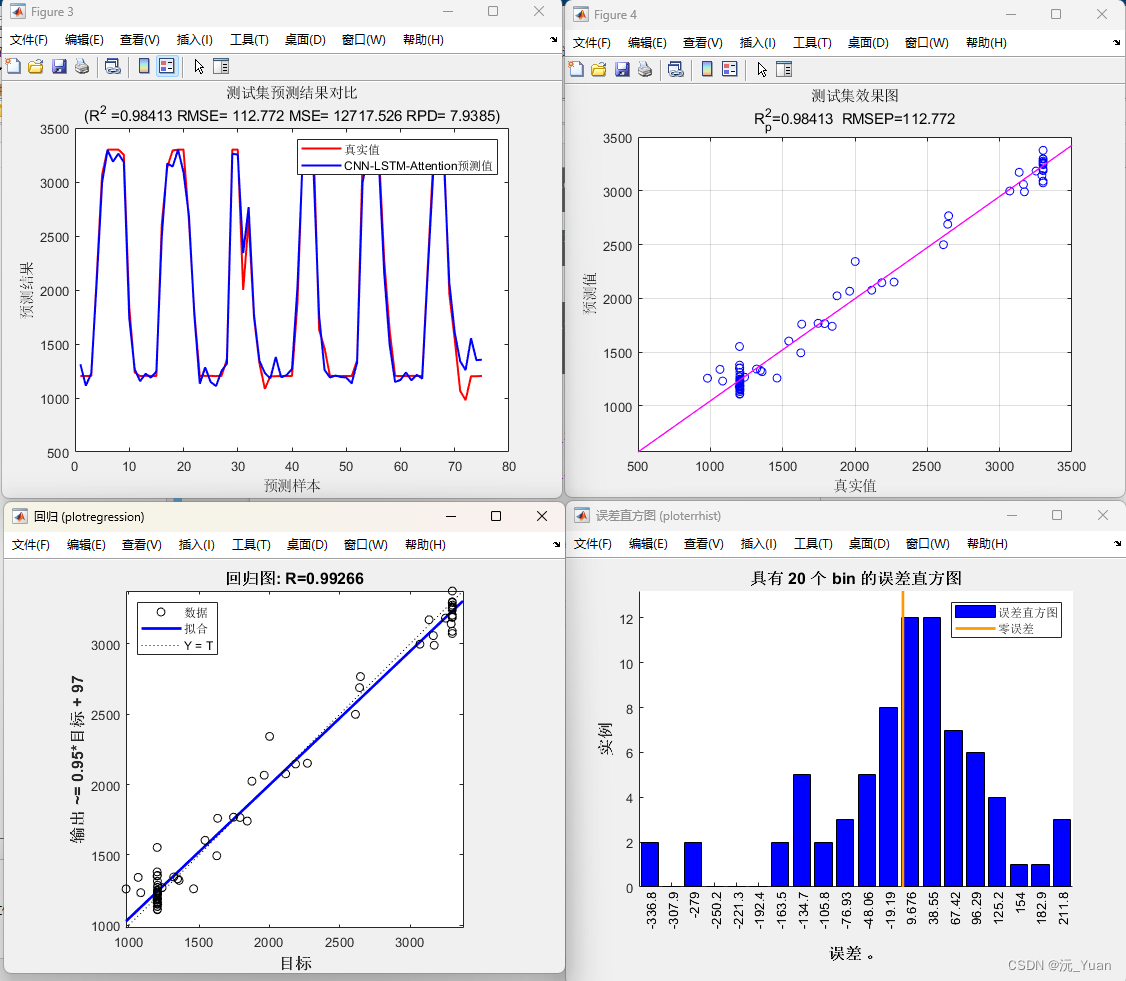

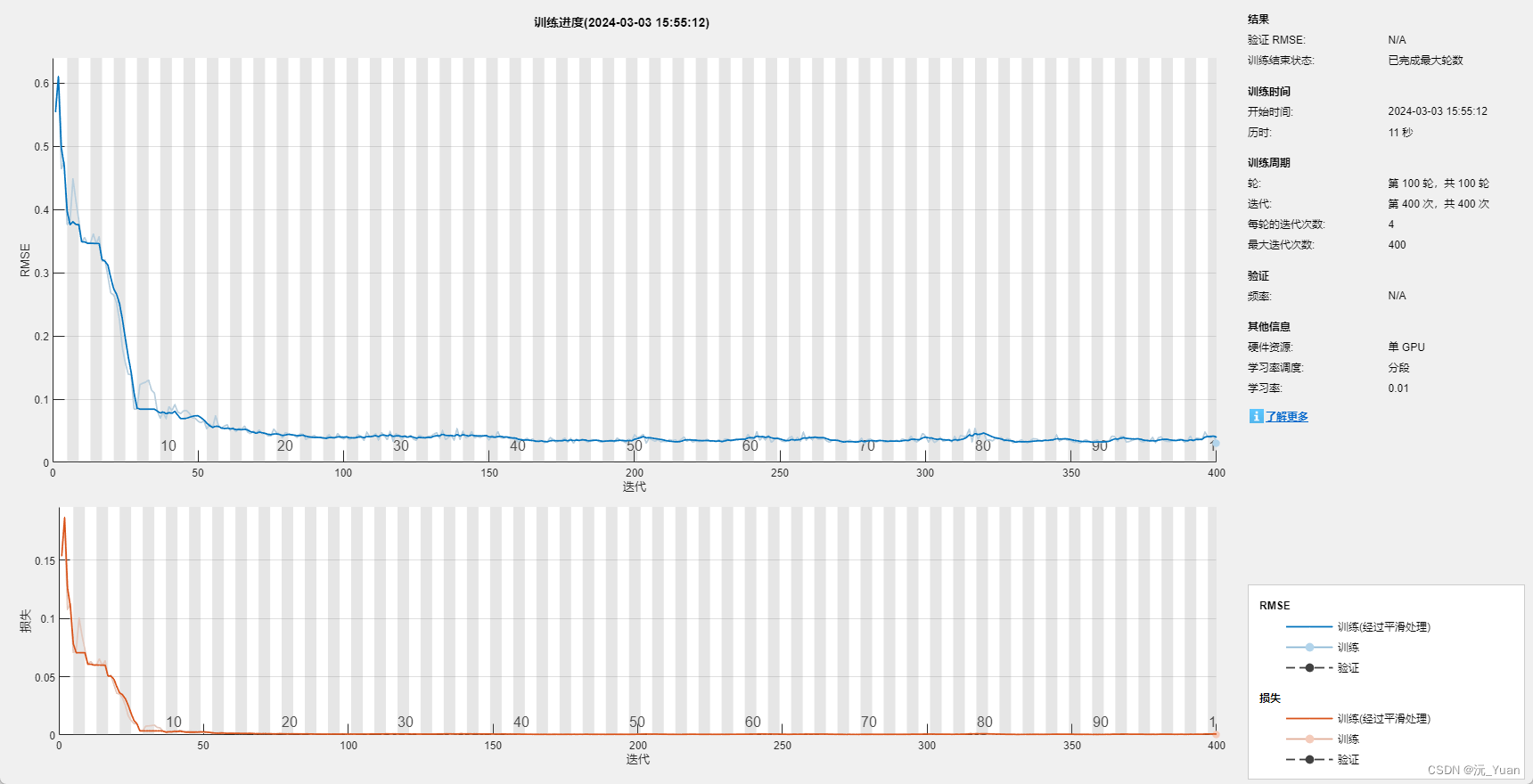

训练结果:

完整代码获取:CNN-LSTM-Attention代码