一、环境配置

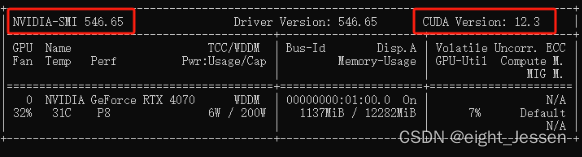

1.nivdia-smi查看显卡信息、cuda版本

可以安装cuda小于12.3的版本,一般不建议安装太新的

2. Anaconda安装

- 安装包下载

- 点击一路安装(注意修改安装路径,不要放在C盘下)

- 配置系统环境变量

参考链接传送门

3. 创建python环境,python>3.8

conda create --name chatglm6b python==3.8.10

激活环境

conda activate chatglm6b

附带删除环境命令

conda remove -n chatglm6b --all

4. pytorch安装

pytorch官网:https://pytorch.org/get-started/locally/

# CUDA 12.1

conda install pytorch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 pytorch-cuda=12.1 -c pytorch -c nvidia

pytorch安装验证、cuda

import torch

torch.cuda.is_available() #True

二、chatglm项目配置

1. 代码下载

git clone https://github.com/THUDM/ChatGLM-6B

2. 模型下载

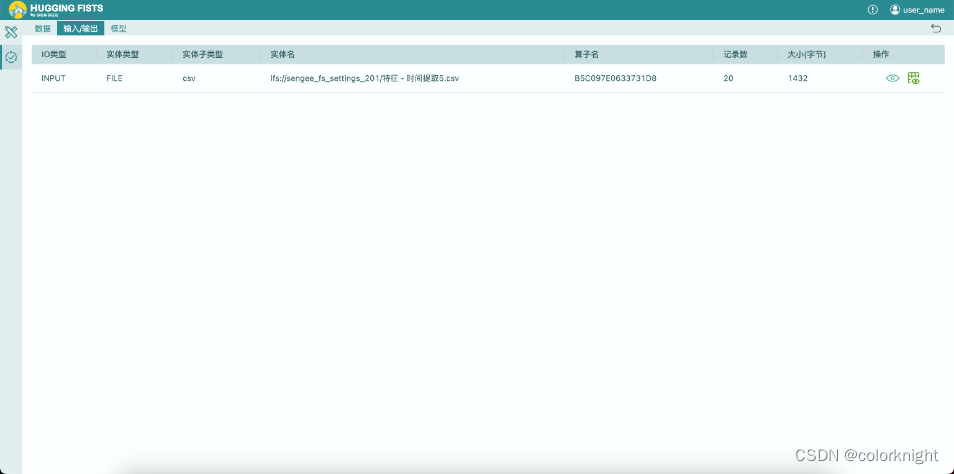

我的模型没有下载到model文件夹下,第一次下载在model文件夹下,在编译器不小心点开了文件夹,直接卡住了,这次创建了跟项目同级的文件夹放模型

git lfs install

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

3. 项目依赖包安装

进入到代码目录,安装依赖包

pip install -r requirements.txt

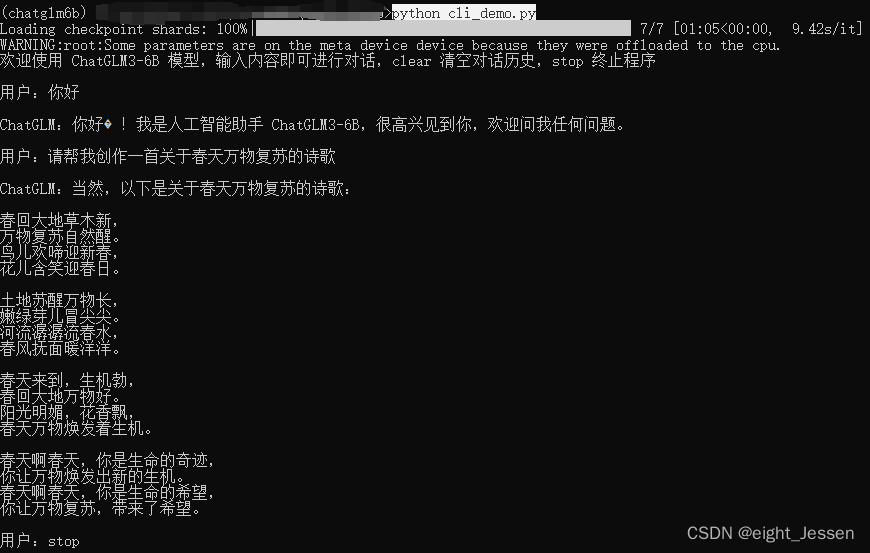

三、chatglm启动

chatglm代码文件夹里面有basic_demo文件夹,里面有可以直接启动的demo

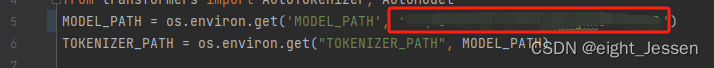

但是需要先修改代码里面的模型路径,以cli_demo为例,修改下面这个代码

终端执行下面代码执行对话

python cli_demo.py

web版本的demo也是修改相应的模型地址即可以启动。

![[嵌入式系统-33]:RT-Thread -18- 新手指南:三种不同的版本、三阶段学习路径](https://img-blog.csdnimg.cn/direct/8f13e2ae00a346afaf1720ea4c921455.png)

![Python算法题集_实现 Trie [前缀树]](https://img-blog.csdnimg.cn/direct/5a897d6e99aa4f639286febc56714d68.png#pic_left)