b站小土堆pytorch教程学习笔记

一、从零开始构建自己的神经网络

1.模型构建

#准备数据集

import torch

import torchvision

from torch.utils.tensorboard import SummaryWriter

from model import *

from torch.utils.data import DataLoader

train_data=torchvision.datasets.CIFAR10('dataset',train=True,

transform=torchvision.transforms.ToTensor(),

download=True)

test_data=torchvision.datasets.CIFAR10('dataset',train=False,

transform=torchvision.transforms.ToTensor(),

download=True)

#查看训练数据集和测试集大小

train_data_size=len(train_data)

test_data_size=len(test_data)

print('训练数据集长度为:{}'.format(train_data_size))#训练数据集长度为:50000

print('测试数据集长度为:{}'.format(test_data_size))#测试数据集长度为:10000

#利用datalo加载数据集

train_dataloader=DataLoader(train_data,batch_size=64)

test_dataloader=DataLoader(test_data,batch_size=64)

#搭建神经网络,在model文件中搭建网络,在此文件中引用

han=Han()

#损失函数

loss_fn=nn.CrossEntropyLoss()

#优化器

# learning_rate=0.01

learning_rate=1e-2

optimizer=torch.optim.SGD(han.parameters(),lr=learning_rate)

#设置训练网络的相关参数

total_train_step = 0#记录训练的次数

total_test_step = 0#记录测试的次数

epoch=10#训练轮数

#添加tensorboard

writer=SummaryWriter('logs/train')

for i in range(10):

print('-------第{}轮训练开始-------'.format(i+1))

for data in train_dataloader:

imgs,target=data

output=han(imgs)

loss=loss_fn(output,target)

#优化器优化模型

optimizer.zero_grad()#梯度清零

loss.backward()#反向传播计算梯度

optimizer.step()#参数优化

total_train_step=total_train_step+1

if total_train_step % 100==0:#逢100打印

print('训练次数:{},loss:{}'.format(total_train_step,loss.item()))#loss.item()取出tensor类型的数字

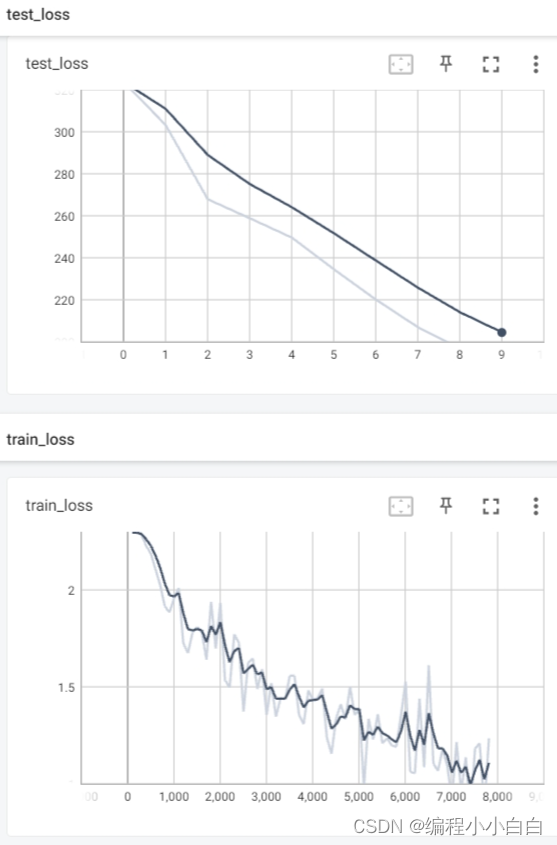

writer.add_scalar('train_loss',loss.item(),total_train_step)

#每训练完一轮将在测试集上跑一遍,评估其训练效果

total_test_loss=0

with torch.no_grad():

for data in test_dataloader:

imgs,target=data

output=han(imgs)

loss=loss_fn(output,target)

total_test_loss=total_test_loss+loss.item()

print('所有测试集上的损失:{}'.format(total_test_loss))

writer.add_scalar('test_loss',total_test_loss,total_test_step)

total_test_step+=1

#保存每一轮模型

torch.save(han,'han_{}.pth'.format(i))

print('模型已保存')

writer.close()

import torch

from torch import nn

class Han(nn.Module):

def __init__(self):

super(Han, self).__init__()

self.model = nn.Sequential(

nn.Conv2d(3, 32, kernel_size=5, stride=1, padding=2),

nn.MaxPool2d(2),

nn.Conv2d(32, 32, kernel_size=5, stride=1, padding=2),

nn.MaxPool2d(2),

nn.Conv2d(32, 64, kernel_size=5, stride=1, padding=2),

nn.MaxPool2d(2),

nn.Flatten(),

nn.Linear(64 * 4 * 4, 64),

nn.Linear(64, 10)

)

def forward(self, x):

x = self.model(x)

return x

if __name__ == '__main__':

han=Han()

input=torch.ones(64,3,32,32)

output=han(input)

print(output.shape)#torch.Size([64, 10])10表示十个类别输出概率

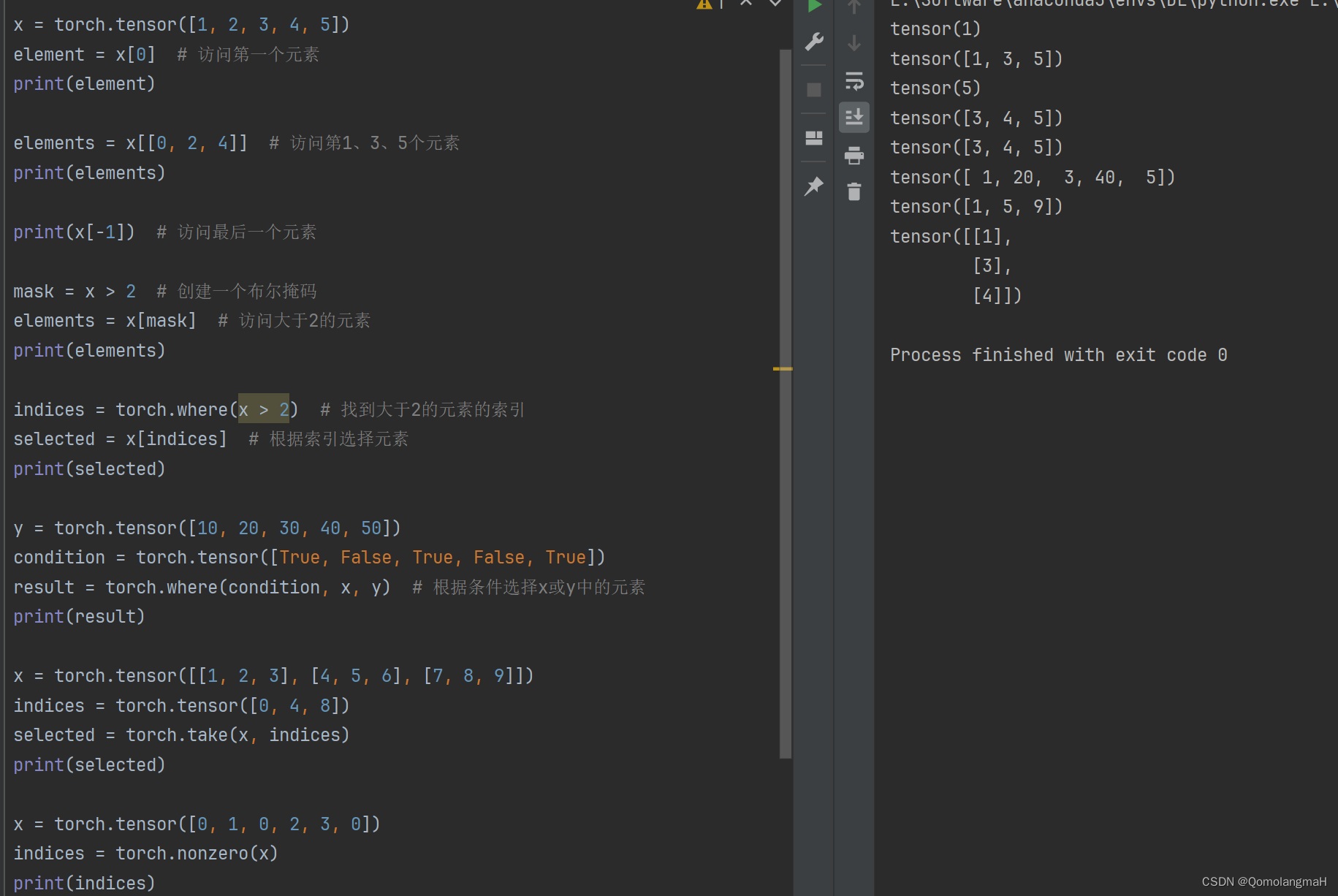

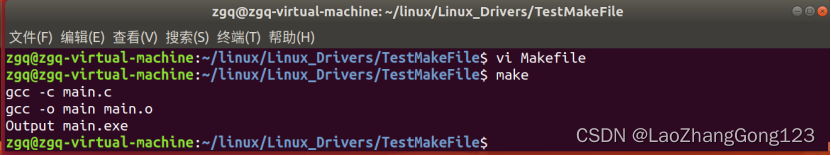

结果如下:

2.使用argmax计算整体正确率

#每训练完一轮将在测试集上跑一遍,评估其训练效果

total_test_loss=0

total_acc=0

with torch.no_grad():

for data in test_dataloader:

imgs,target=data

output=han(imgs)

loss=loss_fn(output,target)

total_test_loss=total_test_loss+loss.item()

acc=(output.argmax(1)==target).sum()#(1)横着看

total_acc+=acc

print('所有测试集上的损失:{}'.format(total_test_loss))

print('整体测试集上的正确率:{}'.format(total_acc/test_data_size))

writer.add_scalar('test_loss',total_test_loss,total_test_step)

writer.add_scalar('test_acc', total_acc/test_data_size, total_test_step)

total_test_step+=1

整体测试集上的正确率:0.27480000257492065

3.当训练或测试时存在dropout层或batch normal层,则需要在训练训练和测试前加入:

#训练前

han.train()

#测试前

han.eval()

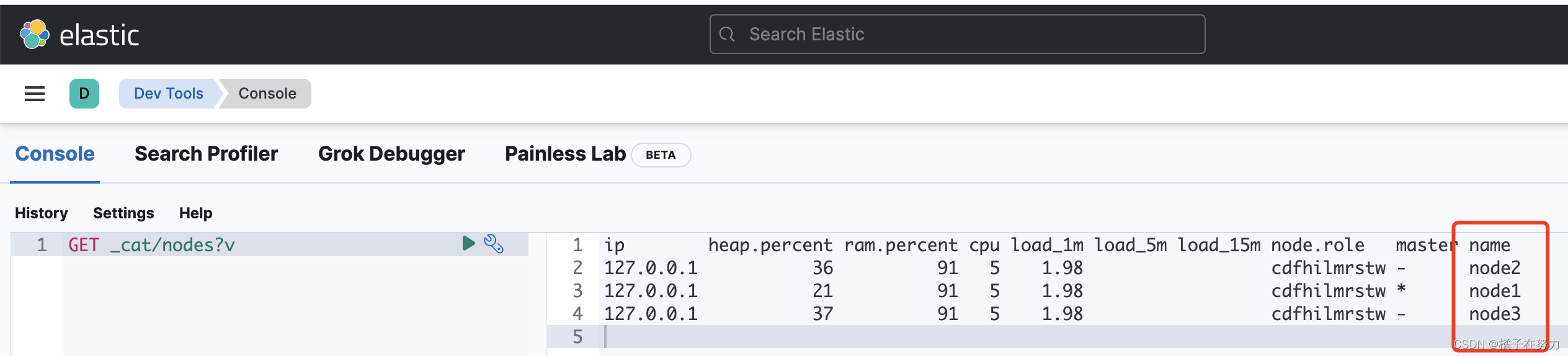

二、使用GPU

网络模型、数据(输入、标注)、损失函数调用cuda()

1.方式1

#模型

if torch.cuda.is_available():

han=han.cuda()

#损失函数

loss_fn=nn.CrossEntropyLoss()

loss_fn=loss_fn.cuda()

imgs,target=data

imgs=imgs.cuda()

target=target.cuda()

2.方式2

#定义训练设备

device=torch.device('cuda')

han=han.to(device)

imgs = imgs.to(device)

target = target.to(device)