title: FLIP解读

mathjax: true

toc: true

date: 2024-02-06 17:22:20

categories:

- Machine Learning

tags: - CLIP

- Masked Autoencoders

- Contrastive Learning

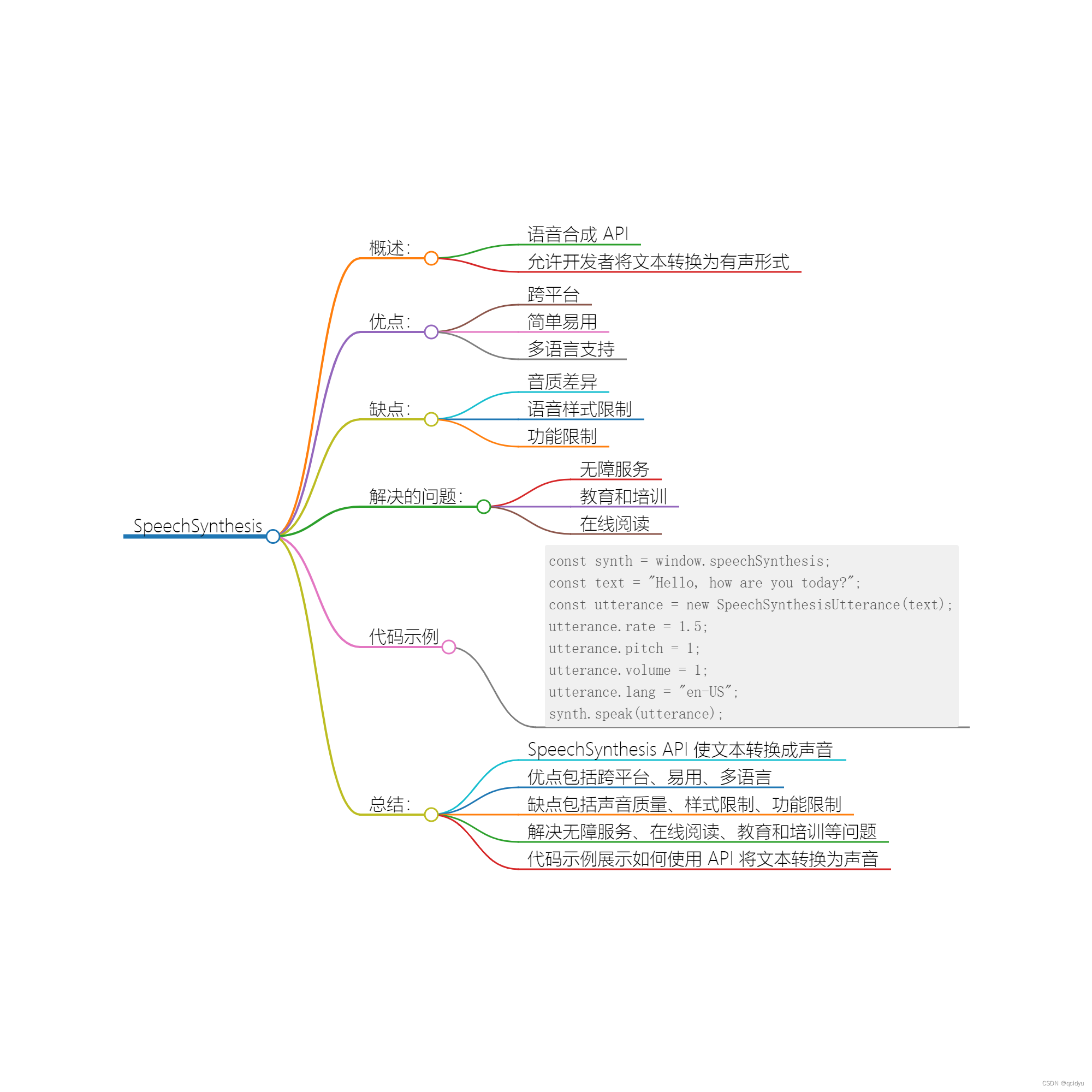

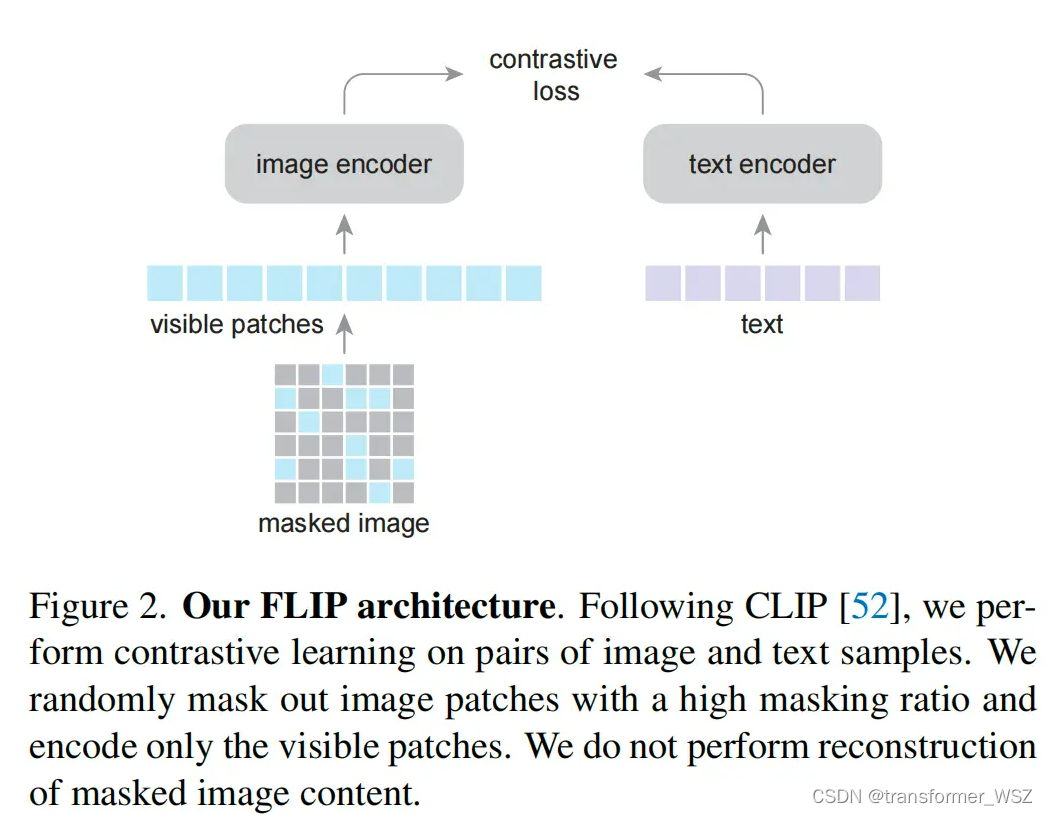

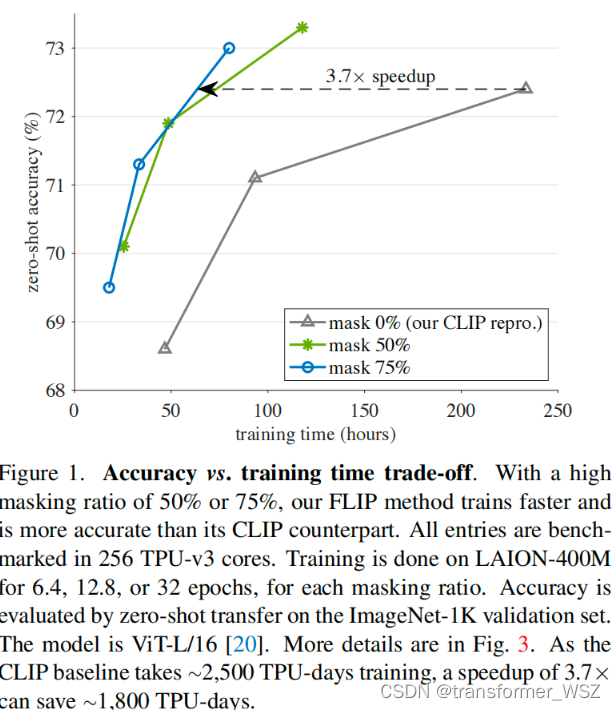

FLIP由CLIP改进而来,其思想非常简单,通过在图片侧mask掉相当比例的patch(无须重构patch),实现速度和准确性的双重提升。

模型结构

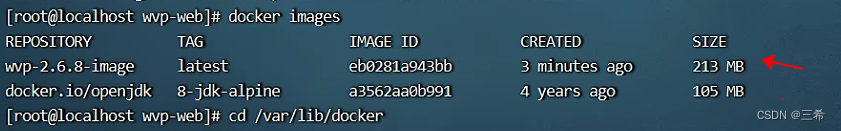

受MAE启发,FLIP对图像进行了mask来预训练。该方法有两方面收益:

- 速度:ViT对图像编码的计算量大幅减少,训练速度更快

- 准确性:相同的显存可以存放更多的batch,从而构造更多的图文对进行对比学习,准确性得以提高

值得注意的是,该预训练任务没有重构patch,个人理解:

- 图片本身就包含了大量的冗余信息,mask掉部分patch不影响图片理解

- mask部分patch,可以强制两边编码器去学习对方的上下文语义信息

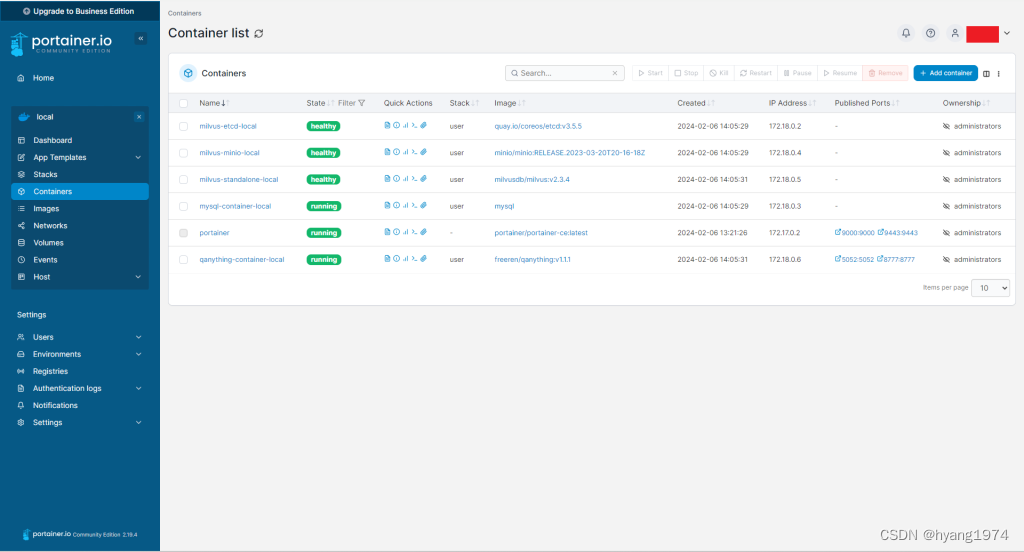

实验结果

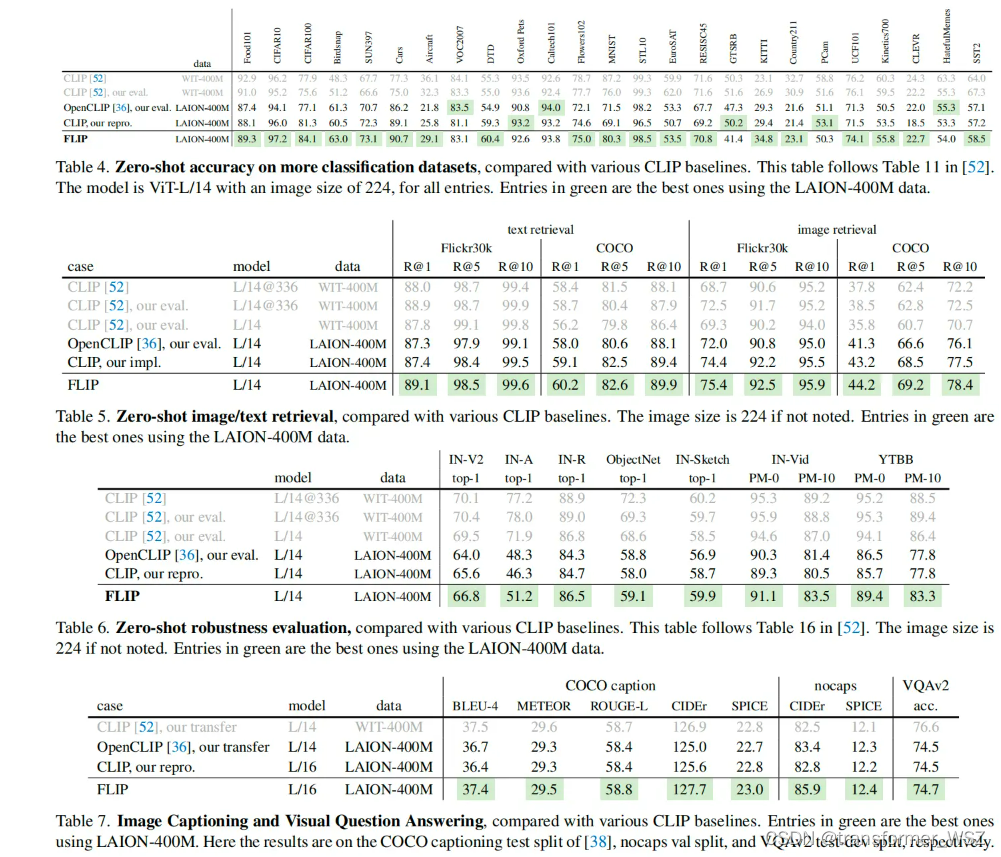

FLIP在下游实验的结果一片绿:

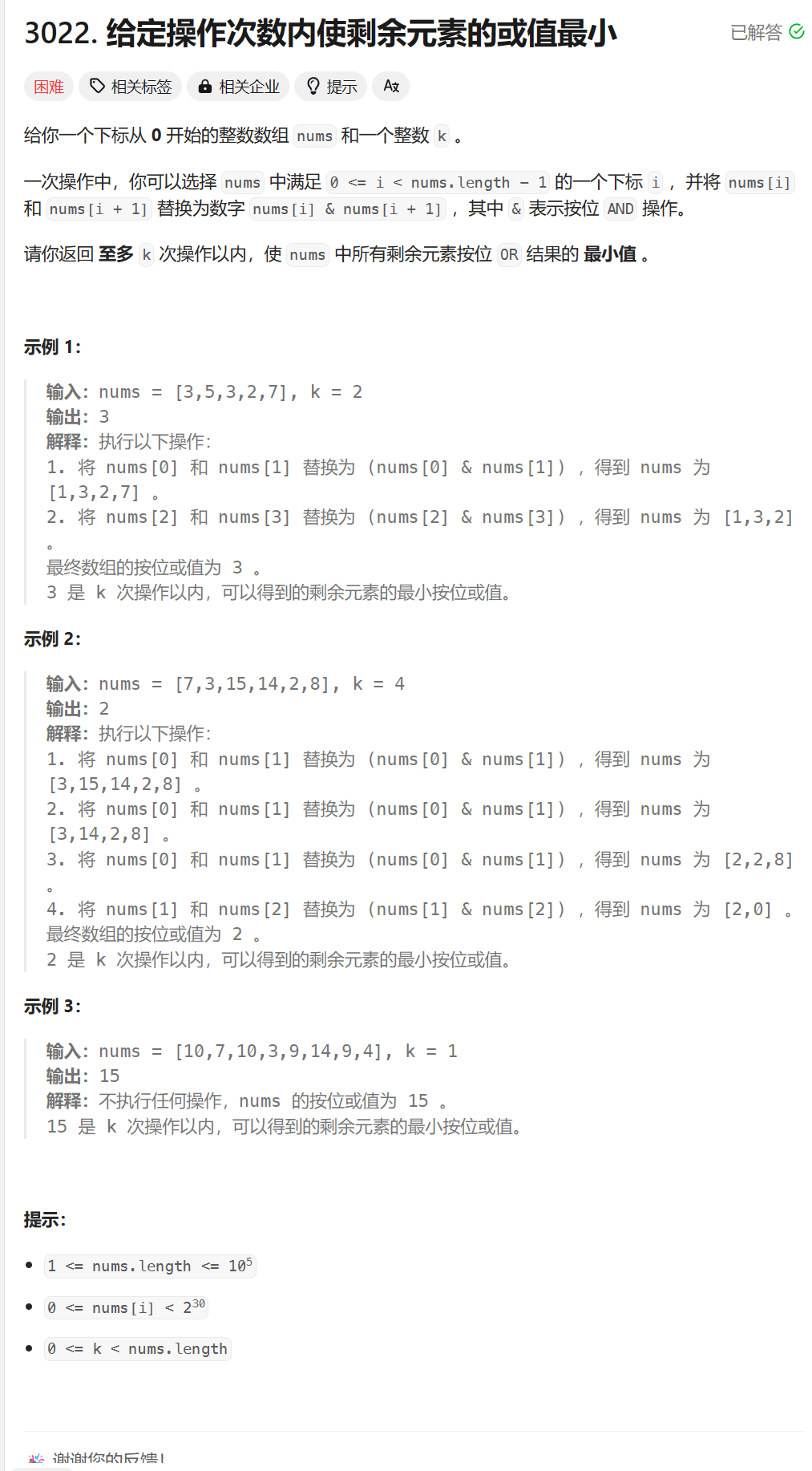

消融实验

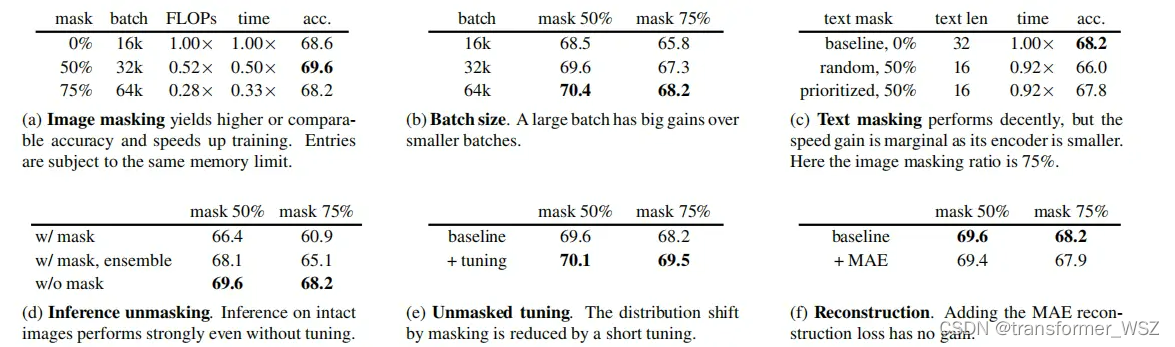

- 作者尝试在图像上的不同mask比例,50%最佳

- 作者也尝试了在文本上做mask,但性能略微有所下降

- 重构patch没有收益

参考

- 简单高效!何恺明大神之多模态预训练FLIP

![pwn旅行之[WUSTCTF 2020]getshell2(一些小知识)](https://img-blog.csdnimg.cn/direct/05311b5e2604406485f6c1fe4ac06356.png)