目录

前言

一、验证码验证

二、IP限制

三、User-Agent限制

四、动态页面加载

总结

前言

反爬虫是一种防止网站被自动程序(爬虫)访问和抓取数据的技术手段。在网络爬虫的发展和使用过程中,有一部分爬虫是用于非法获取网站数据、侵犯隐私和其他违法活动的。因此,为了保护网站的数据安全和合法权益,网站管理员会采取一系列的反爬虫策略来限制爬虫的访问和抓取行为。

本文将介绍一些常见的反爬虫技术和方法,并提供相应的代码示例,帮助读者了解和学习如何实现反爬虫功能。

一、验证码验证

验证码是一种常见的反爬虫技术,通过要求用户输入验证码来验证是否是人类用户。验证码通常是包含有数字或字母的图形或文字,在网站的表单页面中进行展示。爬虫需要通过解析验证码图像或文字,然后再将验证码输入到相应的表单字段中。以下是一个示例代码,模拟输入验证码的过程:

import requests

from PIL import Image

# 下载验证码图片

url = 'http://example.com/captcha.jpg'

response = requests.get(url)

with open('captcha.jpg', 'wb') as f:

f.write(response.content)

# 打开验证码图片,由用户输入验证码

image = Image.open('captcha.jpg')

image.show()

captcha = input('请输入验证码:')

# 提交表单数据

data = {

'username': 'admin',

'password': '123456',

'captcha': captcha

}

response = requests.post('http://example.com/login', data=data)

print(response.text)二、IP限制

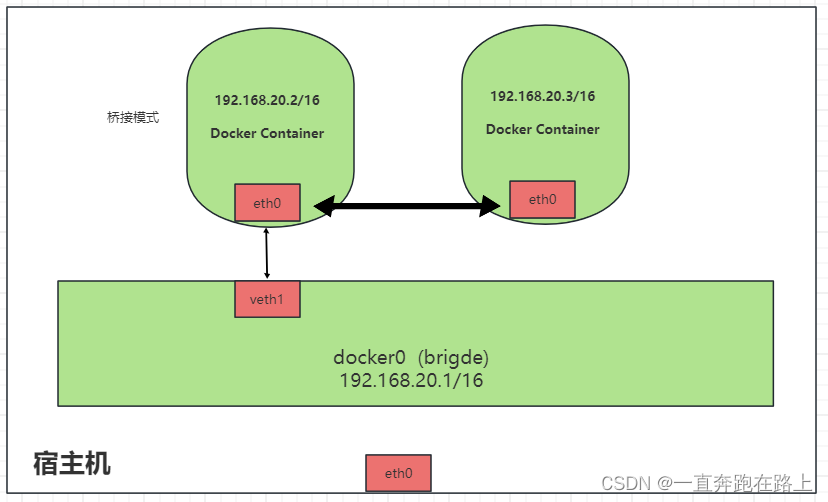

网站管理员可以通过限制相同IP地址的访问频率,来防止爬虫大量请求网页数据,对网站造成过大的负担。以下是一个示例代码,演示如何使用代理IP来绕过IP限制:

import requests

# 使用代理IP来发送请求

proxies = {

'http': 'http://127.0.0.1:1080',

'https': 'http://127.0.0.1:1080'

}

response = requests.get('http://example.com/', proxies=proxies)

print(response.text)三、User-Agent限制

User-Agent是浏览器或客户端程序发送给服务器的一个标识,用于告诉服务器访问者的浏览器类型和版本。有些网站会根据User-Agent来判断是否是爬虫访问,并限制其访问。以下是一个示例代码,演示如何设置User-Agent来绕过限制:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get('http://example.com/', headers=headers)

print(response.text)四、动态页面加载

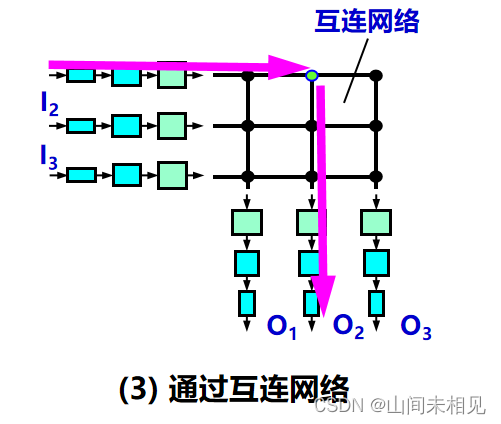

一些网站使用了JavaScript等技术来实现动态页面加载,这使得传统的静态爬虫难以获取到完整的页面数据。在这种情况下,需要使用模拟浏览器的技术来执行JavaScript代码,然后再抓取页面数据。以下是一个示例代码,使用Selenium模拟浏览器来抓取动态页面数据:

from selenium import webdriver

# 使用Chrome浏览器驱动

driver = webdriver.Chrome()

# 打开网页

driver.get('http://example.com/')

# 等待页面加载完成

driver.implicitly_wait(10)

# 获取页面内容

content = driver.page_source

# 关闭浏览器

driver.quit()

print(content)总结

反爬虫是网站管理员为了保护数据安全和合法权益而采取的一系列技术手段。本文介绍了一些常见的反爬虫技术和方法,并提供了相应的代码示例。要应对反爬虫技术,爬虫程序员需要学会如何处理验证码、绕过IP和User-Agent限制,以及使用模拟浏览器来抓取动态页面数据。同时,爬虫程序员也需要遵守网站的访问规则和道德规范,在爬取数据时注意不要对网站造成过大的负担。