日期:2024.1.22 - 2024.1.28

本周工作:

1. 阅读论文

本周阅读了以下论文:

《BRAU-Net:用于医学图像分割的U形混合CNN-Transformer网络》

背景

精确的医学图像分割对于临床量化、疾病诊断、治疗计划和许多其他应用至关重要。基于卷积和基于Transformer的u形结构在各种医学图像分割任务中都取得了显著的成功。前者可以有效地学习图像的局部信息,同时需要卷积运算所固有的更多特定于图像的归纳偏差。后者可以使用自注意在不同的特征尺度上有效地捕捉长程依赖性,而随着序列长度的增加,它通常会遇到二次计算和内存需求的挑战。为了解决这个问题,通过将这两种范式的优点集成到设计良好的u形架构中,本论文提出了一种混合但有效的CNN-Transformer网络,称为BRAU-Net,用于精确的医学图像分割任务。

主要内容

研究目的:这篇论文介绍了一种新的用于医学影像分割的网络架构BRAU-Net++。该架构旨在有效处理医学图像,以助力临床量化、疾病诊断和治疗规划等重要任务。

概述:

-

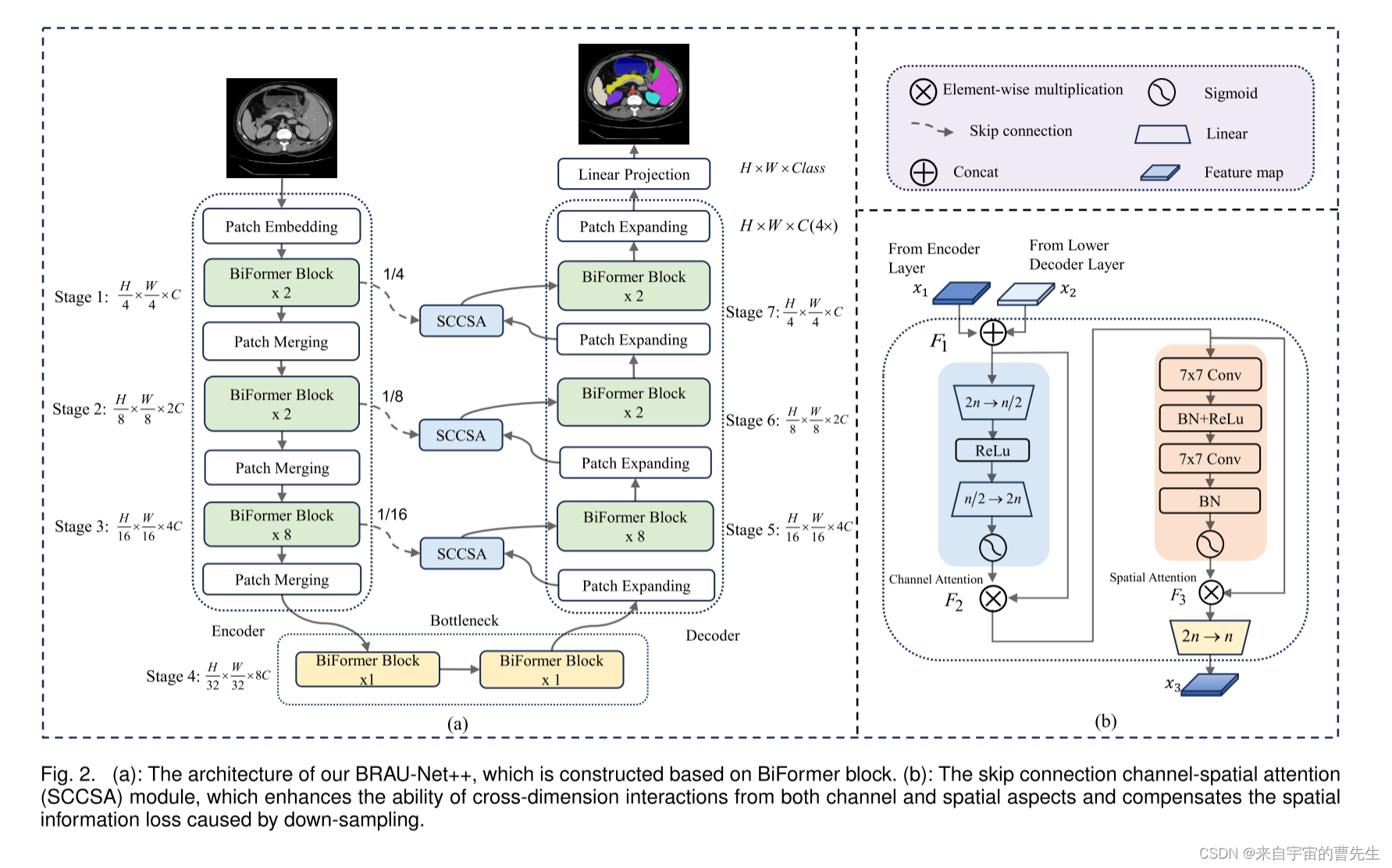

架构:BRAU-Net++是一种将卷积神经网络(CNN)和Transformer技术结合在U型结构中的混合网络。这种设计利用了CNN在学习局部图像信息方面的优势,以及Transformer在捕捉长距离依赖关系方面的优势。

-

贡献:

- 介绍了一种u形混合CNN Transformer网络,该网络以双层路由注意力为核心构建块来设计编码器-解码器结构,其中编码器和解码器都是分层构建的,以便在降低计算复杂度的同时有效地学习局部全局语义信息。

- 利用通道空间注意机制重新设计了传统的跳跃连接,并提出了具有通道空间注意的跳跃连接(SCCSA),旨在增强通道和空间两个方面的跨维度交互,补偿下采样造成的空间信息损失。

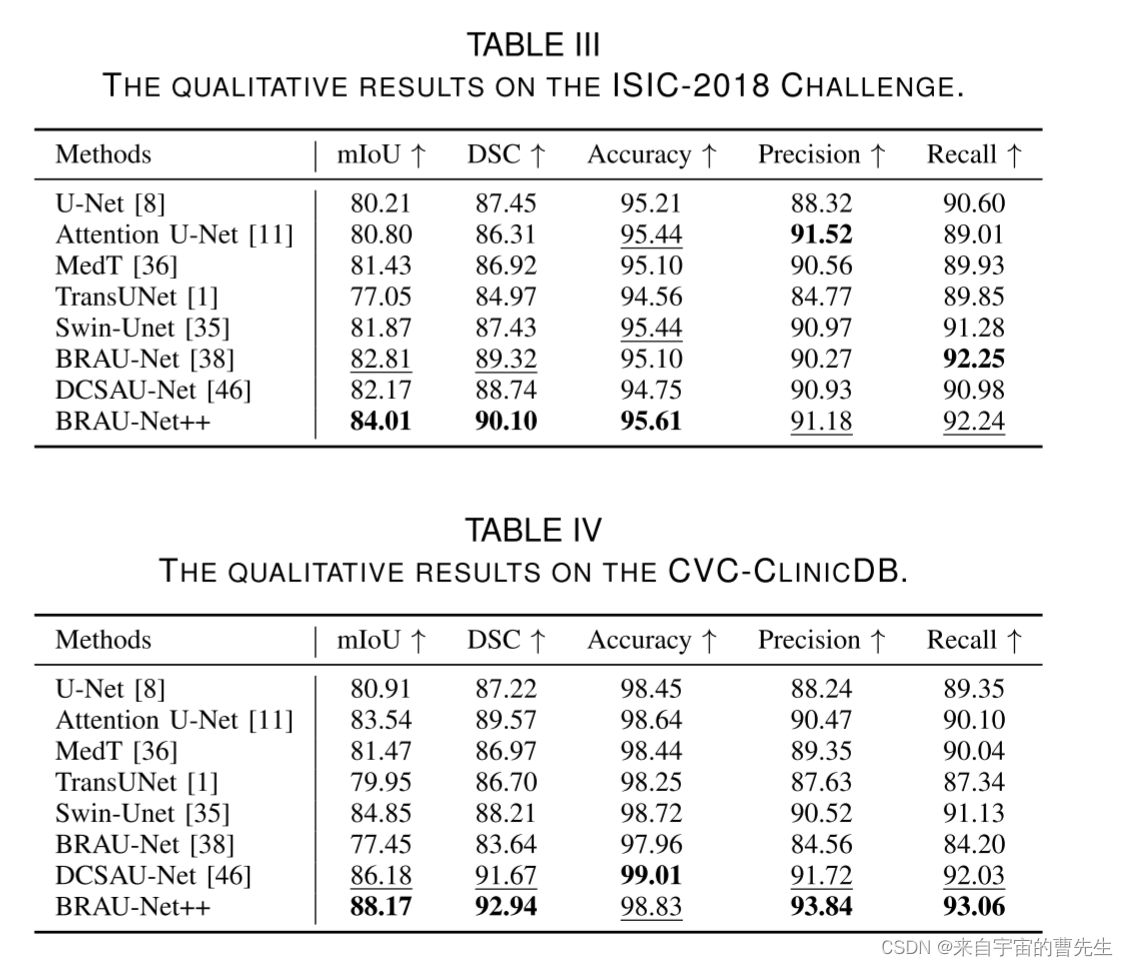

- 三个常用的数据集上验证了BRAU-Net的有效性:Synapse多器官分割、ISIC-2018挑战和CVC ClinicDB数据集。因此,在几乎所有的评估指标下,所提出的BRAUNet都比其他最先进的(SOTA)方法表现出更好的性能。

-

创新点:

- 双层路由注意力:BRAU-Net++的核心组件之一是其U型编码器-解码器结构中使用的双层路由注意力。这个特性使网络能够有效地学习全局语义信息,同时控制计算复杂度。

- 重新设计的跳跃连接:网络在其跳跃连接中加入了通道-空间注意力,使用卷积操作。这种方法旨在最小化局部空间信息的损失,并增强多尺度特征在不同维度间的交互。

-

性能:

- 论文报告了在三个公共基准数据集上进行的广泛实验的印象深刻结果。值得注意的是,BRAU-Net++在几乎所有评估指标上都超越了其他最先进的方法,包括其前身BRAU-Net。

- 网络在Dice相似系数(DSC)和平均交并比(mIoU)等多个数据集上都取得了高分,显示出其在医学图像分割任务中的有效性。

-

应用:提出的网络在推动医学图像分割方面具有重要潜力,这是疾病诊断和治疗规划等多种临床应用中不可或缺的一步。

这种详细且创新的方法在BRAU-Net++中体现出医学图像处理领域的重大进步,利用了CNN和Transformer的结合优势,提高了图像分割任务的准确性和效率。

方法

整体框架

- BRAU-Net++包括编码器、解码器、瓶颈和SCCSA模块。

- 编码器,给定大小为H×W×3的输入医学图像,将医学图像分割为重叠的块,并通过块嵌入将每个块的特征维数投影到任意维数(定义为C)。变换后的补丁令牌通过多个BiFormer块和补丁合并层来生成层次特征表示。具体来说,补丁合并用于降低特征图的分辨率和增加维度,而BiFormer块用于学习特征表示。对于瓶颈,特征图的分辨率和维度保持不变。

- 解码器,设计了一种基于对称变换器的解码器,该解码器由BiFormer块和补丁扩展层组成。补片扩展层负责上采样和降维。通过SCCSA模块将提取的上下文特征与编码器的多尺度特征融合,以弥补下采样造成的空间信息损失,并放大全局维度的相互作用。最后一个补丁扩展层用于4×上采样,以恢复特征图的原始分辨率H×W,然后使用线性投影层生成像素级分割预测。

编码器

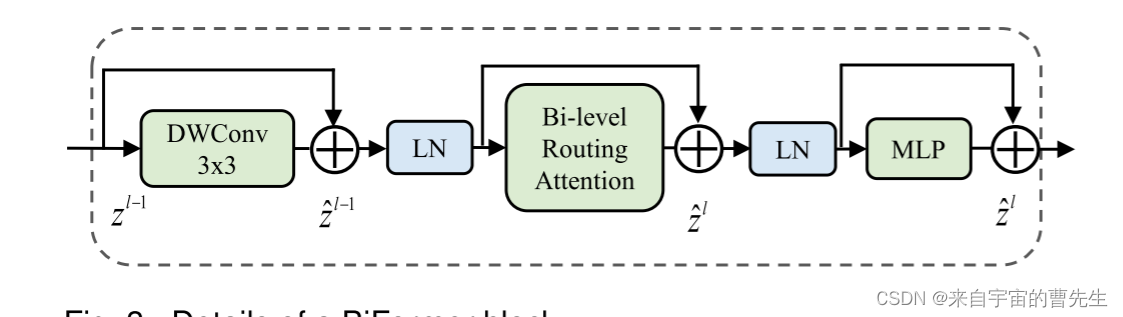

BiFormer模块:

编码器是通过使用三级金字塔结构来分层构造的;

在阶段1中,由两个3×3卷积层组成的补丁嵌入层;

在阶段1-3中,使用具有3×3卷积层的补丁合并层来降低输入空间分辨率,同时增加通道数量;

在阶段1中,将分辨率为H/4×W/4和C通道的标记化输入馈送到两个连续的BiFormer块中,以执行表示学习;

阶段2-3中的标记化输入也以类似的方式执行;

补丁合并层执行2×下采样以将标记数量减少一半,并将特征维数增加2×。

解码器

与编码器类似,解码器也是基于BiFormer块构建的。

采用了补丁扩展层对解码器中提取的深层特征进行上采样。

补丁扩展层主要用于将特征图重塑为更高分辨率的特征图,即将分辨率提高2×,并将特征维数降低一半。

最后一个补丁扩展层执行4×上采样以输出分辨率为H×W的特征图,用于预测像素级分割。

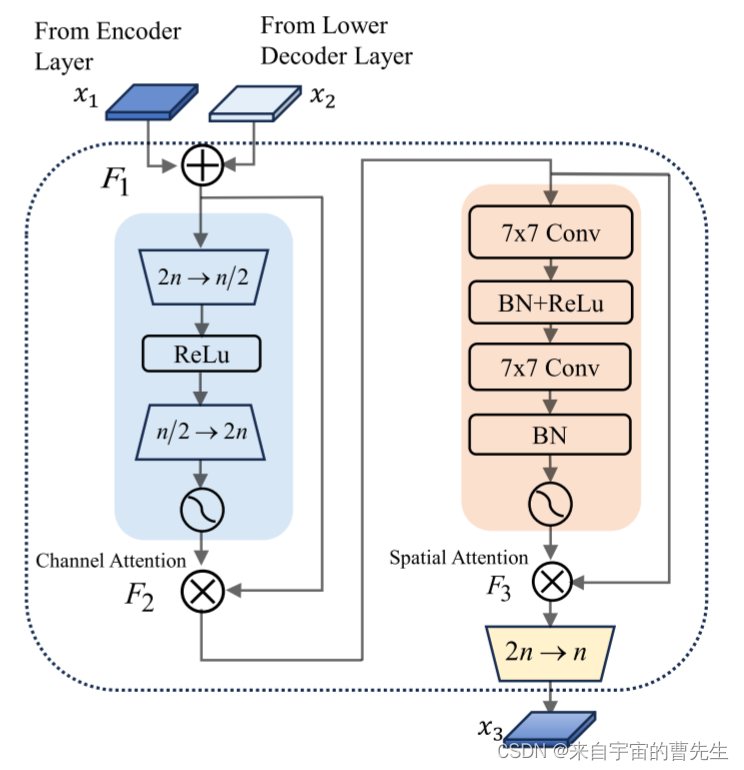

跳跃连接(Skip Connection Channel-Spatial Attention )SCCSA

与使用单一注意力机制相比,通道和空间注意力的结合可以增强模型捕捉更广泛上下文特征的能力。

提出了一种跳跃连接通道空间注意力,简称SCCSA。

SCCSA模块可以有效补偿下采样造成的空间信息损失,增强解码器每层多尺度特征的全局维度交互,从而在生成输出掩码的同时恢复细粒度细节。

SCCSA模块包括通道注意力子模块和空间注意力子模块。

首先通过级联编码器和解码器的输出,导出

F

1

ϵ

R

h

×

w

×

2

n

F1\epsilon R^{h\times w\times 2n}

F1ϵRh×w×2n

然后,通道注意力子模块使用多层感知器(MLP)的编码器-解码器结构放大跨维度信道空间相关性,其缩减率为e=4。使用两个7×7卷积层来关注来自通道注意力子模块的具有相同缩减率e的空间信息。给定输入特征图

x

1

,

x

2

ϵ

R

h

×

w

×

n

x_{1}, x_{2}\epsilon R^{h\times w\times n}

x1,x2ϵRh×w×n

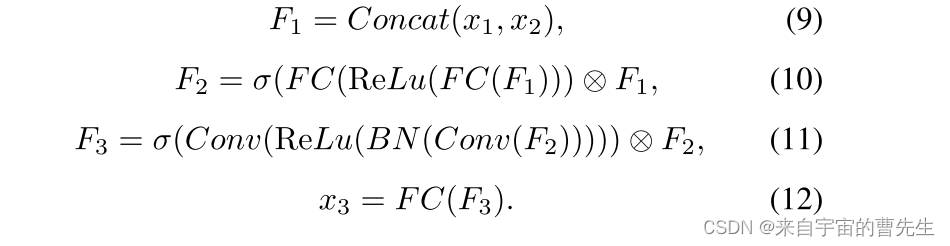

中间状态F1,F2,F3,然后输出x3定义为:

其中F2和F3分别是通道和空间注意力子模块的输出;⊗和σ分别表示元素乘法和sigmoid激活函数。

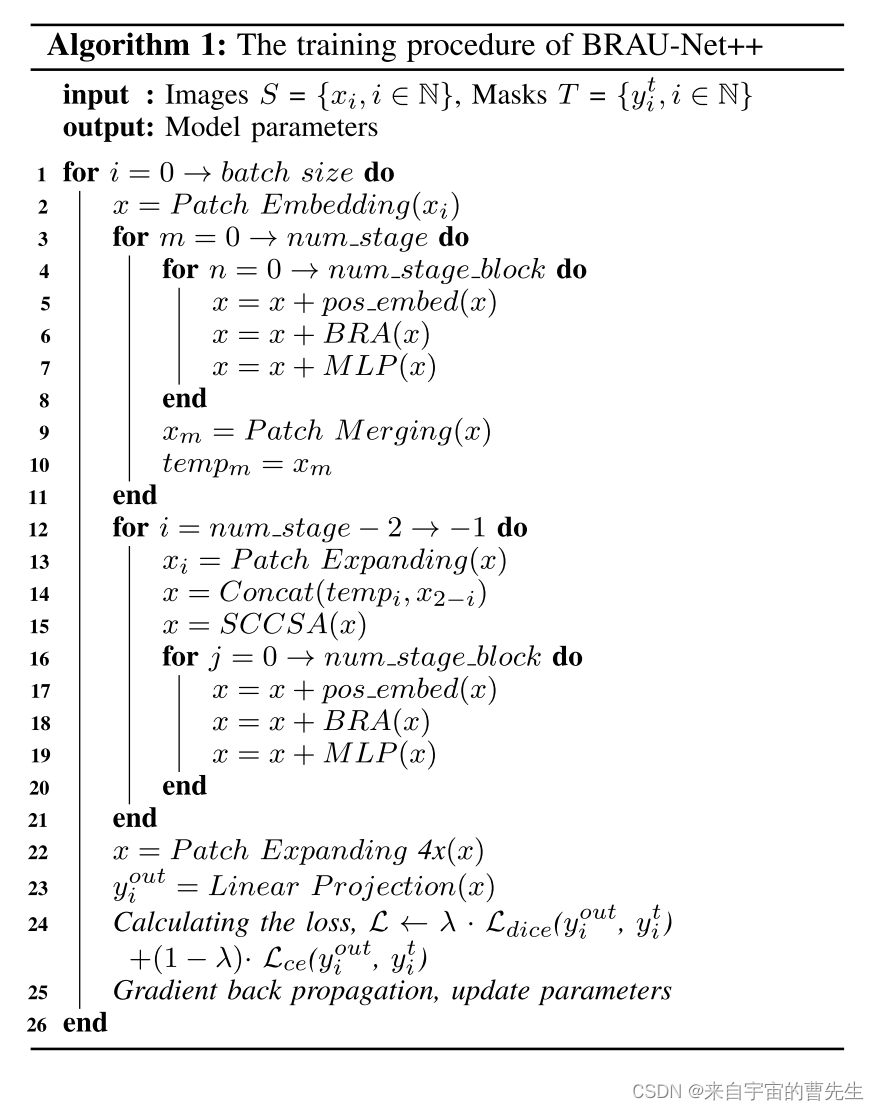

算法训练流程

-

算法接收两个输入:一组图像

S和一组对应的掩码T,目标是训练模型参数。 -

对于每个批次中的图像

xi,执行以下步骤:a.

Patch Embedding:将输入图像xi分解成小块(patches),并将它们转换成嵌入(embedding),这是一个向量表示。b. 进行多个阶段(

num_stage)的处理,每个阶段包含多个块(num_stage_block),对于每个块执行以下操作:- 加入位置嵌入

pos_embed,这有助于网络理解图像中各个部分的位置信息。 - 应用BRA(可能是某种注意力机制或块重复的处理)和MLP(多层感知机)来提取特征和进行非线性转换。

c.

Patch Merging:在每个阶段结束时,合并小块以减少维度,增加每个小块的信息内容。 - 加入位置嵌入

-

在经过初始阶段后,进行反向阶段(

num_stage - 2到-1)的处理,这可能是一个解码或上采样过程,包括:a.

Patch Expanding:与Patch Merging相反,它增加了特征的维度,恢复了一些分辨率。

b.Concat:将扩展的特征与之前的某个阶段的输出进行拼接。

c. 应用SCSA(这可能是另一种特殊的注意力机制或特征选择步骤)。 -

在所有阶段处理完成后,执行最终的

Patch Expanding以进一步提高特征的分辨率。 -

应用

Linear Projection来产生输出yi,这可能是一个分类、分割或其他类型的预测。 -

计算损失函数

L,结合了Ldice和Lce两种损失,这通常是在图像分割任务中用于比较预测掩码和真实掩码之间的相似性。 -

使用梯度反向传播算法更新模型参数。

整体来看,这个算法是一个多阶段的特征提取和转换网络,用于图像处理任务,可能是图像分割。通过在多个尺度上处理图像特征,并通过损失函数优化来学习复杂的表示。

实验结果

消融实验

结论

本论文提出了一种精心设计的U形混合CNN转换器架构BRAU-Net++,它利用动态稀疏注意力而不是全注意力或静态手工制作的稀疏注意力,可以有效地学习局部全局语义信息,同时降低计算复杂度。本文提出了一个新的模块:跳跃连接通道空间注意力(SCCSA)来整合多尺度特征,以补偿空间信息的损失,增强跨维度的交互作用。实验结果表明,在Synapse多器官分割、ISIC-2018 Challenge和CVCClinicDB数据集的几乎所有评估指标下,本论文提出的方法都能实现SOTA性能,尤其擅长捕捉小目标的特征。

个人感悟

本文介绍了一种先进的分割模型,该模型集成了CNN和transformer架构的优势,用于医学成像。

BRAU-Net++使用双级路由注意机制,并包括一个重新设计的跳跃连接通道-空间注意(SCCSA)来解决下采样空间信息丢失问题。该模型旨在有效地捕获局部和全局信息,在保持计算效率的同时提高分割精度。

作者已经在几个基准数据集上测试了他们的模型,显示出比以前最先进的方法更有希望的结果。他们强调在医学图像中准确分割的精细细节和全局背景之间的平衡,这对诊断和治疗计划至关重要。

本文对提高医学图像分析的认识和能力具有重要意义。然而,可能还有改进的空间,例如进一步优化模型的计算效率,探索其可转移到其他类型的医学成像数据,或研究模型在有限数据或无监督学习场景下的表现。这些潜在的改进可以使模型更加通用,并适用于各种现实世界的临床环境。

2. 学习内容

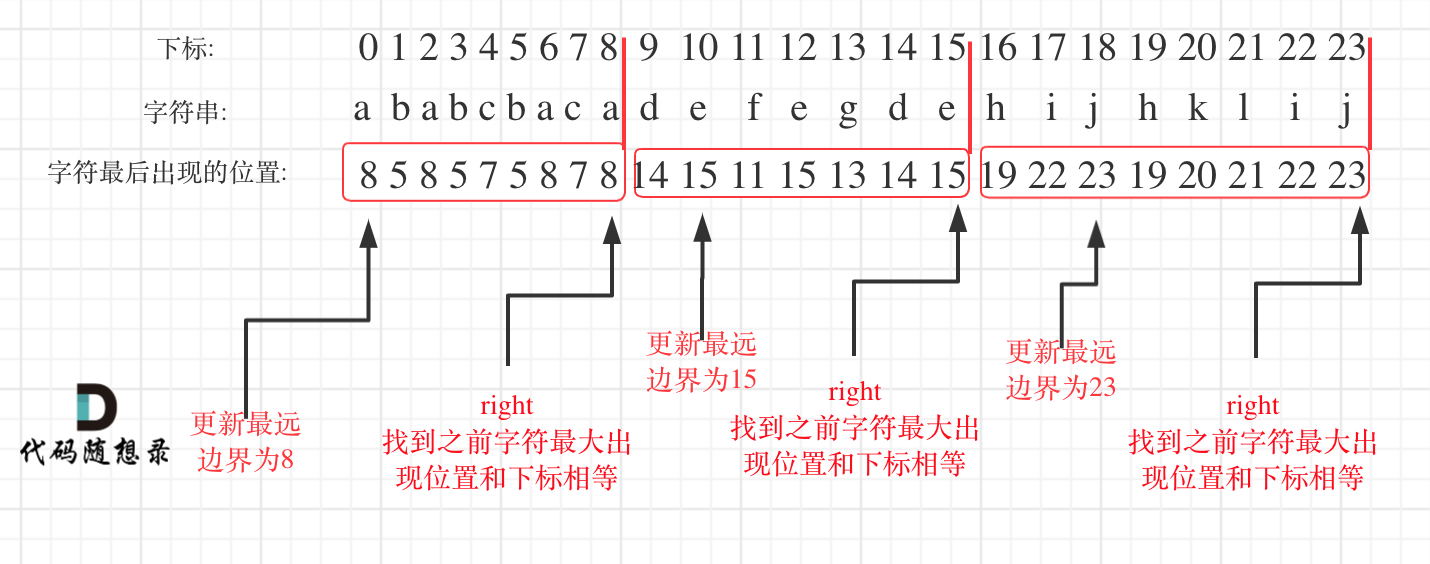

双层路由注意(Bi-Level Routing Attention)

双重路由注意力(Dual-Path Routing Attention)是一种用于增强神经网络模型性能的注意力机制。这个注意力机制的目标是在处理序列数据或图数据时,有效地捕捉不同级别的信息交互,以提高模型的性能。它在处理序列或图像时采用双层结构。这种机制通常涉及到两个层次的注意力分配:在较低的层次上,模型专注于局部特征或序列的细节;在较高的层次上,模型则把注意力放在全局上下文或更广泛的序列特征上。这样,模型可以同时捕捉到细节信息和全局信息,从而提高处理复杂数据时的性能。在医学图像分割中,这种机制有助于精准定位和区分不同的解剖结构或病理特征。

-

背景:

在深度学习中,序列数据或图数据通常需要考虑不同层级或不同分辨率的信息交互,以更好地理解和表示数据。传统的注意力机制通常依赖于一个注意力矩阵,该矩阵用于计算输入的加权和,但它们有时会限制模型的能力,特别是当需要处理多层次的信息时。 -

双重路由注意力的思想:

双重路由注意力引入了两个不同的路径(或通道)来处理输入数据,分别称为“通道注意力”和“空间注意力”。这两个路径允许模型在不同的维度上学习如何关注数据。-

通道注意力:通道注意力关注输入数据的不同通道或特征维度。它的目标是确定哪些特征通道对当前任务更重要,以便更好地表示数据。通道注意力的计算通常涉及计算特征通道之间的相关性或重要性权重。

-

空间注意力:空间注意力关注输入数据的不同位置或空间维度。它的目标是确定哪些位置或区域在当前任务中更重要。空间注意力的计算通常涉及计算不同位置之间的相关性或重要性权重。

-

-

计算过程:

双重路由注意力的计算过程如下:a. 通道注意力计算:首先,通过对输入数据的通道维度进行操作,计算出通道注意力权重。这可以使用不同的机制,例如全局平均池化或1x1卷积等。

b. 空间注意力计算:接下来,通过对输入数据的空间维度进行操作,计算出空间注意力权重。这可以使用卷积操作或其他空间操作来实现。

c. 融合路径:最后,将通道注意力和空间注意力权重相乘,然后将它们应用于原始输入数据,以生成最终的注意力增强表示。这可以通过加权和的方式来实现。

-

应用领域:

双重路由注意力可以应用于多个领域,如自然语言处理、计算机视觉和图神经网络。它可以帮助模型更好地理解和表示数据,从而提高性能。

总的来说,双重路由注意力是一种强大的注意力机制,它通过引入两个不同的关注路径,允许模型在通道和空间维度上更好地捕捉信息交互,从而提高模型在各种任务中的性能。这种注意力机制的应用可以根据具体任务和数据类型进行定制。