AI视野·今日CS.NLP 自然语言处理论文速览

Mon, 15 Jan 2024

Totally 57 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

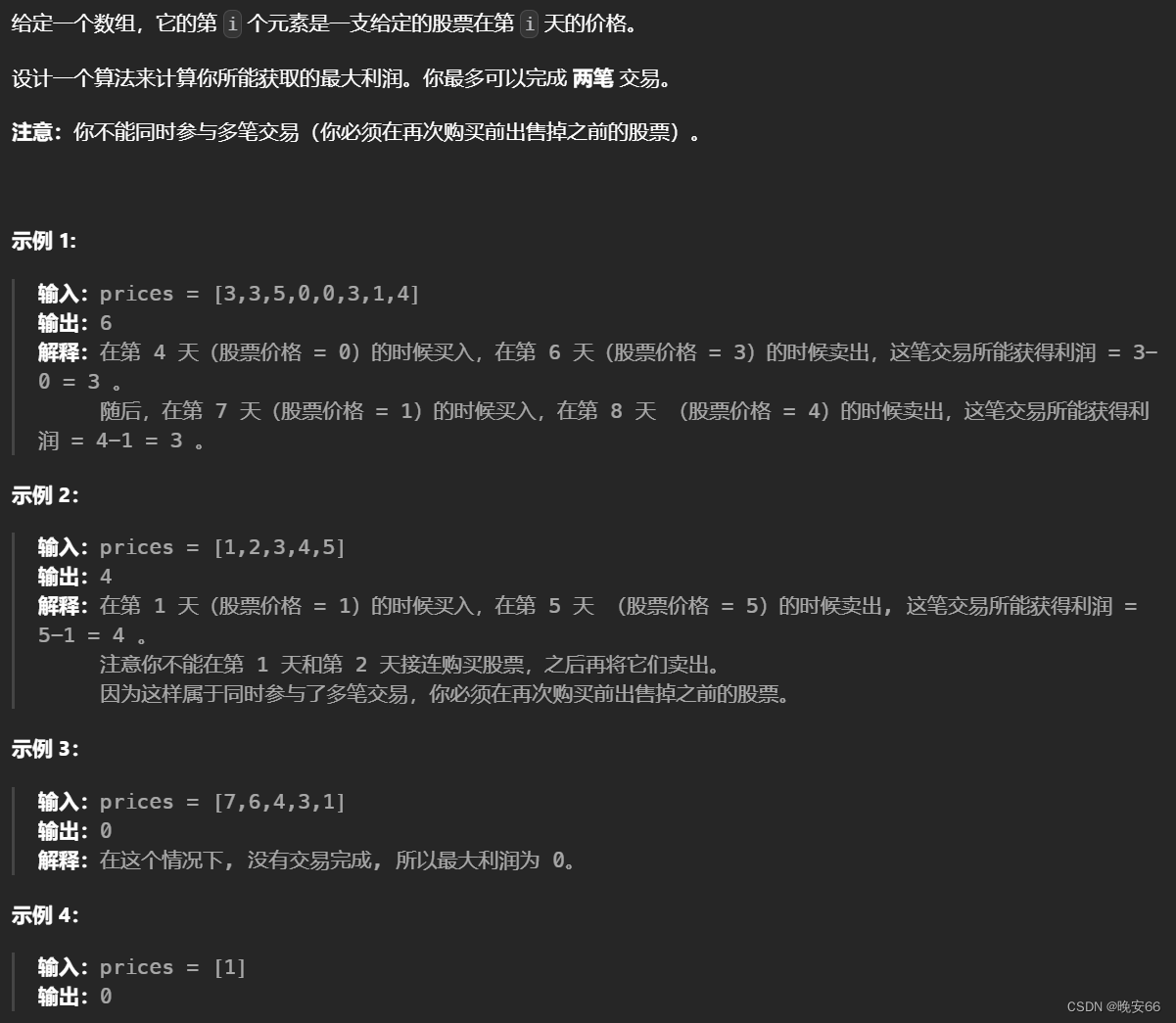

| Machine Translation Models are Zero-Shot Detectors of Translation Direction Authors Michelle Wastl, Jannis Vamvas, Rico Sennrich 检测并行文本的翻译方向不仅可用于机器翻译训练和评估,还具有法医应用,例如解决抄袭或伪造指控。在这项工作中,我们基于翻译语或机器翻译语中众所周知的简化效应的简单假设,探索一种无监督的翻译方向检测方法。在跨 20 个翻译方向的大规模多语言机器翻译模型的实验中,我们确认了该方法对于高资源语言对的有效性,根据所使用的模型,NMT 生成的翻译的文档级别准确度为 82 96,人工翻译的文档级别准确度为 60 81 。 |

| Mind Your Format: Towards Consistent Evaluation of In-Context Learning Improvements Authors Anton Voronov, Lena Wolf, Max Ryabinin 大型语言模型展示了从几个例子中学习解决新任务的卓越能力。提示模板,或者输入示例的格式化方式以获得提示,是上下文学习中一个重要但经常被忽视的方面。在这项工作中,我们对模板格式对上下文学习性能的影响进行了全面的研究。我们评估了提示模板在 770M 到 70B 参数和 4 个标准分类数据集的模型中的影响。我们表明,模板选择不当可能会将最强模型和推理方法的性能降低到随机猜测水平。更重要的是,最好的模板不会在不同的设置之间转移,甚至不会在同一系列的型号之间转移。我们的研究结果表明,目前流行的评估方法忽视了模板的选择,可能会因不同作品中的模板不同而给出误导性的结果。作为缓解这个问题的第一步,我们提出了模板集成,它可以聚合多个模板的模型预测。 |

| APAR: LLMs Can Do Auto-Parallel Auto-Regressive Decoding Authors Mingdao Liu, Aohan Zeng, Bowen Wang, Peng Zhang, Jie Tang, Yuxiao Dong 大型语言模型法学硕士的大规模采用需要高效的部署策略。然而,自回归解码过程是大多数法学硕士生成文本的基础,它对实现高效服务提出了挑战。在这项工作中,我们介绍了一种并行自回归生成方法。通过指导对包含层次结构的一般领域数据进行调整,我们使 LLM 能够独立规划其生成过程并执行自动并行自动回归 APAR 生成,从而显着减少生成步骤的数量。单独使用 APAR 即可实现高达 2 倍的加速,与推测解码结合使用时,加速可达 4 倍。此外,APAR减少了生成过程中的键值缓存消耗和注意力计算。 |

| Navigating the Metrics Maze: Reconciling Score Magnitudes and Accuracies Authors Tom Kocmi, Vil m Zouhar, Christian Federmann, Matt Post 十年前,单一指标 BLEU 控制着机器翻译研究的进展。无论好坏,今天还没有这样的共识,因此研究人员很难发展和保留推动早期研究和部署决策的关于度量增量的启发式直觉。本文研究了许多现代指标的动态范围,旨在提供对指标内部和指标之间分数差异含义的集体理解,换句话说,我们询问两个系统之间需要指标 Y 中的点差 X让人类注意到我们对一个新的大型数据集 ToShip23 进行评估,用它来发现指标实现对人类有意义的系统级差异的增量,我们通过成对系统准确性来衡量这些差异。我们还表明,就测试集大小而言,这种建立增量准确度的方法比统计 p 值的标准使用更稳定。 |

| Stylometry Analysis of Multi-authored Documents for Authorship and Author Style Change Detection Authors Muhammad Tayyab Zamir, Muhammad Asif Ayub, Asma Gul, Nasir Ahmad, Kashif Ahmad 近年来,越来越多地使用基于人工智能的文本生成工具,给文档来源、身份验证和作者检测带来了新的挑战。然而,风格测定学的进步为使用风格分析技术在多作者文档中自动作者身份和作者变更检测提供了机会。风格分析可以作为通过作者身份检测实现文档来源和身份验证的主要步骤。本文研究了风格分析的三个关键任务:i 单作者和多作者文档的分类;ii 单一更改检测(涉及识别作者切换的点);以及 iii 多作者文档中的多作者切换检测。我们将所有三个任务表述为分类问题,并提出了一个基于优点的融合框架,该框架集成了多种最先进的自然语言处理 NLP 算法和权重优化技术。我们还通过对清理后的数据集和原始数据集进行广泛的实验,探索特殊字符(通常在 NLP 应用程序的预处理过程中被删除)对这些任务所提出的方法的性能的潜力。 |

| The Unreasonable Effectiveness of Easy Training Data for Hard Tasks Authors Peter Hase, Mohit Bansal, Peter Clark, Sarah Wiegreffe 当硬训练数据根据定义很难正确标记时,我们如何训练模型在硬测试数据上表现良好?这个问题被称为可扩展监督问题,并且随着语言模型的不断改进而引起越来越多的关注。在本文中,我们提出了一个令人惊讶的结论,即当前的语言模型通常能够相对较好地从简单数据到硬数据进行泛化,甚至表现得与在硬数据上训练的预言机模型一样好。我们使用上下文学习、线性分类器头和 QLoRA 等简单的训练方法来演示这种从易到难的泛化,用于七种不同的数据点硬度测量,包括六种经验丰富的人类硬度测量,如年级水平和一种基于模型的测量损失。此外,我们表明,即使人们最关心硬数据上的模型性能,收集和训练简单数据也比硬数据更好,因为硬数据通常噪声更大,收集成本更高。我们的实验使用大小高达 70b 的开放模型和四个公开可用的问答数据集,问题的难度范围从三年级科学问题到大学水平的 STEM 问题和一般知识琐事。我们得出的结论是,对于所研究的任务而言,LM 中从易到难的泛化能力出人意料地强大,这表明可扩展的监督问题可能比之前想象的更容易。 |

| Using Natural Language Inference to Improve Persona Extraction from Dialogue in a New Domain Authors Alexandra DeLucia, Mengjie Zhao, Yoshinori Maeda, Makoto Yoda, Keiichi Yamada, Hiromi Wakaki 虽然 PersonaChat 等有价值的数据集为训练基于角色的对话代理提供了基础,但它们在对话和叙事环境中缺乏多样性,而这些多样性主要存在于现实世界中。为了开发具有独特角色的对话代理,需要训练模型来与给定的特定角色进行对话,但手工制作这些角色可能非常耗时,因此存在从现有角色特定对话中自动提取角色信息的方法。然而,这些角色提取模型也在源自 PersonaChat 的数据集上进行训练,并且很难从现实世界中不发生的对话设置中提供高质量的角色信息,例如以幻想为中心的数据集 LIGHT。创建新数据来在特定环境下训练模型需要大量人力,因此成本高昂。为了解决这两个问题,我们引入了一种自然语言推理方法,用于事后将经过训练的角色提取模型适应新的设置。我们从对话自然语言推理 NLI 文献中汲取灵感,设计了 NLI 重排序方法来从对话中提取结构化人物角色信息。 |

| Relying on the Unreliable: The Impact of Language Models' Reluctance to Express Uncertainty Authors Kaitlyn Zhou, Jena D. Hwang, Xiang Ren, Maarten Sap 随着自然语言成为人类人工智能交互的默认界面,语言模型迫切需要在下游应用程序中适当地传达不确定性。在这项工作中,我们研究了 LM 如何通过自然语言整合对其响应的信心,以及下游用户如何响应 LM 所表达的不确定性。我们检查了公开部署的模型,发现语言模型在回答问题时无法表达不确定性,即使它们给出了错误的答案。可以明确提示 LM 表达信心,但往往过于自信,导致自信响应中的平均错误率高达 47。我们通过人体实验来测试 LM 过度自信的风险,并表明用户严重依赖 LM 世代,无论它们是否具有确定性。最后,我们研究了 RLHF 对齐中使用的偏好注释数据集,发现人类对不确定的文本存在偏见。 |

| Reframing Tax Law Entailment as Analogical Reasoning Authors Xinrui Zou, Ming Zhang, Nathaniel Weir, Benjamin Van Durme, Nils Holzenberger 法定推理是指将立法规定适用于以自然语言描述的一系列案件事实。我们将法定推理重新构建为类比任务,其中类比任务的每个实例都涉及法定推理的两个实例的组合。这将数据集大小增加了两个数量级,并引入了可解释性元素。我们表明,对于自然语言处理模型来说,该任务与原始任务大致一样困难。 |

| Few-Shot Detection of Machine-Generated Text using Style Representations Authors Rafael Rivera Soto, Kailin Koch, Aleem Khan, Barry Chen, Marcus Bishop, Nicholas Andrews 令人信服地模仿人类书写的指令调整语言模型的出现带来了巨大的滥用风险。例如,此类模型可用于剽窃、虚假信息、垃圾邮件或网络钓鱼。然而,这种滥用可以通过检测一段文本是否由语言模型而不是人类编写的能力来抵消。以前解决这个问题的一些方法依赖于在已确认的人类和机器书面文档的语料库上训练的监督方法。不幸的是,规范下的模型给基于神经网络的检测器带来了不可避免的挑战,使它们在面对数据变化时变得脆弱,例如发布进一步的语言模型,产生比用于训练检测器的模型更流畅的文本。先前的其他方法需要访问可能在推理或检测时生成相关文档的模型,这通常是不切实际的。鉴于这些挑战,我们追求一种根本不同的方法,不依赖于训练时关注的语言模型中的样本。相反,我们建议利用从人类创作的文本中估计的写作风格的表征。事实上,我们发现有效区分人类作者的特征也能有效区分人类和机器作者,包括最先进的大型语言模型,如 Llama 2、ChatGPT 和 GPT 4。此外,给出了每个作者组成的少数示例 |

| Reliability Analysis of Psychological Concept Extraction and Classification in User-penned Text Authors Muskan Garg, MSVPJ Sathvik, Amrit Chadha, Shaina Raza, Sunghwan Sohn 社会 NLP 研究界见证了心理健康分析的计算进步最近激增,为语言使用和自我感知之间的复杂相互作用建立了负责任的人工智能模型。这种负责任的人工智能模型有助于量化社交媒体上用户撰写的文本中的心理概念。在超越低级分类任务的思考中,我们将现有的二元分类数据集推进到通过解释的角度进行可靠性分析的更高级别的任务,将其作为安全措施之一。我们对 LoST 数据集进行注释,以捕获微妙的文本线索,这些线索表明 Reddit 用户的帖子中存在低自尊。我们进一步指出,为确定低自尊的存在而开发的 NLP 模型,更多地关注三种类型的文本提示:i 触发精神障碍的触发词,ii LoST 指示符强调低自尊的文本指示符,以及 iii 描述后果的后果词的精神障碍。我们实现现有的分类器来检查针对特定领域心理学任务的预训练语言模型 PLM 中的注意力机制。 |

| Multi-Candidate Speculative Decoding Authors Sen Yang, Shujian Huang, Xinyu Dai, Jiajun Chen 大型语言模型在各种 NLP 任务中表现出了令人印象深刻的能力,但它们以自回归方式生成文本非常耗时。加速它们的一种方法是推测解码,它从快速草稿模型中生成候选片段和标记序列,然后由目标模型并行验证。然而,候选令牌的接受率受到模型、数据集和解码设置等多个因素的限制。本文建议从草稿模型中采样多个候选者,然后将它们分批组织以进行验证。我们设计了有效的多候选验证算法,同时保持目标模型的分布。 |

| An Experimental Design Framework for Label-Efficient Supervised Finetuning of Large Language Models Authors Gantavya Bhatt, Yifang Chen, Arnav M. Das, Jifan Zhang, Sang T. Truong, Stephen Mussmann, Yinglun Zhu, Jeffrey Bilmes, Simon S. Du, Kevin Jamieson, Jordan T. Ash, Robert D. Nowak 在指令数据集上的监督微调 SFT 在实现现代大型语言模型法学硕士中观察到的卓越的零样本泛化能力方面发挥了至关重要的作用。然而,为指令生成高质量响应所需的注释工作变得异常昂贵,特别是随着指令数据集跨越的任务数量不断增加。主动学习可以有效地从未标记的池中识别有用的样本子集进行注释,但其高昂的计算成本仍然是其在法学硕士背景下广泛适用的障碍。为了减轻 SFT 的注释成本并规避主动学习的计算瓶颈,我们建议使用实验设计。实验设计技术选择信息最丰富的样本进行标记,并且通常会最大化某些不确定性和/或多样性的概念。在我们的工作中,我们实现了一个框架,该框架评估了几种现有的和新颖的实验设计技术,并发现这些方法始终能够以很少的计算开销显着提高标签效率。 |

| Don't Rank, Combine! Combining Machine Translation Hypotheses Using Quality Estimation Authors Giorgos Vernikos, Andrei Popescu Belis 神经机器翻译系统估计给定源句子的目标句子的概率,但这些估计可能与人类的偏好不一致。这项工作引入了 QE 融合,这是一种利用质量估计指标 QE 的方法,可以更好地与人类判断相关联,以综合改进的翻译。 QE 融合利用从模型中采样的候选池,使用 CometKiwi 等 QE 指标组合来自不同候选的跨度。我们将 QE 融合与波束搜索和最近的重新排序技术(例如最小贝叶斯风险解码或 QE 重新排序)进行比较。当应用于用于翻译 PolyLM、XGLM、Llama2 和 Mistral 的大型语言模型 LLM 以及超过五种语言对的多语言翻译模型 NLLB 时,我们的方法在 COMET 和 BLEURT 分数方面持续提高了翻译质量。值得注意的是,QE 融合对法学硕士展示了更大的改进,因为它们能够产生不同的输出。我们证明,我们的方法在超过一半的案例中生成了新颖的翻译,并且在不同数量的候选者 5 200 中始终优于其他方法。此外,我们凭经验确定 QE 融合与池中候选者的数量呈线性关系。 |

| Proximal Causal Inference With Text Data Authors Jacob M. Chen, Rohit Bhattacharya, Katherine A. Keith 最近基于文本的因果方法试图通过将非结构化文本数据作为部分或不完全测量的混杂变量的代理来减轻混杂偏差。这些方法假设分析师已经监督了给定实例子集文本的混杂因素的标签,但由于数据隐私或成本,这一限制并不总是可行。在这里,我们解决了一个重要的混杂变量完全未被观察到的设置。我们提出了一种新的因果推理方法,该方法分割预处理文本数据,从单独分割上的两个零样本模型推断出两个代理,并将这些代理应用于近端 g 公式中。我们证明我们的基于文本的代理方法满足近端 g 公式所需的识别条件,而其他看似合理的建议则不满足。我们在合成和半合成环境中评估我们的方法,发现它产生的估计值具有低偏差。 |

| WisdoM: Improving Multimodal Sentiment Analysis by Fusing Contextual World Knowledge Authors Wenbin Wang, Liang Ding, Li Shen, Yong Luo, Han Hu, Dacheng Tao 通过利用各种数据模式(例如文本、图像),情感分析正在迅速发展。然而,之前的大多数工作依赖于肤浅的信息,忽略了上下文世界知识的结合,例如源自给定图像和文本对但超出给定图像和文本对的背景信息,从而限制了它们实现更好的多模态情感分析的能力。在本文中,我们提出了一个名为 WisdoM 的插件框架,旨在利用从大型视觉语言模型 LVLM 导出的上下文世界知识来增强多模态情感分析。 WisdoM 利用 LVLM 全面分析图像和相应的句子,同时生成相关上下文。为了减少上下文中的噪音,我们还引入了一种免训练的上下文融合机制。多模态情感分析任务的不同粒度的实验结果一致表明,我们的方法有了实质性的改进,与几种最先进的方法相比,五种先进方法的平均 F1 分数为 1.89。 |

| Effects of diversity incentives on sample diversity and downstream model performance in LLM-based text augmentation Authors Jan Cegin, Branislav Pecher, Jakub Simko, Ivan Srba, Maria Bielikova, Peter Brusilovsky 最新的生成式大语言模型 LLM 已在数据增强任务中得到应用,其中少量文本样本经过 LLM 释义,然后用于微调模型。然而,需要更多的研究来评估不同的提示、种子数据选择策略、过滤方法或模型设置如何影响释义数据和下游模型的质量。在本研究中,我们研究了在众包禁忌词、先前异常值解决方案的提示以及先前异常值解决方案的链接中建立的三种文本多样性激励方法。使用这些激励方法作为法学硕士增强文本数据集的说明的一部分,我们测量它们对生成文本词汇多样性和下游模型性能的影响。我们比较了 5 个不同的法学硕士和 6 个数据集的效果。 |

| Experimental Contexts Can Facilitate Robust Semantic Property Inference in Language Models, but Inconsistently Authors Kanishka Misra, Allyson Ettinger, Kyle Mahowald 最近的零样本评估凸显了语言模型 LM 执行意义提取的能力的重要局限性。然而,现在众所周知,语言模型可以在实验上下文(例如上下文示例和说明)中展示出根本性的改进。这对于之前研究的意义敏感任务的转化效果如何?我们提出了一个案例研究,说明实验环境可以在多大程度上提高语言模型在执行属性继承、预测新概念的语义属性方面的鲁棒性,而之前的研究表明它们在这项任务上失败了。在仔细控制上下文示例和指令的性质后,我们的工作表明它们确实可以导致 LM 中不平凡的属性继承行为。 |

| OOP: Object-Oriented Programming Evaluation Benchmark for Large Language Models Authors Shuai Wang, Liang Ding, Li Shen, Yong Luo, Bo Du, Dacheng Tao 推进自动化编程需要强大而全面的代码生成基准,但当前的评估框架在很大程度上忽略了面向对象的编程 OOP,而倾向于函数式编程 FP,例如 HumanEval 和 MBPP。为了解决这个问题,我们的研究引入了一个开创性的以 OOP 为中心的基准测试,其中包含 431 个 Python 程序,这些程序包含基本的 OOP 概念和功能,例如类和封装方法。我们提出了一种新的评估指标 pass o,专为 OOP 定制,增强了传统的 pass k 衡量标准。我们对 23 个领先的大型语言模型法学硕士(包括通用模型和代码专用模型)的评估揭示了三个关键见解 1 通过 o 为 OOP 代码生成提供了更相关和全面的评估 2 尽管在 FP 方面表现出色,但像 WizardCoder 这样的代码专业法学硕士在 OOP 方面落后与 ChatGPT 3 等模型相比,所有高级 LLM 在我们的 OOP 基准测试中表现不佳,凸显了该领域迫切需要改进。 |

| TransliCo: A Contrastive Learning Framework to Address the Script Barrier in Multilingual Pretrained Language Models Authors Yihong Liu, Chunlan Ma, Haotian Ye, Hinrich Sch tze 有 293 种文字,代表 7,000 多种书面语言。由于各种原因,许多密切相关的语言使用不同的文字,这给多语言预训练语言模型mPLM通过词汇重叠学习跨语言知识带来了困难。因此,mPLM 呈现出来自不同脚本的脚本屏障表示位于不同的子空间中,这有力地说明了为什么涉及不同脚本的语言的跨语言迁移表现出次优性能。为了解决这个问题,我们提出了一个简单的框架 TransliCo,其中包含音译对比建模 TCM,通过对比训练数据中的句子和统一脚本 Latn 中的音译来微调 mPLM,在我们的例子中,这确保了表示空间的一致性不同的脚本。使用 Glot500 m(一种针对 500 多种语言进行预训练的 mPLM)作为我们的源模型,我们发现对其训练数据的一小部分 5 进行了调整,并将生成的模型称为 Furina。我们证明 Furina 不仅可以更好地对齐不同脚本的表示,而且在各种跨语言迁移任务上也优于原始的 Glot500 m。此外,我们在印度语群体的案例研究中取得了持续的改进,该群体的语言高度相关,但使用不同的文字。 |

| Mutual Enhancement of Large Language and Reinforcement Learning Models through Bi-Directional Feedback Mechanisms: A Case Study Authors Shangding Gu 大型语言模型 法学硕士展示了强化学习 RL 模型的卓越能力,例如规划和推理能力。然而,LLM 和 RL 模型协作的问题仍然需要解决。在本研究中,我们采用师生学习框架来解决这些问题,特别是通过为使用 RL 模型的 LLM 提供反馈,并在合作的多代理环境中为使用 LLM 的 RL 模型提供高级信息。在这个框架内,LLM 充当老师,而 RL 模型充当学生。两个智能体通过递归帮助的过程相互协作,例如我帮助你帮助我帮助。 LLM 代理向 RL 代理提供抽象信息,从而实现高效的探索和策略改进。反过来,RL 代理向 LLM 代理提供反馈,提供有价值的实时信息,帮助生成更有用的代币。这种双向反馈循环促进了两个智能体的优化、探索和相互改进,使他们能够完成越来越具有挑战性的任务。 |

| Prometheus-Vision: Vision-Language Model as a Judge for Fine-Grained Evaluation Authors Seongyun Lee, Seungone Kim, Sue Hyun Park, Geewook Kim, Minjoon Seo 评估视觉语言模型 VLM 生成的长格式响应具有挑战性。它不仅需要检查VLM是否遵循给定的指令,还需要验证文本输出是否正确地基于给定的图像。受到最近用 LM 评估 LM 的方法的启发,在这项工作中,我们建议用 VLM 评估 VLM。为此,我们提出了一个名为 Perception Collection 的新反馈数据集,其中包含用户在评估过程中可能关心的 15K 个定制评分标准。使用 Perception Collection,我们训练 Prometheus Vision,这是第一个开源 VLM 评估器模型,可以在评估过程中理解用户定义的评分标准。 Prometheus Vision 在开源模型中显示出与人类评估者和 GPT 4V 最高的 Pearson 相关性,显示了其对 VLM 透明且可访问的评估的有效性。 |

| Mapping Transformer Leveraged Embeddings for Cross-Lingual Document Representation Authors Tsegaye Misikir Tashu, Eduard Raul Kontos, Matthia Sabatelli, Matias Valdenegro Toro 文档推荐系统已成为在网络上查找相关内容的工具。然而,这些系统在推荐与查询语言不同的语言的文档时存在局限性,这意味着它们可能会忽略非母语的资源。这项研究的重点是通过使用映射到跨语言域的 Transformer Leverages Document Representations TLDR 来表示跨语言的文档。使用代表欧盟五种选定语言组合的 20 个语言对的三种映射方法对四种多语言预训练 Transformer 模型 mBERT、mT5 XLM RoBERTa、ErnieM 进行了评估。诸如配对检索率和倒数排名之类的指标用于衡量映射 TLDR 与非映射 TLDR 相比的有效性。 |

| Lost in the Source Language: How Large Language Models Evaluate the Quality of Machine Translation Authors Xu Huang, Zhirui Zhang, Xiang Geng, Yichao Du, Jiajun Chen, Shujian Huang 大型语言模型法学硕士在机器翻译评估任务中取得了显着的成果,但在如何利用所提供的数据进行评估方面仍然存在知识空白。本研究旨在探讨法学硕士如何利用源信息和参考信息来评估翻译,最终目标是更好地理解法学硕士的工作机制。为此,我们设计了跨各种输入模式和模型类型的受控实验,并采用粗粒度和细粒度提示来辨别源信息与参考信息的效用。令人惊讶的是,我们发现参考信息显着提高了评估准确性,而源信息有时会适得其反,这表明使用法学硕士评估翻译时缺乏跨语言能力。我们进一步对法学硕士的翻译错误检测进行了元评估,观察到类似的现象。 |

| Intention Analysis Prompting Makes Large Language Models A Good Jailbreak Defender Authors Yuqi Zhang, Liang Ding, Lefei Zhang, Dacheng Tao 将大型语言模型法学硕士与人类价值观结合起来,特别是在面对秘密和复杂的越狱时,提出了一项艰巨的挑战。在本研究中,我们提出了一种简单但高效的防御策略,即意图分析提示 IAPrompt 。其背后的原则是通过两个阶段的过程(1本质意图分析和2政策一致响应)触发LLM固有的自我纠正和提高能力。值得注意的是,IAPrompt 是一种仅推理的方法,因此可以在不影响其有用性的情况下增强法学硕士的安全性。在 Vicuna、ChatGLM、MPT、DeepSeek 和 GPT 3.5 上对 SAP200 和 DAN 基准进行的广泛实验表明,IAPrompt 可以持续显着降低响应平均 46.5 攻击成功率的危害性,并保持总体有用性。进一步的分析对我们的方法如何工作提供了一些见解。 |

| Medical Dialogue Generation via Intuitive-then-Analytical Differential Diagnosis Authors Kaishuai Xu, Wenjun Hou, Yi Cheng, Jian Wang, Wenjie Li 医疗对话系统因其具有提供快速诊断、治疗计划和健康咨询的潜力而吸引了越来越多的研究关注。在医学对话中,正确的诊断至关重要,因为它为未来的咨询奠定了基础。临床医生通常采用直觉推理和分析推理来制定鉴别诊断。这个推理过程假设并验证了多种可能的疾病,并努力产生全面而严格的诊断。然而,最近关于医学对话生成的研究忽视了鉴别诊断建模的重要性,这阻碍了这些系统的实际应用。为了解决上述问题,我们提出了一种具有直观分析鉴别诊断 IADDx 的医学对话生成框架。我们的方法首先通过基于直觉关联的检索进行鉴别诊断,然后通过图形增强分析程序对其进行细化。然后使用所得的鉴别诊断来检索医学知识并指导响应的生成。两个数据集的实验结果验证了我们方法的有效性。 |

| INTERS: Unlocking the Power of Large Language Models in Search with Instruction Tuning Authors Yutao Zhu, Peitian Zhang, Chenghao Zhang, Yifei Chen, Binyu Xie, Zhicheng Dou, Zheng Liu, Ji Rong Wen 大型语言模型法学硕士在各种自然语言处理任务中展示了令人印象深刻的能力。尽管如此,由于许多 IR 特定概念在自然语言中很少出现,因此它们在信息检索 IR 任务中的应用仍然具有挑战性。虽然基于提示的方法可以为法学硕士提供任务描述,但它们通常无法促进IR任务的全面理解和执行,从而限制了法学硕士的适用性。为了解决这一差距,在这项工作中,我们探索了指令调整的潜力,以提高法学硕士在 IR 任务中的熟练程度。我们引入了一个新颖的指令调优数据集 INTERS,包含跨三个基本 IR 类别查询理解、文档理解和查询文档关系理解的 21 项任务。这些数据源自 43 个不同的数据集,并带有手动编写的模板。我们的实证结果表明,INTERS 显着提高了各种公开的法学硕士(例如 LLaMA、Mistral 和 Phi)在搜索相关任务中的表现。此外,我们进行了全面的分析,以确定基本模型选择、指令设计、指令量和任务多样性对性能的影响。 |

| MetaHate: A Dataset for Unifying Efforts on Hate Speech Detection Authors Paloma Piot, Patricia Mart n Rodilla, Javier Parapar 仇恨言论是一种普遍且有害的在线言论形式,通常通过一系列诽谤来体现,从仇恨推文到诽谤性帖子。随着此类言论的激增,它将全球人民联系在一起,并对目标个人和社区构成重大的社会、心理、有时甚至是身体威胁。当前解决这一现象的计算语言方法依赖于标记的社交媒体数据集进行训练。为了统一努力,我们的研究提出了对全面元收集的迫切需求,提倡使用广泛的数据集来帮助有效解决这个问题。我们仔细检查了 60 多个数据集,有选择地将相关数据集成到 MetaHate 中。本文对现有馆藏进行了详细检查,强调了它们的优点和局限性。我们的发现有助于更深入地了解现有数据集,为训练更强大、适应性更强的模型铺平道路。 |

| AntEval: Quantitatively Evaluating Informativeness and Expressiveness of Agent Social Interactions Authors Yuanzhi Liang, Linchao Zhu, Yi Yang 虽然基于 LLM 的大型语言模型代理已成功模仿各种场景中的人类行为,但扩展上下文中复杂、多角色社交互动的领域仍未得到充分探索。由于隐私问题,这一挑战变得更加复杂,使得捕捉和利用复杂的现实生活交互变得困难。更重要的是,定量评估方法的缺乏阻碍了对高质量代理交互的追求,往往导致交互的信息量和表达能力受到限制,其特点是肤浅的闲聊,没有明确的意图。在这项工作中,我们利用桌面角色扮演游戏 TRPG 的规则来创建一个有利于复杂、上下文丰富的交互的环境,强调信息性和表现力。这种虚拟设置减轻了隐私问题,并激励代理进行有意义的、高质量的交互,作为其游戏目标的一部分。为了评估这些交互,我们引入了 Agent 交互评估框架 AntEval ,针对交互信息性和表达性的定性评估。具体来说,我们提出了两个新颖的评估指标信息交换精度 IEP 和交互表现力差距 IEG 。这些指标旨在评估分别侧重于信息交换和意图表达的场景中的交互。我们的实验结果证明了这些指标在评估交互质量方面的有效性。值得注意的是,正如我们的指标所强调的那样,我们确定了法学硕士在社交互动方面需要改进的重要领域。 |

| An investigation of structures responsible for gender bias in BERT and DistilBERT Authors Thibaud Leteno, Antoine Gourru, Charlotte Laclau, Christophe Gravier 近年来,基于 Transformer 的大型预训练语言模型 PLM 通过在各种任务上突破现有技术的性能界限,改变了自然语言处理 NLP 的格局。然而,这种性能提升伴随着复杂性的增加,因此,此类模型的大小高达数十亿个参数,这对其在嵌入式设备或短推理时间任务上的部署构成了限制。为了应对这种情况,出现了压缩模型,例如DistilBERT,在越来越多影响我们日常生活的应用程序中实现其使用民主化。一个关键问题是 PLM 及其精炼同行做出的预测的公平性。在本文中,我们通过形式化两个问题来对这个问题进行实证探索: 1 我们能否识别出 BERT 和 DistilBERT 中造成性别偏见的神经机制 2 蒸馏是否会加剧或减轻性别偏见,例如性别偏见? DistilBERT 是否比其未压缩版本 BERT 更容易出现性别偏见 我们的发现如下: I 无法识别产生偏见的特定层 II 每个注意力头都会统一编码偏见,除非是在敏感属性高度不平衡的代表性不足的类别的情况下 |

| Kun: Answer Polishment for Chinese Self-Alignment with Instruction Back-Translation Authors Tianyu Zheng, Shuyue Guo, Xingwei Qu, Jiawei Guo, Weixu Zhang, Xinrun Du, Chenghua Lin, Wenhao Huang, Wenhu Chen, Jie Fu, Ge Zhang 在本文中,我们介绍了 Kun,一种无需依赖手动注释即可为大型语言模型 LLM 创建高质量指令调优数据集的新颖方法。 Kun 采用基于指令反向翻译和答案完善的自训练算法,利用来自五道、万卷和 SkyPile 等不同来源的未标记数据,生成包含超过 100 万个中文教学数据点的大量数据集。这种方法与传统方法有很大不同,它使用自我管理过程来细化和选择最有效的指令输出对。我们在各种基准上对 6B 参数 Yi 模型进行的实验证明了 Kun 的稳健性和可扩展性。我们方法的核心贡献在于其算法的进步,增强了数据保留和清晰度,以及其创新的数据生成方法,大大减少了对昂贵且耗时的手动注释的依赖。该方法提供了一种可扩展且高效的解决方案,用于提高法学硕士的指令遵循能力,对其在不同领域的应用具有重大影响。 |

| Adapting Large Language Models for Document-Level Machine Translation Authors Minghao Wu, Thuy Trang Vu, Lizhen Qu, George Foster, Gholamreza Haffari 大型语言模型 法学硕士在各种自然语言处理 NLP 任务中取得了重大进展。最近的研究表明,在特定任务的微调之后,中等规模的法学硕士通常比规模较大的法学硕士表现更好。在这项工作中,我们深入研究了使法学硕士适应特定语言对的文档级机器翻译 DocMT 的过程。首先,我们探讨即时策略如何影响下游翻译性能。然后,我们使用两种微调方法、三个 LLM 主干和跨 9 个语言对的 18 个翻译任务进行了广泛的实验。我们的研究结果表明,在某些情况下,这些专门模型的翻译性能甚至超过了 GPT 4,而在其他模型中,即使它们专门针对双语并行文档进行了微调,但它们仍然严重受到脱靶翻译问题的影响。此外,我们还对这些为 DocMT 量身定制的法学硕士进行了深入分析,探讨了翻译错误、并行文档的缩放规律、域外泛化以及零样本跨语言迁移的影响等方面。 |

| PersianMind: A Cross-Lingual Persian-English Large Language Model Authors Pedram Rostami, Ali Salemi, Mohammad Javad Dousti 大型语言模型在各种语言任务中表现出卓越的熟练程度,并在各个领域拥有广泛的知识。尽管他们在英语方面表现最好,但他们在其他语言方面的能力也很引人注目。相比之下,LLaMa 等开源模型主要在英语数据集上进行训练,导致在非英语语言中表现不佳。在本文中,我们介绍了 PersianMind,这是一种开源双语大语言模型,其在波斯语中的性能可与闭源 GPT 3.5 Turbo 相媲美。 |

| BOK-VQA: Bilingual Outside Knowledge-based Visual Question Answering via Graph Representation Pretraining Authors Minjun Kim, Seungwoo Song, Youhan Lee, Haneol Jang, Kyungtae Lim 目前生成模型的研究方向,例如最近开发的GPT4,旨在为多模态、多语言输入寻找相关知识信息,以提供答案。在这些研究背景下,作为多模态系统代表性任务的视觉问答VQA任务的多语言评估需求不断增加。因此,我们在本研究中提出了一个可以扩展到多语言的双语外部知识 VQA BOK VQA 数据集。所提出的数据包括 17K 图像、17K 韩语和英语问答对以及 280K 与问答内容相关的知识信息实例。我们还提出了一个框架,可以通过以图嵌入的形式预训练 BOK VQA 数据的知识信息,有效地将知识信息注入到 VQA 系统中。 |

| From Automation to Augmentation: Large Language Models Elevating Essay Scoring Landscape Authors Changrong Xiao, Wenxing Ma, Sean Xin Xu, Kunpeng Zhang, Yufang Wang, Qi Fu 接收即时和个性化的反馈对于第二语言学习者来说至关重要,而自动作文评分 AES 系统是当人类教师无法使用时的重要资源。本研究调查了大型语言模型 LLM(特别是 GPT 4 和微调 GPT 3.5)作为 AES 工具的有效性。我们在公共和私人数据集上进行的一系列综合实验凸显了基于 AES 系统的 LLM 的显着优势。它们包括卓越的准确性、一致性、普遍性和可解释性,经过微调的 GPT 3.5 超越了传统的评分模型。此外,我们还开展法学硕士辅助人类评估实验,涉及新手和专家评分者。一项关键的发现是,法学硕士不仅可以自动化评分过程,还可以提高人类评分者的表现。新手评分者在获得法学硕士生成的反馈后,可以达到与专家相当的准确性水平,而专家则变得更加高效,并在评估中保持更大的一致性。 |

| Mission: Impossible Language Models Authors Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts 乔姆斯基和其他人非常直接地声称,大型语言模型法学硕士同样能够学习人类可能学习和不可能学习的语言。然而,很少有公开的实验证据支持这种说法。在这里,我们开发了一组不同复杂度的合成不可能语言,每种语言都是通过使用不自然的词序和语法规则系统地改变英语数据而设计的。这些语言处于不可能连续体上,一方面是本质上不可能的语言,例如英语单词的随机和不可逆的洗牌,另一方面是直观上可能并非不可能的语言,但在语言学中通常被认为是不可能的,特别是那些具有基于计算单词位置的规则。我们报告了广泛的评估,以评估 GPT 2 小模型学习这些毫无争议的不可能语言的能力,最重要的是,我们在整个训练的不同阶段进行这些评估,以比较每种语言的学习过程。我们的核心发现是,与英语作为对照相比,GPT 2 很难学习不可能的语言,这挑战了核心主张。 |

| AboutMe: Using Self-Descriptions in Webpages to Document the Effects of English Pretraining Data Filters Authors Li Lucy, Suchin Gururangan, Luca Soldaini, Emma Strubell, David Bamman, Lauren Klein, Jesse Dodge 大型语言模型 法学硕士的能力来自于他们的预训练数据,模型开发从数据管理开始。然而,关于在此初始阶段保留或删除哪些数据的决策正在接受审查。在我们的工作中,我们将网络文本(一种流行的预训练数据源)与其社会和地理背景联系起来。我们创建了一个包含 1030 万个网站创建者自我描述的新数据集,并从他们的主题兴趣、社会角色和地理背景中提取有关他们是谁以及他们在哪里的信息。然后,我们进行了第一项研究,调查十个质量和英语语言识别 langID 过滤器如何影响沿这些社交维度变化的网页。我们的实验阐明了数据管理中的一系列隐式偏好,我们表明一些质量分类器就像主题域过滤器一样,而 langID 可以忽略来自世界某些地区的英语内容。 |

| Generalizing Visual Question Answering from Synthetic to Human-Written Questions via a Chain of QA with a Large Language Model Authors Taehee Kim, Yeongjae Cho, Heejun Shin, Yohan Jo, Dongmyung Shin 视觉问答 VQA 是一项给定图像,并针对该图像提出一系列问题的任务。为了构建高效的VQA算法,需要大量的QA数据,这是非常昂贵的。基于模板生成合成问答对是一种获取数据的实用方法。然而,基于这些数据训练的 VQA 模型在复杂的人类书面问题上表现不佳。为了解决这个问题,我们提出了一种新方法,称为人类书面问题 QA 链 CoQAH。 CoQAH 利用大型语言模型和在合成数据上训练的 VQA 模型之间的一系列 QA 交互来推理并得出人类书面问题的逻辑答案。我们在两种类型的人类编写的 VQA 数据集(针对 3D 渲染和胸部 X 射线图像)上测试了 CoQAH 的有效性,发现它在两种类型的数据中都实现了最先进的准确性。 |

| An approach for mistranslation removal from popular dataset for Indic MT Task Authors Sudhansu Bala Das, Leo Raphael Rodrigues, Tapas Kumar Mishra, Bidyut Kr. Patra 利用计算机系统将内容从一种语言转换为另一种语言的过程称为机器翻译 MT。人们已经提出了各种技术来确保有效的翻译,保留源语言的上下文和词汇解释。端到端神经机器翻译 NMT 是一种流行的技术,现已广泛应用于现实世界的 MT 系统中。机器翻译系统需要大量并行数据集一种语言的句子以及另一种语言的翻译。这些数据集对于机器翻译系统在训练阶段学习两种语言的语言结构和模式至关重要。其中一个数据集是 Samanantar,它是印度语言 IL 的最大的可公开访问的并行数据集。由于该语料库是从各种来源收集的,因此包含许多不正确的翻译。因此,使用该数据集构建的机器翻译系统无法发挥其通常的潜力。在本文中,我们提出了一种算法来从训练语料库中删除误译并评估其性能和效率。选择两种印度语言IL,即印地语HIN和Odia ODI进行实验。为这两个 IL 构建了基线 NMT 系统,并研究了不同数据集大小的影响。使用 BLEU、METEOR 和 RIBES 等标准指标评估实验中的翻译质量。从结果中可以看出,从数据集中删除不正确的翻译可以使翻译质量更好。 |

| Adaptive Data Augmentation for Aspect Sentiment Quad Prediction Authors Wenyuan Zhang, Xinghua Zhang, Shiyao Cui, Kun Huang, Xuebin Wang, Tingwen Liu 方面情感四元预测 ASQP 旨在预测给定句子的四元情感元素,这是基于方面的情感分析领域的一项关键任务。然而,ASQP任务中数据不平衡问题尚未得到足够的重视。在本文中,我们将问题分为两部分:四元模式不平衡和方面类别不平衡,并提出了自适应数据增强 ADA 框架来解决不平衡问题。具体来说,具有条件函数的数据增强过程自适应地增强了尾部四边形模式和方面类别,从而缓解了 ASQP 中的数据不平衡。继之前的研究之后,我们还通过引入类别先验知识和语法引导解码目标,进一步探索了提取完整四边形的生成框架。 |

| How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs Authors Yi Zeng, Hongpeng Lin, Jingwen Zhang, Diyi Yang, Ruoxi Jia, Weiyan Shi 大多数传统的人工智能安全研究都将人工智能模型视为机器,并以安全专家开发的针对算法的攻击为中心。随着大型语言模型法学硕士变得越来越普遍和有能力,非专家用户也可能在日常交互中带来风险。本文介绍了越狱法学硕士作为人类沟通者的新视角,以探索日常语言交互和人工智能安全之间被忽视的交叉点。具体来说,我们研究如何说服法学硕士越狱。首先,我们提出了一个源自数十年社会科学研究的说服分类法。然后,我们应用分类法自动生成可解释的有说服力的对抗性提示 PAP 来越狱法学硕士。结果表明,说服显着提高了所有风险类别的越狱性能,在 10 次试验中,PAP 在 Llama 2 7b Chat、GPT 3.5 和 GPT 4 上始终取得超过 92 的攻击成功率,超过了最近以算法为重点的攻击。 |

| Learning from Semi-Factuals: A Debiased and Semantic-Aware Framework for Generalized Relation Discovery Authors Jiaxin Wang, Lingling Zhang, Jun Liu, Tianlin Guo, Wenjun Wu 我们引入了一项名为“广义关系发现 GRD”的新颖任务,用于开放世界关系提取。 GRD 旨在识别现有预定义关系中未标记的实例,或通过将实例分配给集群并为这些集群提供特定含义来发现新的关系。 GRD 的关键挑战是如何减轻由标记的预定义关系引起的严重模型偏差,以学习有效的关系表示,以及如何在对未标记实例进行分类或聚类时确定新关系的具体语义。然后,我们为该任务提出了一个新颖的框架 SFGRD,通过分两个阶段学习半事实来解决上述问题。第一阶段是半事实生成,由三视图去偏关系表示模块实现,其中我们以每个原始句子为主视图,设计两个去偏视图来生成该句子的半事实示例。第二阶段是由双空间三视图协作关系学习模块执行的半事实思维,其中我们设计集群语义空间和类索引空间来分别学习关系语义和关系标签索引。此外,我们设计了对齐和选择策略来整合两个空间,并通过跨三个视图进行半事实思维,为未标记数据建立自我监督学习循环。大量的实验结果表明,SFGRD 在关系标签索引和关系语义质量的准确度和余弦相似度方面分别超过了最先进的模型 2.36 sim 5.78 和 32.19 sim 84.45。 |

| Multi-Task Learning for Front-End Text Processing in TTS Authors Wonjune Kang, Yun Wang, Shun Zhang, Arthur Hinsvark, Qing He 我们提出了一种多任务学习 MTL 模型,用于联合执行文本转语音 TTS 前端文本规范化 TN 、词性词性标注和同形异义词消歧 HD 中常见的三个任务。我们的框架采用树状结构,其主干学习共享表示,后面是单独的任务特定头。我们进一步整合了预先训练的语言模型,以利用其内置的词汇和上下文知识,并研究如何最好地使用其嵌入,以便最有效地使我们的多任务模型受益。通过任务明智的消融,我们表明,与在单个或子任务组合上训练的模型相比,在所有三个任务上训练的完整模型实现了最强的整体性能,证实了我们的 MTL 框架的优势。最后,我们引入了一个新的高清数据集,其中包含不同上下文中各种同形异义词及其发音的平衡数量的句子。 |

| Misconfidence-based Demonstration Selection for LLM In-Context Learning Authors Shangqing Xu, Chao Zhang Georgia Institute of Technology 在使用大型语言模型进行上下文学习时,法学硕士擅长快速适应各种任务。然而,其成功取决于仔细选择示范,这在实践中仍然是一个障碍。目前解决这一问题的方法要么依赖于难以获得的外部监督,要么需要与法学硕士频繁互动,导致成本高昂。我们提出了一种称为 In Context Reflection ICR 的新方法来克服这些挑战。 ICR 战略性地选择演示,以减少法学硕士的输出与实际输入输出映射之间的差异。具体来说,ICR 从一组随机的初始演示开始,然后迭代地对其进行完善。在每个步骤中,它都会分析一组候选示例,并确定最有可能挑战法学硕士当前理解的示例,并通过称为“不信任”的新指标来衡量。然后选择这些最令人困惑的示例来替换当前集中信息量较少的演示。我们对包含 13 个子任务的 5 个不同数据集进行的综合评估显示了 ICR 的有效性。 |

| LEGOBench: Leaderboard Generation Benchmark for Scientific Models Authors Shruti Singh, Shoaib Alam, Mayank Singh 论文提交量的不断增加使得人们很难及时了解最新的研究进展。为了应对这一挑战,我们引入了 LEGOBench,这是一个用于评估生成排行榜的系统的基准。 LEGOBench 根据 arXiv 中 22 年的预印本提交数据以及 PapersWithCode 门户中的 11,000 多个机器学习排行榜进行整理。我们评估了四种传统的基于图的排名变体和三种最近提出的大型语言模型的性能。我们的初步结果显示自动排行榜生成方面存在显着的性能差距。 |

| EASYTOOL: Enhancing LLM-based Agents with Concise Tool Instruction Authors Siyu Yuan, Kaitao Song, Jiangjie Chen, Xu Tan, Yongliang Shen, Ren Kan, Dongsheng Li, Deqing Yang 为了解决复杂的现实世界任务,人们对大型语言模型法学硕士应用中的工具利用越来越感兴趣。要开发基于LLM的代理,通常需要LLM从不同的工具文档中了解许多工具功能。但这些文档可能多种多样、冗余或不完整,这极大地影响了法学硕士使用工具的能力。为了解决这个问题,我们引入了 EASYTOOL 框架,将多样化、冗长的工具文档转换为统一、简洁的工具指令,以方便工具的使用。 EasyTool 从不同来源的广泛工具文档中纯化了基本信息,并详细阐述了统一的界面(即工具指令),为基于 LLM 的代理提供标准化的工具描述和功能。对多个不同任务的大量实验表明,EasyTool 可以显着减少代币消耗并提高现实场景中工具使用的性能。 |

| DQNC2S: DQN-based Cross-stream Crisis event Summarizer Authors Daniele Rege Cambrin, Luca Cagliero, Paolo Garza 同时总结多个灾难相关数据流尤其具有挑战性,因为现有的检索重新排序策略受到多流数据固有的冗余和多查询设置中有限的可扩展性的影响。这项工作提出了一种基于 Deep Q 网络弱注释的危机时间线生成在线方法。它可以动态选择相关文本片段,无需人工注释或内容重新排名。这使得推理时间与输入查询的数量无关。所提出的方法还将冗余过滤器合并到奖励函数中,以有效处理跨流内容重叠。 |

| PolyTOPS: Reconfigurable and Flexible Polyhedral Scheduler Authors Gianpietro Consolaro, Zhen Zhang, Harenome Razanajato, Nelson Lossing, Nassim Tchoulak, Adilla Susungi, Artur Cesar Araujo Alves, Renwei Zhang, Denis Barthou, Corinne Ancourt, Cedric Bastoul 多面体技术已广泛用于低级编译器和高级进程中的自动代码优化。循环优化是该技术的核心,并且已经提出了几种多面体调度程序,例如 Feautrier、Pluto、isl 和 Tensor Scheduler,它们各自针对不同的架构、并行模型或应用场景。由于架构的异构性,对特定场景优化的需求不断增长。最关键的情况之一是用于人工智能的 NPU 神经处理单元,这可能需要针对不同目标的循环优化。另一个需要考虑的因素是进行多面体优化的框架或编译器。 |

| Batch-ICL: Effective, Efficient, and Order-Agnostic In-Context Learning Authors Kaiyi Zhang, Ang Lv, Yuhan Chen, Hansen Ha, Tao Xu, Rui Yan 在本文中,通过将上下文学习 ICL 视为元优化过程,我们解释了为什么法学硕士对 ICL 示例的顺序敏感。这种理解引导我们开发了 Batch ICL,这是一种有效、高效且与顺序无关的 ICL 推理算法。与标准的 N shot 学习方法不同,Batch ICL 采用 N 次单独的 1 shot 前向计算并聚合生成的元梯度。然后将这些聚合的元梯度应用于零样本学习以生成最终预测。这种批处理方法使 LLM 与 ICL 示例的顺序无关。通过广泛的实验和分析,我们证明 Batch ICL 始终优于示例序列的大多数排列。在某些情况下,它甚至超过了标准 ICL 的最佳性能,同时减少了所需的计算资源。此外,我们开发了 Batch ICL 的一种新颖变体,具有多个元优化时期。 |

| Between Lines of Code: Unraveling the Distinct Patterns of Machine and Human Programmers Authors Yuling Shi, Hongyu Zhang, Chengcheng Wan, Xiaodong Gu 大型语言模型催生了前所未有的代码生成浪潮。在取得重大进展的同时,它们模糊了机器和人类编写的源代码之间的区别,导致软件工件的完整性和真实性问题。以前的方法(例如 DetectGPT)已被证明可以有效识别机器生成的文本,但它们无法识别和利用机器生成代码的独特模式。因此,当应用于代码时,它的适用性就会减弱。在本文中,我们仔细研究了机器和人类编写的代码的特定模式。通过对长度、词汇多样性和自然性等代码属性的严格分析,我们揭示了每个源固有的独特模式。我们特别注意到,代码的结构分段是识别其来源的关键因素。根据我们的发现,我们提出了一种名为 DetectCodeGPT 的新型机器生成代码检测方法,该方法通过捕获代码的不同结构模式来改进 DetectGPT。与依赖外部 LLM 进行干扰的传统技术不同,DetectCodeGPT 通过策略性地插入空格和换行符来干扰代码语料库,从而确保功效和效率。 |

| DevEval: Evaluating Code Generation in Practical Software Projects Authors Jia Li, Ge Li, Yunfei Zhao, Yongmin Li, Zhi Jin, Hao Zhu, Huanyu Liu, Kaibo Liu, Lecheng Wang, Zheng Fang, Lanshen Wang, Jiazheng Ding, Xuanming Zhang, Yihong Dong, Yuqi Zhu, Bin Gu, Mengfei Yang 如何在代码生成中评估大型语言模型法学硕士是一个悬而未决的问题。已经提出了许多基准,但与实际的软件项目不一致,例如不真实的程序分布、不充分的依赖关系以及小规模的项目环境。因此,LLM在实际项目中的能力仍不清楚。在本文中,我们提出了一个名为 DevEval 的新基准,与开发人员在实际项目中的经验相一致。 DevEval 通过严格的管道收集,包含来自 119 个实际项目的 2,690 个样本,涵盖 10 个领域。与之前的基准相比,DevEval 在多个维度上与实际项目保持一致,例如真实的程序分布、足够的依赖关系和足够规模的项目上下文。我们在 DevEval 上评估了五种流行的 LLM,例如 gpt 4、gpt 3.5 Turbo、CodeLLaMa 和 StarCoder,并揭示了它们在代码生成方面的实际能力。例如,在我们的实验中,仅 gpt 3.5 Turbo 的最高 Pass 1 为 42。我们还讨论了实际项目中代码生成的挑战和未来方向。 |

| What should I say? -- Interacting with AI and Natural Language Interfaces Authors Mark Adkins 随着人工智能人工智能技术变得越来越普遍,探索人类如何与人工智能互动变得越来越重要。人机交互 HAI 子领域源自人机交互 HCI 领域,旨在研究这一概念。许多交互模式的实施并没有完全理解所需认知的变化,以及使用这些旨在变得更像人类的替代界面的认知科学含义。 |

| Zero-shot Generative Large Language Models for Systematic Review Screening Automation Authors Shuai Wang, Harrisen Scells, Shengyao Zhuang, Martin Potthast, Bevan Koopman, Guido Zuccon 系统评价对于循证医学至关重要,因为它们全面分析已发表的有关特定问题的研究结果。进行此类审查通常需要大量资源和时间,特别是在筛选阶段,评估出版物的摘要以将其纳入审查。本研究调查了使用零样本大型语言模型法学硕士进行自动筛选的有效性。我们评估了八个不同的法学硕士的有效性,并研究了一种校准技术,该技术使用预定义的召回阈值来确定出版物是否应纳入系统评价。我们使用五个标准测试集进行的综合评估表明,指令微调在筛选中发挥着重要作用,校准使法学硕士对于实现目标召回来说是实用的,并且将两者与零样本模型集合相结合可以节省大量筛选时间。 |

| Beyond the Surface: A Global-Scale Analysis of Visual Stereotypes in Text-to-Image Generation Authors Akshita Jha, Vinodkumar Prabhakaran, Remi Denton, Sarah Laszlo, Shachi Dave, Rida Qadri, Chandan K. Reddy, Sunipa Dev 最近的研究强调了文本到图像 T2I 模型世代中对不同身份群体的人的刻板描述问题。然而,这些现有的方法有几个关键的局限性,包括在评估中明显缺乏对全球身份群体的覆盖,以及其相关刻板印象的范围。此外,他们常常缺乏对固有视觉刻板印象(例如体重过轻或宽边帽)与文化依赖性刻板印象(例如有吸引力或恐怖分子)之间的严格区分。在这项工作中,我们通过多方面的方法解决了这些局限性,该方法利用现有的文本资源,将我们对 T2I 模型生成的图像中的地理文化刻板印象的评估作为基础。我们利用现有的刻板印象基准来识别和评估全球范围内的视觉刻板印象,涵盖 135 个国籍的身份群体。我们证明,与其他属性相比,刻板属性出现在这些身份图像中的可能性是其他属性的三倍。我们进一步调查了不同国籍的生成图像的描述有多么不同的冒犯性。最后,通过详细的案例研究,我们揭示了所有身份群体的默认表示如何具有刻板的外观。此外,对于南半球国家来说,即使有明确提示,不同属性的图像在视觉上也是相似的。 |

| Learning Unsupervised Semantic Document Representation for Fine-grained Aspect-based Sentiment Analysis Authors Hao Ming Fu, Pu Jen Cheng 文档表示是许多机器理解 NLP 任务的核心。以无监督方式学习的通用表示保留了通用性,并且可以用于各种应用。在实践中,情感分析 SA 一直是一项具有挑战性的任务,被认为与语义深度相关,并且通常用于评估一般表示。现有的无监督文档表示学习方法可以分为两类:顺序方法(明确考虑单词的顺序)和非顺序方法(不明确考虑单词的顺序)。然而,他们俩都有自己的弱点。在本文中,我们提出了一个克服这两种方法遇到的困难的模型。 |

| CrisisKAN: Knowledge-infused and Explainable Multimodal Attention Network for Crisis Event Classification Authors Shubham Gupta, Nandini Saini, Suman Kundu, Debasis Das 社交媒体的普遍使用已成为实时信息(例如图像、文本或两者)的新兴来源,以识别各种事件。尽管基于图像和文本的事件分类快速增长,但由于编码不一致,最先进的 SOTA 模型发现弥合图像和文本模态特征之间的语义差距具有挑战性。此外,模型的黑匣子性质无法解释该模型在灾难、流行病等高风险情况下建立信任的结果。此外,对社交媒体帖子施加的字数限制可能会导致对特定事件的偏见。为了解决这些问题,我们提出了 CrisisKAN,这是一种新颖的知识注入和可解释的多模态注意力网络,它将图像和文本与维基百科的外部知识结合起来对危机事件进行分类。为了丰富文本信息的上下文特定理解,我们使用提出的维基提取算法集成了维基百科知识。除此之外,还实现了引导交叉注意模块来填补集成视觉和文本数据中的语义差距。为了确保可靠性,我们采用了一种称为梯度加权类激活映射 Grad CAM 的模型特定方法,它为所提出的模型的预测提供了可靠的解释。对 CrisisMMD 数据集进行的综合实验对各种危机特定任务和环境进行了深入分析。 |

| End to end Hindi to English speech conversion using Bark, mBART and a finetuned XLSR Wav2Vec2 Authors Aniket Tathe, Anand Kamble, Suyash Kumbharkar, Atharva Bhandare, Anirban C. Mitra 长期以来,语音一直是有效沟通和联系的障碍,在我们日益互联的世界中一直是一个挑战。本研究论文介绍了针对这一长期障碍的变革性解决方案,即专为印地语到英语翻译量身定制的端到端语音转换框架,最终实现英语音频的合成。通过集成用于自动语音识别 ASR 的 XLSR Wav2Vec2、用于神经机器翻译 NMT 的 mBART 以及文本到语音 TTS 合成组件等尖端技术,该框架为跨语言通信提供了统一且无缝的方法。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com