目 录

1. 项目综述

1.1. 项目背景

1.2. 项目目标

1.3. 项目建设路线

2 需求分析

2.1功能需求

2.1.1 统一数据接入

2.1.2 数据迁移

2.1.3 数据范围与ETL

2.1.4 报表平台

2.1.5 安全管理

2.1.6 数据治理

2.2非功能需求

2.2.1运维保障需求

2.2.2可用性需求

2.2.3可靠性需求

2.2.4性能需求

2.3需求总结

3 整体解决方案

3.1 数据湖整体方案

3.1.1硬件部署方式

3.1.2基于CDH的数据湖软件部署

3.1.3数据ETL及数据接口开发方案

3.1.4沙盒管理

3.1.5多租户管理

3.2报表平台整体方案

3.2.1系统设计原则

3.2.2数据分析场景

3.2.3业务需求建议

3.2.4系统逻辑架构

3.2.5技术方案特点

3.2.6其它特性

3.2.7 报表平台具体实施步骤:

3.3数据仓库整体方案

3.3.1数仓的定义

3.3.2 数据仓库的特点

3.3.2 数据仓库具体实施步骤

3.4数据治理整体方案

3.4.1主数据管理实施

3.4.2元数据管理实施

4 企业版功能和特性

4.1 CDH核心套件

4.1.1 分布式文件系统HDFS

4.1.2 分布式数据库HBase

4.1.3 统一资源管理和调度框架YARN

4.1.4 分布式批处理引擎MapReduce

4.1.5 分布式内存计算框架Spark

4.1.6 数据仓库组件Hive

4.1.7 安全管理组件 Sentry

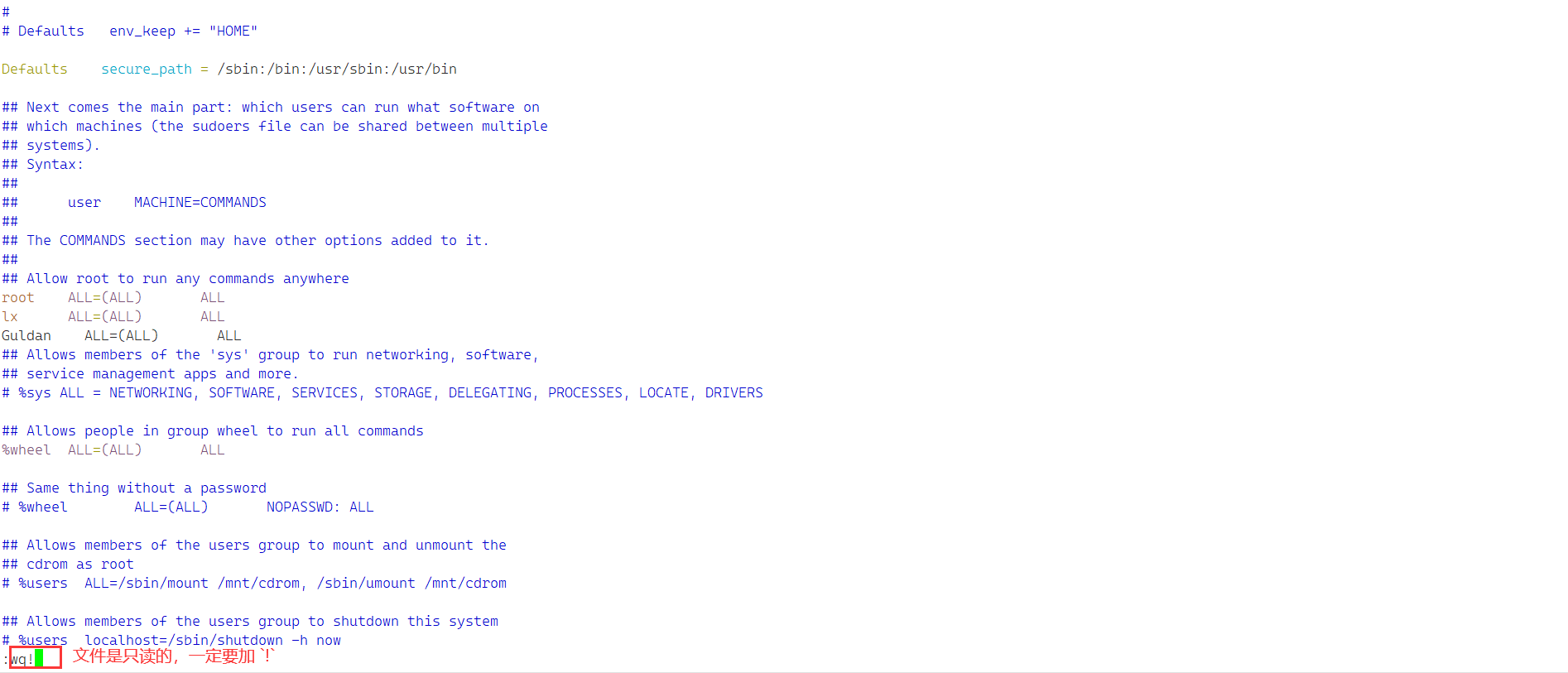

4.1.8 隐私保护

4.1.9 统一用户体验工具 HUE

4.1.10 元数据管理Metastore&HCatalog

4.1.11 高性能数据分析MPP引擎 Impala

4.1.12 数据导入导出工作Sqoop

4.1.13 消息处理总线Kafka

4.2 Manager集群管理组件

4.3 Navigator数据管理组件

5 项目建设

5.1项目实施计划

5.1.1项目实施服务

5.1.2人员构成

5.2验收说明

5.2.1验收依据

5.2.2验收内容和方式

5.3项目风险评估

6 6项目培训

6.1 培训服务简介

在线学习资源

6.2 标准课程简介

Hadoop集群管理课程

Hadoop技术开发课程

Hadoop数据分析课程

培训课程优势

培训质量保障

培训计划定义

6.3智慧企业大数据应用、管控、展示一体化云数据湖维护培训

7售后技术支持服务

7.1提供全程技术支持

7.2全周期技术支持

7.3协调原厂支持

7.3.1全周期的技术支持

7.3.2技术支持种类

7.3.3远程支持

7.3.4服务支持策略

7.4主动技术支持

7.5预测技术支持

7.6知识库

1.1. 项目建设路线

第一期:建设企业数据湖,梳理企业应用系统内部的业务数据类型,数据量;将结构化、非结构化数据打标签导入数据湖中心湖中,构建视频池、文本池和应用池分类。对某些应用场景构建BI报表分析。

第二期:建立主数据管理和数仓,ETL规范和流程,数据安全管理,数据可视化管理,数据监控的管理。梳理数据湖使用人员的角色和权限,对数据湖进行基于业务需求场景的多租户管理。根据业务的微服务化,逐步构建企业大数据微服务平台,细粒度的平台资源管理。

第三期:数据的深化应用,一体化管控数据标准和数据治理,深化主数据消费和应用。逐步将应用的数据来源迁移至数据湖中,形成数据应用平台、数据挖掘和BI报表平台,人工智能和机器学习平台。

2 需求分析

2.1功能需求

数据湖的应用、管控、展示为一体,提供标准的服务和数据接口和报表展现方式。数据湖数据采用高效,可靠的存储架构。企业业务数据制订迁移方案,将ERP系统、数据采集系统、OA系统、视频监控系统、云商系统中存储的核心数据,整体迁移至数据湖,非弹性资源实行本地化部署,对于弹性计算功能,需与算法数据湖进行协同计算。以实现核心数据可控,消除安全问题和潜在未知风险。支持可视化建模,支持鼠标拖拽方式进行人工智能算法建模。包括数据预处理、特征工程、算法模型、模型评估和部署等功能支持快销业务领域的预测预警等多种类型的算法应用,包括逻辑回归、K近邻、随机森林、朴素贝叶斯、K均值聚类、线性回归、GBDT二分类、GBDT回归等算法模型,也支持深度学习等人工智能训练模型。展示层通过统一的商业BI报表组件,多维度,动态的展示各业务系统的运行状况,资源使用情况等。并支撑周期性或临时性生成各业务状况,决策数据展示,故障分析挖掘等业务场景。

x x数据湖架构图

x x数据湖架构图

文件中心:

主要用于存储各种格式文件,包括影像文件,视频音频文件,PDF,Office文件等类型文件,提供文件级别的全文检索,文 件发布,文件共享,文件提取等功能。提供文件权限管理,版本管理,历史版本恢复等管理功能。

文件中心中文件内容可以经由ETL过程与日志中心,数据中心交换融合数据,共同参与数据处理,数据挖掘,机器学习,影像分析等工作。

日志中心:

收集各类日志数据,物联数据等实时数据,由流处理引擎实时处理数据,确保在第一时间分析处理数据,做到实时监控, 实时告警。

经处理的实时数据可与文件中心,数据中心的数据融合,共同参与数据分析等工作。

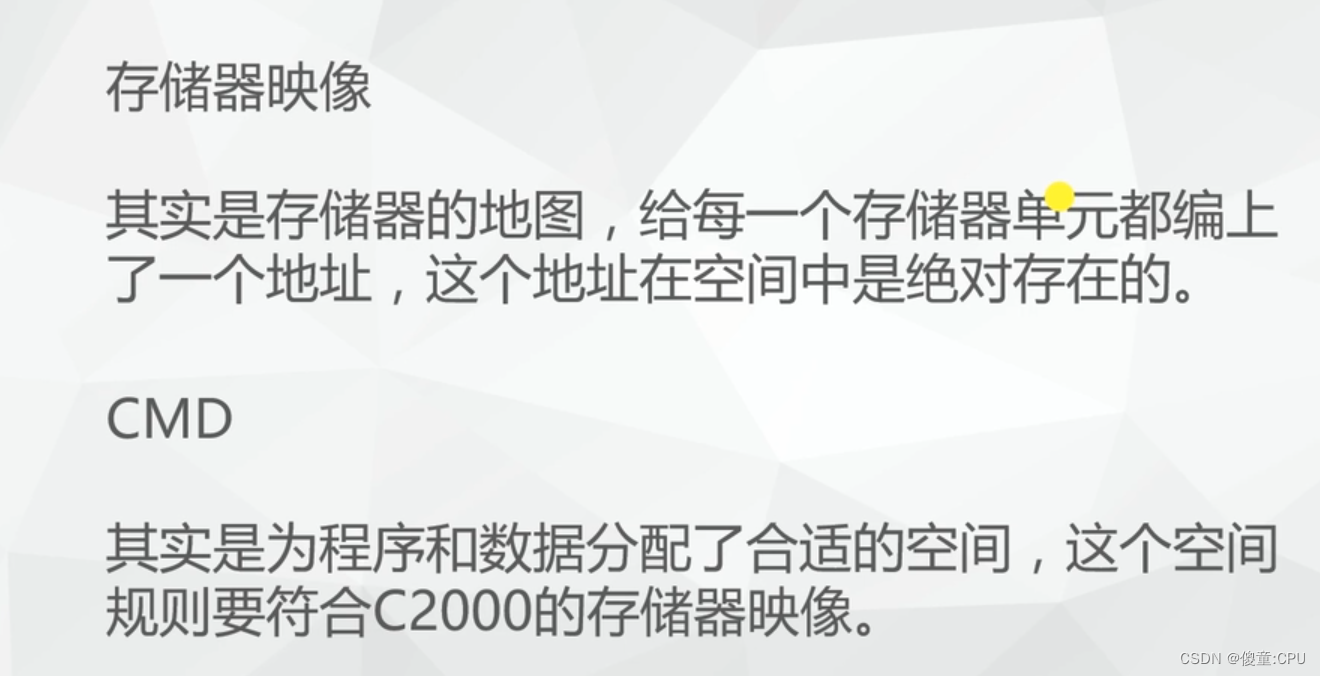

结构化数据中心:

实时(或批量)获取数据库或其他介质中的架构化数据,借助Hadoop/Spark等强大的处理能力,高效处理各类数据。

有效结合文件中心,日志中心中的数据共同参与数据分析,数据挖掘。

支持百亿级数据Cube,做到海量数据亚秒级多维度查询。

标准SQL输出接口,支持不断升级的需求以及二次开发。

文章引用的资料均通过互联网等公开渠道合法获取,仅作为行业交流和学习使用,并无任何商业目的。其版权归原资料作者或出版社所有,本文作者不对所涉及的版权问题承担任何法律责任。若版权方、出版社认为本文章侵权,请立即通知作者删除。