标题:EXTENDING CONTEXT WINDOW OF LARGE LANGUAGE MODELS VIA POSITION INTERPOLATION

论文:https://arxiv.org/pdf/2306.15595.pdf

发表:2023

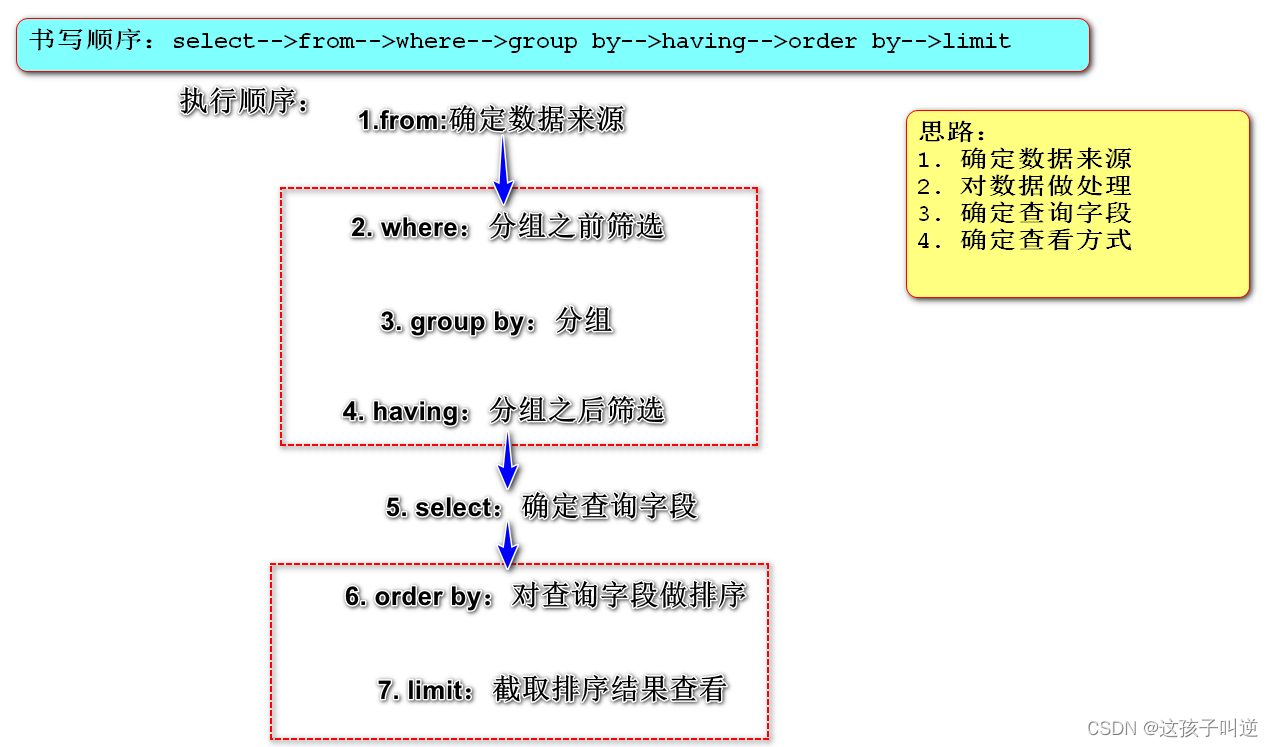

Transformer的长度外推技术分为两类:

1:修改推理:比如PI、NTK-RoPE、YaRN、ReRoPE等。

优点:可直接修改推理模型,无需微调就能达到一定的长度外推效果

缺点:无法保持模型在训练长度内的恒等性

2:修改训练:如ALIBI、KERPLE、XPOS以及HWFA等。

优点:训练和推理保持了一致性

缺点:无法直接用于现成模型,需要训练微调

动机

![[分章:阅读]《我的第一本算法书》](https://img-home.csdnimg.cn/images/20230724024159.png?origin_url=file%3A%2F%2F%2FC%3A%5CUsers%5CAdministrator%5CAppData%5CLocal%5CTemp%5Cksohtml13556%5Cwps41.png&pos_id=mqmGGETO)