1、下载

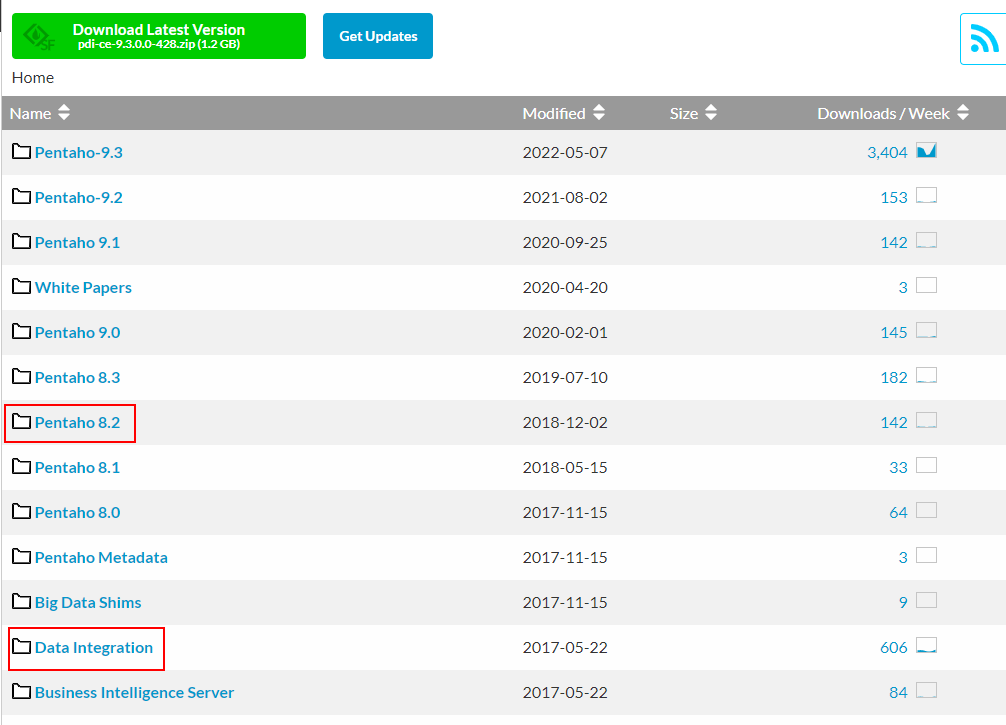

kettle的官网下载地址:Pentaho from Hitachi Vantara - Browse Files at SourceForge.net

如果需要下载其他版本:

直接点击对应的版本Name(8.0以下的实在Data Integration文件夹里面)进去,再选择client-tools点击进去,最后选择pdi-ce-xxx.zip进行下载。

按win和linux安装都是直接解压即可,再配置jdk环境,同步数据时,需要在lib加入对应的数据库驱动包。

2、注意点

${Internal.Entry.Current.Directory},该参数要求ktr文件和job文件必须放到同一目录下

es可能是驼峰命名字段,数据库可能是下划线命名,可以在idea通过camelBar插件进行辅助转换(快捷键:Alt+Shift+U 或者通过Edit-->camelBar)

2)hive相关问题,如果是同步到hive,默认情况下表输出是很慢的,需要修改big-data-plugin插件源码。

如果使用kettle版本过高,hive版本过低,可能会导致连接不上hive,这里也可以通过修改源码来解决。第二种方法是可以直接下载个低版本的kettle,修改plugin.properties配置文件(active.hadoop.configuration=),指定对应的CDH的版本(假设使用使用cdh)

在data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations可以看到对应的大数据一些组件版本。

3、脚本(后面整理再加上)

设计的Linux操作系统之批量杀死进程Linux操作系统之批量杀死进程_PrinciplesMan的博客-CSDN博客_linux kill多个进程

4、问题点

1)Caused by: com.mysql.jdbc.exceptions.jdbc4.MySQLIntegrityConstraintViolationException: Column 'id' cannot be null

如果目标表有主键,过来的数据为空,也会报主键不能为空的问题。如果是通过REST client就可能是查询

2)Caused by: java.sql.SQLException: Incorrect string value: '\xF0\x9F\x9A\x80WZ...' for column

通常情况,Mysql数据编码格式为“utf-8”,对于汉字来说足够;Mysql中utf8占3个字节,但是,3个字节对于表情符号是不够的,需4个字节;此时使用utf8,会出现‘\xF0\x9F\x8D\x83\xF0\x9F’的问题。

utf8mb4编码是utf8编码的超集,兼容utf8,并且能存储4字节的表情字符。

参考连接:Pentaho from Hitachi Vantara - Browse Files at SourceForge.net